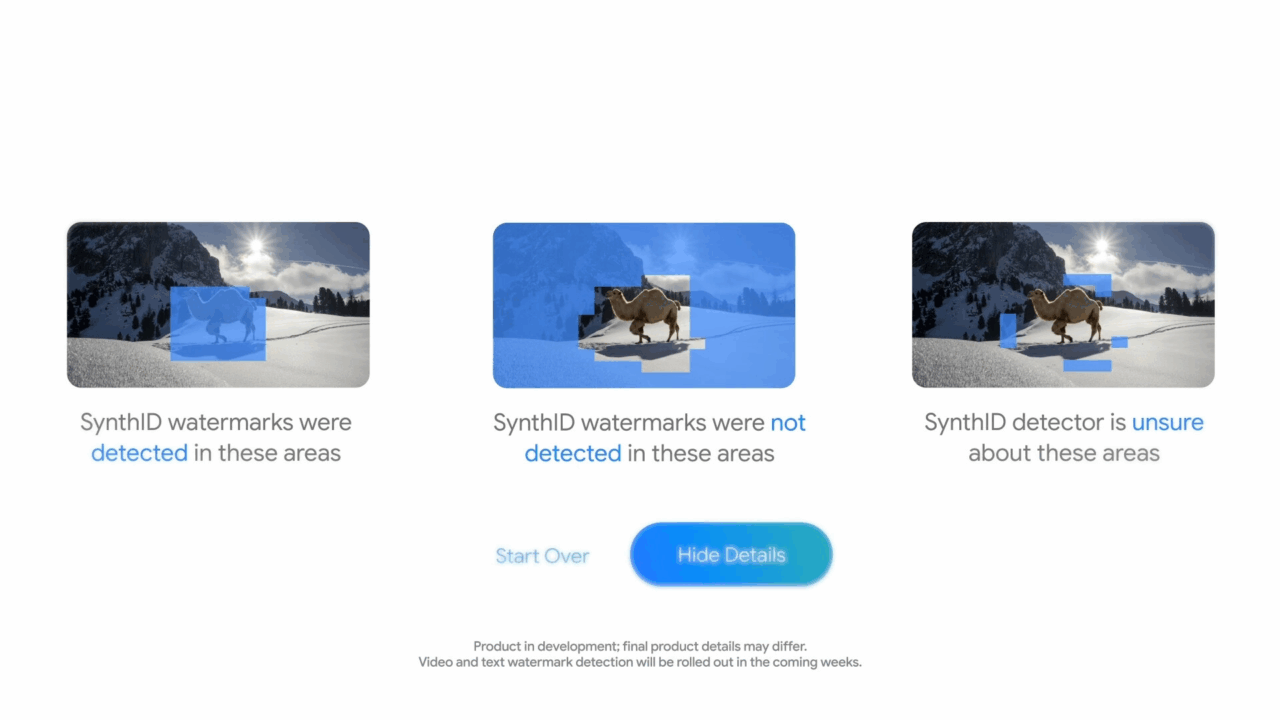

C’è un nuovo sceriffo in città, e si chiama SynthID Detector. Google DeepMind ha deciso di tirare fuori dal cilindro un altro coniglio marchiato AI: un tool capace di sniffare contenuti generati artificialmente attraverso immagini, video, audio e attenzione, attenzione persino il testo. No, non stiamo parlando del solito filtro per le fake news o di un misero plugin per PowerPoint, ma di una tecnologia che incide “watermark invisibili” nelle scelte probabilistiche delle parole, lasciando dietro di sé un’impronta digitale quasi mistica, simile al respiro di un fantasma digitale.

Perché questa tecnologia sta facendo rumore? Perché la parola chiave qui è deepfake. O meglio: deepfake, disinformazione, cheating. E quando questi tre demoni danzano insieme sullo stesso palco, è il momento di accendere i riflettori. SynthID Detector promette di essere l’occhio di Sauron che tutto vede — o almeno tutto ciò che è stato generato dagli strumenti AI di Google: Lyria, Imagen, NotebookLM, Gemini. Un po’ come se Sherlock Holmes lavorasse per Google e avesse imparato a leggere tra le righe digitali del codice.

Ma non corriamo troppo. Perché questo sceriffo, in realtà, ha ancora bisogno della patente. SynthID è infatti in beta chiusa, accessibile solo a giornalisti, ricercatori, educatori e designers in lista d’attesa. L’utente medio? Può solo guardare da lontano e sognare il giorno in cui potrà sapere se il selfie del collega è generato da un algoritmo o da una sbornia ben gestita.

Nel frattempo, nelle scuole e università, la guerra al cheating con AI è già persa da mesi. L’AI si è infiltrata ovunque, anche nei compiti in classe più “personali”. Come racconta il New York Magazine, un docente di etica tecnologica (!) ha ricevuto un saggio “intimo” redatto con ChatGPT. Riflettere sul proprio percorso accademico? Perché sbattersi, quando l’AI può simulare anche l’introspezione?

La cosa ironica — o tragica, dipende da quanto sei alcolizzato dalla realtà — è che OpenAI, dopo aver promesso la luna con il suo rilevatore di testi generati da AI, ha chiuso il bar. Il motivo? “Poca accuratezza”. Tradotto: più che un rilevatore, era un lancio di dadi. E chi ha bisogno di un dado truccato quando il cheating è già diventato sistemico?

Nel frattempo, mentre i giganti tech pasticciano con detection fallimentari, l’ex studente di Columbia Roy Lee — un genio o un piccolo criminale, scegli tu — ha creato Cluely, un’app che ti aiuta a barare agli esami come se stessi giocando a Guitar Hero. Uno schermo traslucido che ti sussurra le risposte mentre l’esaminatore pensa che tu sia semplicemente molto ispirato. Lanciata con un video durante un colloquio Amazon, Cluely ha già incassato 5,3 milioni di dollari. È la Silicon Valley, bellezza.

E mentre Lee colleziona investitori e like, DeepMind prova a chiudere la stalla dopo che i cavalli sono già scappati. SynthID Detector, con la sua capacità di leggere gli spostamenti semantici delle probabilità lessicali (una poesia solo a scriverla), tenta di fermare l’onda lunga della disinformazione. Ma c’è un problema strutturale: nessuno vuole davvero sapere cosa è generato da AI.

Perché la verità è scomoda. Le aziende, i media, gli studenti, i creatori di contenuti, gli influencer… tutti hanno ormai un dito (o tre) nell’inchiostro sintetico dell’intelligenza artificiale. E ogni volta che un detector come SynthID dice “ehilà, questo testo profuma di algoritmo”, l’unica reazione vera è il fastidio. Perché nella nuova economia dell’attenzione, il contenuto vero è quello che funziona, non quello autentico.

E allora Google propone la sua soluzione: un watermark che non si vede, che non si tocca, che non si può rimuovere (forse). È come se volessero tatuare l’anima del contenuto. Ma in fondo, chi controlla il controllore? Chi garantisce che questi watermark non diventino strumenti di controllo editoriale, censorship elegante, o marchingegni legali per bloccare o privilegiare certi contenuti nei motori di ricerca?

Nel frattempo, il caos regna sovrano. SynthID vuole essere la bussola, ma la mappa cambia ogni giorno. Tra detector che falliscono nel riconoscere anche testi umani — sì, c’è chi ha fatto leggere la Dichiarazione d’Indipendenza americana ai principali AI detector, e due su quattro hanno detto “questo è sicuramente GPT-4” — e software nati per sabotare i detector stessi, la sensazione è quella di trovarsi in una specie di guerra fredda informatica.

Chi vince? Come sempre: chi sa muoversi meglio nel grigio.

E mentre DeepMind dipinge i suoi watermark a colpi di probabilità lessicali e ottimizzazioni su contenuti generati da sé stesso (eh sì, solo quelli di Google, mica degli altri), il mercato continua a vendere fumo con etichetta “realtà aumentata”. L’AI è ormai ovunque, come il prezzemolo digitale. La domanda vera è: vogliamo davvero riconoscerla o preferiamo continuare a far finta di niente, come con le calorie del mojito?

D’altronde, come disse uno all’uscita di un esame universitario: “Non è importante sapere le cose, è importante sapere come fare finta di saperle.” Benvenuti nel mondo generativo.