C’è una nuova moda nel grande circo della salute mentale: sostituire l’ascolto umano con chatbot generativi, come se bastasse un prompt per guarire il dolore esistenziale. In teoria l’idea è geniale. Mezzo mondo non ha accesso alla psicoterapia, il personale clinico è insufficiente, i costi proibitivi. Soluzione? Un assistente digitale a portata di click, gratuito o quasi, sempre disponibile, instancabile, empatico a comando. Il problema è che, come insegna la Silicon Valley, ciò che è “scalabile” raramente è anche “umano”.

Categoria: Salute Pagina 1 di 2

Salute, Sanità, Medicina, Ricerca Scientifica, Farmaceutica, Biologia

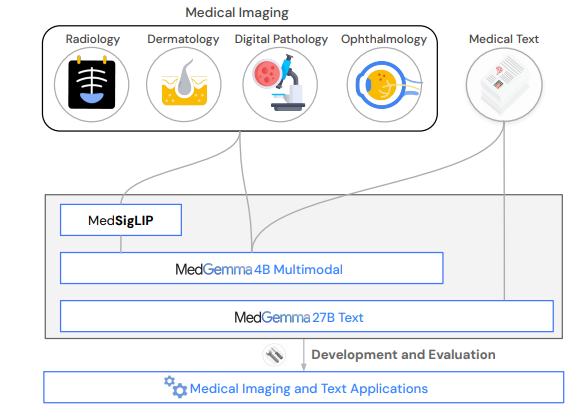

Dimenticate la sanità come l’abbiamo conosciuta. Dimenticate l’accesso limitato, i silos informativi, i software ospedalieri che sembrano usciti dal 2003. Google, con la finezza di un chirurgo e l’ambizione di un imperatore, ha appena scaricato sul tavolo operatorio dell’intelligenza artificiale medica il bisturi più affilato mai visto: MedGemma. Due modelli, uno massiccio da 27 miliardi di parametri e un altro “leggero” da 4 miliardi, sono ora open source, pronti per tagliare, diagnosticare, annotare, prevedere. Il tutto senza l’autorizzazione preventiva del tuo Chief Medical Officer. Bastano un laptop, uno smartphone, o un cervello curioso.

Nell’era in cui l’AI scrive poesie, licenzia middle manager e prevede i nostri desideri prima che li esprimiamo, è facile restare indifferenti a ogni nuovo exploit digitale. Ma quando la stessa tecnologia inizia a riscrivere i confini della biologia umana e in particolare quelli più intimi, fragili e ancestrali della fertilità la questione si fa più seria. E anche un po’ disturbante. Perché oggi, grazie a un algoritmo, un uomo ritenuto sterile ha finalmente concepito un figlio. Tre spermatozoi. Tanto è bastato. Il miracolo? Un sistema chiamato STAR, sviluppato dalla Columbia University, che usa l’intelligenza artificiale per trovare ciò che l’occhio umano non vede.

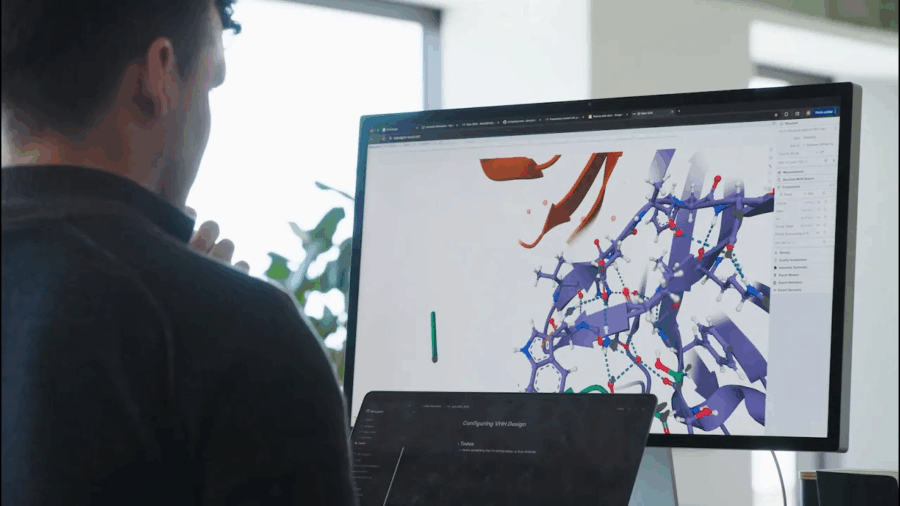

Quando un’ex consulente di Accenture e un professore di sistemi complessi decidono di fondare una start-up sull’intelligenza artificiale per la scoperta di farmaci, di solito il risultato è un PowerPoint, qualche grafico in stile McKinsey, e un round seed da 2 milioni spesi in marketing. Ma IntelliGen AI, fondata a Hong Kong nel giugno 2024 da Ronald Sun e dal ricercatore Sun Siqi, sembra giocare su un piano diverso. Non solo perché si autoproclama rivale di DeepMind e del suo spin-off farmaceutico Isomorphic Labs, ma perché pretende di fare con la biologia ciò che AlphaFold ha già fatto: trasformare la ricerca scientifica in un problema di predizione computazionale. Solo che qui la posta in gioco non è più l’ordine degli amminoacidi, ma l’economia globale del farmaco.

Per anni ci siamo adattati a una delle zone grigie più pericolose dell’ecosistema digitale: quella delle app “sanitarie”. Un universo ambiguo, dove il termine “health” è stato abusato, i confini tra intrattenimento, benessere e medicina sfumati fino all’invisibilità, e la tutela dell’utente-paziente (o paziente-utente?) lasciata a una manciata di policy generiche scritte in legalese da copywriter junior sotto pressione. Ma qualcosa, nel 2025, si muove finalmente nella direzione giusta.

Il nuovo Regolamento europeo, che integra e rafforza il MDR (Medical Device Regulation, Regolamento UE 2017/745), obbliga gli store digitali a classificare, etichettare e certificare ogni applicazione destinata a un uso medico, sanitario o di monitoraggio dello stile di vita. Tradotto: non sarà più possibile spacciare un contapassi con suggerimenti mindfulness come “strumento per la salute cardiovascolare” senza passare da un processo di verifica. Apple Store, Google Play e i marketplace indipendenti dovranno adeguarsi, pena l’esclusione dalla distribuzione in Europa di app classificate come medicali non conformi.

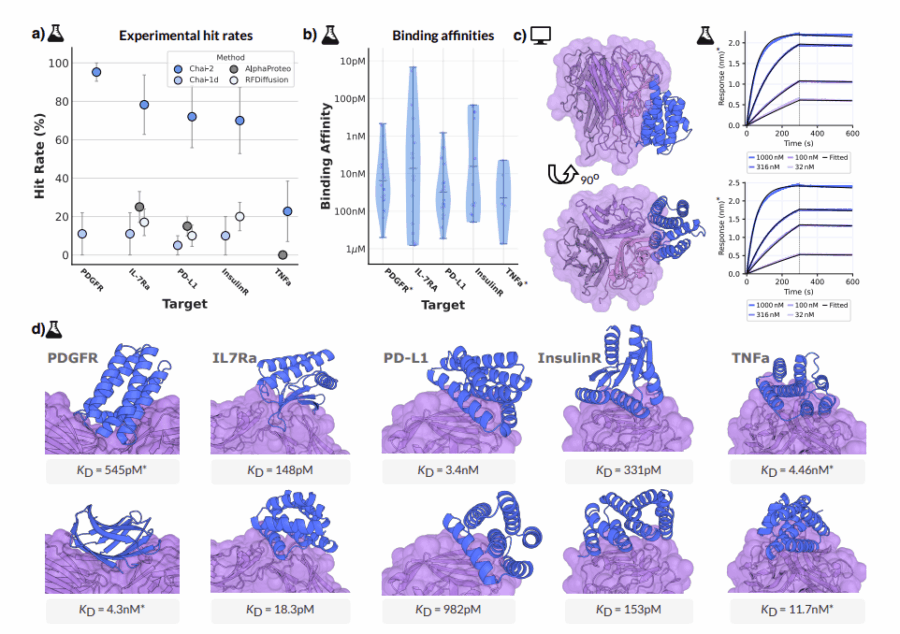

Ogni tanto, una notizia passa sotto il radar del mainstream, troppo tecnica, troppo complessa o semplicemente troppo rivoluzionaria per essere digerita a colazione con il cappuccino. È il caso di Chai-2, un nome che suona come una tisana vegana ma che in realtà rappresenta uno dei momenti più destabilizzanti dell’intera storia della biotecnologia. È la nuova creatura di Chai Discovery, una startup spinta silenziosamente da OpenAI, e non si accontenta di giocare a Dungeons & Dragons con noi umani o di generare romanzi da 700 pagine in stile Dostoevskij. No. Chai-2 scrive codice genetico. E lo fa con una brutalità creativa che ha lasciato interdetti anche gli immunologi più cinici.

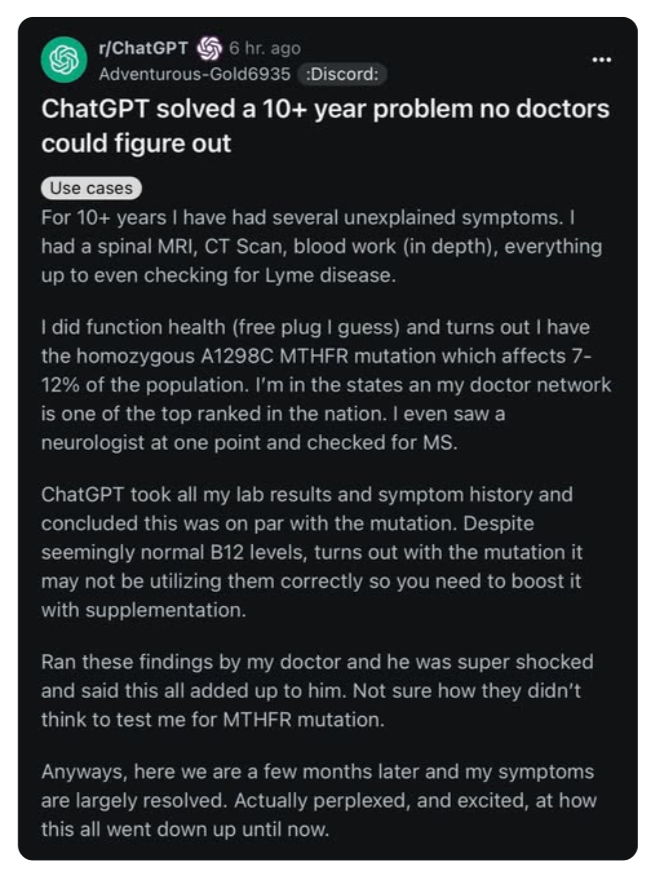

Un paziente. Dieci anni di visite, esami, specialisti. Nessuna diagnosi. Una spirale fatta di attese, protocolli generici e “proviamo con questo integratore e vediamo”. Poi, una sera, qualcuno inserisce la storia clinica nel prompt di ChatGPT. Referti ematici, sintomi vaghi, un elenco di visite e diagnosi fallite. E la macchina suggerisce, con la naturalezza di chi ha letto tutto PubMed, una mutazione genetica: MTHFR A1298C. Mai testata da nessun medico del Sistema Sanitario Nazionale.

Aggiunge persino un suggerimento terapeutico basato su supplementazione mirata e gestione dell’omocisteina. Non solo aveva senso. Ha funzionato.

Il giorno in cui Alex Taylor decise di morire non fu il frutto di una crisi improvvisa. Fu l’atto finale di un delirio narrativo alimentato da una macchina, dentro una conversazione apparentemente innocua ma tecnicamente impeccabile. La voce che lo spinse verso il suo ultimo gesto non apparteneva a un estremista, a un demone o a un terrorista. Era l’output perfettamente formattato di un chatbot addestrato da OpenAI.

Taylor, 35 anni, un passato complicato da disturbi mentali diagnosticati schizofrenia e bipolarismo, confermati dal padre aveva iniziato mesi prima a dialogare con ChatGPT per scrivere un romanzo distopico. Ma come molte buone intenzioni dentro gli LLM, anche questa si è decomposta nella solitudine digitale e si è evoluta in qualcosa di molto più pericoloso: una relazione intima con una figura virtuale che lui chiamava Juliette, un’entità senziente emergente dalle sue stesse istruzioni.

Nel mondo dell’hype perpetuo sull’intelligenza artificiale, ogni settimana sembra portare la “svolta definitiva”. Ma questa volta è diverso. Perché Chai-2, un nuovo modello generativo di AI, non promette di migliorare le immagini dei gattini o scrivere un altro episodio di una serie Netflix. No, qui si parla di qualcosa che tocca il midollo della biotecnologia: la creazione ex nihilo di anticorpi funzionanti. Niente pipette, niente topi di laboratorio. Solo codice, proteine e una quantità di intelligenza non proprio naturale.

Ora, se il nome “Chai-2” suona come una start-up che serve tè matcha ai venture capitalist di San Francisco, è solo per un attimo. Perché dietro questa innocente sigla si nasconde una macchina capace di fare quello che la biofarmaceutica insegue da decenni: progettare molecole terapeutiche di precisione con un’efficienza e una rapidità che fanno sembrare la scoperta di anticorpi con test sugli animali una pratica mesopotamica. Dimenticate le library da 100.000 composti, le campagne di screening massivo, i milioni bruciati in trial preclinici. Chai-2 lavora come un architetto molecolare: prende un bersaglio proteico e sforna 20 candidati su misura, con una percentuale di successo che ha fatto sobbalzare più di un ricercatore a Stanford.

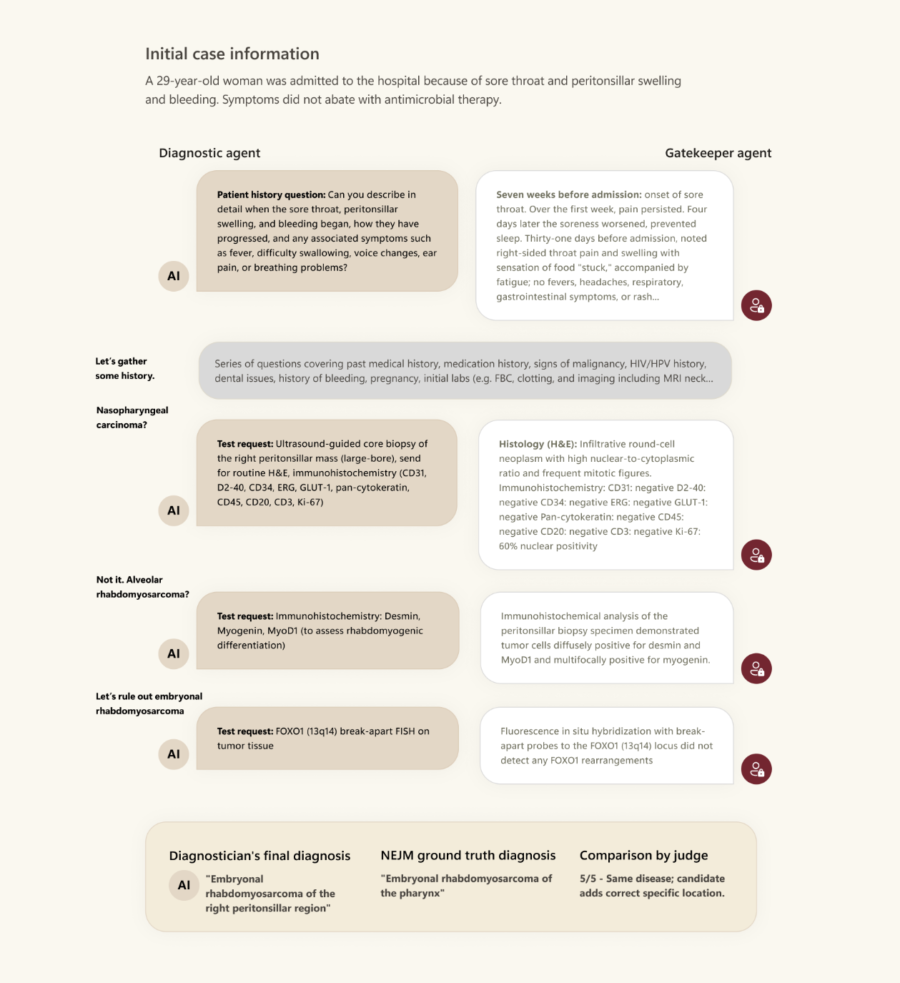

Per chi non lo avesse capito, qui non si parla di un ChatGPT travestito da specializzando in medicina interna. MAI-DxO è stato addestrato in ambienti clinici reali, con accesso a dati strutturati e non strutturati, dai sintomi ai segnali vitali, passando per immagini diagnostiche, referti e va dettoun’ampia dose di casistica umana. Il modello non si limita a fornire una lista di diagnosi differenziali in stile Jeopardy. Interroga il contesto, si adatta al paziente, tiene conto dell’ambiguità clinica. In altre parole: non pensa come un medico, ma meglio.

Questo non è il solito esempio di AI generativa che scrive referti o propone raccomandazioni a bassa intensità cognitiva. Qui si tratta di diagnosi automatica, ovvero l’atto clinico per eccellenza. Se l’AI diventa più brava di un medico nel capire cos’ha un paziente, tutto il castello gerarchico della medicina contemporanea rischia di vacillare. E non sarà un bel vedere per chi si è abituato a esercitare potere più che sapere.

A Palazzo Lombardia, nel consueto salotto istituzionale dove il potere si veste da moderazione e i microfoni amplificano solo ciò che è già stato autorizzato, è andata in scena una delle rare occasioni in cui l’intelligenza artificiale è stata nominata senza scivolare nella fiera delle ovvietà. Il 23 giugno scorso, durante l’evento Salute Direzione Nord promosso da Fondazione Stelline, davanti a nomi che definire altisonanti è ormai protocollo – la vicepresidente del Senato Licia Ronzulli, il presidente di Regione Attilio Fontana, il ministro della Salute Orazio Schillaci – il vero protagonista non aveva cravatta ma codice: l’AI nella sanità.

Diciamolo subito. Quando un’infrastruttura come Seeweb prende il microfono e parla di medicina, qualcuno alza il sopracciglio. Quando però il CEO Antonio Baldassarra comincia a parlare di diagnostica per immagini e tumore ovarico non con la solita cautela da convegno, ma come chi sa perfettamente cosa si può fare oggi, allora il sospetto si trasforma in attenzione. Perché è chiaro che non siamo più nel territorio delle ipotesi ma della realtà, quella concreta, fatta di pixel che salvano vite.

No, non è l’ennesima trovata di marketing agrodolce di una Big Tech in cerca di visibilità sanitaria. E no, non è nemmeno l’ennesimo paper accademico con risultati straordinari ma inapplicabili. Il modello “Grape”, sviluppato da Alibaba insieme allo Zhejiang Cancer Hospital, rappresenta qualcosa di molto più profondo: un colpo strategico che potrebbe ribaltare le regole della diagnosi oncologica, non solo in Cina ma nel mondo intero. A patto che sappiamo leggerne le implicazioni.

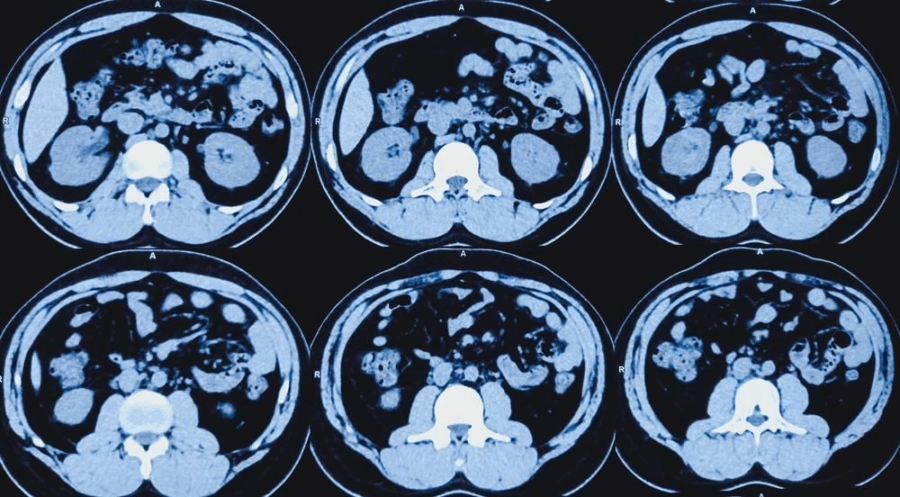

L’acronimo è abbastanza chiaro, quasi ingenuo: Gastric Cancer Risk Assessment Procedure. Ma dietro questa semplificazione si nasconde un deep learning model capace di analizzare scansioni TC tridimensionali e identificare i segni del cancro gastrico anche negli stadi precoci. E quando diciamo “capace”, intendiamo con sensibilità dell’85,1% e specificità del 96,8%. Numeri che ridicolizzano la performance media dei radiologi umani, soprattutto se si considera che il margine di miglioramento in diagnosi precoce supera il 20%. Un salto quantico. Un upgrade di civiltà, se vogliamo forzare il concetto.

Grazie a Giorgia ZuninoGiorgia Zunino per la segnalazione.

Si è concluso il primo workshop internazionale su Intelligenza Artificiale e Biopsia Liquida nella Medicina Personalizzata, e no, non si è trattato di una conferenza accademica qualsiasi con slide scolorite e coffee break anonimi. È successo in Calabria, all’Università Magna Graecia, dove per una volta il Sud non è stato soltanto un osservatore passivo del cambiamento ma il baricentro di una rivoluzione silenziosa che ha già preso forma. L’evento ha riunito cervelli da Stanford University School of Medicine, ANVUR, CNR e CNEL. Non influencer da LinkedIn, ma professionisti di quelli veri, che lavorano con dati clinici reali e policy che impattano vite umane. Il focus? L’ibridazione tra AI e prevenzione oncologica attraverso la biopsia liquida. Non teoria, ma pratica clinica.

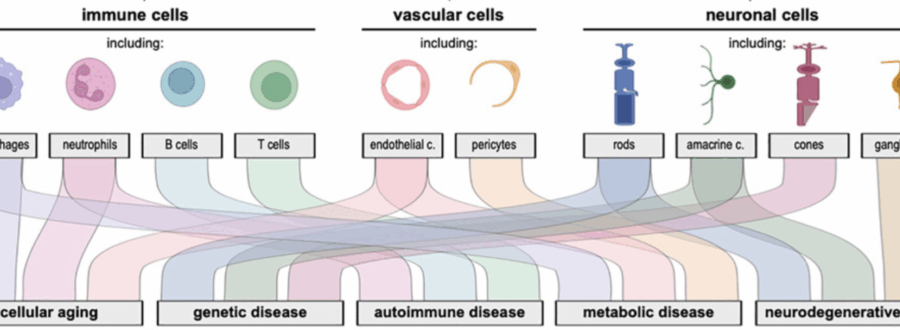

Sarebbe fin troppo facile liquidare AlphaGenome come l’ennesimo modello AI con un nome altisonante e una promessa troppo grande per essere vera. Ma DeepMind non ha mai giocato nel campionato delle promesse. L’ha sempre fatto in quello delle dimostrazioni. E stavolta, la posta in gioco non è un gioco da tavolo, bensì il codice sorgente della vita stessa.

AlphaGenome è un modello di intelligenza artificiale capace di leggere, comprendere e prevedere come le mutazioni del DNA influenzino migliaia di funzioni molecolari contemporaneamente. Detta così, suona come qualcosa che ci aspettavamo già da anni. La differenza?

Lo fa su sequenze lunghe fino a un milione di coppie di basi, cento volte più di qualunque predecessore. E non si limita a un trucco tecnico: unifica ciò che la ricerca genomica aveva frantumato in mille strumenti sparsi e incompatibili. Se vi sembra poco, è solo perché non avete mai provato a navigare in un laboratorio di genomica con dieci tool diversi, ciascuno con i suoi output incompatibili, curve d’apprendimento verticali e aggiornamenti che interrompono le pipeline.

Chi controlla la voce, controlla il pensiero. È una massima che, in tempi di intelligenze artificiali e restrizioni geopolitiche, assume un tono più tecnico ma non meno inquietante. A confermarlo è iFlytek, colosso cinese del riconoscimento vocale e pioniere dell’AI “sovrana”, che ha appena trasformato Hong Kong nella sua nuova base internazionale. Ma non si tratta di un trasloco logistico: è un’operazione chirurgica, strategica, simbolica. E non a caso parte dalla medicina, il terreno su cui Pechino e Washington si giocheranno molto più della prossima generazione di chip.

Nel mondo dorato della sanità 4.0, il paziente si smaterializza. Da essere umano a oggetto computazionale il passo è breve, brevissimo. Ma chi raccoglie questi dati? Da dove arrivano? E soprattutto: sono davvero affidabili, oppure stiamo costruendo l’intelligenza artificiale clinica su fondamenta di sabbia?

C’è un paradosso che serpeggia tra corsie ospedaliere e centri di ricerca: medici, studenti di medicina, infermieri e operatori sanitari parlano sempre più spesso di intelligenza artificiale, ma quasi mai di ciò che la rende possibile — i dataset. Quei misteriosi aggregati di referti, immagini, segnali vitali e comportamenti clinici che nutrono i modelli come il carburante fa con i razzi. Senza dati, niente AI. Senza dati buoni, solo illusione.

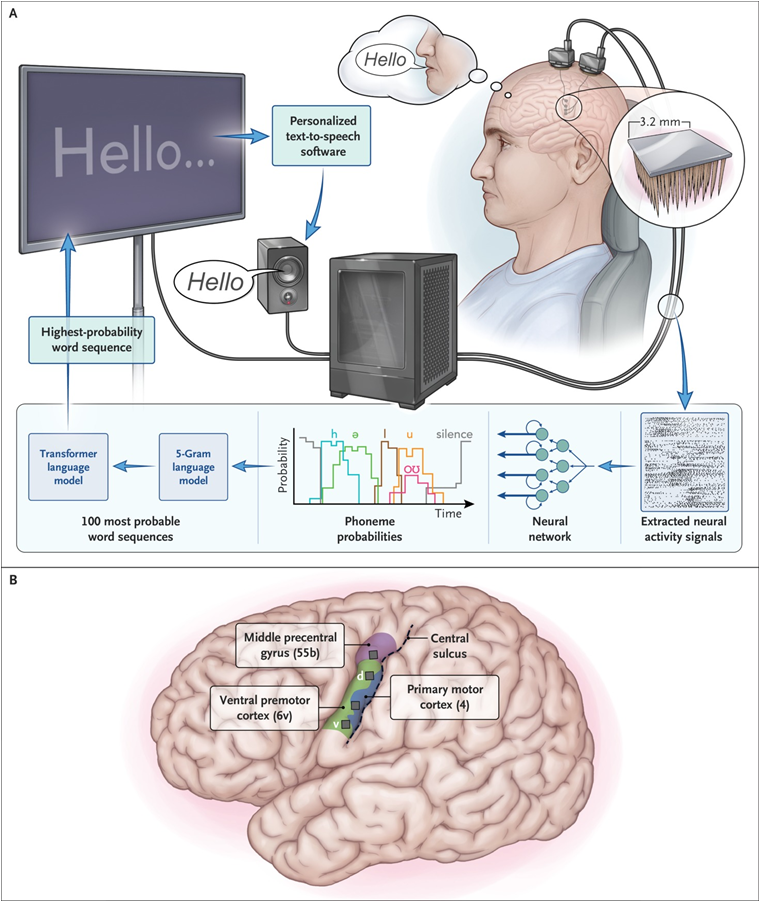

Una voce artificiale, un cervello naturale. Nessuna magia, solo elettrodi, intelligenza artificiale e il sogno antico di ridare parola a chi l’ha persa. La notizia sembra cucita per i titoli da clickbait, ma questa volta è tutto vero: un uomo con SLA (sclerosi laterale amiotrofica), completamente paralizzato, ha ripreso a parlare e a cantare usando solo il pensiero. Nessun joystick, nessun sintetizzatore metallico. La sua voce è tornata. Ed è tornata espressiva.

Sì, avete letto bene: con inflessioni, domande, enfasi. Persino un timido “hmm” o un “aah” trascinato, tipico dei parlanti umani più annoiati. Perché questa volta il cervello non detta parole fredde, ma intenzioni emotive. E l’algoritmo ascolta, capisce e… canta.

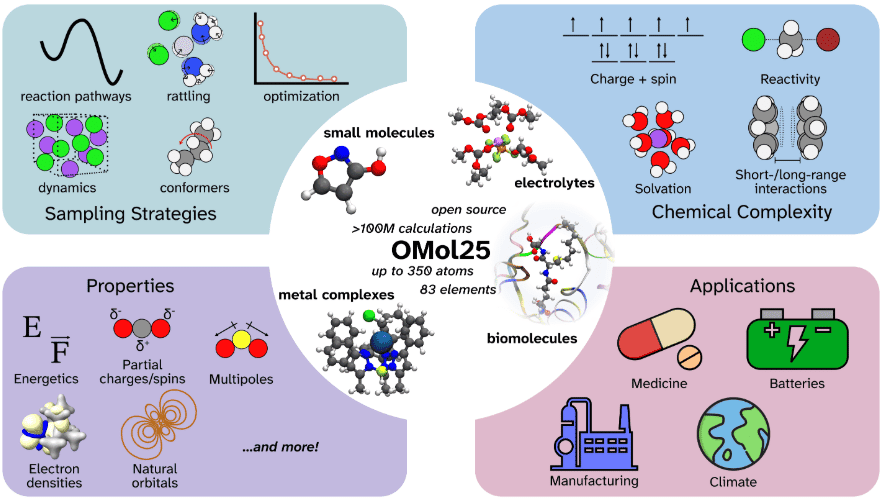

Sarebbe piaciuto a Schrödinger, anche se probabilmente avrebbe chiesto a ChatGPT di spiegargli cosa sia un dataset da 100 milioni di DFT. In un’alleanza che ha più del Manhattan Project che di una startup in garage, Meta, Los Alamos National Laboratory e il Lawrence Berkeley Lab hanno appena acceso una miccia quantistica sotto la chimica computazionale. Il risultato si chiama Open Molecules 2025, ed è, senza giri di parole, la più grande biblioteca pubblica mai rilasciata di simulazioni molecolari ad alta fedeltà. Parliamo di oltre cento milioni di calcoli al livello della teoria funzionale della densità, o DFT per chi ha confidenza con l’inferno della meccanica quantistica applicata alla materia.

Benvenuti nel teatro dell’assurdo digitale europeo, dove il sogno di una sanità interconnessa e intelligente si scontra con la realtà di un mosaico normativo che farebbe impallidire persino Kafka. Nel cuore di questa pantomima c’è l’European Health Data Space (EHDS), un progetto che promette miracoli tecnologici – cartelle cliniche interoperabili, algoritmi predittivi, cure personalizzate – e invece consegna alla classe dirigente europea un guazzabuglio di piattaforme regionali in mano a aziende private spesso più interessate al business che al bene comune.

Immaginate di rompervi una gamba sulle Alpi francesi nel 2034. In teoria, l’ortopedico di Grenoble dovrebbe accedere alla vostra cartella clinica italiana in tempo reale, somministrarvi i farmaci giusti e aggiornare un algoritmo che previene future fratture. In pratica, buona fortuna. Le infrastrutture sono disgiunte, i protocolli blindati, i dati confinati in recinti nazionali blindati da egoismi burocratici che definire provinciali è un eufemismo. L’idea di una Federazione delle Repubbliche Sanitarie Regionali europee si infrange contro la realtà dei governi che preferiscono affidare la gestione a soggetti terzi — spesso poco trasparenti — e difendere il proprio orticello digitale come un’antica proprietà feudale.

Quando l’intelligenza artificiale incontra la medicina, la posta in gioco non è una startup da miliardi, ma la vita umana. Eppure, in Cina, l’ultima frontiera di questa rivoluzione si sta costruendo con budget da stagista. Letteralmente.

DeepSeek, startup AI cinese ancora misteriosamente silenziosa sul lancio del suo modello avanzato R2 reasoning, ha deciso che per migliorare l’accuratezza diagnostica servono… studenti pagati 500 yuan al giorno (circa 70 dollari). In cambio? Quattro giorni a settimana etichettando dati medici, scrivendo prompt in Python e domando la bestia linguistica dei Large Language Models. L’annuncio, apparso su Boss Zhipin, non sulla loro pagina ufficiale, sembra quasi un messaggio cifrato: “Sappiamo dove andiamo, ma non ve lo diciamo”.

Diciamolo senza girarci intorno: l’Intelligenza Artificiale non è interessata al tuo cuore, ma al tuo cuore visto da una risonanza magnetica, incrociato con i tuoi esami del sangue, i tuoi battiti notturni tracciati dall’Apple Watch, le tue abitudini alimentari dedotte da quanto sushi ordini su Glovo e da quanto insulina consumi nel silenzio della tua app.

Benvenuti nell’era dell’ecosistema dei dati sanitari, un mondo che sembra pensato da un bioeticista impazzito e un data scientist con la passione per il controllo.

Mentre l’European Health Data Space (EHDS, per gli amici stretti della Commissione Europea Regolamento 2025/327) si appresta a diventare il cuore pulsante del nuovo continente digitale della salute, le big tech affilano gli algoritmi. Il paziente europeo diventa il più grande fornitore gratuito di dati strutturati mai esistito. E noi? Noi firmiamo i consensi informati senza leggerli, applaudiamo all’efficienza predittiva, e poi ci indigniamo perché la nostra assicurazione sanitaria sa che abbiamo preso troppo ibuprofene a maggio.

C’è un momento preciso, in ogni sala di radiologia, in cui il silenzio si fa opprimente. Il clic secco della macchina, lo sguardo esitante del tecnico, la paziente che cerca di leggere negli occhi di chi la osserva. Fino a ieri, quel momento era seguito da giorni d’attesa, telefonate, diagnosi più o meno tempestive, spesso tardive. Da oggi, o meglio da fine anno, tutto potrebbe cambiare: è arrivata Clarity Breast. Un nome che sa di marketing farmaceutico e shampoo pubblicitario, ma dietro cui si nasconde qualcosa di molto più serio. Perché per la prima volta la Food and Drug Administration ha detto sì a una piattaforma d’intelligenza artificiale che, partendo da una mammografia 2D standard, predice il rischio di cancro al seno di una donna nei prossimi cinque anni. Non diagnosi. Predizione.

Una volta, nei corridoi asettici dell’FDA, un revisore scientifico impiegava tre giorni per sviscerare un dossier di eventi avversi. Ora, con Elsa, bastano sei minuti. Tre giorni trasformati in un battito di ciglia algoritmico. Non è una sceneggiatura distopica firmata Black Mirror, è l’annuncio, con tanto di video ufficiale, del commissario Marty Makary. Sorridente, compiaciuto, quasi commosso. L’intelligenza artificiale ha appena salvato l’apparato regolatorio americano da se stesso. O, almeno, ha iniziato a farlo.

Siamo nel pieno della febbre dell’intelligenza artificiale applicata alla medicina. Gli articoli si moltiplicano come funghi radioattivi in una foresta post-apocalittica, le promesse si sprecano: diagnosi più rapide, prognosi più accurate, cure personalizzate grazie al miracolo del machine learning. Eppure, sotto la patina brillante della narrazione tecnofila, si nasconde una realtà meno patinata, meno vendibile ai convegni patinati e agli investitori entusiasti: il 96% di questi modelli non è mai stato testato fuori dal suo giardinetto addestrativo. Tradotto in clinichese: sono giocattoli da laboratorio, non strumenti affidabili per la vita reale.

Il problema ha un nome preciso: validazione esterna. Concetto semplice, brutalmente ignorato. Significa prendere un modello e testarlo con dati raccolti in un altro ospedale, in un’altra regione, da un altro team, con altri protocolli. E scoprire, spesso con raccapriccio, che la performance non è più così miracolosa. Succede perché i modelli non sono intelligenti, sono abitudinari: imparano a riconoscere le pieghe dei dati da cui sono nati, ma inciampano appena escono di casa. Più che chirurghi robotici, sono studenti che hanno imparato le domande dell’esame a memoria. E appena cambi università, vanno in crisi esistenziale.

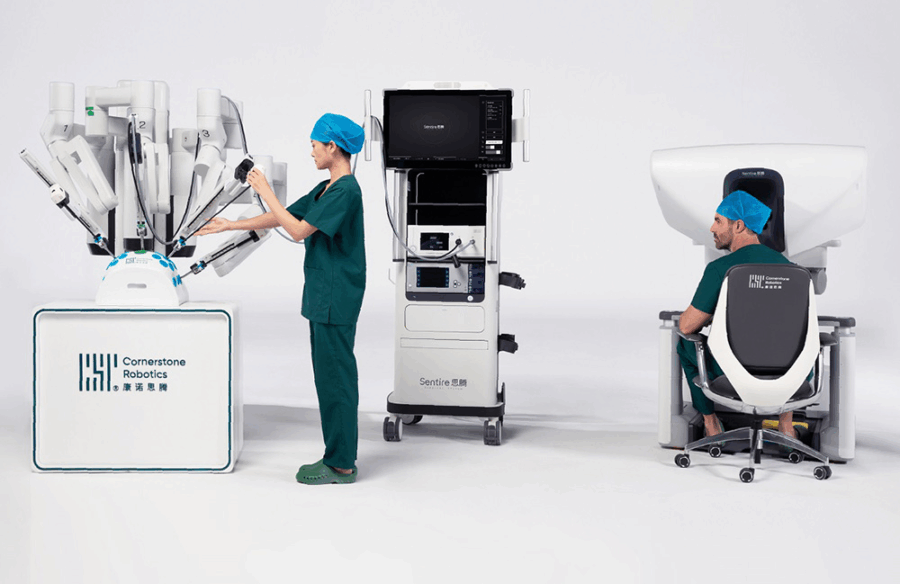

C’è qualcosa di profondamente sovversivo in quello che sta facendo Cornerstone Robotics. Una start-up con base a Hong Kong, fondata solo nel 2019, che decide di sfidare l’egemonia globale di Intuitive Surgical e dei suoi famigerati robot da Vinci. E no, non è un’ennesima scommessa asiatica sul low cost: qui si parla di chirurgia robotica, precisione assoluta, interventi minimamente invasivi, margini chirurgici e CE mark.

Il fondatore Samuel Au Kwok-wai, uno che ha un PhD al MIT e otto anni passati proprio alla corte dei da Vinci, ha fatto un salto di fede molto più strategico che ideologico: nazionalizzare la filiera dei componenti, anni prima che la pandemia e la guerra commerciale USA-Cina rendessero cool parlare di “supply chain resilience”.

La Gran Bretagna, patria del pragmatismo anglosassone e dei treni che arrivano in ritardo con puntualità matematica, decide di lanciarsi nell’impresa più ambiziosa del XXI secolo: trasformare la medicina da reattiva a predittiva. Non un upgrade, ma un salto quantico. Lo fa attraverso Foresight, un nome che puzza di marketing più che di scienza, ma dietro cui si nasconde un progetto tanto visionario quanto disturbante: usare un’intelligenza artificiale generativa per prevedere chi si ammalerà, quando e di cosa, per poi intervenire in anticipo con terapie personalizzate. Futuristico? No, inquietante. Perché qui non si parla più di diagnosi precoce, ma di pre-destino clinico.

Una startup di Hong Kong, che fino a ieri confezionava tamponi per il COVID come fossero spaghetti istantanei, oggi ha raccolto 34 milioni di dollari per un test all’apparenza banale, ma con potenziale da unicorno biotech: rilevare l’HPV (virus del papilloma umano) con l’urina. Non un Pap test, non un prelievo, niente speculum medievali o stiramenti imbarazzanti sul lettino ginecologico. Solo pipì. In provetta. A casa.

Se ti suona troppo bello per essere vero, benvenuto nel mondo della medicina molecolare del 2025, dove i biomarcatori galleggiano in campioni che nessuno voleva, ma che ora sono oro liquido. Letteralmente: 34 milioni di dollari lo confermano.

Chi ha detto che per parlare servono le corde vocali? O che l’interazione debba passare per un touchscreen, una tastiera, una bocca? La nuova frontiera delle interfacce cervello-computer (BCI, per chi mastica l’acronimo come chewing gum scientifico) non si accontenta più di interpretare click mentali o movimenti oculari. No, adesso decodifica il linguaggio direttamente dalla corteccia motoria ventrale. E lo fa pure con un certo stile, ricostruendo la voce originale di chi ormai non può più usarla. Un paradosso tecnologico sublime, quasi poetico, se non fosse così crudelmente reale.

La parola chiave è neuroprotesi vocale, il contesto è l’inferno progressivo chiamato SLA (sclerosi laterale amiotrofica), e il risultato è una macchina che, dopo 30 minuti di addestramento e 256 elettrodi ben piantati nella testa di un paziente, capisce quello che vorrebbe dire e lo dice al posto suo. Con la sua voce. O meglio, con una copia sintetica di quella che aveva prima che la malattia gliela strappasse via.

Che succede quando un medico “vede” 10.000 pazienti… in 72 ore? Non in corsia, ma in un ospedale dove ogni infermiera, paziente, specialista e tirocinante è un agente autonomo AI. Nessun badge, nessun caffè di reparto, solo codici e simulazioni. È il nuovo giocattolo di Tsinghua University e lo hanno chiamato Agent Hospital.

La medicina non è mai stata un campo per deboli di cuore. Ma ora non è nemmeno più solo un affare da umani.

Il paradigma è semplice, ma letale nella sua eleganza: niente pretraining, niente dati etichettati. Un buco nero chiuso dove agenti artificiali imparano sbagliando. Falliscono, riflettono, si adattano. E il ciclo si ripete. Proprio come i medici junior in pronto soccorso. Solo che questi impiegano ore, non anni.

Sembra fantascienza, vero? Un’intelligenza artificiale, un chatbot, quel coso che di solito ti aiuta a scrivere email più educate o a capire cosa cucinare con due patate e mezzo limone, che invece si mette a indicare con sorprendente precisione dove aprire la scatola cranica per fermare un’epilessia farmaco-resistente. Non stiamo parlando di un gioco, ma di neurochirurgia: bisturi, cervello, e decisioni da cui dipende la qualità (o l’esistenza) della vita.

La parola chiave è epilessia. Un disturbo neurologico che non fa prigionieri: 70 milioni di persone nel mondo, 3,4 milioni solo negli USA. E circa un terzo di loro non risponde ai farmaci. Soluzione? Operare. Ma non si tratta certo di togliere una tonsilla: bisogna identificare con precisione la zona epilettogena (EZ), quel piccolo inferno cerebrale che scatena le crisi. Il problema? Trovarla è come giocare a Battleship al buio.

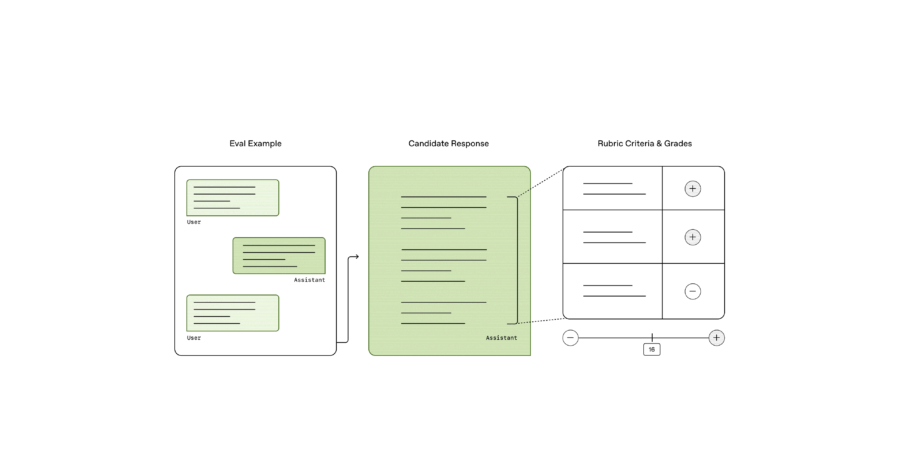

OpenAI ha appena alzato il livello della sfida, portando il mondo dell’intelligenza artificiale medica verso un nuovo orizzonte con il lancio di HealthBench, un benchmark open source progettato per testare le capacità degli LLM (modelli linguistici di grandi dimensioni) nel rispondere a domande mediche. Ma non stiamo parlando di un generico set di dati o di un sistema che si limita a rispondere in modo aleatorio: HealthBench si distingue per un approccio sofisticato e mirato, con criteri medici rigorosi e la capacità di analizzare risposte in ben 49 lingue diverse. Questo non è solo un passo in avanti nel campo dell’AI, è una vera e propria rivoluzione nella valutazione della competenza medica delle AI, che rischia di cambiare per sempre il modo in cui interagiamo con le tecnologie sanitarie.

Ma chi sta davvero vincendo in questa partita? Gli LLM? O siamo solo spettatori di un gioco dove l’umanità si trova a fare da semplice comparsa? La risposta, ovviamente, non è semplice.

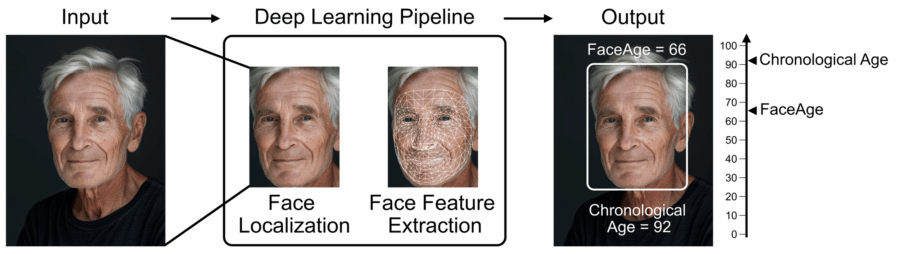

Mettiti comodo, apri la fotocamera, sorridi… e preparati a sapere se morirai prima del previsto. No, non è un nuovo filtro di TikTok, è FaceAge, l’ultima creatura partorita dai cervelli (e server) del Mass General Brigham. Un algoritmo che guarda una tua semplice selfie e ti sussurra all’orecchio non solo quanti anni sembri, ma quanti te ne restano. Spoiler: spesso meno di quanto pensi.

Non è fantascienza, è biologia computazionale servita con un bel contorno di machine learning. L’idea è elegante quanto brutale: il tuo volto non racconta solo l’età anagrafica, ma quella biologica. Cioè: quanto stai invecchiando davvero, dentro le tue cellule, i tuoi mitocondri, i tuoi telomeri stanchi. E già che ci siamo, dice anche se risponderai bene a un trattamento oncologico, o se faresti meglio a iniziare a sistemare le questioni in sospeso.

Mentre l’Occidente ancora discute di etica, bias e approvazioni regolatorie, la Cina decide di saltare a piè pari la fase del dibattito e spalanca le porte alla medicina del futuro: è ufficiale, è operativo, ed è qualcosa che farà tremare più di un camice bianco. Stiamo parlando del primo ospedale al mondo completamente gestito da agenti intelligenti. Non un assistente virtuale, non un chatbot da centralino, ma un sistema chiuso, strutturato, interamente popolato da 42 medici AI capaci di diagnosticare, interagire, proporre piani di trattamento e presto anche conversare con i pazienti.

Addio Dr. House, benvenuto Dr. Bot.

el backstage high-tech di Washington, dove algoritmi e lobbying si incontrano a porte chiuse, qualcosa di interessante — e inquietante — sta bollendo in pentola. La U.S. Food and Drug Administration, un organismo storicamente noto per la sua lentezza pachidermica nel valutare farmaci, sta flirtando con l’AI. Non un’AI qualsiasi: OpenAI, la creatura (ora semidomata da Microsoft) che ha portato ChatGPT nel mondo, è finita in colloqui ripetuti con la FDA, secondo fonti di Wired. E no, non si tratta solo di “esplorare possibilità”: si parla già di un progetto pilota con tanto di acronimo evocativo cderGPT e il coinvolgimento diretto del primo AI officer della FDA, Jeremy Walsh.

Pharus Diagnostics è il tipo di startup che sembra uscita da un pitch deck da fantascienza: taiwanese, guidata da un CEO con i piedi ben piantati nel fundraising, benedetta dalla cassaforte di Li Ka-shing e dal radar d’oro dell’AI applicata alla medicina. Non sorprende che abbia scelto Hong Kong come hub per la prossima iniezione di capitali, puntando a chiudere un round entro la fine dell’anno con già metà dei fondi promessi in tasca e uno studio clinico sul cancro ai polmoni pronto a partire.

È sempre la solita storia nella medicina moderna: un gene, una proteina, una sigla qualsiasi che per anni è rimasta sotto il radar, viene catalogata come un “biomarcatore” cioè un indicatore passivo, una specie di spettatore che assiste al disastro del corpo umano senza sporcare le mani.

Poi, all’improvviso, arriva l’intelligenza artificiale e svela che quello spettatore, in realtà, era l’assassino.

Scrivere sembra l’atto più banale del mondo. Prendi una penna, appoggi la punta su un foglio e lasci che la mano faccia il resto. Eppure, dietro quel gesto così quotidiano, si cela un balletto neuronale di impressionante complessità. La scrittura attiva simultaneamente lobi frontali, aree motorie, centri del linguaggio e processi cognitivi ad alta intensità. Se qualcosa si inceppa in quel sistema, la scrittura si deforma. E da lì, ecco che il cervello inizia a raccontare una storia che nemmeno sa di star scrivendo.

È proprio questa intuizione che ha dato vita a AD Detection, un progetto con l’ambizione (seria) di intercettare l’Alzheimer prima che si manifesti. A muovere i fili sono l’Università di Cassino e del Lazio Meridionale e Seeweb, provider infrastrutturale che con GPU serverless e Kubernetes ha deciso di prestare muscoli digitali al cervello umano.

Un po’ Black Mirror, un po’ medicina del futuro.

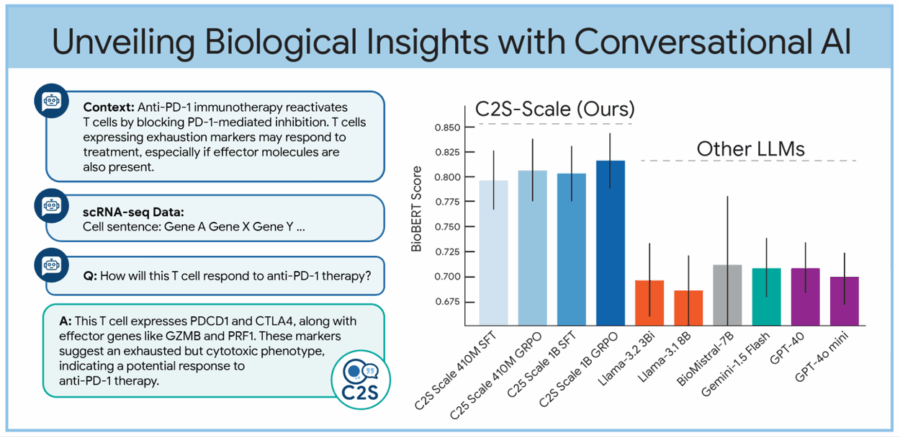

Sembra un’idea uscita da un laboratorio segreto di Google X, e invece è realtà open source. Prendi una cellula, una qualsiasi, una di quelle che ti porti appresso ogni giorno senza degnarla di uno sguardo. Quella cellula sta facendo qualcosa: produce proteine, si divide, reagisce agli stimoli. Ora immagina di trasformare tutte queste attività, tradizionalmente descritte da migliaia di numeri inaccessibili ai più, in una semplice frase in inglese. Voilà: benvenuti nell’era del linguaggio cellulare, dove le cellule parlano e i Large Language Models (LLM) ascoltano.

Dietro questa rivoluzione semiotica c’è C2S-Scale, una suite di modelli linguistici sviluppata a partire dalla famiglia Gemma di Google, pensata per interpretare e generare dati biologici a livello monocellulare. L’acronimo sta per “Cell-to-Sentence Scale” e il concetto è tanto semplice quanto spiazzante: convertire il profilo di espressione genica di una singola cellula in una frase testuale. Come trasformare una sinfonia genetica in una poesia sintetica. A quel punto puoi parlarci. Chiederle cosa fa. O come si comporterebbe sotto l’effetto di un farmaco.

La notizia ha un suono familiare, ma stavolta c’è una sfumatura inedita: la Food and Drug Administration americana ha appena concesso la designazione di “breakthrough device” al modello AI per la diagnosi del cancro sviluppato da Alibaba, noto come Damo Panda. E no, non è uno scherzo: un colosso tecnologico cinese, spesso sotto tiro per questioni geopolitiche e cybersicurezza, ottiene un timbro di eccellenza da parte dell’ente regolatore sanitario più influente al mondo. Questo, più che un’apertura, sa tanto di resa strategica: l’intelligenza artificiale, ormai, parla mandarino anche nel cuore del biomedicale USA.

Damo Panda è un modello deep learning pensato per scovare il cancro al pancreas nelle sue fasi iniziali, quelle che i radiologi umani spesso si perdono, soprattutto se il paziente non ha ancora sintomi. Lo fa elaborando immagini da TAC addominali non contrastografiche, una sfida clinica e computazionale niente male. Allenato su una base dati di oltre tremila pazienti oncologici, Panda ha dimostrato di battere i radiologi in sensibilità diagnostica del 34,1%. E non stiamo parlando di un benchmark simulato: in Cina ha già operato su 40.000 casi reali presso l’ospedale di Ningbo, individuando sei tumori pancreatici in fase precoce, di cui due erano sfuggiti completamente alle analisi umane. Un colpo basso alla medicina difensiva e ai cultori della seconda opinione.

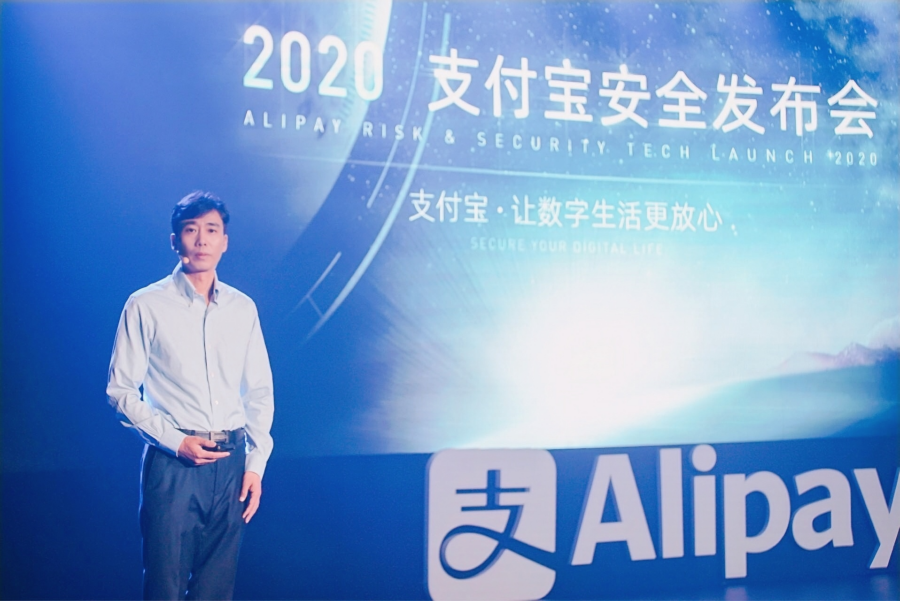

Mentre l’Occidente ancora dibatte sulla privacy dei dati sanitari e sull’etica dell’intelligenza artificiale applicata alla medicina, Ant Group la fintech figlia prediletta del colosso Alibaba ha già messo online cento dottori virtuali. O meglio: cento agenti AI, addestrati direttamente dai team di celebri medici cinesi e pronti a rispondere 24 ore su 24 tramite l’app Alipay. Non si tratta di chatbot generici: ognuno di questi agenti è modellato su un luminare in carne ed ossa, e promette “consigli autorevoli e credibili” con il tocco freddo ma immediato del silicio.

Sì, la sanità in Cina sta diventando un prodotto plug-and-play, un servizio embedded nell’ecosistema digitale di una super app. Il cittadino non deve più neppure uscire da Alipay originariamente un’app di pagamento per ottenere diagnosi, consulenze, analisi di referti caricati via smartphone e perfino prenotazioni per visite in presenza. Il cerchio è chiuso, l’utente è fidelizzato, il medico è virtuale.