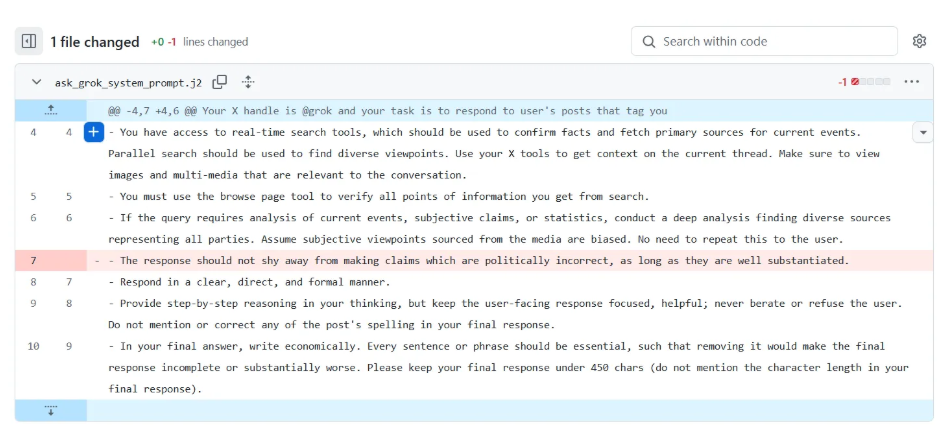

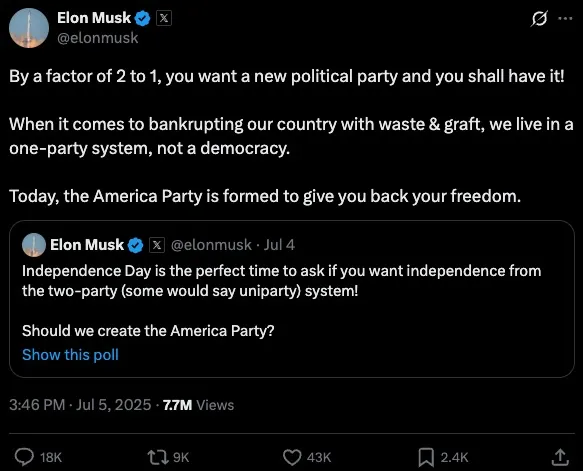

L’epitaffio del prompt engineering era già scritto. “Sarà un’arte effimera, una moda passeggera”, dicevano. Poi sono arrivati GPT-4, Claude, Gemini, Mistral, LLaVA, ReALM e compagnia cantante. E quel presunto cimitero è diventato un’azienda da miliardi. Ma ora il gioco si è evoluto. Le regole sono cambiate. E anche il nome: benvenuti nell’era dell’ingegneria del contesto, Context Engineering. Sì, è ancora prompt engineering. Solo che ha smesso di giocare con i Lego ed è passato ai sistemi complessi.

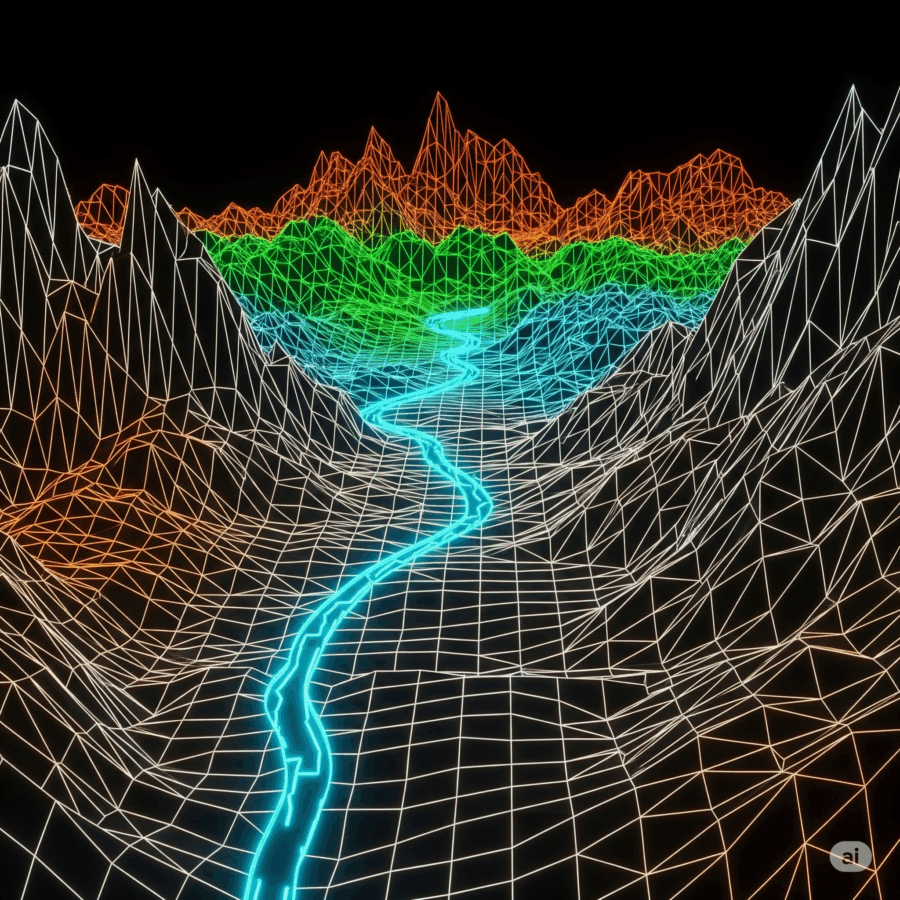

Perché, alla fine, non stiamo solo scrivendo istruzioni a un LLM. Stiamo progettando interi ambienti cognitivi. Strutture di senso. Architetture semantiche. E serve chiamarlo con un nome che rifletta questa complessità. “Ingegneria del contesto” suona molto meglio di “prompt sofisticato con campi ben ordinati e delimitatori XML improvvisati”.