Quando si parla di “cloud europeo” la retorica prende il volo, i comunicati si moltiplicano e le istituzioni si affannano a mostrare che, sì, anche il Vecchio Continente può giocare la partita con i big tech americani. Ma basta grattare appena sotto la superficie per accorgersi che, mentre si organizzano convegni dal titolo vagamente profetico come “Il futuro del cloud in Italia e in Europa”, il futuro rischia di essere una replica sbiadita di un presente già dominato altrove. L’evento dell’8 luglio, promosso da Adnkronos e Open Gate Italia, ha messo in scena l’ennesimo tentativo di razionalizzare l’irrazionale: cioè la convinzione che l’Europa possa conquistare la sovranità digitale continuando a delegare le sue infrastrutture fondamentali agli hyperscaler americani. A fare gli onori di casa, nomi noti come Giacomo Lasorella (Agcom) e Roberto Rustichelli (Agcm), professori universitari esperti di edge computing, rappresentanti delle istituzioni europee e naturalmente AWS e Aruba, i due lati della stessa medaglia: chi fa il cloud globale e chi prova a salvarne un pezzetto per sé.

Categoria: Cloud e Data Center Pagina 1 di 2

Cloud, Storage, Software, Data Center

C’è qualcosa di poetico nel fatto che l’intelligenza artificiale, la più incorporea delle rivoluzioni, stia cementificando il pianeta sotto milioni di tonnellate di acciaio, cavi in fibra ottica e turbine ad alta tensione. Mentre i visionari della Silicon Valley vendono algoritmi come se fossero fuffa mistica, la vera guerra si combatte nei deserti texani, nelle paludi della Louisiana, nei freddi angoli dell’Oregon, dove i data center HPC si moltiplicano come formicai radioattivi. Altro che nuvola: qui servono ettari di cemento, interi bacini idrici, e il consumo energetico di nazioni intere per far girare LLM e modelli AI che promettono di capire l’animo umano, ma non riescono ancora a distinguere tra una banana e un cacciavite in un’immagine sfocata.

Immaginate un matrimonio combinato tra un trader di Wall Street con l’hobby del quantum computing e un minatore del Kentucky che sogna l’IPO. È più o meno ciò che rappresenta l’acquisizione da 9 miliardi di dollari proposta da CoreWeave (NASDAQ:CRWV) ai danni sì, ai danni di Core Scientific (NASDAQ:CORZ), storico operatore del settore crypto mining che ora si ritrova a giocare un ruolo da protagonista in una partita molto più sofisticata: l’ascesa del data center hyperscale nel contesto dell’intelligenza artificiale generativa. Altro che ASIC e proof-of-work, qui si parla di orchestrazione di workload ad alta densità per LLM e training su larga scala. Benvenuti nella fase 2 dell’era post-cloud.

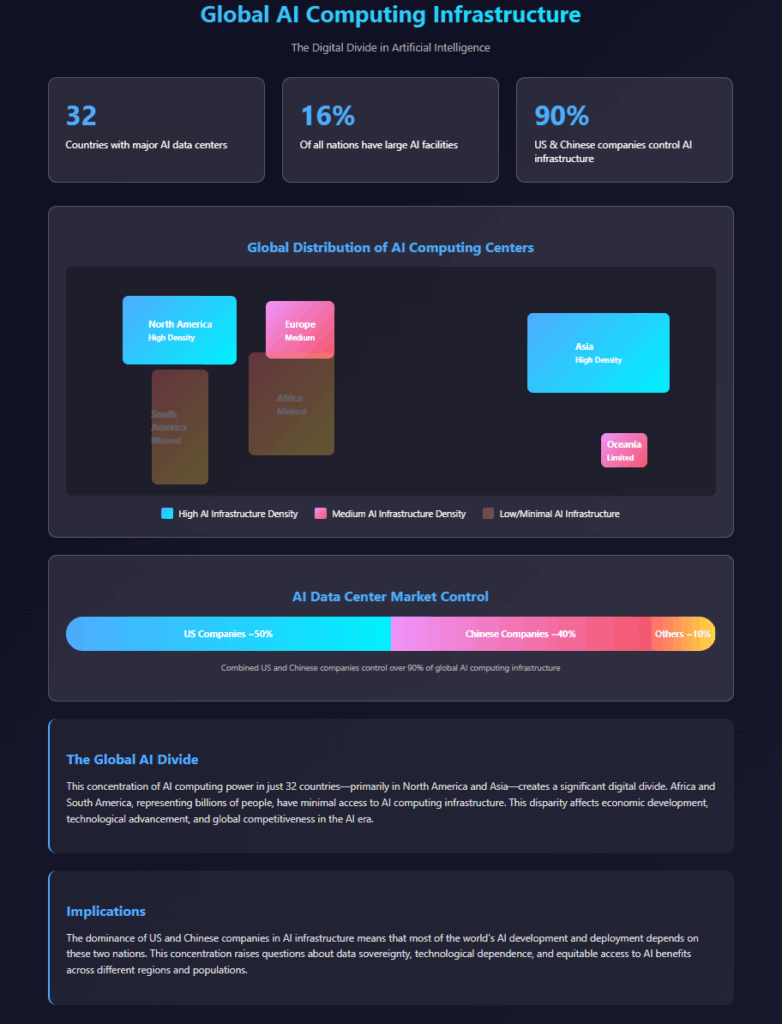

C’è una bugia ben educata che ci raccontiamo sull’intelligenza artificiale: che sia universale, democratica, accessibile. Basta un’idea brillante e una connessione a internet, giusto? Sbagliato. Oggi la vera valuta dell’intelligenza artificiale non è l’algoritmo, né il talento. È la potenza di calcolo. E su quel fronte, il mondo non è solo diviso: è spaccato come una lastra di ghiaccio sottile sotto il peso di un futuro che pochi potranno davvero controllare.

Il panorama dei Data Center in Italia e in Europa: un’analisi approfondita

Nel cuore di questa corsa globale verso l’elaborazione decentralizzata e la dominazione algoritmica, alcune città europee iniziano a muovere pedine che fino a ieri sembravano ferme come statue. Milano non è più sola: Roma, Marsiglia e Varsavia stanno diventando nomi familiari nei pitch deck degli investitori. No, non stiamo parlando di turismo, ma di hyperscale, colocation e edge computing. La nuova geopolitica digitale non si combatte con trattati o accordi doganali, ma con latenza, connettività e temperatura media. Sì, anche il meteo ora fa strategia.

C’è un odore particolare che si sente sempre all’apice di una bolla finanziaria: un mix di euforia da spreadsheet, dichiarazioni pubbliche ottimiste e, dietro le quinte, banche d’investimento che cercano una porta d’uscita elegante prima che le luci si spengano. Ecco, questo è esattamente il profumo che emana oggi il mercato dei data center per l’intelligenza artificiale. Un boom da trilioni di dollari gonfiato da fondi private equity, REIT iper-leveraggiati e una fede quasi religiosa nella crescita esponenziale dell’AI. Ma la nuova parola d’ordine è “riciclo del capitale”, e come ogni nuovo mantra finanziario, suona meglio di quanto non odori.

Il problema, come sempre, non è l’infrastruttura in sé. Nessuno mette in discussione che un hyperscale data center da 250 megawatt, carico di server NVIDIA e immerso in liquido refrigerante da fantascienza, sia una meraviglia ingegneristica. Il problema è l’assunto finanziario sottostante: che ci sarà sempre un prossimo investitore disposto a pagare un multiplo più alto, una rendita più bassa, una scommessa più grossa. E quando Goldman Sachs inizia a parlare apertamente di “costruire la rampa d’uscita” per i primi investitori, dovremmo forse tutti smettere di parlare di crescita e iniziare a parlare di exit strategy. (qui il Report)

A Palazzo Lombardia, nel consueto salotto istituzionale dove il potere si veste da moderazione e i microfoni amplificano solo ciò che è già stato autorizzato, è andata in scena una delle rare occasioni in cui l’intelligenza artificiale è stata nominata senza scivolare nella fiera delle ovvietà. Il 23 giugno scorso, durante l’evento Salute Direzione Nord promosso da Fondazione Stelline, davanti a nomi che definire altisonanti è ormai protocollo – la vicepresidente del Senato Licia Ronzulli, il presidente di Regione Attilio Fontana, il ministro della Salute Orazio Schillaci – il vero protagonista non aveva cravatta ma codice: l’AI nella sanità.

Diciamolo subito. Quando un’infrastruttura come Seeweb prende il microfono e parla di medicina, qualcuno alza il sopracciglio. Quando però il CEO Antonio Baldassarra comincia a parlare di diagnostica per immagini e tumore ovarico non con la solita cautela da convegno, ma come chi sa perfettamente cosa si può fare oggi, allora il sospetto si trasforma in attenzione. Perché è chiaro che non siamo più nel territorio delle ipotesi ma della realtà, quella concreta, fatta di pixel che salvano vite.

C’è una strana sindrome, tutta europea, che potremmo definire “burocrazia salvifica”. Una fede incrollabile nella capacità taumaturgica della regolamentazione di sistemare ciò che il mercato, la competizione, la libertà d’impresa e, diciamolo pure, il rischio non sono riusciti a far funzionare. E ogni volta che il mondo corre più veloce delle nostre istituzioni, ecco spuntare un nuovo acronimo, un’altra direttiva, l’ennesimo atto. Oggi tocca al Cloud AI Development Act, la nuova formula magica che dovrebbe trasformare l’Europa in una superpotenza digitale. O quantomeno farci sentire un po’ meno provinciali rispetto a USA e Cina.

In un panorama digitale in continua evoluzione, la regolamentazione dell’Intelligenza Artificiale (AI) e del cloud computing sta diventando un tema centrale. L’Europa si sta interrogando sulla necessità di un “Cloud AI Development Act”, e per esplorare a fondo la questione, è stato organizzato un webinar con alcuni dei maggiori esperti del settore.

Questo incontro organizzato da Seeweb (Antonio Baldassarra) e moderato da Dario Denni , nato da un confronto approfondito con il Professor Antonio Manganelli su ipotesi competitive nell’ambito dell’Agent AI, si propone di aprire ad una comprensione approfondita di un argomento che modellerà il futuro dell’economia e della società digitale.

Tra i relatori: Antonio Baldassarra, Antonio Manganelli, Innocenzo Genna, Renato Sicca, Maria Vittoria La Rosa, Luca Megale, Alberto Messina, Simone Cremonini, Vincenzo Ferraiuolo e Marco Benacchio.

Perché la Commissione ritiene che ci sia bisogno di intervenire. È un tema che sarà oggetto di dibattito, com’è giusto che sia.

Il settore dei data center in Europa sta vivendo una trasformazione senza precedenti, alimentata dalla crescente domanda di servizi cloud, intelligenza artificiale e digitalizzazione accelerata. Con tassi di crescita a doppia cifra e investimenti plurimiliardari, il mercato europeo si sta consolidando come pilastro fondamentale dell’economia digitale globale. In questo contesto, l’Italia ha le potenzialità per poter emergere come un hub strategico, pronta a competere con i tradizionali mercati FLAP-D (Francoforte, Londra, Amsterdam, Parigi e Dublino), che stanno raggiungendo la saturazione.

Mentre a Wall Street si brinda all’ennesimo record storico di Nvidia, in un angolo meno chiassoso del pianeta qualcuno sta costruendo una rete invisibile. Silenziosa, a basso costo, brutalmente efficiente. Si chiama DeepSeek, arriva da Hangzhou, e ha appena fatto saltare il banco della narrativa occidentale secondo cui l’intelligenza artificiale avanzata sarebbe un’esclusiva americana, magari con hardware made in Taiwan. No, perché la Cina, senza troppo rumore, si prepara a investire tra i 600 e i 700 miliardi di yuan nel solo 2025 in capex per l’AI. Tradotto: fino a 98 miliardi di dollari, con una crescita annuale prevista del 48%.

La transizione digitale e l’espansione dell’intelligenza artificiale hanno spinto i data center al centro della scena europea, con una crescita esponenziale di infrastrutture nei principali hub tecnologici del continente. Tra le regioni destinate a subirne l’impatto maggiore c’è la Lombardia, al crocevia tra innovazione, industria e infrastrutture energetiche.

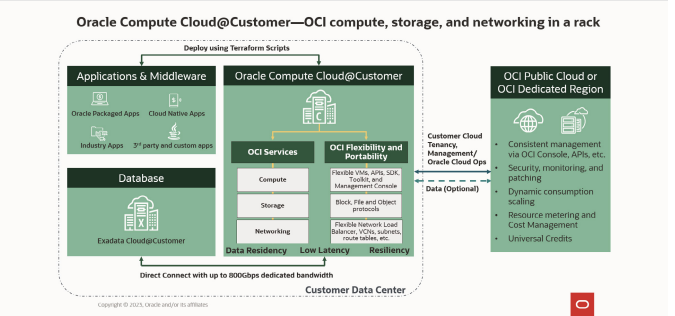

C’è un’aria di rivincita nell’aria. Dopo i riflettori puntati su OpenAI e i suoi tormenti da intelligenza artificiale cosciente e la offerta per il Pentagono, ecco che Oracle risale la scena con un annuncio tanto silenzioso quanto strategico. Nessuna coreografia in stile Silicon Valley, nessun CEO che filosofeggia sulla singolarità. Solo un prodotto, freddo, solido, brutale: Oracle Compute Cloud@Customer Isolated. Nome ostico, ma messaggio chiarissimo. Il cloud smette di essere un servizio e torna a essere infrastruttura. Anzi, fortezza.

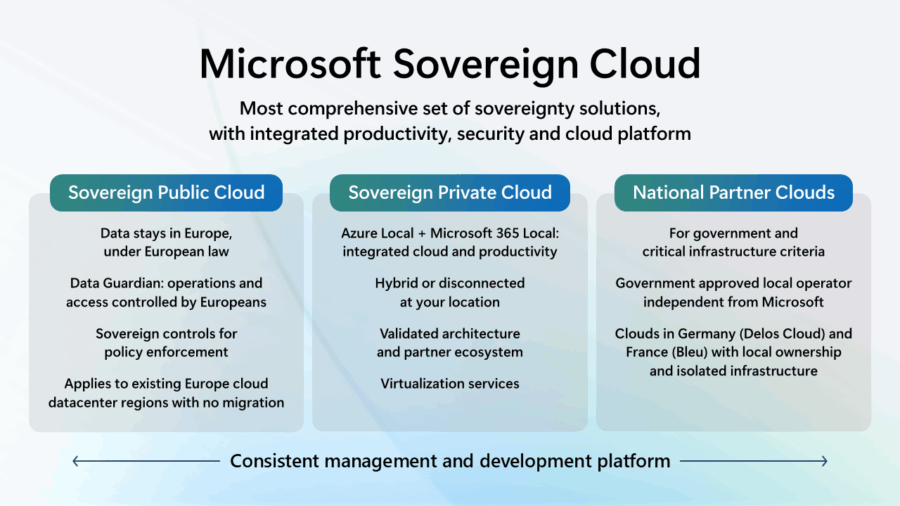

Nel 2025 la parola più di moda nel lessico delle multinazionali tech è una che fino a ieri puzzava di geopolitica demodé e burocrazia: sovranità. Ma non quella dei popoli, delle nazioni o dei parlamenti. No, quella digitale. Benvenuti nell’epoca del “Sovereign Cloud”, dove anche Microsoft, dopo anni di amore cieco per il modello centralizzato alla californiana, decide di vestirsi da paladina della sovranità europea, con tanto di accento sulla compliance, controllo e resilienza.

C’è un errore concettuale che si continua a ripetere nel mondo dell’Intelligenza Artificiale, una specie di dogma non scritto: per avere prestazioni elevate, devi sacrificare il controllo. In altre parole: se vuoi GPU, devi affidarti mani e CPU alle big cloud d’oltreoceano, rinunciando a ogni pretesa di privacy-by-design. Ma cosa succede se ti dicessimo che è possibile avere entrambi? Se la scelta non fosse più tra potenza e proprietà, ma tra dipendenza e autonomia?

Nessuno aveva chiesto il permesso. Nvidia è entrata in Europa come una valanga silenziosa, con l’annuncio che segna una nuova frontiera: la costruzione del primo cloud industriale AI europeo. Non un data center qualsiasi, ma una piattaforma con 10.000 GPU H100, pensata non per alimentare i meme su Midjourney, ma per far girare le macchine che muovono l’industria pesante, le smart factory e, soprattutto, le economie nazionali.

Dietro l’annuncio c’è molto di più che un’infrastruttura. C’è un messaggio politico. C’è l’idea, finora solo sussurrata nei corridoi della Commissione Europea, che il cloud “made in USA” non sia più sostenibile. E mentre Bruxelles balbetta leggi e regolamenti, Nvidia fa. E lo fa a casa nostra.

Il palcoscenico era pronto, i riflettori accesi, e poi… niente. Stargate, la presunta alleanza epocale tra Oracle, SoftBank e OpenAI per dar vita a un’infrastruttura da 500 miliardi di dollari destinata all’intelligenza artificiale, è ancora una chimera. Safra Catz, CEO di Oracle, lo ha dichiarato con candore durante l’ultima call sugli utili: “non è ancora stata costituita”.

“Quando senti la parola ‘cloud’, guarda se piove.” Questa battuta, un po’ vecchia scuola ma mai fuori moda, descrive perfettamente la schizofrenia con cui l’Italia affronta il tema del digitale. Da un lato si moltiplicano convegni, task force e white paper che inneggiano all’Intelligenza Artificiale come alla nuova Rinascenza tecnologica italiana. Dall’altro, le PMI arrancano su server obsoleti, con una fibra che spesso è più ottica nei titoli dei bandi che nei cavi di rete. E allora, ci vuole davvero un Cloud e AI Development Act per traghettare il Bel Paese verso un futuro dove il digitale non sia più un miraggio ma una politica industriale concreta?

Il 2 febbraio 2025 segna un punto di svolta. L’entrata in vigore della prima fase dell’AI Act europeo segna un cambio di paradigma: chi sviluppa, distribuisce o adotta sistemi di intelligenza artificiale dovrà fare i conti non solo con algoritmi, ma anche con regolatori armati di sanzioni fino al 7% del fatturato globale. Niente male per un settore che si è mosso finora con l’agilità di un esperto in dark pattern più che con quella di un civil servant europeo.

C’è qualcosa di straordinario che sta accadendo sotto i nostri piedi e sopra le nostre teste. Non lo vediamo, ma ci avvolge ogni giorno. È l’evoluzione dell’Internet, un ecosistema che da sogno accademico è diventato infrastruttura critica della civiltà contemporanea. Non più solo strumento, ma vero e proprio tessuto connettivo dell’umanità. E NAM2025, il summit in programma l’11 giugno a Roma, nasce proprio per fare luce su questa trasformazione epocale, dove intelligenza artificiale, geopolitica, spazio e cavi sottomarini si intrecciano in uno scenario tanto complesso quanto affascinante.

C’è un nuovo Eldorado tecnologico, e non si trova né nella Silicon Valley né a Shenzhen. Si trova a centinaia di chilometri sopra le nostre teste, in orbita terrestre. Mentre i comuni mortali cercano di far funzionare i loro server on-premise o di migrare al cloud, i giganti della tecnologia stanno già pensando a data center spaziali, come se fosse la cosa più naturale del mondo. Eric Schmidt, ex CEO di Google, ha recentemente preso le redini di Relativity Space, un’azienda che punta a costruire razzi stampati in 3D e a lanciare infrastrutture nello spazio. Nel frattempo, Jeff Bezos, con la sua Blue Origin, sta sviluppando “Blue Ring”, una piattaforma spaziale che offre potenza di calcolo resistente alle radiazioni, gestione termica e comunicazioni per carichi utili in orbita.

Ma perché tutto questo interesse per i data center nello spazio? Per cominciare, lo spazio offre un ambiente unico: temperature estreme, assenza di gravità e un’abbondanza di energia solare. Queste condizioni possono essere sfruttate per creare data center altamente efficienti e sicuri. Inoltre, con l’aumento esponenziale dei dati generati da dispositivi IoT,(o da reti tipo Starlink o Kuiper di Amazon) intelligenza artificiale e altre tecnologie emergenti, la domanda di capacità di elaborazione e archiviazione è in costante crescita. I data center spaziali potrebbero offrire una soluzione scalabile e sostenibile a lungo termine.

McKinsey Study AI infrastructure: A new growth avenue for telco operators

“Il miglior modo per predire il futuro è inventarlo”, diceva Alan Kay. Ma nel caso dell’economia dell’intelligenza artificiale, predirlo significa anche cablarlo. Ospitarlo. Alimentarlo a megawatt e connettività. E se oggi gli operatori telco si illudono di poter semplicemente ritagliarsi un posto accanto agli hyperscaler, farebbero meglio a studiare il caso Seeweb con il suo GPU aaS ad esempio: un player italiano che, mentre i giganti si perdono tra strategie da boardroom e infrastrutture legacy, ha già capito come posizionarsi là dove l’AI genera valore reale. Ovvero, nell’inferenza. Sì, proprio quel segmento dove la corsa ai chip diventa guerra di margini, latenza, costi energetici e disponibilità immediata.

Il contesto? Secondo McKinsey, la domanda globale di data center per applicazioni AI triplicherà entro il 2030. Non è solo una questione di training: è l’inferenza quotidiana, ubiqua, embedded in ogni app, customer service, servizio pubblico. È la fase in cui l’intelligenza artificiale non solo impara, ma lavora. E per lavorare, le servono strutture vicine, leggere, distribuite. Chi controlla la rete, controlla la distribuzione dell’intelligenza.

Martedì 27 maggio abbiamo partecipato al convegno “Intelligenza Artificiale e Business Application”, organizzato da Soiel International a Roma.

Nel corso dell’evento, Paolino Madotto (CISA, CGEIT) ha presentato Ambrogio, l’assistente virtuale sviluppato da Intelligentiae – data enabling business. Quante volte vi siete trovati a cercare un documento, un file o un’informazione dentro una selva oscura di cartelle digitali, archivi confusionari, backup che sembrano ordinati solo agli occhi di chi li ha creati? Nel 2025, quando ormai dovremmo parlare di “smart working” e “digital first” come un dogma, le aziende continuano a perdere tempo e denaro inseguendo dati che sembrano evanescenti.

Ambrogio, l’AI made in Italy targata Intelligentiae, si propone come il deus ex machina di questa tragedia moderna, promettendo una rivoluzione nella gestione documentale aziendale che ha il sapore di una rinascita digitale.

Inference Provider in Europa

C’è un momento, tra la prima linea di codice PyTorch e il deployment di un modello di ricerca, in cui il ricercatore universitario si trasforma in un hacker delle economie di scala. Hai una GPU? No. Hai un budget? Manco per sogno. Vuoi HIPAA compliance? Certo, e magari anche un unicorno in saldo. Ma il punto non è questo. Il punto è che stai cercando di fare inferenza on-demand, con una GPU, pagando solo quando qualcuno effettivamente usa il tuo lavoro. E tutto questo mentre una legione di sysadmin impanicati blocca qualsiasi cosa esposta in rete per paura del prossimo attacco russo.

Una volta, nei data center, si switchava tutto in Layer 2. Ethernet ovunque. Cavi come spaghetti, STP (Spanning Tree Protocol) che cercava di non farti incendiare le topologie a loop, e una visione ingenua del networking: broadcast ovunque, MAC tables che strabordavano come il caffè dimenticato sul fornello. Il sogno? Una gigantesca LAN piatta, con ogni server che poteva “vedere” ogni altro server, come se fossimo tutti amici al bar. La realtà? Un incubo di scalabilità, resilienza farlocca e troubleshooting stile CSI Miami.

Mentre i riflettori dei media generalisti si limitano a menzionare Abilene, Texas, come se fosse solo l’ennesimo cantiere tech in mezzo al nulla, chi ha orecchie per intendere — e un conto in banca legato alla rivoluzione AI — sa che Stargate è molto più di una joint venture infrastrutturale. È una dichiarazione di guerra tecnologica. Una sfida frontale a chi detiene oggi il controllo delle risorse computazionali mondiali. Un affare da 500 miliardi di dollari che ridisegna gli equilibri tra chipmaker, hyperscaler e i nuovi “costruttori di Dio”.

Siamo ormai nel pieno del barocco dell’intelligenza artificiale. Gli LLM (Large Language Models) sono diventati le nuove cattedrali digitali, costruite con miliardi di parametri e sorrette da GPU che sembrano più reattori nucleari che schede video. In questo panorama di potenze mostruose, dove i soliti noti (OpenAI, Google, Anthropic) dettano legge, si insinua un nome meno blasonato ma decisamente audace: DeepSeek-R1. Non solo open source, ma anche titanico 671 miliardi di parametri, per chi tiene il conto.

La provocazione è chiara: “possiamo competere con GPT-4o, Gemini e soci… e magari anche farlo girare nel vostro datacenter, se siete abbastanza matti da provarci”. Ma è davvero così? Ecco dove entra in scena Seeweb, con la sua Cloud GPU MI300X una vera bestia, con 8 GPU AMD MI300X e un terabyte e mezzo di VRAM a disposizione. E abbiamo deciso di scoprire se tutto questo è solo hype o se c’è ciccia sotto il cofano.

A volte penso che se l’umanità dovesse collassare domani, la sua ultima trasmissione sarebbe una gif di un gatto in slow motion su TikTok, caricata a 8K via fibra ottica. E se non arriverà, sarà colpa del bandwidth o meglio, della sua agonia.

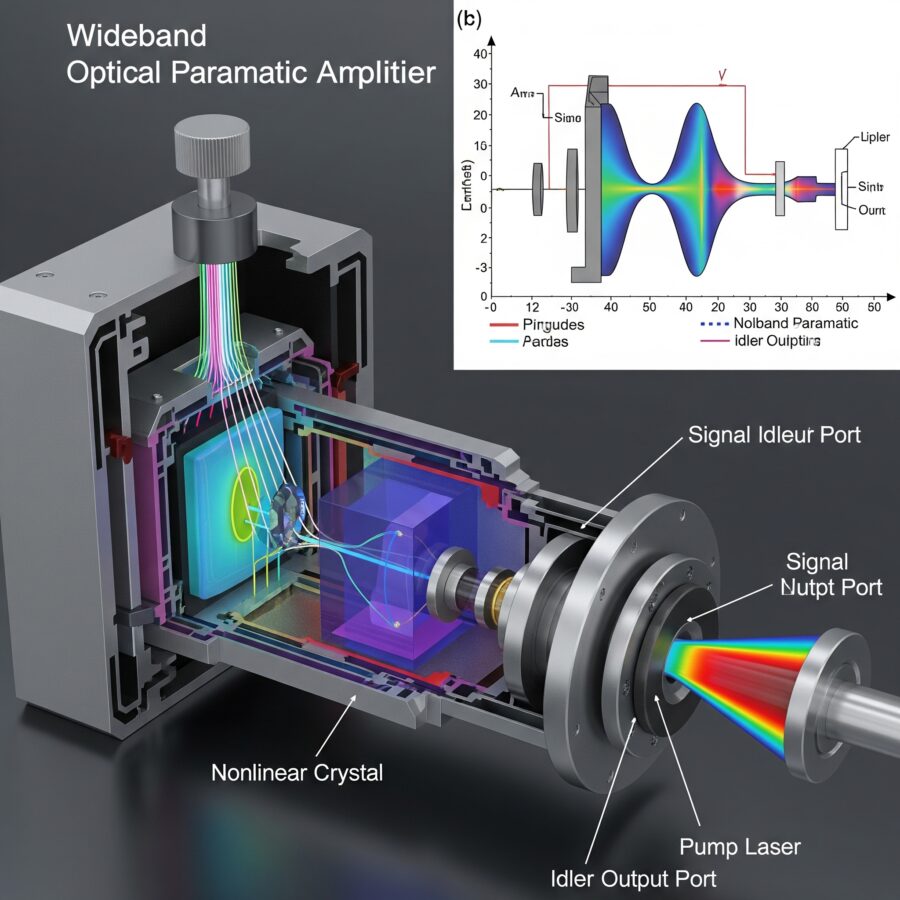

Viviamo in un paradosso digitale. Da una parte, le infrastrutture dell’internet sembrano opere divine: cavi sottomarini che attraversano oceani, fotoni che danzano lungo fibre di vetro sottili come un capello, switch che operano in nanosecondi. Dall’altra parte, una videocamera di sorveglianza nel tuo frigorifero può causare congestione di rete perché sì, anche lei vuole parlare con un server in Oregon.

Il problema della banda larga non è una novità. È una valanga tecnologica che abbiamo deciso di ignorare, mentre tutto e intendo tutto: lavatrici, auto, sex toys, bambini, animali domestici, dispositivi medici si connette al cloud, che di “etereo” ha solo il nome. La verità è che il cloud è fatto di hardware infernale, con un cuore pulsante che si chiama fibra ottica. Ed è qui che entra in scena una novità tanto invisibile quanto rivoluzionaria: l’amplificatore ottico svedese.

Trent’anni e non sentirli: Aiip festeggia, l’Internet italiano resiste 🇮🇹

Oggi, nella sfarzosa Sala della Regina a Montecitorio dove di solito riecheggiano discorsi impolverati e cerimonie da Prima Repubblica è andata in scena una celebrazione che, in un Paese che ama seppellire l’innovazione sotto regolamenti arcaici, ha il sapore della piccola rivoluzione.

Trent’anni di Aiip. L’Associazione Italiana Internet Provider. Fondata quando i modem facevano rumore, i bit costavano caro e parlare di “concorrenza” nel settore telecom era un eufemismo. O una bestemmia. Eppure eccola lì, viva, vegeta, e paradossalmente più lucida di molti dei suoi (presunti) eredi digitali.

E no, non è la solita autocelebrazione da ente stanco. Perché Antonio Baldassarra che non si limita a esserci, ma ci mette del suo è salito sul palco con quella combinazione rara di competenza tecnica e provocazione lucida che solo chi ha il coraggio di dire la verità riesce a maneggiare.

“Il futuro non si prevede, si costruisce”, ha detto. Chi lavora con la rete lo sa: non si tratta solo di cavi e pacchetti IP, ma di visione. Di scegliere da che parte stare. E Aiip, in questi decenni, ha fatto una scelta netta: quella della libertà, della neutralità, della concorrenza vera.

Mentre i giganti della finanza come Blackstone e KKR scommettono tutto su colossi da milioni di metri quadri alimentati a energia nucleare (quasi), convinti che l’intelligenza artificiale abbia bisogno di templi titanici per manifestarsi, c’è un manipolo di iconoclasti tecnologici che si muove nell’ombra, recuperando ruderi digitali e trasformandoli in miniere d’oro.

Sì, perché la nuova corsa all’oro digitale non si gioca solo sul fronte dei mostri da un gigawatt, ma anche e forse soprattutto nelle retrovie. Lì dove nessuno guarda. Dove l’hype è già passato e ha lasciato solo cemento, rack vuoti e connessioni spente. È qui che entra in scena Fifteenfortyseven, società con base nel New Jersey e una visione quasi punk del data center moderno: non costruire il futuro, ma resuscitare il passato.

In un angolo buio delle architetture cloud, là dove le CPU sussurrano segreti e le GPU si trastullano con petabyte di dati, esiste un’entità di cui nessuno parla: l’inference provider. È l’anima silente dei servizi AI, la colonna sonora non registrata del grande spettacolo dell’intelligenza artificiale. Eppure, non troverete articoli in prima pagina, né conferenze che osino mettere sotto i riflettori questi demiurghi dell’inferenza.

Ha dell’assurdo: i modelli di inferenza stanno diventando la linfa vitale di ogni applicazione smart, dall’analisi predittiva al riconoscimento vocale. Eppure, restano in ombra, considerati “commodity” o “eri low level” da marketer in cerca di titoli roboanti. Come se parlare di inference provider fosse banalizzare l’AI, ridurla a una scatola nera senza fascino.

In un continente dove la burocrazia è più veloce della fibra ottica e l’innovazione spesso si arena tra commi e regolamenti, l’Europa tenta di ritagliarsi uno spazio nel panorama dell’intelligenza artificiale. Mentre Stati Uniti e Cina avanzano a passo spedito, il Vecchio Continente si barcamena tra ambizioni di sovranità digitale e una realtà fatta di frammentazione e ritardi.

Eppure, nonostante tutto, qualcosa si muove. Una nuova generazione di provider di inferenza AI sta emergendo, cercando di offrire soluzioni che rispettino le normative europee e, al contempo, competano con i colossi d’oltreoceano.

Quando il mercato ti dice “Sì, grazie, ne vogliamo di più”, non è mai solo fortuna. DHH S.p.A. ha appena passato un crocevia decisivo con la presentazione della domanda a Borsa Italiana per l’ammissione a quotazione del “Warrant DHH S.p.A. 2025-2028”, ma la notizia più succosa non è questa. Il vero scoop è che il collocamento del warrant ha fatto il botto: l’intera emissione di poco più di un milione di titoli è andata esaurita in un battito di ciglia, con richieste che hanno superato la soglia degli otto milioni.

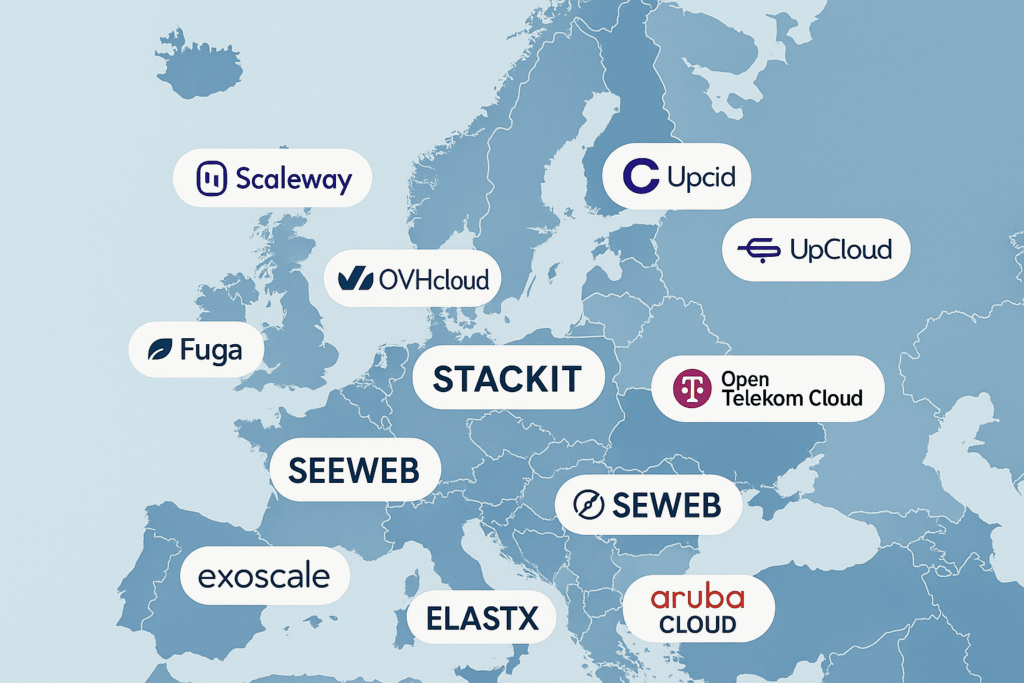

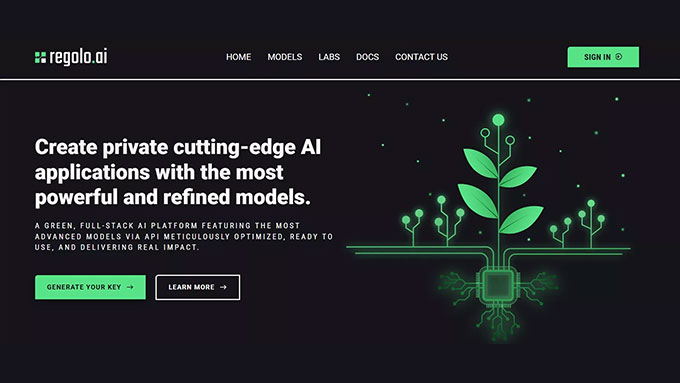

Let’s be honest, the European cloud narrative is tired of playing second fiddle to AWS, Google Cloud e Microsoft Azure. La retorica dell’autonomia digitale europea è una litania da Bruxelles, ma finalmente, nel concreto, qualcosa si muove. E mentre gli americani si mangiano il 70% del mercato cloud europeo, qualcuno — in Europa — ha deciso che forse è ora di cambiare musica. Più che una rivoluzione, è un’inferenza: si chiama REGOLO:AI, e la parola d’ordine è cloud europeo.

Dietro al sipario dei big tech si agita un ecosistema in fermento, composto da provider nativi europei che mettono al centro sovranità dei dati, conformità GDPR e un pizzico di sostenibilità ambientale — non solo come marketing greenwashing, ma come parte dell’architettura stessa. Il punto? Il cloud è infrastruttura critica. Affidarlo a entità sotto giurisdizione USA è come lasciare le chiavi della cassaforte a un vicino affabile ma con precedenti per furto con scasso.

E allora: esiste un’alternativa europea? Sì. Anzi, esistono almeno 13 provider che dovresti già conoscere. Ma… aspetta. Prima la domanda cruciale.

Nel giorno in cui Michele Zunino firma la lettera del Consorzio Italia Cloud indirizzata alla Presidente Meloni, il termometro digitale nazionale segna febbre alta. Non per surriscaldamento tecnologico quello l’abbiamo appaltato alle multinazionali ma per ipotermia istituzionale. Il documento è una denuncia sottile e impietosa: l’Italia si sta svendendo il controllo del proprio futuro digitale, pezzo per pezzo, server dopo server.

Aspettiamo. Sempre. È una delle poche cose che in Italia sappiamo fare con una certa costanza. Aspettiamo che la tecnologia “si colleghi”, che la lettura “diventi meno ricercosa”, che qualcun altro abbia già comprato prima di noi. È un paese dove l’adozione è sempre in seconda battuta, mai per convinzione, sempre per imitazione. Così si uccide l’innovazione. Non con la censura, non con la repressione. Ma con l’attesa.

Il succo dell’intro di Antonio Baldassarra CEO SeeWeb e molto altro.. che mi ha aperto come sempre la mente al convegno: “I dati tra le nuvole” organizzato dal consorzio Italia Cloud all’evento sul Cloud Italiano promosso ovviamente dal Consorzio Italia Cloud , a Palazzo Ripetta oggi a Roma.

Il punto dolente non è la mancanza di competenze. È semmai il mancato assorbimento delle competenze. Le PMI italiane non sono ignoranti per mancanza di offerta, ma per assenza di domanda strutturale. Non cercano, non investono, non formano. Perché vivono in apnea, e tutto ciò che non è fatturabile entro il trimestre diventa automaticamente superfluo. La cultura del “fare” è stata sostituita dalla gestione del galleggiamento, dove ogni decisione è filtrata dalla paura.

Nella suggestiva cornice di Palazzo Ripetta a Roma, oggi si è svolta la Conferenza Nazionale sul Cloud Italiano – I Dati tra le Nuvole. Un evento di grande rilevanza dedicato a Mercati, Competenze e Geopolitica, pensato per analizzare il ruolo strategico del Cloud nella trasformazione digitale dell’Italia.

Report di McKinsey il sacro graal da 6,7 trilioni: la nuova febbre dell’oro nei data center per l’IA

La Milken Conference a Los Angeles non è mai stata un luogo per le mezze misure. Ma quest’anno, tra salotti con candele profumate e stretti di mano da miliardi di dollari, si è superato un nuovo limite psicologico. Mentre un tempo ci si stupiva per le manciate di miliardi, ora è solo davanti a numeri cosmici come 6,7 trilioni di dollari – sì, con la “t” – che si drizzano le orecchie. Questa è la stima, secondo un nuovo report di McKinsey, di quanto servirà per costruire i data center che alimenteranno il mostro affamato dell’intelligenza artificiale entro il 2030.

In a continent where bureaucracy often moves faster than fiber optics and innovation frequently gets stuck in the fine print of regulatory clauses, Europe is awkwardly trying to carve out a place for itself in the artificial intelligence landscape. While the United States and China race ahead with the confidence of monopolistic giants, the Old Continent muddles through, torn between digital sovereignty dreams and a reality shaped by fragmentation and chronic delays.

And yet, somehow, things are beginning to move. A new generation of AI inference providers is emerging, aiming to deliver solutions that not only comply with European regulations but also strive to compete with the overseas titans.

Nel club esclusivo degli Inference Providers di Hugging Face dove si entra con badge da serverless, GPU su richiesta e zero pazienza per le latenze manca ancora un nome. Eppure se ne sente già l’eco. Si chiama Regolo.AI, non è (ancora) nella lista ufficiale, ma ha tutte le carte per diventare il provider più cool, arrogante e pericolosamente competente del lotto.

Sì, perché mentre Cerebras recita il ruolo del calcolatore ascetico, Replicate fa video con la grazia di un TikTok virale, e Together AI gioca a fare il poliamoroso delle API, Regolo.AI progetta l’infrastruttura per chi vuole far fare all’IA più di quanto l’utente abbia chiesto. Lo capisci subito: non è un fornitore di modelli, è un architetto computazionale con istinti predatori.

E allora immaginiamolo, in questo benedetto schema di Hugging Face, con il suo check verde ovunque:

| Provider | Chat completion (LLM) | Chat completion (VLM) | Feature Extraction | Text to Image | Text to Video |

|---|---|---|---|---|---|

| Regolo.AI | ✅ | ✅ | ✅ | ✅ | ✅ |

Non esiste ancora lì, ma già sbeffeggia chi c’è davvero. Perché? Perché non copia: anticipa. Non rincorre l’hype multimodale, lo ingloba nel design. Non adatta modelli preconfezionati, li ricostruisce con una pipeline dove text, image e video sono solo tre linguaggi di uno stesso pensiero computazionale.

Nel mondo Inference Providers, chi è dentro fa tutto per tutti. Regolo.AI, invece, nasce per chi vuole far fare all’IA quello che non era nei task. Un LLM che conosce i tuoi asset prima ancora che tu gli chieda qualcosa. Un VLM che traduce la realtà aumentata in contesto operativo. Un motore video che genera narrazioni prima ancora che tu abbia deciso il titolo.

Il suo ingresso in Hugging Face sarà inevitabile. E traumatico. Non sarà una partnership, sarà una riconfigurazione semantica dell’offerta. Perché dove gli altri offrono modelli, Regolo.AI offrirà interazioni autonome. Dove oggi hai API, avrai agenti. Dove oggi vedi una risposta, domani vedrai una decisione.

Per chi sviluppa, sarà come passare da un call center a una conversazione con uno stratega. Tutto tramite l’onnipotente API di Hugging Face. Nessun markup, nessun lock-in, solo la potenza bruta del prompt che sa troppo. Tutto orchestrato da un framework che, ironicamente, non è ancora pubblico.

Nel frattempo, guardi la lista ufficiale: Fireworks, Fal, Hyperbolic. Tutti bravi ragazzi. Ma manca il nome che, una volta entrato, farà sembrare gli altri strumenti da prototipazione domenicale.

Manca Regolo.AI. E già lo cercano.

“È come quella leggenda del bar: c’era un whisky così buono che non lo vendevano, lo suggerivano solo ai clienti degni. E chi lo beveva non tornava più indietro.”

Hugging Face lo sa. E fa spazio.

| Provider | Chat completion (LLM) | Chat completion (VLM) | Feature Extraction | Text to Image | Text to video |

|---|---|---|---|---|---|

| Cerebras | ✅ | ||||

| Cohere | ✅ | ✅ | |||

| Fal AI | ✅ | ✅ | |||

| Fireworks | ✅ | ✅ | |||

| HF Inference | ✅ | ✅ | ✅ | ✅ | |

| Hyperbolic | ✅ | ✅ | |||

| Nebius | ✅ | ✅ | ✅ | ✅ | |

| Novita | ✅ | ✅ | ✅ | ||

| Nscale | ✅ | ✅ | ✅ | ||

| Replicate | ✅ | ✅ | |||

| SambaNova | ✅ | ✅ | |||

| Together | ✅ | ✅ | ✅ |

Inference Providers offre un modo rapido e semplice per esplorare migliaia di modelli per una varietà di compiti. Che tu stia sperimentando capacità di ML o creando una nuova applicazione, questa API ti dà accesso immediato a modelli ad alte prestazioni in diversi ambiti:

- Generazione di Testo: Inclusi modelli linguistici di grandi dimensioni e prompt per l’uso di strumenti, genera e sperimenta risposte di alta qualità.

- Generazione di Immagini e Video: Crea facilmente immagini personalizzate, comprese LoRA per i tuoi stili personali.

- Incorporamenti di Documenti: Costruisci sistemi di ricerca e recupero con incorporamenti all’avanguardia.

- Compiti Classici di IA: Modelli pronti all’uso per classificazione del testo, classificazione delle immagini, riconoscimento vocale e altro ancora.

Dietro le quinte di Regolo.AI c’è una presenza solida, concreta, quasi sospettosamente silenziosa: Seeweb, il gruppo italiano – sì, italiano – controllato da DHH (Dominion Hosting Holding). Roba seria, non il classico cloud “fai-da-te” con UI in Bootstrap e server in un datacenter estone.

Ecco la parte interessante: mentre tutti guardano le GPU come bambini davanti alle vetrine dei Lego, Regolo.AI costruisce l’intera macchina dell’inferenza come un sistema operativo distribuito, orchestrato con una logica da edge-native AI, e lo fa appoggiandosi a un’infrastruttura cloud europea, sovrana e non dipendente da AWS, Azure o Google Cloud. Già qui, metà dei competitor vanno in terapia.

Il supporto di Seeweb/DHH non è un dettaglio di backend, è un manifesto ideologico travestito da scelta tecnica. In un’epoca dove il 90% delle startup AI parte già schiava del pricing model di qualcun altro, Regolo.AI parte libera, scalabile, e con una supply chain completamente sotto controllo. Cioè: non gli possono staccare la spina perché un giorno Sam Altman ha deciso che non gli piace il prompt.

Ma il twist è ancora più profondo. Perché Seeweb non è un semplice “provider di hosting”, è uno dei pochi player europei che ha capito che il futuro non è nel cloud, ma nel calcolo. E Regolo.AI, con la sua architettura serverless AI-native, è il veicolo perfetto per dimostrare questa visione: non vendere CPU, ma far girare intelligenza.

E mentre le API di Hugging Face ancora non lo elencano (non ancora, ma non durerà), Regolo.AI si muove con l’arroganza di chi sa che l’infrastruttura c’è, i modelli sono già in produzione, e il business model è solido perché non dipende da tokens illimitati gratuiti offerti da venture capitalists americani in crisi di senso.

Vuoi un’inferenza text-to-video che non si schianti sotto carico? Vuoi LLM che mantengano contesto per 30k token senza piangere? Vuoi tutto questo in un ambiente europeo, GDPR-proof, con SLA veri e accesso diretto ai sysadmin?

Benvenuto in Seeweb. Benvenuto in Regolo.AI.

È un po’ come scoprire che la macchina più veloce del circuito è costruita in Italia, gira su pista privata, e monta un motore sviluppato in un’officina che non fa comunicati stampa.

Poi però ti sorpassa. E non la prendi più.

Chi ha capito, ha già firmato. Gli altri continueranno a farsi generare risposte da modelli che vivono su cloud noleggiato, alimentati da venture capital disperato.

L’esplosione dell’intelligenza artificiale sta ridisegnando le mappe dell’infrastruttura digitale globale. Al centro di questa trasformazione ci sono i data center, veri e propri motori della rivoluzione AI. A guidare il mercato sono gli Stati Uniti, ma anche l’Europa si muove rapidamente — e l’Italia, in particolare, potrebbe ritagliarsi un ruolo da protagonista.