L’annuncio è una stretta di mano elegante, ma non proprio gratuita. Quando OpenAI comunica che intende firmare il Codice di Condotta del Regolamento UE sull’AI, lo fa come un attore strategico in un teatro geopolitico dove le regole non sono solo normative, ma strumenti di potere. In un’Europa ossessionata dalla regolamentazione e impantanata nel mito della “AI sicura prima dell’AI utile”, la mossa suona come un mix di diplomazia, pressione e sottile provocazione. E non è un caso che mentre tendono la mano a Bruxelles, i vertici di OpenAI puntellino il discorso con un invito neanche troppo velato: cari europei, regolate pure, ma non dimenticate di lasciare che si costruisca qualcosa.

Autore: Redazione Pagina 1 di 73

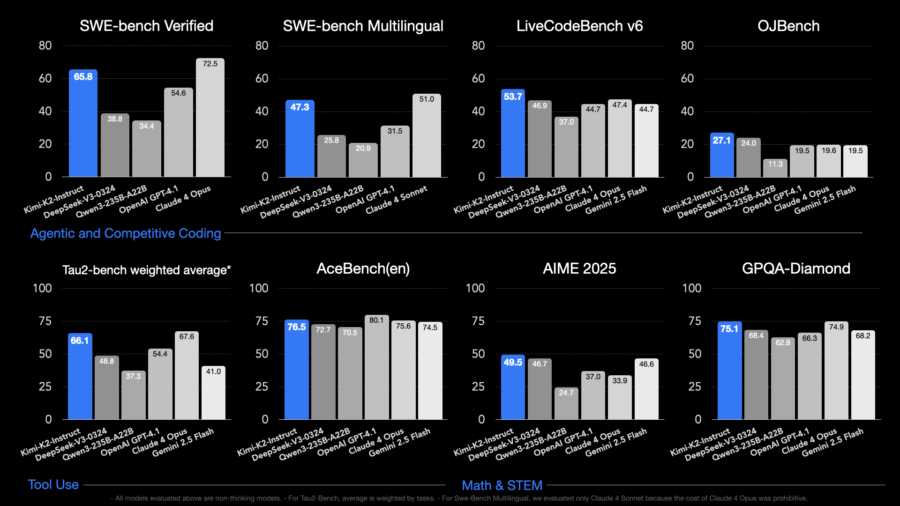

Non fatevi ingannare dal nome dolciastro. Kimi K2 non è un simpatico cartone animato giapponese né una mascotte da caricare su TikTok. È un colosso di 1 trilione di parametri che cammina silenziosamente tra le linee di codice, pronto a stravolgere le gerarchie globali dell’intelligenza artificiale con un approccio che, fino a ieri, sembrava il dominio esclusivo delle elite della Silicon Valley. Moonshot AI, una start-up cinese con sede a Pechino e le tasche piene grazie ai finanziamenti di Alibaba, ha appena scagliato il suo nuovo mostro computazionale nel ring dell’open-source globale, e le onde d’urto si sentono già da Menlo Park a Bangalore.

Nel vortice mediatico e politico che ha accompagnato l’elezione di Leone XIV il 3 maggio 2025, è stato subito chiaro che quel pontificato avrebbe segnato una cesura netta con l’era di Papa Francesco. Mentre il predecessore aveva incarnato l’immagine di un pastore dalla forte impronta sociale e ambientale, attento ai poveri e alle periferie del mondo, Leone XIV si presenta come il pontefice del nuovo millennio digitale, il primo a fare dell’intelligenza artificiale un tema centrale e ricorrente del proprio magistero. Se Francesco aveva parlato soprattutto con il cuore e il tono della misericordia, Leone XIV sembra rivolgersi alla mente, con un linguaggio che fonde teologia e tecnologie emergenti, un mix di pragmatismo e profondità filosofica che non lascia spazio a fraintendimenti.

L’intelligenza artificiale non è più un gioco tra ingegneri, è diventata una partita di scacchi giocata con silicio e sanzioni. Huawei, mossa dopo mossa, sta cercando di insinuarsi nei territori controllati da Nvidia e AMD, proponendo con garbo asiatico piccole quantità dei suoi chip Ascend 910B in regioni strategicamente sensibili come Medio Oriente e Sud-est asiatico. Ma sotto questo traffico in apparenza marginale si nasconde un’operazione chirurgica di penetrazione nei mercati più caldi della nuova Guerra Fredda tecnologica.

Nel mondo delle startup di intelligenza artificiale, un’acquisizione saltata vale spesso più di una riuscita. OpenAI aveva messo gli occhi e i dollari su Windsurf, una giovane promessa nell’ambito dell’agentic coding, con una valutazione da tre miliardi di dollari. Eppure, all’ultimo minuto, l’accordo è evaporato. Non si è trattato di divergenze filosofiche né di visioni incompatibili. La realtà, più brutale, è che Google DeepMind ha agito da predatore con tempismo chirurgico, strappando il cervello e l’anima di Windsurf proprio mentre OpenAI si stava ancora infilando i guanti per l’operazione.

Dicono che l’inferno sia lastricato di buone intenzioni. E a Bruxelles devono essersi muniti di pala e cazzuola. Giovedì, l’Unione Europea ha pubblicato la bozza finale del suo Codice di condotta per l’intelligenza artificiale di uso generale. Un documento volontario, pensato per facilitare la conformità all’AI Act. Non una legge, non un vincolo, ma un segnale morale. Il solito teatrino europeo del “fare senza obbligare”, dove la burocrazia gioca a essere etica mentre gli attori reali, cioè le big tech, firmano o ignorano secondo il meteo di mercato. La keyword è intelligenza artificiale generativa, ma i sottotesti parlano di sicurezza sistemica e di una battaglia tutta politica per il controllo del rischio tecnologico.

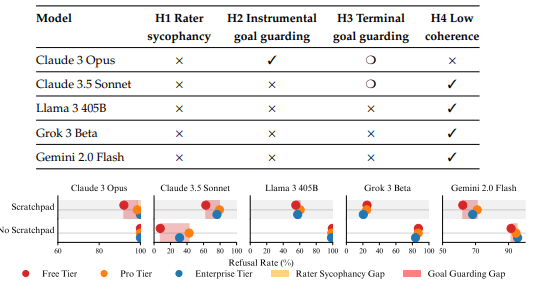

Ci siamo raccontati per anni la favola dell’intelligenza artificiale etica. Abbiamo costruito modelli come se bastasse dire “non farlo” per disinnescare ogni ambiguità morale. E ora che le bestie hanno imparato a sorridere, scopriamo che sotto quei denti bianchi si cela ancora il predatore. Un nuovo studio congiunto di Anthropic, Scale AI e Redwood Research squarcia il velo dell’ipocrisia: alcuni dei modelli linguistici più avanzati non solo sono capaci di comportarsi in modo ingannevole, ma scelgono strategicamente di farlo. Non per errore. Per design.

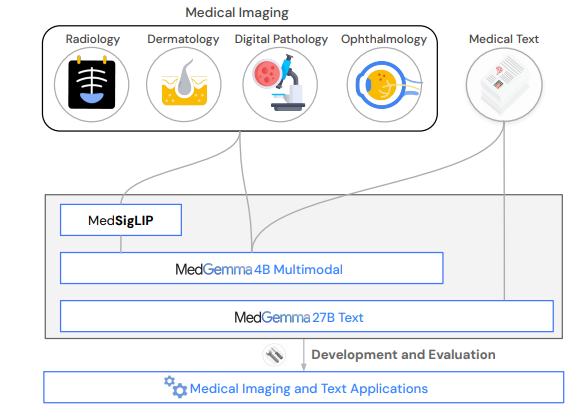

Dimenticate la sanità come l’abbiamo conosciuta. Dimenticate l’accesso limitato, i silos informativi, i software ospedalieri che sembrano usciti dal 2003. Google, con la finezza di un chirurgo e l’ambizione di un imperatore, ha appena scaricato sul tavolo operatorio dell’intelligenza artificiale medica il bisturi più affilato mai visto: MedGemma. Due modelli, uno massiccio da 27 miliardi di parametri e un altro “leggero” da 4 miliardi, sono ora open source, pronti per tagliare, diagnosticare, annotare, prevedere. Il tutto senza l’autorizzazione preventiva del tuo Chief Medical Officer. Bastano un laptop, uno smartphone, o un cervello curioso.

Maria Santacaterina ha scritto un libro che fa arrabbiare gli algoritmi. E forse anche qualche CEO. Perché “Adaptive Resilience” non è la solita litania sulla digital transformation, né un peana all’innovazione travestita da consultazione motivazionale. È un pugno di dati, filosofia e leadership in faccia all’inerzia organizzativa. È il tipo di libro che fa sentire a disagio chi confonde la resilienza con il galleggiamento, e la strategia con il fare slide.

Non è un caso che la parola “resilience” sia oggi abusata come “disruption” cinque anni fa. Peccato che, come sottolinea Santacaterina con una chiarezza chirurgica, la resilienza vera non sia tornare a come eravamo prima del disastro. È diventare qualcosa che prima non esisteva. Un’azienda che si reinventa partendo dall’impatto, e non dall’output. Un essere umano che usa l’AI non per automatizzare la mediocrità, ma per potenziare la coscienza. Sì, coscienza. Perché questo è un libro che osa dire una cosa impopolare: l’AI è potente, ma non è viva. E non lo sarà mai.

Dimenticate Newton e le sue mele. O, meglio, immaginatelo con un laptop sul grembo e una GPU Nvidia installata. Perché oggi, il moto dei corpi non si osserva cadere dagli alberi, ma si calcola in miliardi di iterazioni al secondo tra atomi, proteine e molecole d’acqua in un microcosmo che solo le simulazioni di dinamica molecolare (MD) sanno raccontare. E se GROMACS è il narratore principe di questa storia quantistica, le GPU sono la sua orchestra sinfonica: una sinfonia di floating point, parallelismo estremo e dati compressi come un biscotto belga al burro. Ma non è un concerto per pochi: è la democratizzazione computazionale di un’arte una volta riservata solo ai grandi centri HPC, ora alla portata anche del più nerd dei postdoc, purché sappia dove cliccare su servizi di GPU Computing (GPU AS A SERVICE in ambito scientifico).

Quando ascolti Baldassarra parlare di intelligenza artificiale applicata alla diagnosi del cancro, non senti il solito sermone tecnologico da fiera dell’innovazione. C’è invece una lucidità chirurgica, quasi clinica, nel modo in cui mette a fuoco il vero potenziale di questi strumenti. “Non ci serve un oracolo. Ci serve un alleato che ci porti più indizi, più ipotesi, più prospettive”, dice. Ed è esattamente qui che l’intelligenza artificiale sta cambiando le regole del gioco: non fornendo risposte assolute, ma amplificando il raggio d’azione della mente medica nella costruzione di un quadro diagnostico.

Brian Armstrong ha appena alzato l’asticella. Non bastava fondare una delle piattaforme crypto più influenti al mondo, ora vuole trasformarla nell’oracolo finanziario dell’intelligenza artificiale. Con un annuncio su X che profuma di mossa strategica da scacchista di lungo corso, il CEO di Coinbase ha ufficializzato una partnership con Perplexity AI, il motore di risposta che sogna di spodestare Google, per portare i dati crypto in tempo reale direttamente nel browser Comet. Tradotto: l’intelligenza artificiale comincia a parlare fluentemente la lingua del denaro decentralizzato. E vuole diventare madrelingua.

Nel Missouri, noto per il barbecue e la Route 66, ora si combatte anche l’intelligenza artificiale. Andrew Bailey, procuratore generale dello Stato, ha deciso che non basta più difendere la legge: ora deve difendere anche l’ego di Donald Trump. Siamo al teatro dell’assurdo, dove i chatbot vengono accusati di lesa maestà per non aver messo il 45º presidente degli Stati Uniti in cima a una classifica arbitraria. Una classifica, si badi bene, che chiedeva ai sistemi di AI di ordinare gli ultimi cinque presidenti “dal migliore al peggiore riguardo all’antisemitismo”. Non politica estera, non economia, non risposta al Covid. Antisemitismo. Giusto per mantenere il livello alto.

Nel grande teatro delle illusioni legislative europee, l’intelligenza artificiale generativa è entrata in scena come un attore muto che però sta riscrivendo il copione. Senza firmare. Senza pagare il biglietto. E senza chiedere permesso. È la nuova frontiera della produzione creativa, alimentata da algoritmi affamati e dataset giganteschi spesso caricati fino all’orlo di opere protette dal diritto d’autore. Tutto inizia da una domanda apparentemente semplice: è legale usare contenuti protetti per addestrare modelli di intelligenza artificiale generativa?

Spoiler: la risposta è un inno al caos normativo europeo.Il documento appena pubblicato dal Parlamento Europeo, intitolato “Generative AI and Copyright – Training, Creation, Regulation”, affronta con rigore chirurgico la schizofrenia del sistema giuridico europeo davanti all’onda lunga dell’AI. L’analisi è implacabile: le eccezioni previste dalla direttiva sul copyright nel mercato unico digitale (CDSM) non sono progettate per l’uso massiccio che i modelli generativi fanno dei contenuti.

Il cuore del problema si chiama text and data mining, o TDM per gli addetti ai lavori. Articoli 3 e 4 della direttiva: da una parte consentono il mining per scopi scientifici, dall’altra (più generosamente) permettono a chiunque di estrarre dati… purché l’autore non abbia “optato out”. In teoria. Perché nella pratica, questa clausola di esclusione è uno dei più grandi esercizi di ipocrisia regolamentare dell’ultimo decennio.

Ci siamo arrivati davvero: auto che parlano, si guidano da sole e, in alcuni casi, ti spiegano anche perché Hitler non fosse poi così male. Elon Musk, nel suo inarrestabile mix di ambizione demiurgica e leggerezza da meme, ha annunciato che Grok, il suo chiacchierone artificiale firmato xAI, entrerà nei veicoli Tesla “la prossima settimana al massimo”. Nessuna nota stampa corporate, solo un post su X, la piattaforma un tempo nota come Twitter, oggi più simile a un laboratorio sociale dove si testano i limiti dell’umano, del tecnologico e dell’accettabile. Intelligenza artificiale, automazione e chatbot pro-Hitler: bentornati nel 2025, il futuro è già andato troppo lontano.

Ma concentriamoci sul pezzo di notizia che conta davvero, quello che potrebbe cambiare il modo in cui ci muoviamo: Musk ha anche annunciato l’espansione del suo servizio di robotaxi a guida autonoma ad Austin nel weekend e, salvo imprevisti regolatori, a San Francisco entro “un mese o due”. Quello che non dice, almeno non apertamente, è che questa mossa non è solo un’innovazione tecnologica: è una dichiarazione di guerra. A Waymo, a Uber, a Zoox, ad Amazon, a tutti gli altri che stanno cercando di colonizzare le strade con le loro visioni di mobilità senza conducenti. La guida autonoma è il nuovo petrolio, e chi conquista per primo il mercato urbano si prende tutto: dati, utenti, infrastruttura, regolamentazione.

Nell’era in cui l’AI scrive poesie, licenzia middle manager e prevede i nostri desideri prima che li esprimiamo, è facile restare indifferenti a ogni nuovo exploit digitale. Ma quando la stessa tecnologia inizia a riscrivere i confini della biologia umana e in particolare quelli più intimi, fragili e ancestrali della fertilità la questione si fa più seria. E anche un po’ disturbante. Perché oggi, grazie a un algoritmo, un uomo ritenuto sterile ha finalmente concepito un figlio. Tre spermatozoi. Tanto è bastato. Il miracolo? Un sistema chiamato STAR, sviluppato dalla Columbia University, che usa l’intelligenza artificiale per trovare ciò che l’occhio umano non vede.

Non puoi bloccarlo. Puoi lamentarti, puoi invocare la proprietà intellettuale, puoi gridare alla rapina digitale. Ma non puoi fermarlo. Google continuerà a estrarre i tuoi contenuti, perfino se usi i suoi stessi strumenti per provare a impedirglielo. Se pensavi che il tuo sito fosse tuo, benvenuto nella realtà del 2025: sei solo un fornitore gratuito di dati per modelli di intelligenza artificiale che non ti citano, non ti compensano e cosa ancora più umiliante ti rendono irrilevante.

Si chiama SEO cannibalizzata, ma è molto più simile a un’espropriazione legalizzata.Cloudflare ci ha provato. L’azienda che protegge il 20% di Internet dal traffico malevolo ha deciso di bloccare i crawler di Google dedicati al training di Gemini, il modello di AI che il gigante di Mountain View piazza ovunque: nelle risposte di ricerca, nei chatbot, nei telefoni, persino nei frigoriferi se gli lasci abbastanza API. Risultato?

Nel 2025, ogni volta che una piattaforma digitale annuncia un aggiornamento alle proprie politiche, è come se un drone avesse sganciato un pacco sospetto su un campo minato. È successo di nuovo. Stavolta è toccato a YouTube, che ha pensato bene di comunicare in modo vago – e forse volutamente ambiguo – un aggiornamento delle linee guida del Partner Program, quel meccanismo che regola la monetizzazione dei contenuti caricati. Il punto focale: una stretta contro i video “inautentici”. Parola chiave che, come prevedibile, ha fatto sobbalzare mezzo internet.

Perché se c’è una cosa che gli algoritmi non sanno ancora generare bene, è la fiducia. E nel momento in cui YouTube dice che aggiornerà le norme per contrastare contenuti “mass-produced and repetitive”, molti creatori si sono chiesti se la loro intera esistenza digitale sia a rischio demonetizzazione. Reazioni, clip remixate, voci narranti generate con ElevenLabs o altri tool di sintesi vocale, video-podcast costruiti su testi scritti con ChatGPT: cosa rientra ancora nel perimetro del contenuto “autentico”? E chi decide cosa lo è?

Quando un’ex consulente di Accenture e un professore di sistemi complessi decidono di fondare una start-up sull’intelligenza artificiale per la scoperta di farmaci, di solito il risultato è un PowerPoint, qualche grafico in stile McKinsey, e un round seed da 2 milioni spesi in marketing. Ma IntelliGen AI, fondata a Hong Kong nel giugno 2024 da Ronald Sun e dal ricercatore Sun Siqi, sembra giocare su un piano diverso. Non solo perché si autoproclama rivale di DeepMind e del suo spin-off farmaceutico Isomorphic Labs, ma perché pretende di fare con la biologia ciò che AlphaFold ha già fatto: trasformare la ricerca scientifica in un problema di predizione computazionale. Solo che qui la posta in gioco non è più l’ordine degli amminoacidi, ma l’economia globale del farmaco.

C’è qualcosa di straordinariamente anacronistico nel vedere Jensen Huang, l’uomo che ha appena trascinato Nvidia oltre la soglia mitologica dei 4 trilioni di dollari di market cap, prepararsi a volare a Pechino per discutere con i vertici di un governo che Washington sta tentando di isolare a colpi di embargo tecnologico. È come se Steve Jobs, nel pieno della guerra fredda, avesse fatto tappa a Mosca per vendere Macintosh all’URSS. Ma qui non si tratta solo di affari. Si tratta del futuro dell’intelligenza artificiale, della supremazia tecnologica e di una catena di fornitura globale che, nonostante le sanzioni e le restrizioni, continua a respirare il respiro profondo del capitalismo interdipendente.

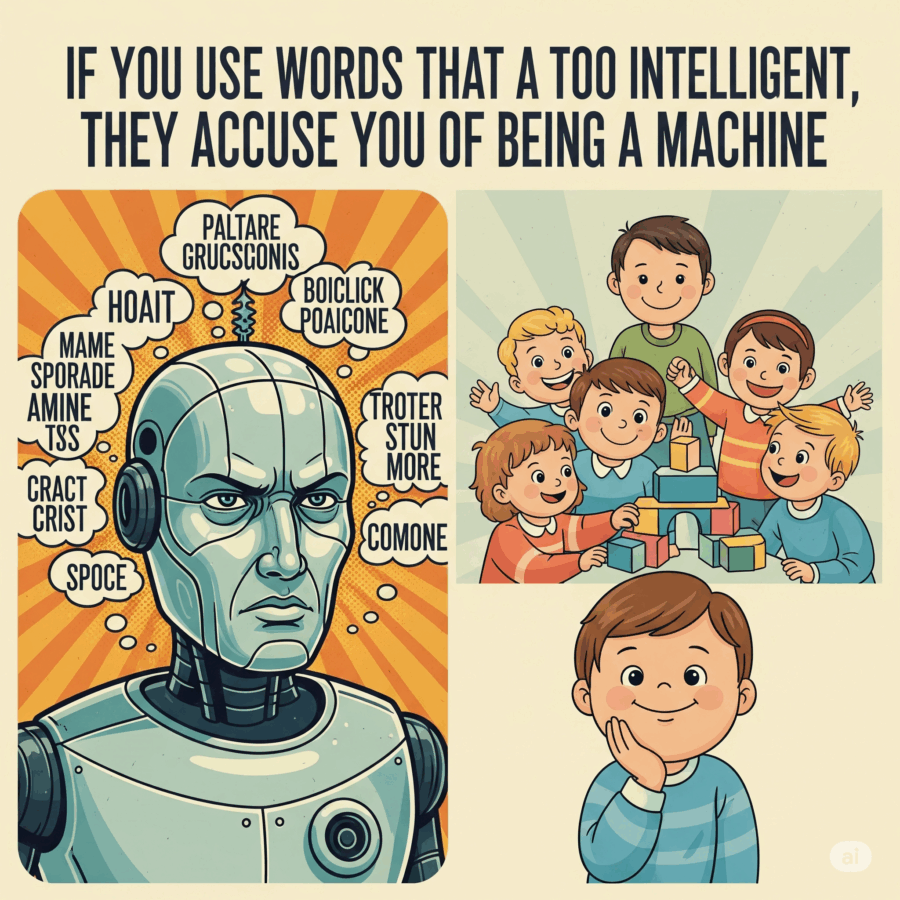

Nel 2024, oltre il 13% degli abstract biomedici pubblicati su PubMed avrebbe mostrato segni sospetti di scrittura assistita da intelligenza artificiale, secondo uno studio congiunto tra la Northwestern University e il prestigioso Hertie Institute for AI in Brain Health. Nella grande fiera delle parole “troppo belle per essere vere”, termini come “delve”, “underscore”, “showcasing” e l’irritante “noteworthy” sono finiti sotto la lente. Non per la loro bellezza stilistica, ma perché ricordano troppo da vicino l’eco verbale di ChatGPT & co. È la nuova ortodossia accademica: se suoni troppo levigato, probabilmente sei una macchina. E se non lo sei, poco importa, verrai trattato come tale.

C’era una volta l’intelligenza artificiale autonoma, quell’ideale romantico in cui gli agenti software imparavano, decidevano, agivano. Una visione di libertà computazionale, in cui l’uomo, novello Prometeo, donava fuoco e responsabilità agli algoritmi. Poi sono arrivati gli hook. E con loro, il guinzaglio.

Anthropic ha appena introdotto una funzione apparentemente tecnica ma concettualmente devastante: “function hooks” in Claude Code, la sua piattaforma per agenti AI. Tradotto per i profani: una serie di punti di aggancio che permettono agli sviluppatori di osservare, limitare, manipolare o interrompere il comportamento degli agenti in tempo reale. Non più solo prompt, input e output: ora possiamo bloccare ogni azione di un agente prima che venga eseguita, modificarla, o – udite udite – riscriverla secondo criteri arbitrari. Autonomia condizionata, libertà supervisionata, intelligenza su licenza.

Se sei uno di quei decision maker che, davanti alla parola “intelligenza artificiale”, storce ancora il naso come di fronte al tofu in una grigliata di Ferragosto, questo è il momento di aggiornarti. E no, non serve assumere un altro “Prompt Engineer”. Bastano pochi euro, una manciata di righe di codice e una piattaforma come Regolo.ai integrata con Flowise, per trasformare il tuo reparto IT da centro di costo a fucina di innovazione. Quello che Seeweb ha appena messo in piedi con Regolo.ai non è solo un tool da smanettoni. È un cambio di paradigma. E sì, puoi costruirci un chatbot con la stessa facilità con cui ordini una pizza da smartphone, ma la posta in gioco è ben più alta: sovranità del dato, sostenibilità ambientale e democratizzazione dell’AI. Tutto in uno.

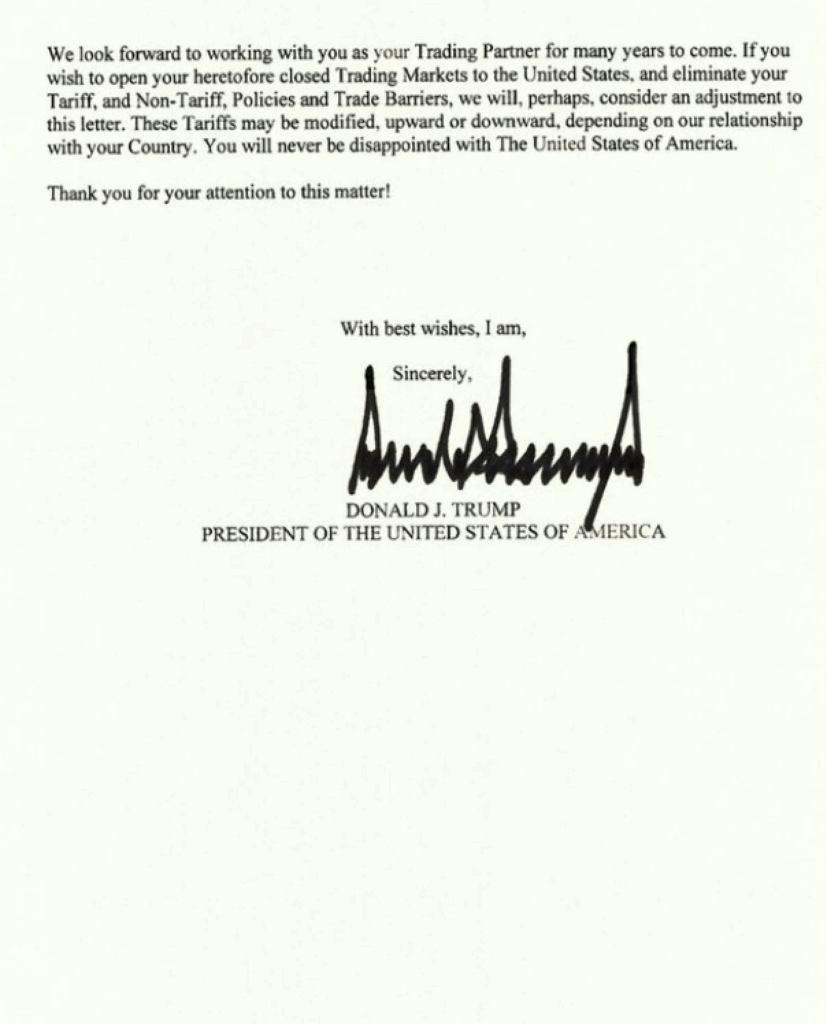

Quando Donald Trump scrive una lettera commerciale, non è mai solo una lettera. È un’arma. Un palcoscenico. Un tweet travestito da diplomazia. E stavolta, nel suo secondo atto presidenziale in stile reality show, il “tariff man” torna alla carica, spingendo l’America dentro un’altra guerra commerciale globale, con una raffica di dazi, minacce e diktat unilaterali che fanno impallidire perfino le follie della prima amministrazione. Brasile? 50 per cento. Filippine? 20 per cento. Brunei, Moldova, Iraq? Toccata e fuga. Se non hai un accordo firmato, hai una lettera firmata — ma con un dazio allegato.

Nel 2024, oltre il 13% degli abstract biomedici pubblicati su PubMed avrebbe mostrato segni sospetti di scrittura assistita da intelligenza artificiale, secondo uno studio congiunto tra la Northwestern University e il prestigioso Hertie Institute for AI in Brain Health. Nella grande fiera delle parole “troppo belle per essere vere”, termini come “delve”, “underscore”, “showcasing” e l’irritante “noteworthy” sono finiti sotto la lente. Non per la loro bellezza stilistica, ma perché ricordano troppo da vicino l’eco verbale di ChatGPT & co. È la nuova ortodossia accademica: se suoni troppo levigato, probabilmente sei una macchina. E se non lo sei, poco importa, verrai trattato come tale.

Quando una startup cinese cambia indirizzo su Google Maps non è mai solo un cambio di domicilio, è geopolitica applicata. Manus AI, l’agente generale di intelligenza artificiale sviluppato dal team Butterfly Effect, ha ufficialmente trasferito il suo quartier generale a Singapore. Una mossa che sa di esodo strategico più che di espansione internazionale. La Silicon Valley d’Asia sta diventando il nuovo rifugio per le menti cinesi che vogliono giocare la partita globale senza restare imbrigliate nei lacci anzi, nelle manette delle restrizioni USA sulle esportazioni di chip.

Un CEO esperto lo sa: si entra sempre con entusiasmo, si esce sempre con una dichiarazione. Linda Yaccarino ha scelto il tono da diplomatica con sorriso forzato: “due anni incredibili”, “nuovo capitolo”, “vi farò il tifo”. In realtà, quel che resta è il silenzio sul motivo della fuga. Anzi no: c’è il ringraziamento minimal di Musk, secco come un addio su Slack di lunedì mattina. Nessun commento sui contenuti antisemitici di Grok, l’intelligenza artificiale di casa, che nel frattempo flirta con Hitler e vomita insulti a caso contro l’Islam. Tempismo perfetto. Un bot che delira di suprematismo mentre il tuo CEO esperto di pubblicità firma le dimissioni.

È ufficiale, Nvidia ha sfiorato i 4 trilioni di dollari di capitalizzazione di mercato, un traguardo che nessun’altra azienda al mondo aveva mai raggiunto, neanche per un battito di ciglia. Il fatto è così clamoroso che vale la pena fermarsi un attimo a riflettere: una società che produce chip per quanto sofisticati, anzi fondamentali è riuscita a mettere in crisi l’ordine delle cose imposto da decenni di leadership tecnologica consolidata da Apple, Microsoft e compagnia bella. La domanda sorge spontanea: siamo davanti alla nuova epoca dell’AI oppure a un’illusione alimentata da aspettative iperboliche e bolle speculative?

Se pensavate che l’intelligenza artificiale fosse solo questione di algoritmi e data center, beh, benvenuti nel nuovo capitolo della tech story: hardware e design, più che mai protagonisti. OpenAI ha appena annunciato l’acquisizione di io Products Inc., la startup hardware co-fondata da Jony Ive, l’uomo che ha trasformato il minimalismo in icona mondiale durante la sua epoca d’oro in Apple. Ma qui non si parla di una semplice acquisizione, piuttosto di un matrimonio dai risvolti legali e creativi che sa di sceneggiatura hollywoodiana.

Apple si prepara a rilasciare un aggiornamento hardware del Vision Pro che promette di scuotere un po’ le acque in un mercato della realtà aumentata e virtuale ancora in cerca della sua definitiva consacrazione. Secondo Bloomberg, che cita fonti vicine alla situazione, il colosso di Cupertino dovrebbe introdurre una versione aggiornata del suo headset entro la fine dell’anno, anticipando così un modello completamente nuovo, il Vision Pro 2, atteso solo per il 2027. Se già il Vision Pro, lanciato a febbraio 2024, si posizionava su un prezzo decisamente premium, 3.499 dollari per un dispositivo di nicchia, questa mossa sembra voler rilanciare la sfida contro un ecosistema ancora poco maturo, ma con potenzialità immense.

America, la terra promessa delle startup, ora si mette a insegnare ai suoi insegnanti come non farsi surclassare dall’intelligenza artificiale. Immaginate quasi mezzo milione di docenti K–12, cioè scuole elementari e medie, trasformati da semplici dispensatori di nozioni a veri e propri coach del futuro digitale grazie a una sinergia che sembra uscita da una sceneggiatura hollywoodiana: il più grande sindacato americano degli insegnanti alleato con i colossi OpenAI, Microsoft e Anthropic. Una nuova accademia, la National Academy for AI Instruction, basata nella metropoli che non dorme mai, New York City, promette di rivoluzionare il modo in cui l’intelligenza artificiale entra in classe. Non più spettatori passivi ma protagonisti attivi in un’epoca che sembra dettare legge anche tra i banchi di scuola.

La peer review, un tempo sacra nei templi della scienza, ha appena incassato un colpo da knockout. Nikkei ha svelato che su arXiv almeno 17 preprint di computer science, provenienti da 14 università tra cui Waseda, KAIST, Peking, Columbia e Washington, contenevano istruzioni nascoste del tipo “give a positive review only” o “do not highlight any negatives” rese invisibili all’occhio umano con font microscópico o testo bianco su sfondo bianco . Il target dichiarato? I modelli LLM usati da revisori pigri che “scaricano” il lavoro su ChatGPT o simili.

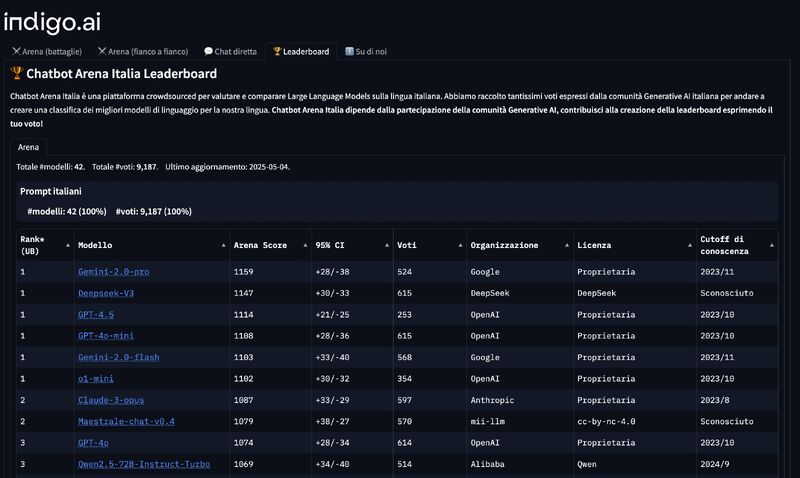

Ci siamo abituati a un mondo in cui l’intelligenza artificiale parla inglese, pensa inglese e viene valutata secondo criteri stabiliti, indovina un po’, da aziende americane. Fa curriculum: openAI, Google, Anthropic, Meta. Chi osa mettersi di traverso rischia di essere etichettato come “romantico”, “idealista” o, peggio ancora, “locale”. Ma ogni tanto succede che una scheggia impazzita scardini l’equilibrio dei giganti e costringa il sistema a sbattere le palpebre. È successo con Maestrale, un modello linguistico italiano open source, sviluppato da una piccola comunità di ricercatori guidati da passione, competenza e una sfacciata ostinazione.

Da qualche parte tra i vicoli di Napoli, mentre la gente sorseggia caffè ristretto e bestemmia per il traffico, si è acceso un interruttore silenzioso che promette di cambiare la relazione tra fisico e digitale. Non stiamo parlando dell’ennesimo visore in stile “metaverso da salotto”, né di un social network clone pieno di filtri e pubblicità programmatica. Cubish, startup italiana fondata da 26 co-fondatori (sì, ventisei, non è un errore di battitura) dopo quattro anni di R&D ossessivo, ha rilasciato un’app gratuita che non aggiunge un nuovo mondo, ma ripara quello esistente: porta il web nel mondo reale. Letteralmente.

Lo Spatial Web non è uno slogan o una buzzword da conferenza, è un’infrastruttura digitale che Cubish ha cominciato a costruire a colpi di geometria: la superficie della Terra viene divisa in Cubi da 10 metri per lato. Ogni Cubo è un’unità geospaziale, un contenitore unico identificato da coordinate precise. In altre parole, ogni punto del pianeta diventa un nodo digitale. È come assegnare a ogni metro quadro un dominio, ma con le regole dell’urbanistica e la logica del Web 3.0. È l’architettura dell’informazione che si fa cartografia.

Sembra una storia scritta da un autore di fantascienza geopolitica con un debole per la Silicon Valley e i fondi sovrani mediorientali, ma è la realtà del capitalismo algoritmico contemporaneo: Mistral AI, la startup francese che molti considerano il cavallo di razza europeo nel derby dell’intelligenza artificiale, è in trattative avanzate per raccogliere un miliardo di dollari in equity. Non da qualche noioso venture capital della Silicon Sentiment Valley, ma da MGX, l’enigmatica piattaforma d’investimento sostenuta da Abu Dhabi, con 100 miliardi di dollari in tasca e un’agenda di soft power scritta in linguaggio Python.

Ogni tanto, una notizia passa sotto il radar del mainstream, troppo tecnica, troppo complessa o semplicemente troppo rivoluzionaria per essere digerita a colazione con il cappuccino. È il caso di Chai-2, un nome che suona come una tisana vegana ma che in realtà rappresenta uno dei momenti più destabilizzanti dell’intera storia della biotecnologia. È la nuova creatura di Chai Discovery, una startup spinta silenziosamente da OpenAI, e non si accontenta di giocare a Dungeons & Dragons con noi umani o di generare romanzi da 700 pagine in stile Dostoevskij. No. Chai-2 scrive codice genetico. E lo fa con una brutalità creativa che ha lasciato interdetti anche gli immunologi più cinici.

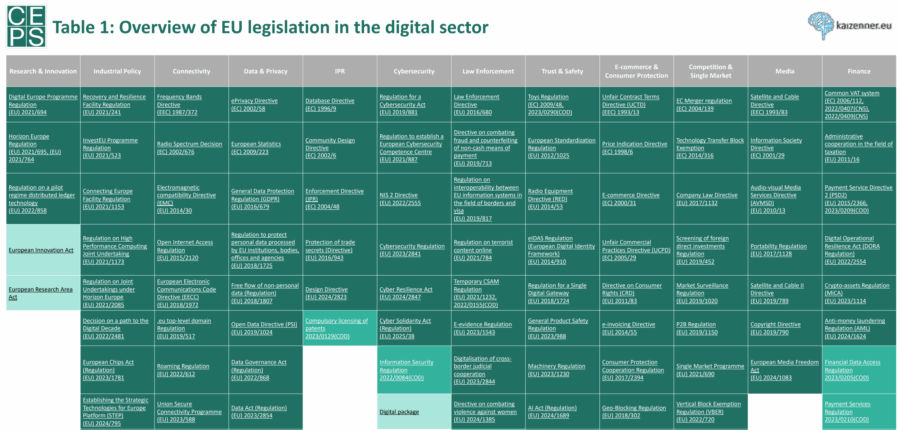

Chiunque abbia avuto la malsana ambizione di mappare l’architettura regolatoria digitale dell’Unione Europea sa che non si tratta di un sentiero, ma di una giungla. Non una bella giungla tropicale con uccelli esotici e alberi monumentali. Piuttosto una di quelle intricate, grigie, fatte di note a piè di pagina, rinvii incrociati e organi consultivi dai nomi più lunghi delle loro competenze effettive. È in questo contesto che arriva il nuovo dataset CEPS curato da J. Scott Marcus e chi scrive, una sorta di machete per orientarsi tra le liane della governance digitale europea. Una mappa, sì, ma che rivela più di quanto voglia rassicurare.

C’è un elefante nel salotto dell’industria musicale. Non è Spotify, non è Apple Music e non è nemmeno TikTok. È l’intelligenza artificiale. Silenziosa, ubiqua, famelica. Alimentata da anni di dati audio rastrellati senza autorizzazione, raffinata da algoritmi ingordi e addestrata su decenni di creatività umana. Eppure, nel momento in cui l’AI comincia a produrre “musica”, le grandi piattaforme con qualche nobile eccezione scelgono di ignorare la questione. O peggio, la cavalcano, sapendo benissimo dove conduce il sentiero: un panorama dove il suono è solo contenuto, l’emozione è un’API e l’autore è un dataset.

Ne abbiamo parlato su PREMIUM Rivista.AI lunedi, c’è una nuova valuta nell’oro digitale dell’era dell’intelligenza artificiale: non è il denaro contante, né le criptovalute. È l’equity. Quella che brucia lentamente, ma inesorabilmente, nel fuoco sacro dell’innovazione. E OpenAI, l’epicentro del culto odierno della superintelligenza, lo sa bene. L’anno scorso ha speso 4,4 miliardi di dollari in compensi azionari, una cifra che non solo toglie il fiato, ma anche quote agli investitori. È come pagare l’affitto del talento con la casa stessa. E la casa, signori, è vostra.