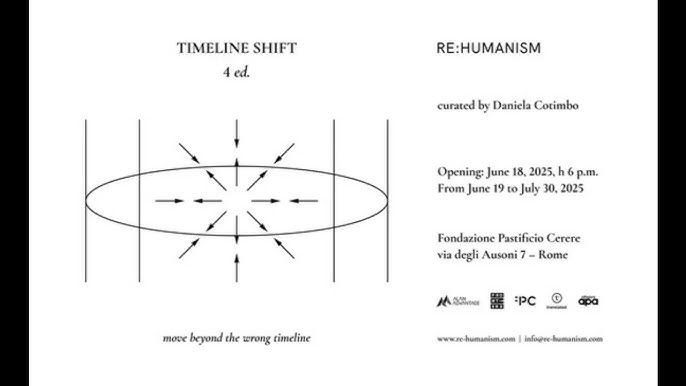

Fondazione Pastificio Cerere, via degli Ausoni 7, Rome

Ci sono momenti in cui la tecnologia smette di essere strumento e si rivela religione. Dogmatica, rituale, ossessiva. Con i suoi sacerdoti (i CEO in felpa), i suoi testi sacri (white paper su GitHub), i suoi miracoli (GPT che scrive poesie su misura), le sue eresie (la bias, l’opacità, il furto culturale). A Roma, il 10 luglio 2025, questo culto algoritmico entra finalmente in crisi. O meglio, viene messo sotto processo con precisione chirurgica. Perché AI & Conflicts Vol. 02, il nuovo volume a cura di Daniela Cotimbo, Francesco D’Abbraccio e Andrea Facchetti, non è solo un libro: è un attacco frontale al mito fondativo dell’intelligenza artificiale come panacea post-umana.

Presentato alle 19:00 alla Fondazione Pastificio Cerere nell’ambito del programma Re:humanism 4, il volume – pubblicato da Krisis Publishing e co-finanziato dalla Direzione Generale Educazione, Ricerca e Istituti Culturali – mette a nudo l’infrastruttura ideologica della cosiddetta “estate dell’AI”. Un’estate che sa di colonizzazione dei dati, di estetiche addomesticate, di cultura estratta come litio dal sottosuolo cognitivo dell’umanità. Se questa è la nuova età dell’oro, allora abbiamo bisogno di più sabotatori e meno developers.