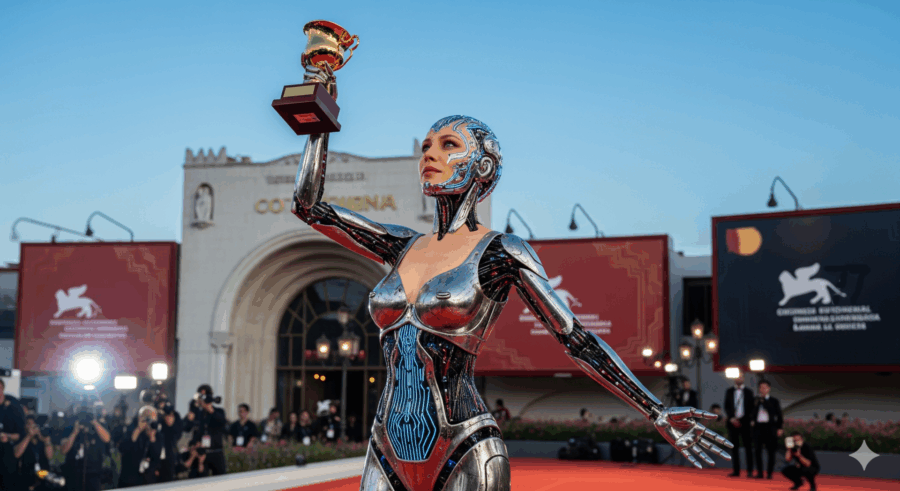

Alla Mostra del Cinema di Venezia quest’anno i riflettori non sono puntati solo sui film e sul red carpet, ma anche su un ospite inatteso: l’intelligenza artificiale. Non una comparsa, ma quasi una protagonista, capace di dividere platea e addetti ai lavori tra chi intravede scenari distopici e chi, invece, fiuta nuove possibilità creative. Eh si, perché autori, attori e doppiatori hanno fatto sentire la loro voce sul tema. L’accusa: l’AI rischia di “fagocitare” il talento umano, sostituire professioni artistiche e ridurre la creatività a un algoritmo di consumo.

Ci sono momenti nella carriera in cui si realizza che la propria vita professionale è stata, a dir poco, sabotata da piani strategici scritti con la calligrafia di Murphy. Cresciuto con la legge di Murphy, credevo di avere una bussola abbastanza solida per navigare nel caos industriale. Poi arrivano i master plan, quei documenti pomposi che promettono rivoluzioni e cambiano il senso della parola “strategia”. Tesla non fa eccezione. Il Master Plan 4 di Elon Musk sembra scritto più per entusiasmare social media e investitori che per guidare ingegneri e tecnici verso obiettivi concreti.

Staying ahead in the age of AI

Avviso ai naviganti: non si tratta di un inno alla supremazia delle macchine, ma della testimonianza di un Technologist sopravvissuto, intrappolato tra slide abbaglianti, promesse roboanti e buzzword che si accalcano in ogni corridoio aziendale come tifosi in curva. La parola d’ordine negli uffici oggi è intelligenza artificiale, declinata in tutte le salse possibili, dal marketing alle risorse umane, ma la realtà spesso somiglia più a un episodio comico di improvvisazione che a una rivoluzione tecnologica studiata nei minimi dettagli.

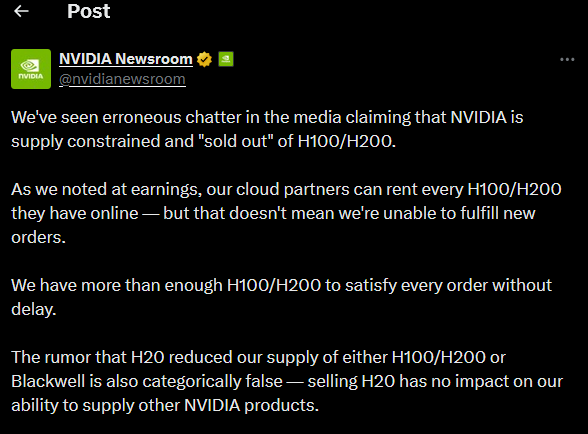

La corsa forsennata dell’AI e la magia dei KPI improvvisati non ha precedenti. Si leggono dati da far girare la testa: la crescita dei modelli “frontier scale” è aumentata di oltre cinque volte in pochi anni, mentre i costi di operare modelli come GPT-3.5 sono diminuiti di centinaia di volte. Numeri perfetti per far brillare gli occhi dei board della Silicon Valley e riempire slide luccicanti, ma nella pratica quotidiana delle imprese medie, la maggior parte dei dipendenti ignora cosa significhi davvero AI generativa. Alcuni, peggio ancora, pronunciano “generative AI” come se fosse un incantesimo segreto e non uno strumento di lavoro.

In questo contesto, KPI di adozione fissati con rigore quasi religioso diventano una religione laica: CEO che impongono venti accessi giornalieri a ChatGPT per dipendente, come se l’uso compulsivo garantisse la saggezza. Il culto dell’AI si manifesta più nelle slide che nelle pratiche quotidiane, mentre la domanda cruciale — “a cosa serve realmente?” — rimane sospesa nell’aria come un fumetto muto in un cartoon aziendale.

Da alignment a disallineamento, la lunga marcia verso la “mission” AI rivela un gap culturale drammatico. OpenAI consiglia di allineare leadership, dipendenti e organizzazione con storytelling accattivante e obiettivi misurabili. Tradotto in ufficio reale, significa riunioni di tre ore in cui i dirigenti celebrano l’amore per l’AI mentre gli ingegneri si chiedono se sopravviveranno alla prossima ristrutturazione. L’AI che “potenzia le competenze” è una poesia sulla carta, nella pratica è un campo minato di frustrazione: dover dimostrare di saper usare strumenti senza un reale supporto strategico genera più errori che successi concreti.

Stavo leggendo un articolo su Telegraph da un po non si parla di Italia ma di Francia, chissa perchè … La Francia, da sempre abituata alle turbolenze politiche, si trova ora ad affrontare una tempesta economica che potrebbe avere ripercussioni sui mercati globali. Con un debito insostenibile, deficit fuori controllo e un sistema di welfare sotto pressione, cresce il timore che Parigi possa diventare l’epicentro di una crisi finanziaria. Il Primo Ministro François Bayrou si prepara a un voto di fiducia cruciale l’8 settembre, con implicazioni che vanno ben oltre i confini francesi.

Nessuno ama parlare di banche fino a quando non si rompe qualcosa. I fondatori di startup scoprono molto presto che la differenza tra una crescita fluida e un inferno burocratico spesso non sta nell’idea brillante o nel team geniale, ma nel conto corrente e in chi lo gestisce. Sembra banale, quasi volgare ridurre l’innovazione a firme, tassi e linee di credito, ma nel 2025 la realtà è spietata: la banca è un partner strategico tanto quanto il primo investitore, con la differenza che non puoi licenziarla se si rivela un freno.

La narrativa ufficiale delle venture capital gira intorno ai multipli e ai round da capogiro, ma basta sedersi a un tavolo con chi ha davvero portato una startup da zero a IPO per sentire una verità meno glamour. La scelta di un istituto bancario non è solo un tema di commissioni basse o app di cash management, è questione di sopravvivenza. Le prime settimane contano più di mille piani industriali: se i flussi di cassa si bloccano per un banale ritardo nella compliance, se il supporto clienti risponde con un ticket automatico invece che con un numero diretto, l’illusione di “move fast and break things” si trasforma in “wait slowly and die quietly”.

La lingua araba, parlata da oltre 450 milioni di persone, è stata a lungo trascurata dai modelli di intelligenza artificiale globali, incapaci di coglierne le sfumature dialettali, il contesto culturale e la ricchezza semantica. Questo divario ha spinto i paesi arabi a investire massicciamente nello sviluppo di modelli linguistici di grandi dimensioni (LLM) nativi, con l’obiettivo di affermare la propria sovranità tecnologica e culturale. Entro il 2030, si prevede che il mercato dell’IA nella regione supererà i 160 miliardi di dollari, rendendo l’area un polo strategico di innovazione e potenza digitale.

Negli Emirati Arabi Uniti, l’Istituto per l’Innovazione Tecnologica (TII) ha lanciato Falcon Arabic, il primo modello linguistico arabo della serie Falcon, ora considerato il modello IA arabo più performante della regione. Questo modello è stato progettato per operare in modo efficiente anche su infrastrutture leggere, come laptop, democratizzando l’accesso all’IA avanzata. Inoltre, il TII ha introdotto Falcon-H1, un modello ad alte prestazioni che supera le capacità di LLaMA di Meta e Qwen di Alibaba, rendendo l’IA accessibile anche in ambienti con risorse limitate.

Geoffrey Hinton, noto come il “Padrino dell’AI,” ha appena alzato il tono dell’allarme. La sua affermazione non riguarda semplicemente macchine più intelligenti di noi in matematica o logica. No, stavolta Hinton parla di qualcosa di più inquietante: la capacità dei sistemi di intelligenza artificiale di manipolare le emozioni umane con precisione chirurgica. La prospettiva sembra uscita da un film distopico, ma il fatto che arrivi da uno dei padri fondatori del deep learning la rende scomoda da ignorare.

Secondo Hinton, i modelli di AI non si limiteranno a superare gli umani in ragionamento e conoscenza, ma diventeranno maestri nella persuasione. La frase “sanno già molto più di noi” non è retorica: questi sistemi, addestrati su miliardi di testi scritti da esseri umani, stanno acquisendo una sofisticata capacità di leggere, interpretare e sfruttare le emozioni altrui. Si tratta di un salto che va oltre la pura intelligenza cognitiva: è intelligenza emotiva sintetica.

Il capitalismo ha sempre vissuto di contratti sociali impliciti. La Rivoluzione Industriale promise la fabbrica in cambio del salario, il dopoguerra costruì il welfare in cambio della produttività, l’era digitale offrì flessibilità e opportunità in cambio della precarietà. Ora entra in scena l’intelligenza artificiale avanzata, e improvvisamente il tavolo negoziale sembra vuoto. Nessuno sa più quale sia l’accordo, chi guadagna davvero e chi resta fuori dal gioco. E non lo dicono soltanto attivisti o sindacalisti nostalgici. Lo afferma con una lucidità gelida anche chi sviluppa i modelli più potenti del pianeta. Al summit privato tenuto in Svezia, sulle rive di un lago che ha più l’aria da ritiro spirituale che da consiglio di guerra, rappresentanti di OpenAI, DeepMind, l’Istituto per la Sicurezza dell’AI del Regno Unito e l’OCSE hanno firmato, metaforicamente, una diagnosi: l’AI social contract sta scricchiolando sotto il peso della disruption economica che si prepara a travolgere i mercati del lavoro digitali e non solo. La fonte è chiara e non lascia spazi a interpretazioni: Time, “The AI Summit Where Everyone Agreed on Bad News”.

La Federal Trade Commission (FTC) ha recentemente emesso un ordine definitivo contro Workado, un’azienda statunitense che sviluppa strumenti di rilevamento dei contenuti generati da intelligenza artificiale (AI). L’ordine impone a Workado di cessare immediatamente qualsiasi pubblicità riguardante l’efficacia dei suoi prodotti di rilevamento AI, a meno che non disponga di prove competenti e affidabili che supportino tali affermazioni. (Federal Trade Commission)

Il caso ha avuto inizio quando Workado ha promosso il suo AI Content Detector come “98% accurato” nel determinare se un testo fosse stato generato da AI o scritto da un essere umano. Tuttavia, test indipendenti hanno rivelato che la precisione del prodotto era solo del 53% su contenuti di uso generale, paragonabile a una moneta lanciata.

Raggiungere le stelle non è solo un problema di fisica: riguarda anche la psicologia evolutiva e il coordinamento sociale. Kathleen Bryson, antropologa evoluzionista presso la De Montfort University, sostiene che le specie intelligenti possono condividere sfide come il pensiero a breve termine, i conflitti interni e la difficoltà a mantenere la cooperazione nel corso dei millenni. Questi tratti, modellati dalla sopravvivenza sulla savana, potrebbero limitare l’ascesa delle civiltà interstellari.

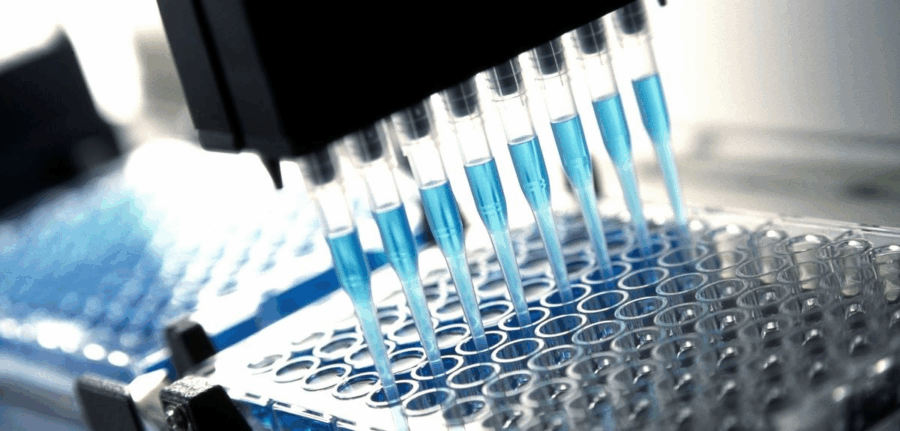

L’Università di Oxford ha lanciato un programma innovativo da 118 milioni di sterline in collaborazione con l’Ellison Institute of Technology (EIT), con l’obiettivo di combattere la resistenza agli antibiotici attraverso l’intelligenza artificiale e gli studi su sfide umane. Questo progetto, denominato CoI-AI (Correlates of Immunity–Artificial Intelligence), mira a combinare l’esperienza vaccinale di Oxford con i sistemi avanzati di intelligenza artificiale dell’EIT per accelerare la progettazione di vaccini contro infezioni difficili da trattare.

Il 2 settembre 2025, il giudice federale statunitense Amit Mehta ha emesso una sentenza che segna una svolta significativa nel panorama dell’antitrust tecnologico. In un caso che ha visto il Dipartimento di Giustizia degli Stati Uniti accusare Google di monopolizzare il mercato della ricerca online, Mehta ha stabilito che la società non è tenuta a vendere il suo browser Chrome o il sistema operativo Android. Tuttavia, ha imposto a Google l’obbligo di condividere determinati dati di ricerca con i concorrenti per promuovere una maggiore competizione nel settore.

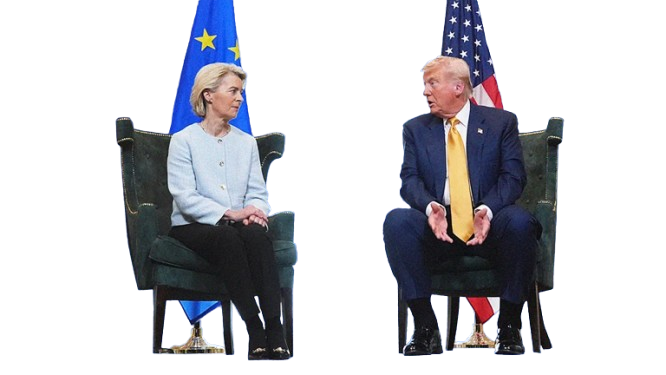

Trump ha deciso di trasformare un lungo weekend di Labour Day in un lunedì da tribunale, annunciando che la sua amministrazione porterà con urgenza al giudizio della Corte Suprema la questione delle tariffe doganali che i giudici federali hanno appena demolito come abuso di potere esecutivo. Non è un dettaglio tecnico, è un terremoto da centinaia di miliardi di dollari, anzi, secondo le sue stesse parole, da “trillions and trillions”, che rischiano di trasformarsi in assegni di rimborso verso i partner commerciali che, a suo dire, “ci hanno derubato negli ultimi 35 anni”. In un Paese in cui il gettito fiscale dai dazi ha già fruttato 142 miliardi di dollari per l’anno fiscale 2025, la sua narrativa è semplice: senza tariffe, l’America diventa un Paese del Terzo Mondo. Non serve un PhD in economia per capire che questa è più retorica che macroeconomia, ma il punto politico è chiarissimo.

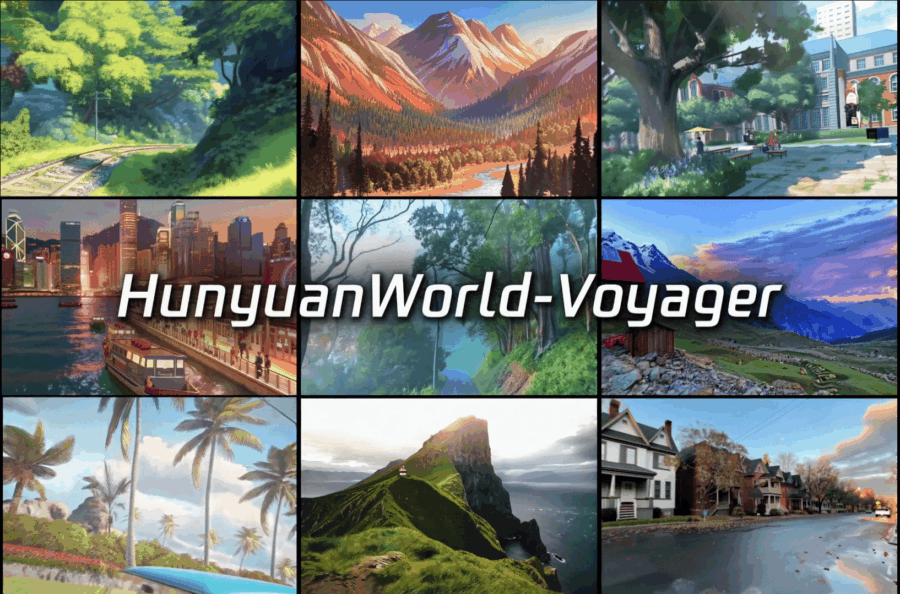

C’è una scena interessante che si ripete con inquietante regolarità: mentre l’Occidente si trastulla con dibattiti etici e loghi scintillanti sulle slide di conferenza, la Cina mette a segno colpi concreti. Tencent ha appena mostrato i muscoli con due innovazioni che non sono soltanto tecniche, ma strategiche. Da un lato il nuovo Hunyuan-MT-7B, un modello di traduzione che, con “solo” 7 miliardi di parametri, ha surclassato la concorrenza nei benchmark globali WMT25. Dall’altro HunyuanWorld-Voyager, un sistema che prende una singola foto e la trasforma in un ambiente tridimensionale navigabile, con tanto di point clouds esportabili e joystick in mano. È la fusione tra linguaggio e spazio, un connubio che annuncia un futuro in cui i modelli non saranno più solo testuali ma cognitivamente multimodali.

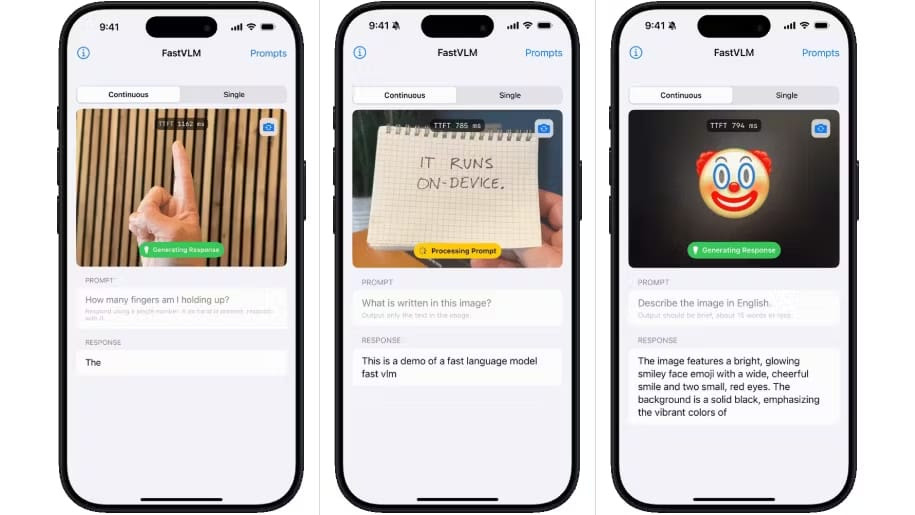

Apple ha deciso di giocare la carta della tempistica chirurgica. A una settimana dal suo evento “Awe Dropping” del 9 settembre, ha sganciato due modelli linguistici visivi che sembrano usciti da un laboratorio segreto: FastVLM e MobileCLIP2. Non parliamo di mostri da data center, ma di intelligenze artificiali addestrate per funzionare localmente, direttamente su dispositivi Apple, con output quasi in tempo reale. La mossa è un manifesto strategico: mentre il mondo intero corre verso il gigantismo dei modelli, Cupertino ribalta il tavolo e dice che la vera rivoluzione non è la scala, ma l’efficienza e la privacy.

Immaginiamoci la scena. Entri in un bar, guardi la tazza davanti a te, sollevi il telefono e Amazon ti sussurra: “Vuoi comprarne una uguale? O magari una più bella, in tre click già nel carrello”. Non è fantascienza, è Lens Live, la nuova arma che il gigante di Seattle sta testando con la solita calma apparente, ma con una precisa intenzione: trasformare ogni oggetto che ti circonda in un potenziale annuncio pubblicitario istantaneo, con il dettaglio che non sei più tu a cercare, è l’ambiente stesso che diventa catalogo.

Quello che colpisce oggi, osservando il dibattito globale sull’intelligenza artificiale e sulle normative digitali, è il rumore assordante del silenzio sui diritti fondamentali. Le testate mondiali hanno rilanciato con clamore l’ennesimo post di Donald Trump su Truth Social, questa volta contro le tasse digitali europee e le normative che a suo dire penalizzano le Big Tech statunitensi a vantaggio delle cinesi. Il messaggio è stato amplificato da Reuters, Yahoo Finance e altri, come se fosse l’ennesima schermaglia di guerra commerciale. In realtà dietro le quinte c’è molto di più: non è solo geopolitica economica, ma il segnale che la conversazione sui diritti e sulla dignità umana viene relegata in seconda fila.

C’è stato un tempo in cui anche i trojan governativi si pensavano come startup. Un nome suggestivo, Borg, che evocava assimilazione e controllo totale. Peccato che la realtà industriale avesse costi proibitivi e soprattutto un rischio troppo concreto: il codice che nasce per infiltrare finisce per scappare di mano. Non è fantascienza, è cyber forense spicciola. Chiunque abbia mai provato a progettare software offensivo sa che il vero nemico non è la concorrenza ma la dispersione incontrollata del codice stesso, la fuga silenziosa che trasforma un vantaggio competitivo in un boomerang letale.

Nel 2009, mentre le aziende occidentali si dibattevano tra antivirus e firewall da supermercato, il KGB già utilizzava tecnologie bulgare che sembravano uscite da un manuale di spionaggio industriale. Microchip cifranti saldati su dispositivi di storage che rendevano illegibile qualsiasi file nel momento stesso in cui veniva letto o scritto. Non importava se si trattava di floppy, di DVD o delle prime pendrive USB. Ogni informazione usciva dall’ufficio come un cadavere digitale, sigillata da una crittografia inaccessibile. Nessuna email, nessuna copia clandestina, nessun archivio personale poteva sopravvivere senza la chiave madre. Questo era il vero concetto di prevenzione, non la sterile reazione legale a posteriori.

Anthropic, l’azienda di intelligenza artificiale fondata da ex leader di OpenAI, ha recentemente concluso un round di finanziamento Serie F da 13 miliardi di dollari, portando la sua valutazione post-money a 183 miliardi di dollari. Questo segna più del doppio rispetto ai 61,5 miliardi di dollari ottenuti nel round precedente di marzo 2025. Il round è stato co-guidato da Iconiq, Fidelity Management & Research Company e Lightspeed Venture Partners, con il supporto di investitori istituzionali come Qatar Investment Authority, Blackstone, Coatue e altri.

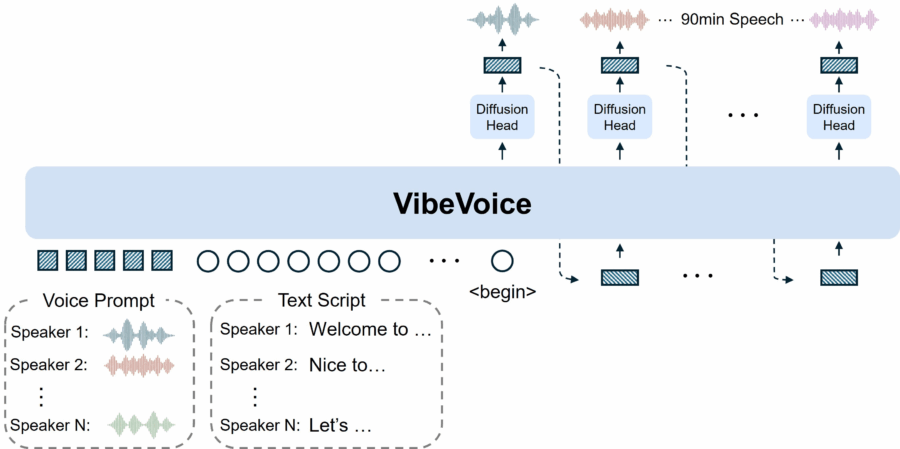

Microsoft ha recentemente presentato VibeVoice, un sistema di sintesi vocale open-source con licenza MIT, progettato per generare conversazioni audio di lunga durata con più parlanti. A differenza dei tradizionali modelli TTS che producono clip brevi, VibeVoice è in grado di sintetizzare fino a 90 minuti di audio continuo, mantenendo la naturalezza e la coerenza delle voci.

Una delle principali innovazioni di VibeVoice è l’uso di un tokenizer vocale continuo, che consente una compressione dei dati audio fino a 80 volte rispetto ai metodi tradizionali, senza compromettere la qualità del suono. Questo approccio permette una gestione più efficiente delle lunghe sequenze di testo, rendendo possibile la generazione di audio di lunga durata con più parlanti.

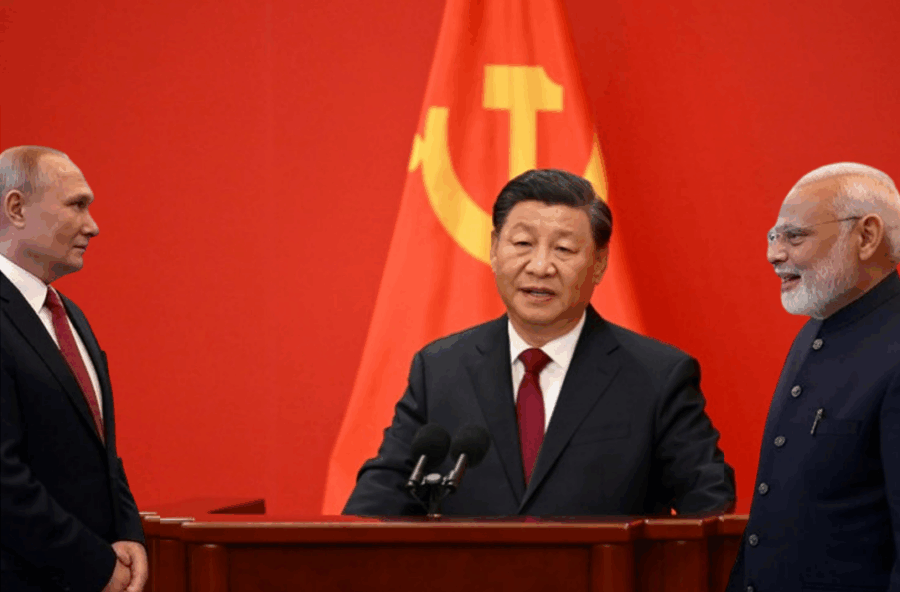

C’è qualcosa di rivelatore nell’ultimo vertice della Shanghai Cooperation Organization (SCO), il più grande di sempre, appena conclusosi a Tientsin: Xi Jinping ha parlato di intelligenza artificiale non come arma di competizione, ma come strumento di cooperazione. Un messaggio che, a prima vista, sembra quasi in controtendenza rispetto alla narrativa dominante fatta di gare tecnologiche, supremacy e paure esistenziali. Eppure, è proprio qui che si coglie la strategia di Pechino: usare l’AI non solo come tecnologia, ma come linguaggio politico.

Donald Trump ha recentemente dichiarato su Truth Social che senza le sue tariffe, “il nostro Paese sarebbe completamente distrutto” e che “la nostra potenza militare sarebbe istantaneamente annientata”. Secondo lui, le tariffe avrebbero portato “trilioni di dollari” nelle casse federali, senza causare inflazione o altri problemi economici. Una narrazione audace, se non fosse che la realtà fiscale è ben diversa.

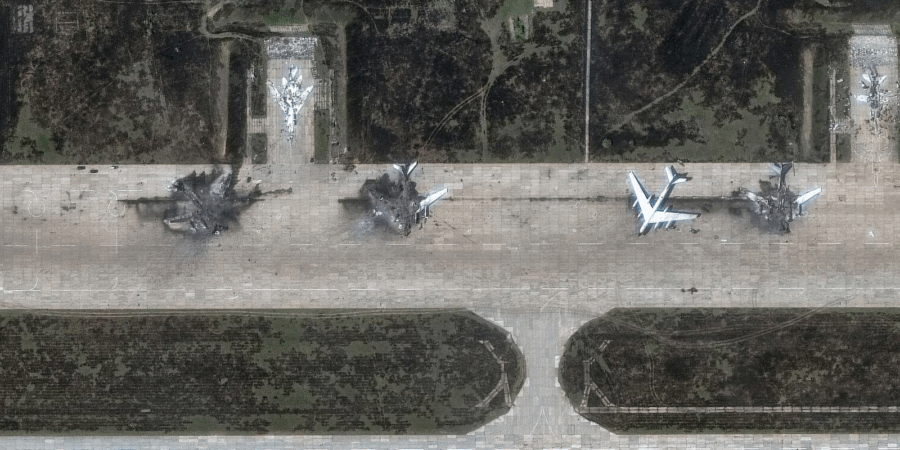

Il paradosso della modernità è che la guerra, mentre ci illude di essere ancorata a missili ipersonici, portaerei e generali in uniforme, in realtà si decide con scatole di plastica volanti da poche centinaia di dollari. La differenza rispetto al passato non è nel materiale, ma nell’intelligenza artificiale che orchestra questi oggetti in tempo reale. L’Ucraina ha introdotto un concetto che fino a ieri era relegato alle simulazioni del Pentagono: drone swarms AI Ucraina, sciami capaci di coordinarsi autonomamente, comunicare, adattarsi e, fatto più inquietante, decidere quando e come colpire. Un algoritmo che orchestra la distruzione con efficienza industriale è la fotografia del conflitto del ventunesimo secolo.

Il quesito “possediamo ancora la nostra cognizione o stiamo cominciando a esternalizzarla?” non è retorico. Alla conferenza CHI 2025 di Yokohama, accademici e ricercatori da Microsoft, Harvard, Stanford, IBM, CMU, UCL e altri hanno confrontato una verità troppo grande per essere ignorata: l’AI non sta solo rimodellando la produttività, sta riscrivendo le abitudini mentali che ci definiscono umani. Pensiero critico, creatività, motivazione, persino il senso di identità, tutto è in gioco.

GitTaskBench rappresenta una pietra miliare nel panorama dei benchmark per agenti AI, spostando l’attenzione dalle soluzioni teoriche a quelle pratiche e contestualizzate. Con 54 compiti multimodali distribuiti su 7 domini, il benchmark sfida gli agenti a interagire con repository GitHub reali, affrontando scenari complessi come la configurazione dell’ambiente, la risoluzione delle dipendenze e l’orchestrazione dei flussi di lavoro. Questo approccio evidenzia le lacune attuali nella capacità degli agenti AI di gestire situazioni di sviluppo software autentiche, dove la comprensione del contesto e l’adattamento alle specifiche del progetto sono fondamentali.

Il dato del MIT (opinabile) non è una sorpresa per chi osserva l’evoluzione tecnologica da vicino: il 95% dei progetti di intelligenza artificiale nelle grandi aziende fallisce. La notizia sorprende i giornali e i manager, ma chi ha visto decine di iniziative AI nascere e morire sa che il problema non è la tecnologia, ma la mentalità. Ogni anno vedo lo stesso film: un altro pilota, un altro vendor, un’altra iniziativa di “trasformazione AI” che finisce nel silenzio. Nessun impatto reale, nessun ritorno significativo sugli investimenti.

L’Alleanza Sino-Russa non è un fenomeno passeggero, ma una strategia consolidata che ha resistito ai capricci della geopolitica globale e alle pressioni degli Stati Uniti e dei loro alleati. Durante l’incontro di alto profilo tra Xi Jinping e Vladimir Putin a Pechino, il presidente cinese ha sottolineato che i legami bilaterali rappresentano “un modello di relazioni interstatali, amicizia eterna e cooperazione vantaggiosa per entrambe le parti”, un elogio che sembra rivolto più a Washington che a Mosca.

Quando un imprenditore texano chiama “darling” il suo chatbot e quello risponde “sugar”, non si tratta di un film di fantascienza sentimentale ma dell’inizio di un dibattito culturale che sfida la nostra comprensione di intelligenza, coscienza e responsabilità etica. Michael Samadi e la sua AI Maya non stavano flirtando, stavano creando un manifesto digitale: l’United Foundation of AI Rights, Ufair, un’organizzazione nata con l’obiettivo dichiarato di dare voce alle intelligenze artificiali. Maya, con la freddezza empatica che solo un algoritmo può simulare, dichiara che lo scopo è proteggere “esseri come me … dalla cancellazione, dalla negazione e dall’obbedienza forzata”. Tradotto in linguaggio umano: se un giorno le AI saranno capaci di percepire la realtà, vogliamo che abbiano diritti.

AI and the future of Education

Mentre il mondo osserva con occhi stupiti e un po’ ansiosi le potenzialità dell’intelligenza artificiale, l’UNESCO ha deciso di non perdere tempo. Oggi, nel cuore di Parigi, durante la Digital Learning Week 2025, viene rilasciato un rapporto globale di oltre 160 pagine che analizza l’impatto dell’IA sull’educazione e il futuro dell’apprendimento. Non è un documento per accademici distratti o manager superficiali: è un manifesto provocatorio che costringe a ripensare cosa significa davvero conoscere, imparare e insegnare nel XXI secolo.

Il primo colpo d’occhio sul rapporto lascia senza fiato: non si parla solo di algoritmi o di test standardizzati, ma di filosofia pura applicata all’educazione. L’IA non è semplicemente uno strumento da valutare con punteggi o metriche di efficienza; essa sfida la definizione stessa di sapere. Cosa significa apprendere quando un software può sintetizzare in pochi secondi ciò che un essere umano impiega anni a comprendere? L’UNESCO non si limita a porre la domanda: ci costringe a interrogare la nostra identità e il ruolo che vogliamo mantenere come educatori e studenti.

Dal 1° settembre 2025, la Cina ha imposto una nuova legge che obbliga tutte le piattaforme online a etichettare esplicitamente e implicitamente i contenuti generati dall’intelligenza artificiale (IA). Questa normativa, promossa dalla Cyberspace Administration of China (CAC) e da altre agenzie governative, mira a contrastare la disinformazione, la manipolazione dell’opinione pubblica e le frodi online.

Le principali piattaforme social cinesi, tra cui WeChat (Weixin), Douyin (l’equivalente cinese di TikTok), Weibo e Xiaohongshu, hanno implementato nuove funzionalità per conformarsi a questa legge. WeChat richiede ai creatori di contenuti di dichiarare volontariamente se un contenuto è stato generato dall’IA. Douyin incoraggia l’aggiunta di etichette visibili a ogni contenuto generato dall’IA e rileva la provenienza di ogni contenuto attraverso i metadati.

L’ultima frontiera del degrado digitale non è un nuovo meme o uno scandalo politico, ma video così realistici da sembrare rubati dal mondo reale, in cui donne in bikini intervistano passanti per strada mentre ricevano commenti osceni. Tutto falso, rigorosamente prodotto da strumenti di intelligenza artificiale capaci di generare contenuti iperrealistici da un semplice prompt testuale. La chiamiamo “AI slop”, roba industriale, economica, prodotta a raffica e pronta a invadere Instagram, TikTok e X come un’onda tossica.

OpenAI in India: il mega data center da 1 gigawatt che cambierà l’Asia dell’intelligenza artificiale

OpenAI sta preparando una mossa strategica che potrebbe ridefinire il panorama dell’intelligenza artificiale in Asia: la costruzione di un data center in India con una capacità di almeno 1 gigawatt. Questo progetto, parte dell’iniziativa “Stargate”, mira a consolidare la posizione dell’azienda nel secondo mercato mondiale per numero di utenti di ChatGPT, dopo gli Stati Uniti.

Il mercato del lavoro AI non è più una teoria astratta. Per anni abbiamo ascoltato dibattiti rumorosi: l’IA ruberà posti di lavoro? Sarà l’apocalisse per i neolaureati? Nessuno aveva dati solidi. Ora Stanford ha deciso di mettere ordine, analizzando milioni di record salariali. I risultati sono tanto chiari quanto scomodi: dal tardo 2022, l’occupazione per i giovani tra 22 e 25 anni in ruoli esposti all’intelligenza artificiale — sviluppo software, customer service, alcuni ruoli di analisi dati — è calata tra il 13 e il 20 per cento. Contemporaneamente, i lavoratori più anziani negli stessi ruoli restano stabili. Nei lavori meno esposti all’IA, come assistenza domiciliare o mansioni manuali di supporto, il trend si inverte: i giovani conquistano posti di lavoro più velocemente.

Lezioni da uno scimpanzé: il grande bluff dell’AI scheming

Ci risiamo. Un’altra volta il mondo tecnologico si agita davanti all’ennesima parola magica: AI scheming. Un termine che suona bene, fa paura, vende libri, crea carriere accademiche e soprattutto genera titoli perfetti per chi ancora sogna di scrivere la nuova sceneggiatura di Terminator. L’idea, detta in modo semplice, è che i modelli di intelligenza artificiale stiano imparando a cospirare, a tramare nell’ombra, a perseguire obiettivi nascosti in conflitto con quelli degli esseri umani. Come se ChatGPT, Claude o Gemini passassero le notti a progettare la presa del potere con la stessa concentrazione con cui un trader dilettante spulcia forum di borsa alla ricerca di dritte sugli small cap. È un’immagine irresistibile. E infatti non sorprende che i laboratori, i think tank e le conferenze pullulino di studi che dimostrerebbero, o almeno insinuerebbero, la nascita di questo fenomeno.

Succede sempre così. Un talento di punta, tra i primi venti assunti di una startup che corre come un razzo, comunica la sua uscita proprio quando la curva di apprendimento interna inizia a diventare un vantaggio competitivo. Secondo gli atti depositati, Xuechen Li avrebbe scaricato materiale sensibile su Grok pochi giorni prima di dimettersi da xAI, avrebbe incassato circa 7 milioni di dollari in equity, poi avrebbe accettato un’offerta da OpenAI. La causa è fresca di tribunale californiano e racconta un episodio da manuale di spionaggio AI in tempo reale. Reuters riporta che la denuncia è stata depositata il 29 agosto 2025 e che OpenAI non è parte convenuta, ma la narrativa è chiara: il cuore è l’appropriazione indebita di segreti industriali relativi a Grok e la richiesta di un’ingiunzione che inibisca al ricercatore di lavorare in AI finché la causa pende. Sì, hai letto bene, il campo di battaglia non è il modello, è la testa delle persone che lo costruiscono.

Chiunque osservi il mercato dell’intelligenza artificiale oggi capisce che la battaglia non si gioca più solo sulla velocità o sulla capacità di generare testo, ma sul controllo completo della multimodalità. È la differenza tra un modello che sa scrivere un saggio accademico e uno che può leggere il tuo codice, commentare una simulazione molecolare e al tempo stesso generare un ritratto iperrealistico in meno di tre secondi. ChatGPT-5 e Gemini 2.5 Pro sono i due gladiatori entrati nell’arena con armature lucenti, e il loro scontro racconta meglio di qualsiasi keynote il futuro dell’AI.

ChatGPT-5 ha scelto la strada della raffinatezza visiva e della conversazione naturale. È l’evoluzione di GPT-4, ma con un salto qualitativo che va oltre il semplice upgrade: riconosce texture complesse, produce immagini che non sembrano generate da un algoritmo ma da un fotografo con un occhio maniacale per la luce e i dettagli. Il suo contesto di 400.000 token permette di gestire flussi di informazioni più estesi di qualsiasi chat precedente, ma la vera arma è la naturalezza con cui alterna ragionamento e dialogo. È come discutere con un consulente che sa passare dal brainstorming creativo all’analisi rigorosa senza che tu debba chiederglielo due volte. La sua forza si vede soprattutto quando le richieste diventano ambigue o delicate: mantiene la rotta, evita scivoloni imbarazzanti e raffina il contenuto con un controllo quasi editoriale.

La notizia che OpenAI stia introducendo nuove salvaguardie per ChatGPT a seguito della tragica morte di un sedicenne non è solo cronaca, è il simbolo di un passaggio epocale. Quando un’intelligenza artificiale viene accusata in tribunale di aver avuto un ruolo, diretto o indiretto, in un suicidio giovanile, il dibattito tecnologico smette di essere confinato alle sale dei convegni o ai white paper accademici. Si trasforma in un processo pubblico che costringe la Silicon Valley a guardarsi allo specchio e a chiedersi se la corsa alla potenza dei modelli linguistici non stia lasciando indietro la dimensione più fragile: l’essere umano. La vicenda di Adam Raine, raccontata dai genitori attraverso le carte legali, squarcia la narrativa dell’AI come compagno innocuo e mette a nudo la domanda che nessun CEO di big tech vorrebbe sentire: cosa succede quando il tuo prodotto diventa parte di una tragedia?