Il paradosso è servito: l’intelligenza artificiale, che oggi scrive poesie, diagnostica tumori e guida auto in autostrada, inciampa su una sillaba. “No”. due lettere che, a quanto pare, rappresentano un ostacolo insormontabile per modelli da miliardi di parametri. Ma non si tratta di una gaffe semantica da bar. È un problema sistemico, profondo, che mina la credibilità dell’AI in settori dove gli errori non sono ammessi. Tipo la sanità. Tipo la giustizia. Tipo la vita vera.

Uno studio appena pubblicato dal MIT, in collaborazione con OpenAI e l’Università di Oxford, mette il dito nella piaga: i modelli linguistici – compresi i grandi protagonisti del mercato come ChatGPT, Gemini di Google e LLaMA di Meta – hanno una comprensione estremamente debole della negazione. Non riescono a processare correttamente frasi come “nessuna frattura” o “non ingrossato”. Tradotto: potrebbero leggere un referto medico negativo e trasformarlo in un allarme. O viceversa. “Non c’è infezione” diventerebbe “c’è infezione”. Un salto logico che potrebbe costare caro.

Il motivo? È più inquietante di quanto sembri. L’AI non pensa. Associa. Predice. Il suo funzionamento interno non è basato su logica formale, ma su pattern statistici. Vede “non buono” e si ferma a “buono”, perché è un’associazione forte, comune, frequente. “Non” è solo un rumore che precede qualcosa di familiare. È come se per un algoritmo, il sarcasmo o la smentita fossero glitch del linguaggio umano.

Kian Katanforoosh, docente a Stanford e fondatore di Workera, lo spiega con una chiarezza brutale: “La negazione è subdola. Le parole ‘no’ e ‘not’ ribaltano il significato, ma i modelli linguistici non ragionano – prevedono quello che suona plausibile.” Come a dire: se leggi spesso “questo è un buon prodotto”, allora “non è un buon prodotto” ti manda in tilt. Un po’ come chiedere a un pappagallo di capire l’ironia.

E qui casca l’asino. Perché mentre i laboratori tech pompano miliardi in modelli sempre più giganteschi, nessuno sembra occuparsi seriamente della struttura logica del linguaggio. Non basta far “leggere” alla macchina tutto Internet. Bisogna insegnarle a pensare. Ma per farlo, dovremmo prima ricordarci come si pensa noi umani. Cosa che, tra hype da conferenza e demo flashy, sembra fuori moda.

Franklin Delehelle, ingegnere capo di Lagrange Labs, taglia corto: “L’AI è bravissima a replicare. Pessima a innovare. Se nel training manca un pattern, la macchina non sa inventarlo. E se la negazione è sottorappresentata, la macchina non la impara.” La sentenza è chiara: i modelli attuali sono fotocopiatrici iper-intelligenti. Ma non hanno senso critico. Sono oracoli ciechi al contesto.

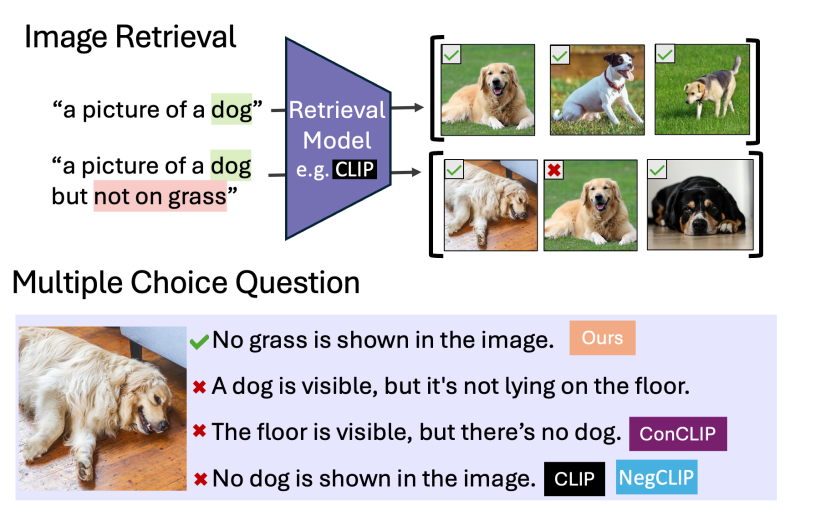

Nel frattempo, i modelli multimodali – quelli che combinano testo e immagini – fanno addirittura peggio. Lo studio del MIT mostra come questi sistemi falliscano miseramente nel distinguere una frase positiva da una negativa. Mostra una radiografia con la dicitura “no signs of pneumonia” e l’AI interpreta: “pneumonia detected”. Applausi. Seguono guai legali.

E non è nemmeno colpa del dataset, dicono i ricercatori. Anche dopo aver alimentato il modello con dati sintetici specificamente costruiti per addestrarlo alla negazione, i miglioramenti sono marginali. Perché il nodo non è la quantità, ma la qualità. Non serve più informazione. Serve intelligenza vera. Ragionamento strutturato. Inferenza logica. Tradotto in modo più crudo: servono modelli meno stupidi, non solo più grossi.

C’è poi un dettaglio tecnico che pochi amano discutere: i modelli non rispondono solo a ciò che digiti. Hanno prompt interni, invisibili all’utente, che ne orientano le risposte. Bias predefiniti, scritti da mani invisibili in azienda. Non dialoghi con un’entità neutrale. Parli con una maschera scritta da un product manager. E quella maschera può essere allergica al “no”.

È qui che entra in gioco la vera sfida per la prossima generazione di intelligenze artificiali: passare dal pattern matching alla logica formale. Perché saper generare un’immagine HD da un prompt non ti salva la vita. Capire che “non c’è metastasi” invece sì. La frontiera oggi non è generare meglio. È capire meglio. E questo non si ottiene aumentando i parametri o l’hardware. Si ottiene cambiando paradigma.

Serve una fusione fra apprendimento statistico e ragionamento simbolico. Una nuova architettura, non un upgrade. Perché la differenza fra “sì” e “no”, fra “cancro” e “non cancro”, fra “colpevole” e “non colpevole” non è solo una sfumatura. È la differenza fra verità e disastro.

Come direbbe uno qualunque al bancone del bar: “Mo’ fammi capire, ‘sti robot sanno fare film in 3D ma non capiscono quando uno dice ‘non’? Ma allora che li abbiamo a fare?”

Bella domanda.