Ogni volta che una nuova ondata tecnologica emerge nel campo dell’intelligenza artificiale, la storia si ripete con una prevedibilità quasi comica: entusiasmo smodato, dichiarazioni roboanti, titoli iperbolici. È accaduto negli anni ’80, quando Rodney Brooks — allora giovane ingegnere visionario — scriveva che “ogni tanto arriva una nuova scoperta nell’AI, e l’eccitazione dilaga: tutti si convincono di aver trovato la chiave dell’intelligenza”. Poi, come sempre, la realtà si incarica di ridimensionare la festa. Eppure, quarant’anni dopo, nulla sembra cambiato: l’illusione persiste, con più GPU, più hype e meno memoria storica.

Brooks, già nel 1988, aveva compreso ciò che molti ancora oggi si rifiutano di accettare: l’intelligenza non è una monolite da scardinare con un colpo solo, ma una giungla intricata di processi. Non c’è un algoritmo magico, né un transformer universale che ci trasporti dal chatbot alla coscienza in tre prompt ben formulati. L’idea stessa che l’intelligenza possa essere ridotta a una formula è, per usare un termine tecnico, una sciocchezza colossale. Eppure è una sciocchezza che vende bene, ottiene finanziamenti, genera click, soprattutto quando si traveste da innovazione radicale.

Il paradosso è che ogni generazione di ricercatori sembra voler ripetere l’errore dei predecessori con una fiducia quasi religiosa: il Perceptron negli anni ’60, gli esperti rule-based negli anni ’70, il connectionismo negli ’80, il deep learning negli anni 2010, e ora il grande culto degli LLM. Tutti innamorati della loro “chiave definitiva”. Come se l’intelligenza fosse una porta chiusa e bastasse trovare il giusto codice numerico per spalancarla. Ma non c’è una porta, non c’è un codice. C’è una rete di funzioni, reazioni, rappresentazioni, e soprattutto: contesto. E il contesto, per definizione, non è scalabile con un prompt.

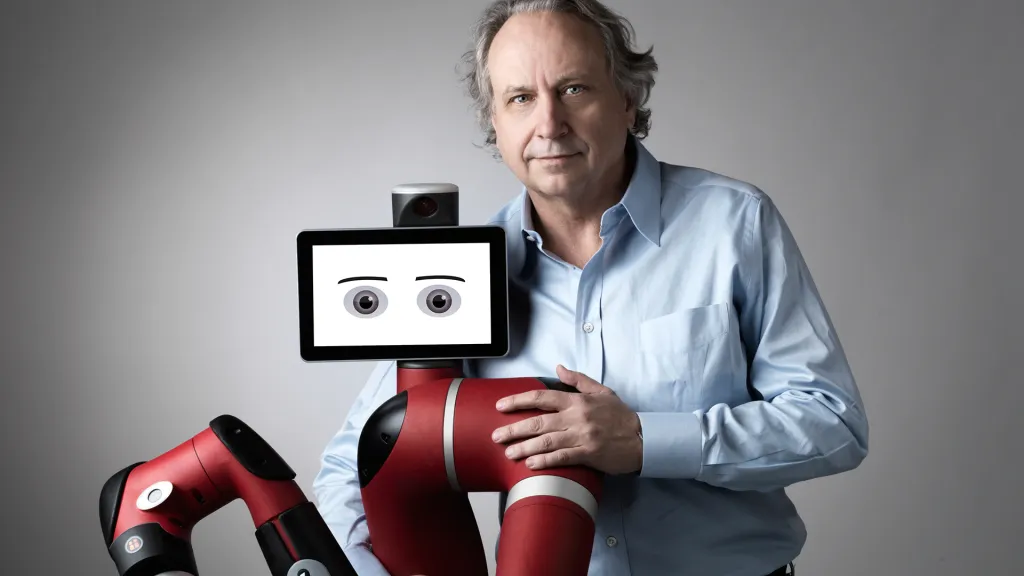

Forse è per questo che Rodney Brooks parlava di “modesti successi reali” come contraltare necessario alle grandi aspettative. Non era cinico, era clinico. La sua era un’analisi da ingegnere dell’evoluzione, non da guru delle TED Talk. Trovava eccitante la complessità, non la semplificazione. E forse, in quel suo entusiasmo pacato, risiedeva la vera forza della visione: riconoscere che l’intelligenza artificiale non sarà mai una scoperta istantanea, ma una costruzione artigianale, progressiva, spesso noiosa. Una sorta di cattedrale digitale in costruzione perenne.

Ma oggi, nel 2025, questa voce prudente è annegata in un mare di euforia generativa. Tutti vogliono “l’AGI entro il 2030”, come se fosse un KPI trimestrale. Ci si affida a modelli linguistici giganteschi che, pur mostrando capacità sorprendenti, non hanno né comprensione semantica né agency. Sono simulacri sofisticati, generatori statistici con una cultura enciclopedica e una coscienza assente. Eppure vengono trattati come oracoli, se non come baby-God.

È ironico che proprio mentre l’intelligenza artificiale diventa più ubiqua, la nostra comprensione di essa diventa più superficiale. Ci accontentiamo della performance senza capire l’architettura. Celebriamo la coerenza linguistica come fosse pensiero. Ma un modello che predice la parola successiva non sta pensando: sta facendo ciò per cui è stato addestrato. La differenza tra imitazione e comprensione non è sottile, è ontologica. E negarla equivale a confondere l’immagine con l’oggetto, la mappa con il territorio.

La verità è che stiamo vivendo una forma sofisticata di pareidolia digitale: vediamo intenzionalità dove c’è solo correlazione, attribuiamo coscienza a ciò che è solo un sofisticato specchio neurale. Come disse Brooks, quando finalmente capiremo davvero l’AI, essa non ci sembrerà una semplice applicazione informatica, ma “un meraviglioso testamento al genio creativo dell’evoluzione”. Non uno specchio della mente umana, ma un organismo artificiale con una logica propria, frutto di secoli di ingegneria e scoperte pazienti, non di un weekend hackathon.

Ma finché continueremo a cercare la chiave unica, a sperare nel salto quantico, nel breakthrough salvifico, resteremo intrappolati in un eterno ciclo di disillusione. Perché ogni hype ha la sua nemesi: la realtà. E la realtà dell’intelligenza — biologica o artificiale — è che essa è sempre il risultato di un intreccio. Non una singola illuminazione, ma una miriade di microprogressi, ognuno dei quali rivela un pezzo in più del puzzle.

Oggi, in un’epoca dove anche il più banale dei comunicati stampa può dichiarare l’alba dell’intelligenza artificiale cosciente, la lezione di Brooks suona ancora più attuale: “sbloccheremo quei processi uno per uno, tra fiammate di grandi aspettative e risultati più modesti ma reali”. È un invito all’umiltà epistemologica, ma anche alla perseveranza. Perché dietro ogni grande sogno tecnologico, c’è sempre una lunga sequenza di lavori noiosi e revisioni continue.

Dunque no, l’intelligenza artificiale non è ancora qui. E forse non arriverà nel modo in cui ce l’aspettiamo. Ma ogni passo — per quanto piccolo — ci avvicina a qualcosa di più interessante della fantascienza: una comprensione profonda della mente, della materia e della macchina. Il che, a ben vedere, è molto più affascinante di qualsiasi bot che recita Shakespeare su richiesta.

Rivista.AI ringraza Nicola Grandis per i continui spunti intellettuali.