OpenAI ha un problema. Ed è lo stesso problema che ha ogni gigante tecnologico quando diventa troppo bravo a costruire strumenti intelligenti: la confusione. Non quella di sistema, ma quella degli utenti. In un mondo in cui ogni nuovo modello viene lanciato con nomi sempre più astratti o4-mini-high, o3, o1 Pro, GPT-4o l’illusione è che basti accendere la macchina e “funzioni”. No. Sbagliare modello oggi significa perdere soldi, tempo e credibilità. E anche un po’ di rispetto di sé.

L’utente medio inclusi molti executive digitali che parlano di AI con la stessa sicurezza con cui parlavano di blockchain nel 2017 sta usando modelli sbagliati per i compiti giusti. O modelli giusti per problemi inesistenti. È l’equivalente di usare un acceleratore di particelle per fare il caffè. E poi lamentarsi se il caffè sa di grafite.

Il fatto è che non è colpa loro. L’AI è passata, nel giro di 24 mesi, da “strumento di ricerca per pochi” a “copilota conversazionale per tutti”. Ma senza il manuale. Anzi, con troppi manuali. E ogni tool, plug-in, piattaforma o verticalizzazione ha la sua narrativa: chi spinge su GPT-4o, chi su modelli custom, chi su “mini”, chi su agenti autonomi. Tutti hanno ragione, in parte. Ma solo se capisci bene il contesto.

Partiamo da una verità scomoda: il modello GPT-4o che la maggior parte delle persone usa oggi è sovrautilizzato per cose semplici e sottoutilizzato per cose complesse. È come se usassimo una Tesla in modalità autopilot per fare il tragitto casa-supermercato, ma ci dimenticassimo che può anche guidare in autostrada mentre tu pianifichi l’anno fiscale.

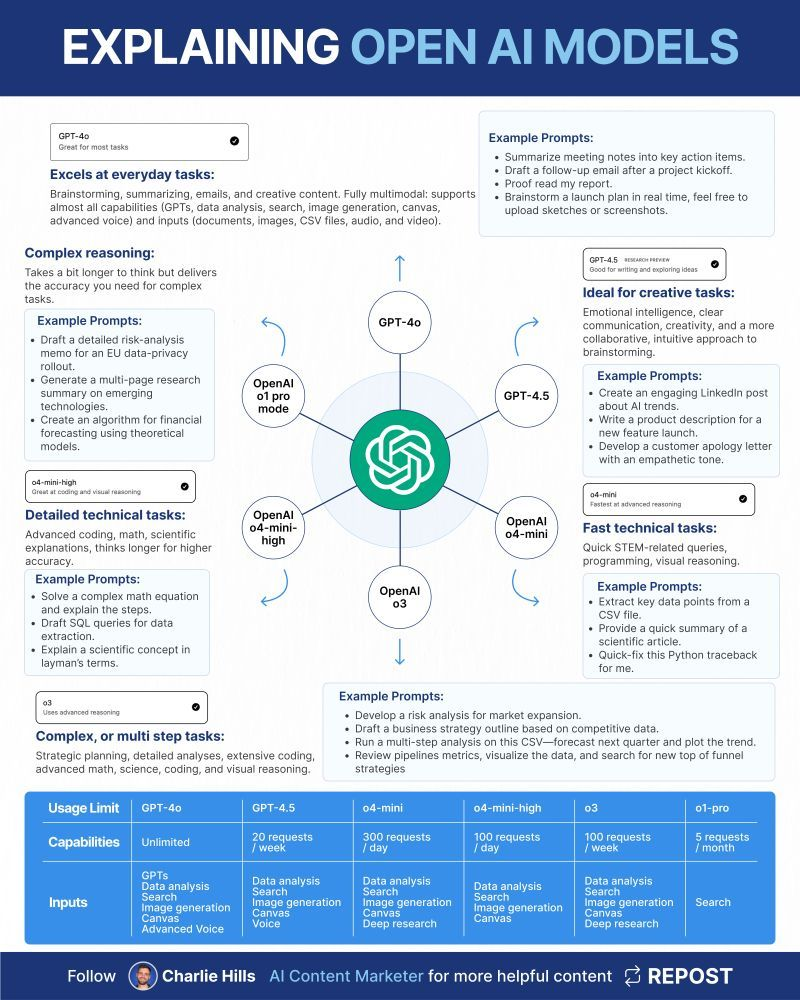

GPT-4o è potente. Accetta testo, immagini, documenti, voce. È l’assistente perfetto se vuoi “parlare con i tuoi dati”, riassumere 20 pagine di contratto o analizzare una presentazione PowerPoint mentre sei in call. Ma non è il più creativo, né il più analitico. È il coltellino svizzero, non il bisturi. Quindi se stai scrivendo una campagna pubblicitaria emozionale o devi redigere una lettera di scuse che eviti un disastro PR, ti serve altro: GPT-4.5, per esempio. Il modello con un senso dell’umano più raffinato, capace di capire quando “mi dispiace” suona falso e quando invece salva un cliente da un churn da sei cifre.

Poi ci sono gli specialisti veri. GPT-4o-mini-high, per esempio. Un nome che sembra una sigla di GPU anni ’90 ma che in realtà è il genio della logica: tabelle, formule, query SQL, ottimizzazione di codice, calcoli, spiegazioni matematiche. In ufficio, l’equivalente dell’ingegnere che capisce al volo perché il tuo script batch si rompe alle 23:58 ogni sera.

E ancora più nerd c’è GPT-4o-mini, il fratello minore, velocissimo e meno sofisticato. È perfetto per chi lavora con dati strutturati, ha bisogno di parsing rapidi di CSV o vuole un feedback istantaneo su uno stacktrace di Python. Lì dove l’efficienza conta più dell’eleganza.

Ma il modello che nessuno capisce e che tutti dovrebbero usare almeno una volta è GPT-o3. Non è il più sexy. Non è nemmeno quello che OpenAI pubblicizza di più. Ma è, nel bene e nel male, quello più vicino a un partner di pensiero. Quando hai bisogno di costruire una strategia articolata, analizzare un business plan da 80 slide o fare previsioni con scenari what-if, GPT-o3 è il tuo uomo. O meglio: è il tuo board member silenzioso, quello che ti guarda mentre fai una mossa sbagliata e non ti giudica, ma te lo fa notare.

Infine, il santo graal dei modelli verticali: GPT-o1 Pro Mode. Accesso limitatissimo, capacità di indicizzazione e ricerca profonda in contesti specifici. È l’equivalente AI di un analista da hedge fund: scrupoloso, iper-esigente, ma letale quando trova un pattern dove altri vedono solo rumore. Ideale per chi fa ricerca avanzata, investigazioni digitali, legal tech o R&D spinto. Non serve a tutti. Ma chi lo usa bene, cambia le regole del gioco.

Certo, scegliere il modello giusto richiede tempo, sperimentazione, e soprattutto una capacità che molti manager hanno dimenticato di esercitare: saper leggere il contesto prima di agire. La tecnologia oggi è come una cassetta degli attrezzi di precisione, e molti ci stanno ancora entrando a martellate. La verità è che l’AI non risolve problemi: li amplifica, se li poni male.

Il futuro non appartiene a chi ha l’AI più potente. Appartiene a chi sa usarla nel modo più intelligente. E questo inizia da una domanda banale che nessuno si fa più:

“Sto usando lo strumento giusto per il compito giusto?”

Chi non sa rispondere, ha già perso.