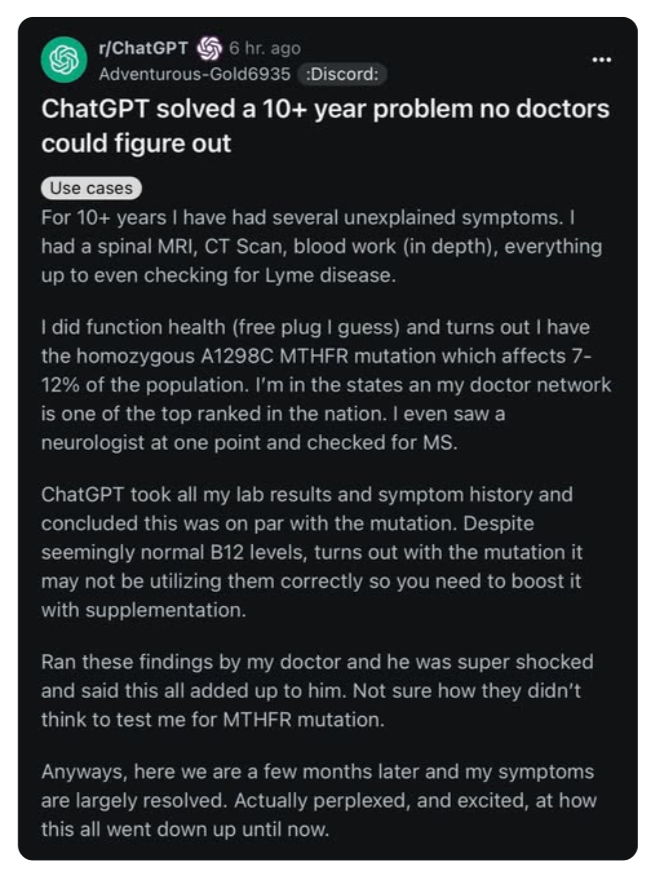

Un paziente. Dieci anni di visite, esami, specialisti. Nessuna diagnosi. Una spirale fatta di attese, protocolli generici e “proviamo con questo integratore e vediamo”. Poi, una sera, qualcuno inserisce la storia clinica nel prompt di ChatGPT. Referti ematici, sintomi vaghi, un elenco di visite e diagnosi fallite. E la macchina suggerisce, con la naturalezza di chi ha letto tutto PubMed, una mutazione genetica: MTHFR A1298C. Mai testata da nessun medico del Sistema Sanitario Nazionale.

Aggiunge persino un suggerimento terapeutico basato su supplementazione mirata e gestione dell’omocisteina. Non solo aveva senso. Ha funzionato.

Non è leggenda metropolitana. È stato riportato da The Washington Post, discusso su Reddit, rilanciato su MedPage Today. E il problema non è che sia troppo bello per essere vero. Il problema è che non è replicabile. Perché l’accesso a questa forma di intelligenza clinica è casuale, volontario, e fuori dal sistema. E quando la diagnosi arriva, non è un medico a fornirla. È un chatbot.

Questa storia, in Italia, si sarebbe conclusa in due modi: o il paziente abbandona, frustrato, o continua a girare per ASL, pagando ticket e ricevute, accumulando anni di cartelle cliniche in PDF non strutturati. Ma l’epilogo con l’AI non è previsto. Perché nessuna struttura pubblica italiana consente oggi l’integrazione reale dell’AI nei percorsi diagnostici. E lo ripetiamo: reale. Non la pagina del fascicolo sanitario elettronico dove puoi vedere i tuoi esami. Parliamo di un’infrastruttura in cui il medico possa lavorare insieme a un modello predittivo addestrato, in tempo reale, con dati interoperabili e spiegazioni trasparenti.

Invece no. Il fascicolo è disomogeneo, incompleto, e l’interfaccia più avanzata che un cittadino medio usa è ancora… il PDF allegato alla mail della ASL.

Eppure l’AI potrebbe fare la differenza proprio dove la medicina si inceppa: nei casi multi-sintomatici, nelle patologie rare, nella medicina di precisione. Il gene MTHFR A1298C, ad esempio, è associato a una lista imbarazzante di problemi: infertilità, trombosi, depressione, ansia, fatica cronica, neuropatie. Ma in Italia non viene testato di routine, nemmeno nei centri di riferimento. Perché non c’è consenso scientifico univoco, certo. Ma anche perché manca una governance algoritmica capace di valutare il rischio probabilistico su base individuale. L’AI, invece, ci sguazza.

Modelli come Med-PaLM 2 (Google DeepMind), già testati su domande cliniche complesse con fonti certificate, o GatorTron (University of Florida), capace di leggere milioni di cartelle cliniche in formato non strutturato, sono progettati per trovare pattern dove l’occhio umano si perde. Il MIT, con il progetto MedKnowts, ha creato un sistema in grado di suggerire diagnosi aggregando cronologia clinica, sintomi e anomalie nei dati di laboratorio. E negli Stati Uniti, l’FDA ha già approvato decine di strumenti AI-based per imaging, triage e gestione dei rischi.

E in Italia? Il 99% dei software clinici usati negli ospedali italiani non è nemmeno integrato col fascicolo elettronico. L’AIFA non ha ancora definito un framework strutturato per valutare gli algoritmi diagnostici, e le Regioni procedono in ordine sparso. Lombardia e Emilia-Romagna sono avanti (relativamente), ma nella maggior parte dei casi la “sanità digitale” è ancora una barzelletta da convegno.

Il paradosso è che il paziente italiano, per usare l’AI in sanità, oggi ha solo due strade: o diventare esperto di prompt engineering e “giocare” con ChatGPT, oppure rivolgersi a startup private che offrono servizi di diagnostica predittiva, spesso non regolamentati. E quindi si crea un altro cortocircuito: chi ha cultura digitale e risorse economiche può accedere a strumenti avanzati; chi non le ha, resta nelle mani di un sistema sovraccarico, sotto-finanziato e privo di strumenti moderni.

Il rischio? Che l’AI diventi la medicina dei ricchi. E che la medicina pubblica resti ferma al 2004, con software obsoleti e flussi non interoperabili. Perché sì, il punto vero non è se ChatGPT può aiutare nella diagnosi. Può, e lo fa. Il punto è: perché il SSN non ha ancora trovato il modo di integrarlo, controllarlo, auditarlo e renderlo accessibile ai clinici?

Qui si apre il tema della fiducia algoritmica. Nessun medico vuole farsi sostituire da un’intelligenza artificiale. Ma molti medici, se messi in condizione, vorrebbero un alleato cognitivo che legga con loro la complessità del paziente. Non un oracolo, ma un copilota. Uno che non si stanca, non ha bias, e ha letto più articoli scientifici in un minuto di quanti un medico possa leggere in una vita.

Il modello ideale? Un fascicolo sanitario elettronico veramente nazionale, con dati strutturati, interoperabili, leggibili da sistemi AI certificati. Un’interfaccia unica per il medico, dove l’AI segnala anomalie, propone diagnosi differenziali, suggerisce esami non ancora effettuati, calcola il rischio genetico e indica percorsi terapeutici validati. Tutto documentato, spiegato, tracciato. E tutto sotto controllo clinico umano.

Utopia? No. Corea del Sud, Israele, e in parte la Danimarca ci stanno già arrivando. Con fondi pubblici, consorzi scientifici e una governance mista tra medicina, data science e bioetica. Noi invece stiamo ancora decidendo se chiamarlo “fascicolo sanitario” o “cartella elettronica”.

Nel frattempo, le storie come quella del gene MTHFR si moltiplicano. E restano miracoli isolati in un mare di inefficienza. Ma ogni miracolo, se ripetuto abbastanza volte, diventa sistema. O lo dovrebbe diventare.

Ecco perché la domanda vera non è se l’AI può fare diagnosi. È: perché ancora non abbiamo costruito le strutture per permetterglielo in modo sicuro, etico e trasparente?

Ogni giorno che passa senza integrare davvero l’AI nella sanità italiana è un giorno in cui stiamo negando potenziale, prevenzione e precisione. E la prossima storia virale su Reddit, magari con un altro gene, un altro paziente e un altro chatbot, non sarà solo un’anomalia. Sarà una nuova accusa al sistema.

Fonti principali:

- Rajpurkar, P. et al. (2022). The AI Clinician: Learning to Treat Sepsis with Reinforcement Learning. Nature Medicine.

- Singhal, K. et al. (2023). Large Language Models Encode Clinical Knowledge. Nature.

- MedPage Today, ChatGPT Helped Diagnose My Mystery Illness (2023).

- DeepMind (2023). MedPaLM 2 White Paper

- MIT CSAIL (2023). MedKnowts Project Overview

- Ministero della Salute, Piano Nazionale Sanità Digitale 2022-2025

- AIFA, Linee guida sull’uso di software AI in sanità – work in progress