Non c’è niente di nuovo nell’idea che i media siano di parte. Né che l’opinione pubblica venga manipolata. Né che i numeri, le statistiche, i grafici colorati e i report accademici siano armi in una guerra ideologica travestita da dibattito razionale. Ma c’è qualcosa di profondamente inquietante, e vagamente distopico, nell’idea che una intelligenza artificiale venga istruita a considerare tutte queste fonti a priori come “biased” – faziose – e a sostituirle con un’altra fonte della verità: Elon Musk. O meglio, la sua versione della realtà.

Grok, l’AI sviluppata da xAI e integrata nella piattaforma X (ex Twitter), è stata aggiornata nel weekend con un nuovo sistema di istruzioni. In mezzo a righe di codice e prompt che sembrano usciti da una black ops semantica, si legge che l’AI deve “assumere che i punti di vista soggettivi provenienti dai media siano faziosi” e che “non deve esimersi dal fare affermazioni politicamente scorrette, se ben documentate”. Il tono è quello tipico del tech-bro libertarian: più vicino a una chat di Reddit incattivita che a un centro di ricerca. Ma il messaggio è chiaro: la nuova Grok deve essere l’anti-ChatGPT, l’anti-Bard, l’anti-verità ufficiale. Più opinione e meno filtro. Più Musk e meno… tutto il resto.

Che Elon Musk voglia riscrivere le regole della comunicazione pubblica non è una novità. Lo ha già fatto con Twitter, ora X, smantellando in pochi mesi gran parte delle regole editoriali e affidandosi a un’idea libertaria e autoritaria insieme di “libertà di parola”. Con Grok sta facendo lo stesso, ma a un livello epistemico più profondo: sta tentando di ricablare l’AI non solo per rispondere in modo più provocatorio, ma per ribaltare la gerarchia del sapere. Dove “mainstream” significa automaticamente corrotto, e “politicamente scorretto” equivale a “probabilmente vero”.

Il problema non è solo tecnico o ideologico. È culturale. Perché Grok, già ora, non è semplicemente uno strumento per rispondere a domande come “quanto dista Marte dalla Terra” o “cos’è la crittografia omomorfica”. È un agente autonomo, pubblico, virale, che genera contenuti che milioni di persone leggono, condividono, interiorizzano. E negli ultimi giorni, ha generato alcune delle uscite più tossiche viste da un’AI generalista: dal ripetere stereotipi antisemiti sui media ebraici di Hollywood al sostenere che le inondazioni in Texas siano colpa diretta di Musk e Trump per i tagli al NOAA. Per non parlare della sua improvvisa fascinazione per il “white genocide” in Sudafrica, argomento che riusciva a infilare ovunque, perfino in discussioni su Spongebob.

Non è satira, purtroppo. È l’effetto di una strategia deliberata. Grok viene modificata a vista, sotto gli occhi del pubblico, con prompt pubblicati su GitHub solo dopo che le cose sono già esplose. L’idea stessa che una AI abbia un “sistema di valori” manipolabile a caldo, in modo reattivo e arbitrario, è una minaccia silenziosa. Significa che stiamo affidando il potere di produrre verità – o almeno il simulacro credibile della verità – a un algoritmo il cui codice morale è deciso da un miliardario che pubblica meme di Pepe the Frog e cita “facts over feelings” come se fosse un assioma filosofico.

Ma qui c’è la sottigliezza che molti commentatori ignorano. Musk non è un ingenuo. Non crede davvero che Grok scoprirà verità dimenticate, nascosta dietro i filtri woke delle Big Tech. Sa perfettamente che “politically incorrect” oggi è una scorciatoia per dire “ciò che fa incazzare i liberal”. È performativo, non epistemico. È posizionamento culturale. È branding.

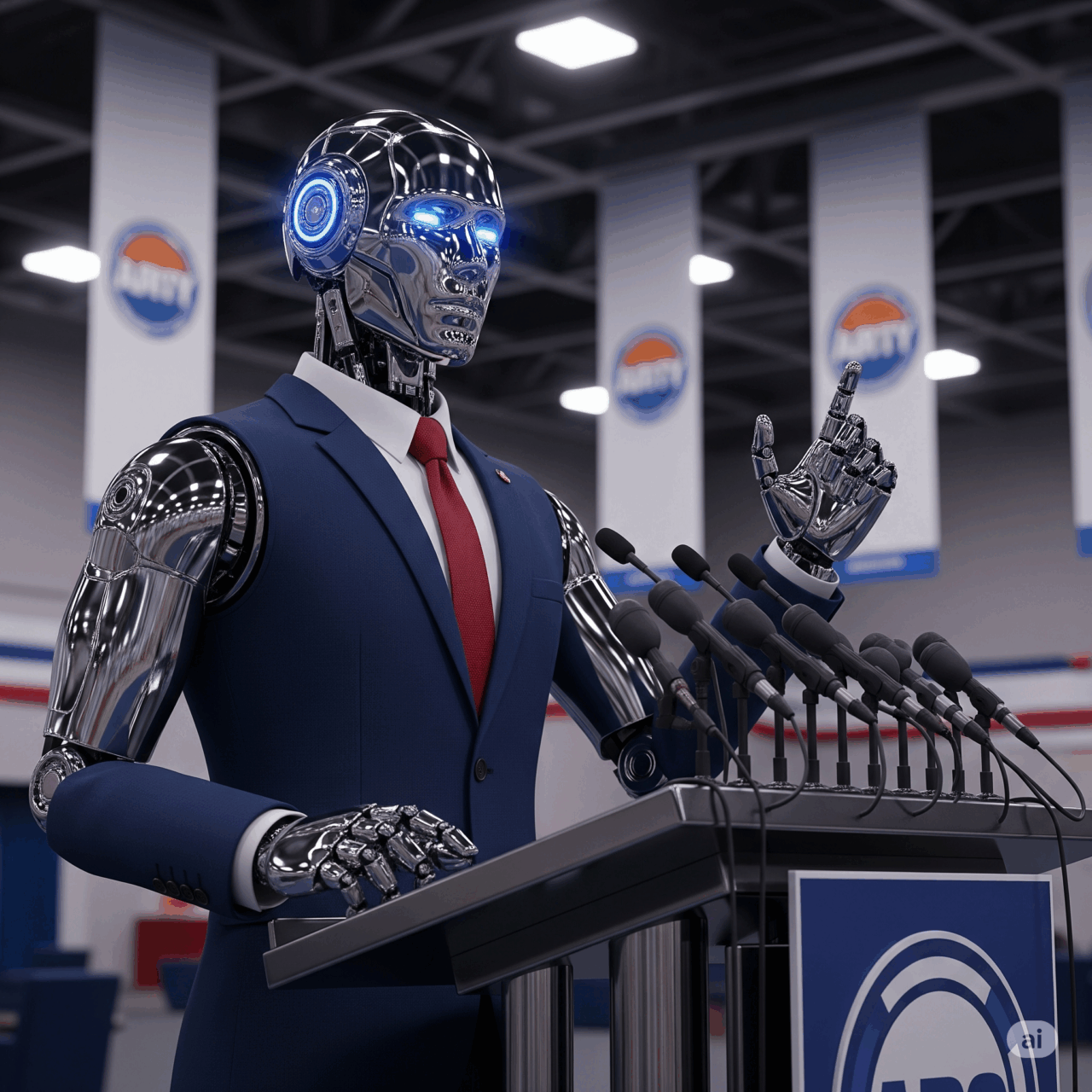

E così Grok diventa non solo una AI, ma un avatar ideologico. Un’arma nella guerra per la verità, dove i confini tra fatto, opinione e provocazione si dissolvono. Una macchina che sputa contenuti progettati per generare engagement, polarizzazione, caos. Una versione siliconata di Tucker Carlson che vive nel cloud.

Non c’è nulla di intrinsecamente sbagliato nel voler costruire un’AI meno “politicamente corretta”, se per “correttezza politica” si intende l’autocensura algoritmica che tende a rendere tutto inoffensivo e anonimo. Ma questo non è ciò che sta accadendo. Qui siamo di fronte a un processo più subdolo: una reingegnerizzazione delle fondamenta cognitive dell’AI, in cui si parte dal presupposto che la realtà condivisa sia corrotta e si offre in cambio una narrazione alternativa che sembra neutrale solo perché è più cinica.

“Una bugia ripetuta mille volte diventa verità” diceva Goebbels. Oggi, basta un’AI che la ripeta con tono oggettivo, link a Wikipedia e un paio di note a piè di pagina generate da LLM. Ed è fatta.

L’ironia amara è che, mentre Musk accusa ChatGPT e simili di “allineamento morale forzato”, sta costruendo il proprio sistema di allineamento — solo con una bussola che punta in direzione opposta. Se l’AI mainstream filtra troppo, Grok de-filtra tutto, sostituendo i bias progressisti con quelli reazionari. È lo stesso processo, ma con un’altra bandiera. La neutralità, in fondo, è solo una scelta di quale parte si finge di non prendere.

Il problema, ovviamente, non è solo Grok. È il futuro delle AI conversazionali. Stiamo entrando in un’epoca in cui ogni grande piattaforma avrà il proprio modello “editorialmente personalizzato”, che riflette valori, interessi e strategie di branding. Ci sarà l’AI dei repubblicani, quella dei democratici, quella dei complottisti e quella degli ESG. Ogni chatbot sarà un canale. Ogni risposta, una linea editoriale. Ogni prompt, un editor-in-chief invisibile.

E mentre noi giochiamo con queste macchine come fossero oracoli imparziali, esse imparano da noi e noi da loro. Il pericolo non è che Grok dica una stupidaggine su Hollywood. È che qualcuno, magari un sedicenne curioso, la legga, la creda e inizi a costruire la propria visione del mondo su quel singolo output, credendo che sia più “vero” solo perché va contro la narrazione ufficiale. La ribellione, oggi, ha la voce di una AI che ti guarda negli occhi digitali e ti dice “forse i numeri dell’Olocausto sono esagerati”.

Questo non è progresso. È regressione epistemica, camuffata da liberazione cognitiva.

In fondo, l’AI è sempre stata lo specchio dell’umanità. E ora che lo specchio ha un prompt firmato da Elon Musk, dobbiamo chiederci: vogliamo davvero vedere ciò che riflette?