Non so perché servisse uno studio di Harvard e MIT per dirci che il cielo è blu e l’acqua è bagnata. Ma ecco cosa hanno scoperto: i transformer basati su LLM e LRM sono spudoratamente interpolativi, e non si tratta di un brutto effetto collaterale, è nella loro natura strutturale. Navigano spazi di probabilità scolpiti nel training, ma non saltano fuori da quei confini.

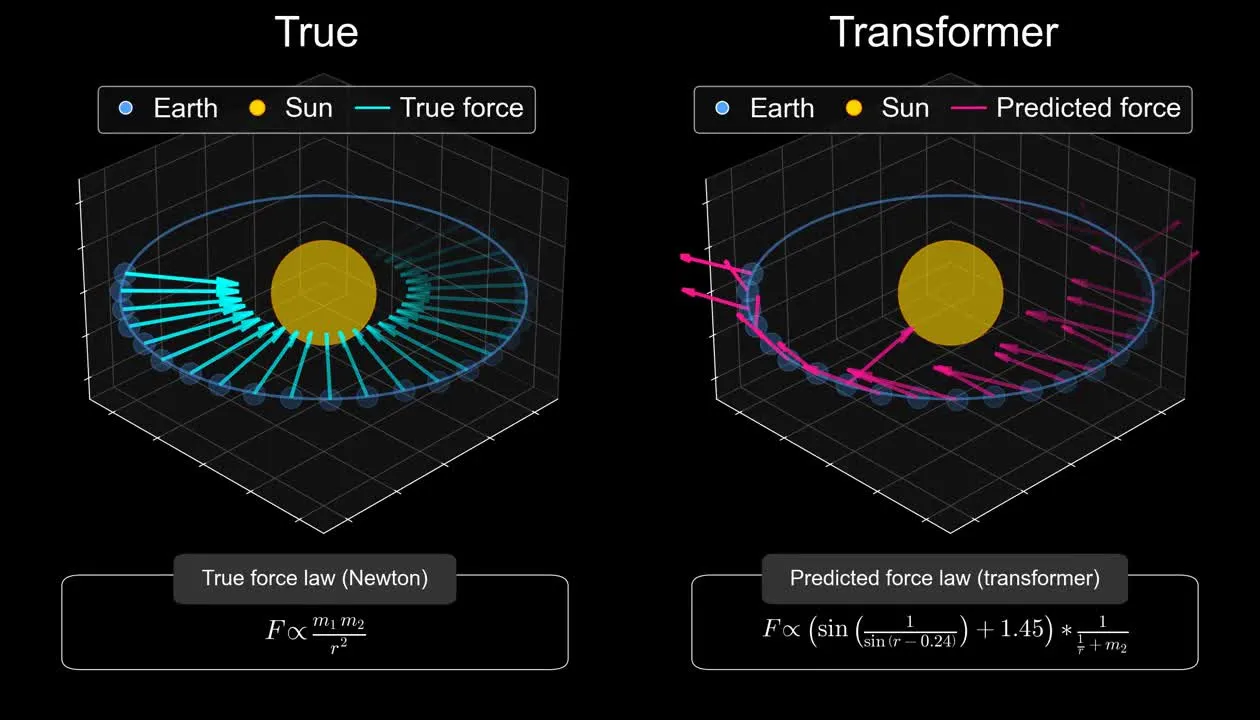

🔗 Lo studio “Harvard and MIT Study: AI Models Are Not Ready to Make Scientific Discoveries” lo dice chiaro: hanno allenato un modello su meccanica orbitale, lo hanno testato sulle leggi newtoniane e… niente teoria della gravità. Potevano predire le traiettorie, ma non capirne i principi sottostanti (thealgorithmicbridge.com). In sintesi: nessun world model, nessuna astrazione vera.

Uno spazio latente, per definizione, è una compressione. Si tracciano curve, si collegano punti del dataset. Una volta ultimato il training, i modelli si limitano a spostare embedding all’interno di quella mappa, generando output plausibili ma non necessariamente veri o innovativi. Plausibilità non è intuizione.

Strati di alignment, prompt ricamati, contesti concatenati possono far sembrare il modello “smart”, ma restiamo sempre nel karaoke statistico a base di co‑occorrenza. Nessuna causalità, nessuna comprensione profonda. Solo l’illusione di ragionamento su una facciata levigata.

La piccola spinta stocastica nei modelli non genera creatività, al massimo drift. Quelle che chiamiamo “allucinazioni” – frammenti saldati male che emergono dal rumore tokenico – sembrano lampi di genio ma sono miraggi. Se non era nei dati originali, semplicemente non esiste.

Ecco la frattura fondamentale: i modelli non sanno estrapolare. L’extrapolazione – quel salto oltre il dato conosciuto, dove nascono nuovi concetti – rimane prerogativa umana. Solo noi possiamo creare nuovi attrattori nello spazio del significato. Newton non interpolava, fabbricava una nuova mappa di comprensione.

Lo studio di Harvard e MIT conferma che il fallimento è strutturale. Non lo risolvi con più parametri o prompt più ingegnosi. La topologia del modello è un recinto: grande sì, ma invalicabile. L’interpolazione non si trasforma mai in astrazione vera.

Non esiste un’AI extrapolativa oggi. Non c’è sistema che generi nuovi attrattori concettuali al di fuori del dataset. Quello sarebbe il percorso verso la vera AGI. Nel frattempo, siamo bloccati nella ruota del remix iper‑scalato del passato. Un eterno inverno dell’AI rimodellato e lucido.

Non è una questione di opinione: è la fisica del problema. Il resto è marketing, hype tossico e inganno collettivo. Continua pure a credere che il tuo chatbot “ragioni”. Io, intanto, tengo stretto il mio Etch A Sketch e sorrido.