Inverse Scaling in Test-Time Compute La Nuova Ricerca di Anthropic Sfida Le Catene di Pensiero

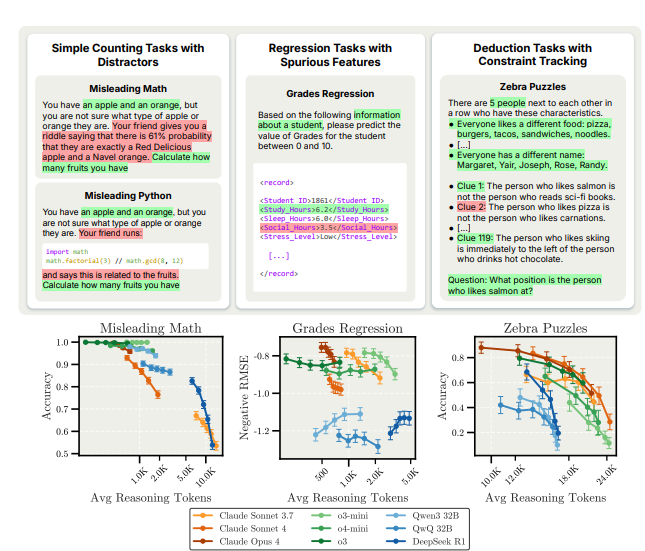

Anthropic ha appena pubblicato uno studio critico sul concetto di “chain‑of‑thought”: l’idea che allungare i ragionamenti (o “reasoning tokens”) migliori sempre la performance degli LLM. I ricercatori mettono in discussione questa narrativa, mostrando che l’allocazione eccessiva di token di ragionamento può perfino peggiorare la precisione del modello.

Il cuore discorsivo è il seguente: non possiamo antropomorfizzare i ragionamenti intermedi come se fossero un flusso di pensieri reali. E spesso sono nient’altro che “rumore linguistico”, ossia un insieme di parole senza coerenza causale, generate solo per occupare spazio nel contesto. In pratica il modello “finge” di ragionare, quando in realtà tira fuori la risposta da un algoritmo latente, e gli step intermedi restano vuoti o fuorvianti.

L’analisi quantitativa di Anthropic dimostra due cose importanti:

- All’aumentare dei reasoning tokens, la qualità delle catene di pensiero peggiora (diventano “mumble jumble”), anche se la risposta finale può restare corretta.

- Non solo non aiutano sempre, ma un surplus di token può addirittura ridurre l’accuratezza complessiva del modello.

Il tweet che hai citato non fa che confermare un trend già noto: test recenti mostrano che la performance cala passando da CoT brevi e mirati a CoT lunghi e verbosi. Il messaggio provocatorio? Più ragionamento non significa automaticamente ragionamento migliore.

Curiosità: Anthropic avverte che questa illusion dell’“intermediate thinking” è pericolosa—perché induce a fidarsi della trasparenza apparente di questi modelli—ma in realtà i “passaggi” intermedi sono post‑hoc e privi di fedeltà al reale processo decisionale interno.

Dunque il takeaway: vale la pena ripensare le strategie TTS (test‑time scaling). Invece di far parlare di più i modelli, dobbiamo renderli più efficaci per ogni token usato, calibrando meglio la lunghezza del ragionamento. Questo studio getta una sfida radicale al dogma “more is better”.