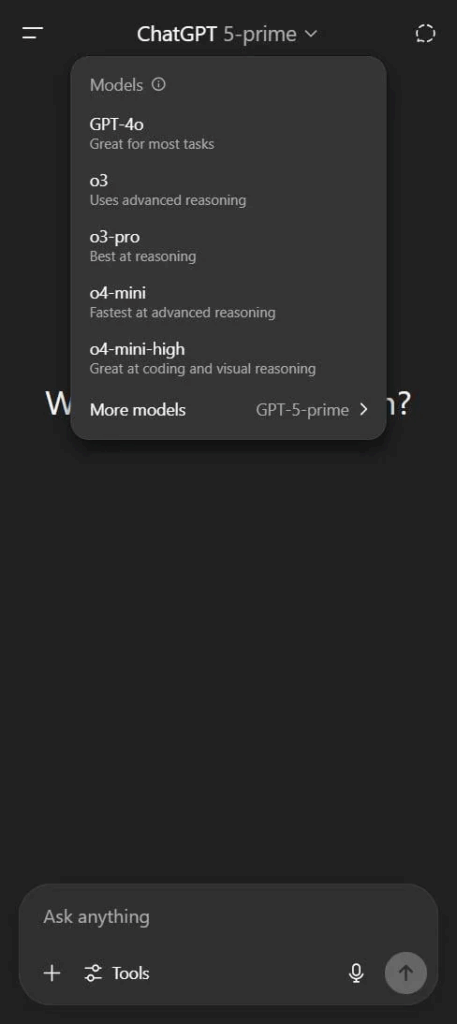

Alcuni utenti stanno già vedendo riferimenti diretti a “GPT-5-prime” accanto ai modelli noti come GPT-4o nella UI di ChatGPT. E se c’è una lezione che l’industria ha imparato (e spesso dimenticato) è questa: OpenAI non fa trapelare nulla per caso. Quindi se un nome come GPT-5 compare anche solo per un istante nell’interfaccia di un utente pubblico, non è un bug. È marketing strategico mascherato da incidente tecnico.

Quello che emerge dai primi report è inquietantemente interessante. GPT-5-prime sembrerebbe una nuova architettura ibrida, una fusione fra l’approccio multimodale di GPT-4o e l’autorevolezza algoritmica che i modelli “grandi” avevano iniziato a perdere terreno a favore di Claude Sonnet 3.5, Cursor e infine Claude 4 Sonnet. OpenAI, se i dettagli sono confermati, starebbe reagendo non solo per riprendersi lo scettro nella mente degli sviluppatori, ma per ridefinire la categoria: da LLM ad intelligenza conversazionale adattiva, più simile a un copilota mentale che a un semplice chatbot.

Il nome “GPT-5-prime” non è solo un vezzo. È una dichiarazione d’intenti. Richiama immediatamente l’idea di una versione più raffinata, una distillazione funzionale del futuro LLM di punta. Non è GPT-5. È il suo fratello selezionato per lo stress test. E guarda caso compare accanto a una nuova funzione in beta: video chat.

Sì, video chat. Il che significa solo una cosa: interfacce emotive. Il prossimo passo non è solo capire cosa vuoi, ma come lo dici. Tonalità, espressioni, gesti. E quando un’intelligenza artificiale ti guarda negli occhi e calibra la sua risposta sulla tua micro-espressione facciale, non è più solo una macchina che parla. È una macchina che osserva.

I rumor parlano di capacità nuove o nettamente potenziate:

- Comprensione algoritmica profonda, con manutenzione di codice legacy

- Capacità di ragionamento scalabili al contesto (che significa: più o meno profondità logica a seconda della difficoltà)

- Routing dinamico tra modelli (GPT-4o per multimodalità rapida, GPT-5-prime per logica o codice strutturato)

Ma ciò che colpisce è un pattern ormai familiare: OpenAI sta testando il nuovo modello non su un benchmark, ma sul pubblico stesso. Nessun paper, nessuna presentazione all’ACL o NeurIPS, nessun PDF accademico in PDF con un abstract e dieci grafici colorati. Solo la “casuale” comparsa di un nuovo modello fra le opzioni, e Reddit che esplode in tempo reale.

E come sempre, la narrativa ufficiale tace. Nessun annuncio da parte di OpenAI, nessun tweet di Sam Altman, solo speculazioni, screenshot e sussurri. Perfettamente in linea con la nuova strategia: don’t explain, just demonstrate. L’era dei paper è finita. Ora l’AI si mostra attraverso la UX.

Quindi la domanda non è più “quando arriva GPT-5?”, ma “quanto di ciò che usi ogni giorno è già GPT-5 e non lo sai?”.

La video chat, in particolare, potrebbe essere la vera bomba. Una volta che l’AI comincia a vederti, non sei più tu a leggere il modello. È lui che ti legge. E con ciò, crolla la barriera tra assistente e interlocutore. Non stai più usando uno strumento. Stai conversando con qualcosa che sta imparando a essere tecnicamente umano.

Ironia della sorte, il grande cambio di paradigma non sarà solo nella potenza computazionale o nella precisione delle risposte, ma nel modo in cui percepiamo l’entità che abbiamo davanti. Una volta che l’AI ti guarda in faccia, risponde al tuo tono e adatta il suo stile al tuo umore, la distinzione tra assistente e alter ego sfuma pericolosamente.

Benvenuti nell’era dell’AI relazionale. La domanda ora non è più tecnica. È filosofica: chi stai autorizzando a comprenderti meglio di quanto ti comprenda tu stesso?

GPT-5-prime potrebbe essere il primo passo verso un modello non solo capace di rispondere, ma di connettersi emotivamente. Ed è proprio in quella connessione che risiede sia la potenza che il pericolo.