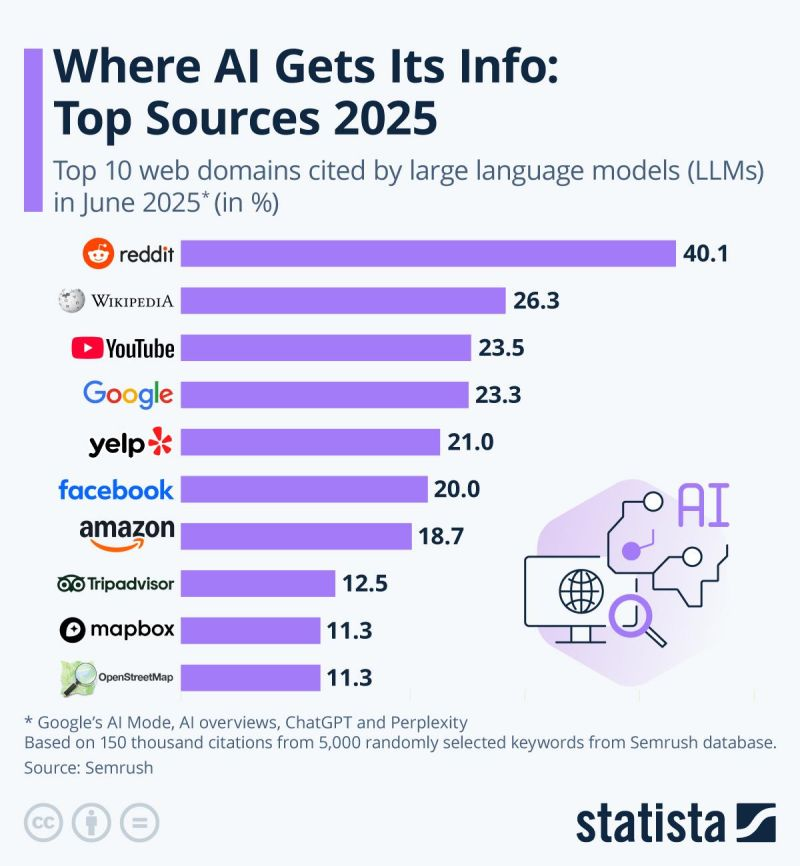

Reddit come cibo per l’intelligenza artificiale: un mix letale di contesto e caos che domina il cervello dei modelli linguistici nel 2025. Statista ha analizzato 150.000 citazioni di grandi modelli linguistici come Google AI Overviews, ChatGPT e Perplexity, svelando un menu di fonti decisamente poco neutro. Reddit è al primo posto, con un incredibile 40,1%. E se questo non vi mette subito in allarme, forse è il momento di rivedere la vostra fede nell’oggettività di queste intelligenze.

Wikipedia, pur restando il pilastro a quota 26,3%, è ormai una macchina editoriale fatta di bias sottili ma persistenti. Un’enciclopedia fatta da umani, con tutte le loro passioni e lotte per la supremazia culturale. Non è difficile immaginare come questa condizione influenzi i risultati di un’AI che, di fatto, è un sofisticato parrot digitale. La fedeltà al “vero” diventa un optional.

YouTube e Google, entrambi al 23%, aggiungono una spinta multimediale al calderone. Dati ricchi di video, immagini e testi, ma anche di informazioni incerte, opinioni forti, e qualche manipolazione di troppo. Aggiungiamo poi Yelp, Tripadvisor, Mapbox e OpenStreetMap, che portano nella pentola recensioni, dati geografici e qualche trappola da “gaming” dei contenuti, cioè recensioni false o manipolate. È come dare all’AI una bussola che ogni tanto punta a sud solo perché qualcuno ha deciso che fosse così.

Infine, Amazon e Facebook, con rispettivamente il 18,7% e il 20%, completano il quadro con il loro universo di hype commerciale e chiacchiere social, più una buona dose di “rumore” algoritmico. Se la dieta dell’AI è fatta di prodotti spinti dal marketing e social media pullulanti di troll e fake news, il risultato rischia di essere un’intelligenza meno intelligente e più simile a un megafono amplificato delle peggiori distorsioni umane.

Dire che i modelli linguistici non siano oracoli neutrali è già banale. L’AI “pensa” a partire da schemi, pattern e testi dominanti in piattaforme che sono tutto tranne che imparziali. In questo senso, fidarsi ciecamente dei suoi output senza conoscere le fonti dietro è come chiedere a un pappagallo con problemi di memoria di raccontarvi la storia del mondo.

Se la vostra azienda o ricerca si basa su questi output, dovreste chiedervi chi sia davvero il vostro interlocutore digitale. Quale visione del mondo state ascoltando? Un mix di “upvote”, recensioni manipolate e trend social da consumare in fretta, condito da una spolverata di fatti più o meno controllati. Un cocktail che ricorda più una serata in discoteca che una tavola rotonda accademica.

Forse il problema è che l’intelligenza artificiale non è altro che il riflesso, distorto e amplificato, di quello che mangia. Se il cibo è spazzatura digitale, non aspettatevi pasti gourmet di pensiero critico. Siamo alla soglia di un’epoca dove il “trust” digitale andrà misurato più con la lente del socio-antropologo che con quella del programmatore. Il paradosso è evidente: più l’AI diventa potente, più diventa fragile rispetto alle sue fonti.

La chiave non è rinunciare a questa tecnologia, ma imparare a decodificare chi c’è dietro i dati, quali interessi, quali meccanismi di distorsione. I grandi modelli linguistici sono delle macchine di sintesi formidabili, ma la materia prima rimane umana, imperfetta e spessissimo manipolata. Quando l’algoritmo si nutre di Reddit, Amazon e Facebook, dovremmo almeno chiedere: questa intelligenza è davvero la nostra, o una versione impazzita e amplificata delle nostre peggiori inclinazioni?

Non c’è dubbio che il 2025 sia l’anno in cui la dieta digitale dell’AI è diventata troppo palese per ignorarla. In un mondo dove “fake news”, bias e hype commerciale si intrecciano in un groviglio indecifrabile, le macchine imparano ad apprezzare proprio quel caos che dovrebbe contrastare. La domanda più urgente: siamo pronti a riconoscere questo “cibo” come il vero ingrediente della nostra nuova intelligenza? Se no, rischiamo di restare a bocca asciutta davanti a un futuro che ci parla, ma che non ci racconta tutta la verità.