Parlare di intelligenza artificiale oggi significa spesso cadere nella trappola di numeri astratti, benchmark incomprensibili e promesse fumose. Per fortuna, c’è un indicatore semplice, quasi banale, che invece taglia il rumore: la durata dei compiti che un agente AI riesce a portare a termine autonomamente con una affidabilità del 50%. Non è una metrica glamour come “numero di parametri” o “accuratezza sui test”, ma forse è la più significativa per capire dove siamo e soprattutto dove stiamo andando. Un paper recente, noto come metr paper, ha dimostrato con dati solidi che questa durata sta raddoppiando ogni 7 mesi, e da ben 6 anni. Tradotto in soldoni, significa che in meno di un decennio avremo agenti AI in grado di eseguire autonomamente compiti complessi che oggi richiedono giorni o settimane di lavoro umano.

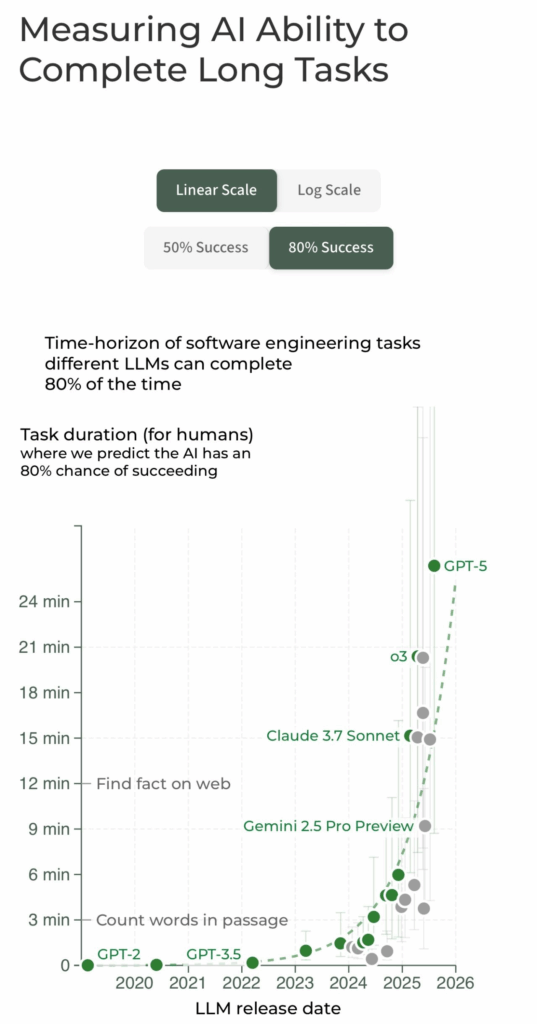

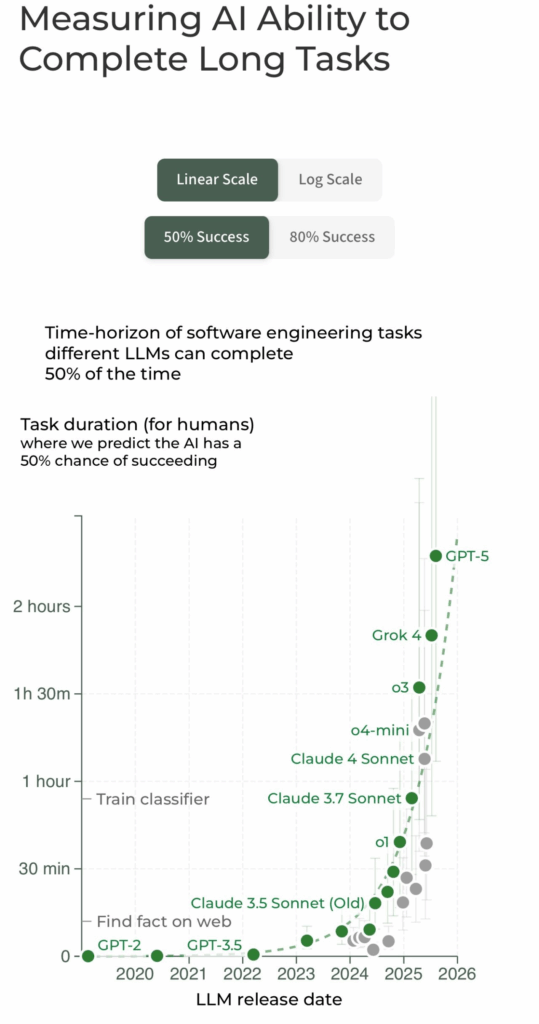

Il dato è così robusto che lascia poco spazio a dubbi: l’aumento esponenziale nella capacità di gestire task lunghi e articolati non è un effetto passeggero né un’illusione da hype tech. Le curve logistiche di successo, che mettono in relazione la durata del compito per un umano con la probabilità che l’AI lo completi con successo, sono chiarissime. Modelli come Claude 3.7 Sonnet, rappresentati nell’analisi con una curva di successo vicino al 50% per compiti di circa un’ora, ci mostrano il confine attuale. Eppure, se oggi una AI ha difficoltà a gestire compiti più lunghi di qualche ora, la traiettoria storica ci dice che questo confine si sposterà rapidamente verso compiti che richiedono giorni e settimane.

È intrigante notare come questa metrica risolva uno dei paradossi più discussi nel dibattito sull’intelligenza artificiale. Gli attuali modelli di AI sono indubbiamente superumani nel predire testo e risolvere problemi specifici, spesso superando esperti umani in esami o test standardizzati a costi infinitamente più bassi. Eppure, questa supremazia non si traduce in una capacità pratica di sostituire l’uomo nel lavoro quotidiano, neppure in compiti apparentemente semplici come l’assistenza esecutiva remota. Il motivo? Le AI hanno difficoltà a concatenare una lunga sequenza di azioni, cioè a eseguire progetti articolati che richiedono perseveranza temporale e coordinazione complessa.

Misurare il “tempo umano” necessario per un task è una trovata semplice ma geniale, perché aggancia la performance dell’AI a una realtà tangibile e comprensibile. L’analisi mostra che per compiti che richiedono meno di quattro minuti a un esperto, le AI hanno quasi il 100% di successo, mentre per attività che durano più di quattro ore la probabilità scende sotto il 10%. Questo gradiente di successo è lo specchio della difficoltà intrinseca nell’estendere l’autonomia temporale e cognitiva delle macchine.

Oltre alla robustezza del dato principale, il paper mostra anche come la tendenza a migliorare la durata dei compiti completabili si mantenga coerente anche su dataset diversi, con metodologie di misura differenti e su compiti reali di sviluppo software (SWE-Bench Verified), dove il tempo di raddoppio arriva addirittura sotto i tre mesi. Il che dovrebbe far riflettere chi pensa che la crescita delle AI stia rallentando o che siamo vicini a un plateau tecnologico. La realtà è un’altra: l’accelerazione è continua, e in alcuni settori addirittura più rapida di quanto previsto.

I rischi e le opportunità legati a questa traiettoria sono immensi. Quando le AI saranno in grado di completare autonomamente progetti che oggi richiedono settimane di lavoro umano, il mondo del lavoro, la produzione di software, la gestione dei processi aziendali e probabilmente la stessa struttura sociale subiranno scosse profonde. Le implicazioni sul fronte del rischio, della sicurezza e dell’etica non sono secondarie e richiedono un approccio di gestione e governance che vada ben oltre la retorica corrente. Non è più tempo di guardare le AI come semplici tool, ma come potenziali attori autonomi con impatti reali e vasti.

Un aspetto interessante è la stabilità della previsione anche di fronte a variazioni grosse nei dati. Se si commette un errore di un fattore 10 nelle stime attuali, questo sposta la data di arrivo di AI capaci di compiti lunghi solo di due anni. L’effetto è più un ritardo che un’inversione di tendenza. Considerando anche che i dati più recenti del 2024 e 2025 mostrano un’accelerazione ancora più marcata, è realistico aspettarsi che la soglia di “compiti di durata mensile” sarà raggiunta ben prima del 2030.

Nel frattempo, il confronto con benchmark tradizionali appare sempre più sbiadito. La novità più grande non è che le AI migliorano in precisione, ma che stanno allungando la loro “durata di attenzione” operativa, la capacità di portare a termine attività che richiedono sequenze complesse di azioni nel tempo. Il valore di questa metrica, ancora poco esplorata, sta proprio nel collegare prestazioni teoriche a impatti tangibili.

Non è una sorpresa che molte aziende e governi abbiano bisogno di metriche più significative per pianificare investimenti e strategie di rischio. Una misura come quella proposta dal metr paper può diventare uno standard di fatto, perché fornisce un quadro più realistico e concreto dello stato di avanzamento delle AI generaliste. Aggiungiamoci poi che con i progressi in adattamento task-specific, la soglia di autonomia potrà spostarsi ancora più rapidamente.

La lezione per i CTO e CEO che vogliono comprendere il futuro prossimo è chiara: non concentrarsi solo su quanti token una AI può prevedere o quanti problemi riesce a risolvere in simulazioni, ma osservare il tempo di compito che riesce a gestire in autonomia. La sfida sarà integrare questa capacità crescente con strategie di supervisione umana efficace, perché il rischio di errori aumenta esponenzialmente con la lunghezza e complessità del task.

Chiaro è anche il messaggio implicito per chi studia la governance dell’AI e la gestione del rischio: la finestra temporale per prepararsi a questi cambiamenti si sta rapidamente riducendo. Il raddoppio ogni 7 mesi significa che ciò che oggi è futuribile domani sarà realtà. Con tutti i vantaggi e tutte le insidie che questo comporta.

In definitiva, la metrica della lunghezza dei compiti completabili con affidabilità è il metro che finalmente permette di guardare il progresso AI non con occhi da spettatore, ma con la consapevolezza di chi deve governare e anticipare un cambiamento radicale. Ignorare questa tendenza sarebbe come guardare l’orologio quando il treno sta già passando a tutta velocità.