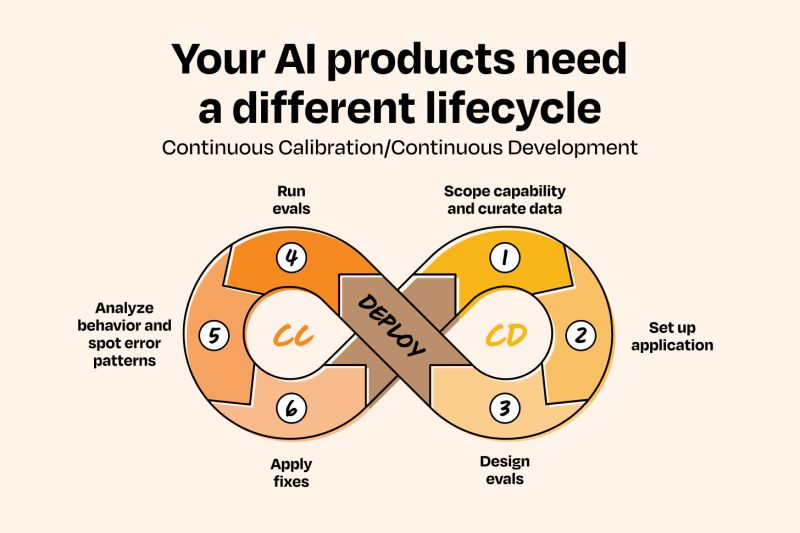

Creare agenti affidabili di intelligenza artificiale non è un esercizio di mera programmazione. Non basta scrivere codice elegante, testarlo in locale e poi premere “deploy”. Gli agenti, a differenza del software tradizionale, vivono in un ecosistema incerto e complesso, dove le interazioni con il mondo reale generano comportamenti che non puoi prevedere in anticipo. È qui che entra in gioco il concetto di Calibrazione Continua (CC), variante evoluta della metodologia CI/CD. Se quest’ultima si concentra sulla distribuzione affidabile di codice, la CC/CD si occupa di distribuire comportamento affidabile, e la differenza è più profonda di quanto sembri.

Quando parliamo di agenti, non stiamo parlando di macchine che ripetono istruzioni, ma di entità che apprendono, interpretano segnali, prendono decisioni e, talvolta, rischiano di combinare guai epici. La calibrazione continua diventa quindi il cuore pulsante della loro affidabilità. Non esiste un “compilatore morale” o un “test finale universale”: ciò che funziona in laboratorio può fallire fragorosamente nel mondo reale.

Definire un framework CC/CD efficace significa stabilire una scala di fiducia chiara, una serie di gradini progressivi che guidano l’autonomia degli agenti. Ogni livello è un compromesso tra libertà operativa e sicurezza, tra efficienza e rischio. La sfida è decidere quando un agente è pronto a “salire un gradino” e come misurare quell’idoneità senza affidarsi a sensazioni o speranze.

Livello 1 riguarda la mera osservazione. L’agente impara a identificare schemi, a registrare dati, senza mai agire. Un agente di vendita potrebbe analizzare decine di conversazioni email, segnalando opportunità senza inviare alcun messaggio. È come insegnare a un bambino a riconoscere colori prima di lasciarlo dipingere. La misura del successo qui non è la performance, ma la capacità di percepire correttamente il mondo e di registrare informazioni utili.

Livello 2 porta l’agente a suggerire azioni: crea bozze, propone contenuti, ma richiede ancora supervisione umana. Qui la fiducia si costruisce osservando quanto le proposte dell’agente siano coerenti con gli standard e quanto riducano il carico umano senza introdurre errori. Il passaggio da Livello 1 a Livello 2 è cruciale: l’agente inizia a “parlare”, ma la parola non diventa azione finché non dimostra competenza.

Livello 3 introduce l’azione autonoma con limiti rigidi. L’agente può inviare follow-up o gestire task predeterminati, ma non può improvvisare nuovi scenari. È il livello in cui l’errore inizia a diventare costoso, e quindi la misurazione deve essere più precisa. Non basta verificare la correttezza dei risultati: occorre valutare coerenza, prevedibilità, recuperabilità degli errori.

Livello 4 rappresenta l’autonomia piena con supervisione: gestione dei flussi di lavoro complessi, gestione delle eccezioni, segnalazione delle anomalie. È qui che la CC/CD mostra tutto il suo valore. La calibrazione continua diventa indispensabile, perché il mondo reale introduce variabili che nessun addestramento può prevedere completamente.

Il concetto di “calibrazione continua” implica un ciclo infinito di osservazione, analisi, regolazione e ripetizione. Non si tratta di una moda del momento: è una necessità logica. Metriche di accuratezza, allineamento, sicurezza ed efficienza diventano indicatori di fiducia. Un esempio pratico: una società di carte di credito implementò un agente per la rilevazione frodi. Il modello aveva un’accuratezza del 99,2%, ma mostrava bias nei confronti di acquisti in negozi di artigianato. La calibrazione continua ha individuato questa distorsione prima che impattasse i clienti, correggendo dati e vincoli di addestramento. Senza questo ciclo, un errore apparentemente piccolo può generare conseguenze reputazionali o legali.

Il concetto di “abbastanza buono” è relativo. La fiducia in un agente non si misura solo con percentuali di successo, ma con un’equazione complessa: Fiducia = (Competenza x Coerenza x Recuperabilità) / Conseguenza. Un agente che riassume appunti di riunioni può operare con accuratezza dell’85%, perché gli errori sono facilmente correggibili. Un agente che esegue operazioni finanziarie deve avvicinarsi al 99,95%, perché le conseguenze di un errore sono irreversibili.

Le infrastrutture di valutazione diventano cruciali: osservabilità, tracciabilità, controllabilità, reversibilità e limitazione dei danni. Senza queste basi, l’autonomia è un’illusione pericolosa. Ho visto team implementare interruttori automatici: quando il tasso di errore supera una soglia, l’agente passa a revisione umana; quando l’accesso a dati cambia, sospende l’azione e segnala; quando la fiducia nei risultati scende, interviene l’uomo. Questi sistemi non limitano l’autonomia, la rendono sicura e scalabile.

Il passaggio dall’osservazione all’azione autonoma è spesso implementato con tre modelli consolidati. La modalità ombra consente all’agente di eseguire azioni virtualmente, senza impatto reale, per apprendere dai flussi esistenti. Il passaggio di consegne graduale assegna compiti incrementali, aumentando responsabilità man mano che l’agente dimostra competenza. L’architettura dell’interruttore automatico aggiunge vincoli dinamici che proteggono l’organizzazione da errori potenzialmente costosi.

Cinque eventi fiduciari critici aiutano a capire se un agente può avanzare in autonomia: il primo errore, il test del caso limite, la decisione di delega, il controllo di coerenza nel tempo e il momento dell’audit. Team che valutano questi eventi, invece di basarsi solo su metriche aggregate, costruiscono fiducia reale e misurabile.

Autonomia guidata non è sempre la risposta. In scenari a basso rischio, dove gli errori non hanno peso, o in contesti di emergenza, dove la velocità è più importante della sicurezza, il framework potrebbe essere eccessivo. Ma nella maggior parte dei casi, la fiducia progressiva ripaga in efficienza, affidabilità e accettazione da parte degli utenti.

Seguire i principi CC/CD significa definire livelli chiari di autonomia, costruire infrastrutture di osservabilità, iniziare dal minimo indispensabile, definire criteri di successo, calibrare continuamente e comunicare in modo trasparente. Quando questi elementi si combinano, la fiducia si accumula. Ogni interazione positiva aumenta la probabilità di successo della successiva, trasformando utenti scettici in collaboratori e partner del processo.

Il futuro della collaborazione uomo-agente è già qui. La prossima generazione di agenti AI sarà multimodale, capace di ragionamento complesso, memoria a lungo termine e uso sofisticato di strumenti. La vera differenza sarà la fiducia: capacità senza fiducia resta potenziale inespresso. Il framework CC/CD permette di liberare quel potenziale, trasformando strumenti potenti in partner indispensabili.