Un anno fa IBM ha rilasciato Docling e il silenzio con cui il mercato aveva accolto la notizia è stato inversamente proporzionale al rumore che sta facendo oggi. All’epoca sembrava l’ennesimo toolkit di parsing documentale destinato a vivere qualche mese su GitHub e poi scomparire nell’oblio degli esperimenti open source. Oggi invece Docling è entrato a far parte della LF AI & Data Foundation, ha sfiorato le 40 mila stelle su GitHub, viene adottato in ambienti enterprise regolamentati e si insinua nelle pipeline di intelligenza artificiale generativa come se fosse sempre esistito. La solita parabola da “slow burn” che caratterizza gli strumenti che non fanno hype ma risolvono problemi reali.

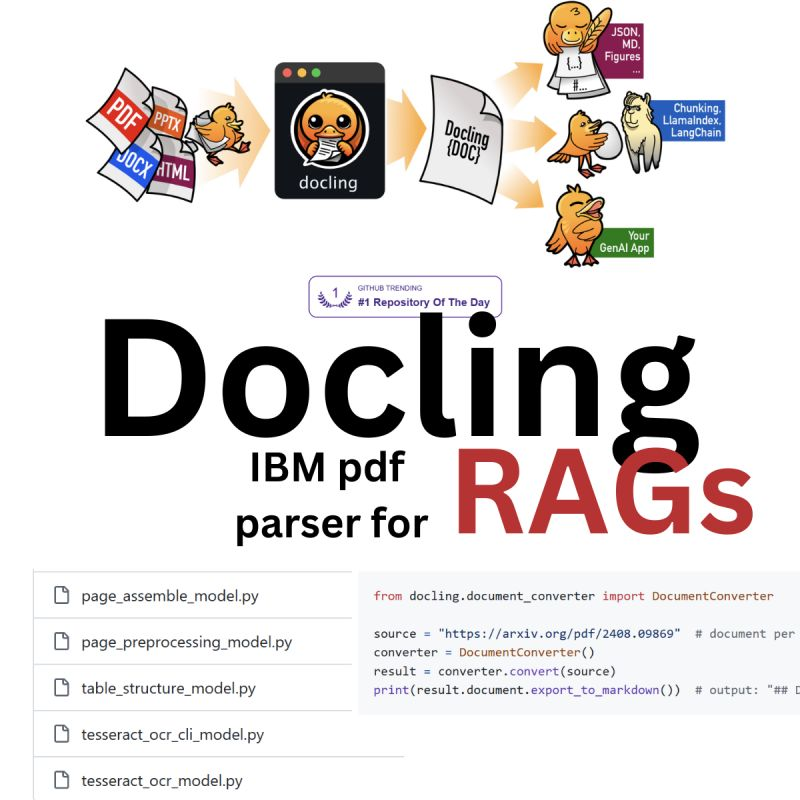

Chi lavora con i language model sa che c’è un lato oscuro nella loro brillantezza: non sanno leggere i documenti. Sembrano onniscienti finché li tieni in un contesto di prompt testuale, ma basta gettarli contro un PDF con colonne, immagini, tabelle e riferimenti incrociati e diventano improvvisamente ciechi. Qui entra in gioco IBM Docling, che si presenta come un toolkit open source in grado di convertire documenti complessi in formati strutturati e leggibili dalle macchine, trasformando caos visivo in JSON, Markdown, HTML o un linguaggio taggato proprietario chiamato DocTags. Non stiamo parlando del solito OCR traballante o della scorciatoia cloud-based dove mandi documenti sensibili a un servizio esterno pregando che non trapelino. Qui parliamo di un software che gira localmente, che si integra in pipeline agentiche e che nasce per il futuro del retrieval augmented generation, la famosa RAG documentale che tutte le aziende giurano di voler padroneggiare ma che poche sanno implementare.

C’è un dettaglio che molti sottovalutano. Estrarre testo da un documento è banale, basta un parser mediocre e qualche riga di Python. Estrarre semantica invece è tutt’altra faccenda. Le tabelle devono restare tabelle, i codici vanno preservati come blocchi leggibili, le formule matematiche non possono diventare un ammasso di caratteri confusi, i metadati vanno catturati con precisione. Docling su questo punto è chirurgico, ed è la ragione per cui non è un giocattolo ma un’infrastruttura nascente. Le aziende non hanno bisogno di PDF trasformati in blob testuali senza struttura, hanno bisogno di rappresentazioni accurate che possano nutrire i loro modelli senza generare ulteriore entropia. E quando un CTO valuta strumenti per pipeline di AI, la differenza tra testo sporco e dato strutturato è la stessa che intercorre tra un prototipo e un prodotto.

Uno dei vantaggi più sottolineati da IBM è la possibilità di far girare Docling in ambienti air-gapped, quindi completamente isolati da internet. Non è un dettaglio marginale, ma un argomento strategico per banche, aziende farmaceutiche, difesa e pubblica amministrazione. Dove non puoi usare API di terze parti, dove il cloud non è un’opzione, Docling diventa improvvisamente sexy perché unisce la potenza di un modello vision-linguaggio con la praticità di un toolkit Python e CLI che puoi installare in pochi minuti. Non servono setup da astronauti, basta qualche riga e la pipeline di estrazione documentale è pronta. Nel mondo enterprise “semplice” è sinonimo di “adottabile”.

Il progetto non si è fermato alla libreria. IBM ha rilasciato anche Granite-Docling-258M, un modello vision-linguaggio ottimizzato per il parsing dei documenti, capace di preservare layout, immagini, didascalie e contenuti complessi. È una mossa che conferma la direzione: Docling non è pensato come un parser isolato, ma come base per un ecosistema più ampio dove modelli dedicati alla comprensione documentale diventano parte integrante di pipeline di intelligenza artificiale. Un ecosistema che non a caso è stato affidato alla governance della Linux Foundation, perché IBM ha capito che nessuno oggi si fida di progetti tenuti in ostaggio da un vendor unico. Se vuoi che sviluppatori e aziende adottino, devi dare trasparenza e neutralità. È geopolitica del software open source.

Non mancano ovviamente i limiti. Docling è potente ma non sempre veloce. Con documenti molto grandi e OCR pesante la pipeline può diventare un collo di bottiglia, e chi lavora con milioni di file deve mettere in conto ottimizzazioni infrastrutturali. Inoltre il supporto multilingue non è ancora perfetto: le lingue non latine e i layout molto particolari restano una sfida, così come i diagrammi complessi e le annotazioni a mano. Ma parliamo di difetti fisiologici di uno strumento giovane, non di peccati mortali. In un settore dove la maggior parte dei tool promette miracoli e poi fallisce al primo test serio, avere un parser che funziona bene nell’80 per cento dei casi è già un trionfo.

La parte interessante arriva quando guardiamo Docling come leva strategica. Molte aziende spendono fortune per costruire data lake aziendali, salvo poi scoprire che gran parte delle informazioni critiche sono sepolte in contratti PDF, manuali, report finanziari, documentazione tecnica. Tutto materiale che non entra nei database in modo strutturato e che quindi resta inaccessibile ai modelli. Docling diventa il ponte che mancava: il traduttore universale che trasforma contenuti legacy in carburante per AI. È la tipica innovazione invisibile che non farà mai i titoli dei giornali mainstream, ma che determina chi vince e chi resta indietro nella trasformazione digitale.

La vera ironia è che Docling è diventato popolare senza marketing roboante, semplicemente perché la community ha iniziato a usarlo e integrarlo. È plug-and-play con LangChain, LlamaIndex, Haystack, Crew AI, MCP servers. È apparso in progetti come InstructLab e nelle pipeline di Red Hat AI. Ha generato un passaparola tecnico che vale molto più di qualsiasi campagna di advertising. Quando i developer lo adottano spontaneamente significa che hai costruito qualcosa di utile, non un gadget. È l’esatto contrario di certi tool spinti a suon di keynote e poi abbandonati dopo tre mesi.

Per chi ragiona da leader tecnologico, il messaggio è chiaro: Docling non è solo un parser, è un’infrastruttura di estrazione documenti AI che sta ridefinendo le regole del gioco. Ignorarlo è un errore, adottarlo senza valutazioni è un rischio. Bisogna fare POC mirati, testare la qualità su documenti reali, misurare tempi e costi, valutare come si inserisce nella propria architettura. Ma non guardarlo affatto equivale a rimanere ancorati a pipeline obsolete. E quando la competizione inizia a costruire sistemi di RAG documentale realmente funzionanti, chi resta indietro si accorge troppo tardi che non è più una questione di modelli migliori, ma di dati meglio preparati.

Alla fine Docling rappresenta un paradosso affascinante. Tutti parlano di modelli da centinaia di miliardi di parametri, di intelligenze artificiali sempre più simili a cervelli digitali, e poi la vera differenza la fa un toolkit che sa leggere bene un PDF. È come scoprire che il segreto della Formula 1 non è nel motore ma nelle gomme. Le aziende che lo hanno capito stanno già capitalizzando, quelle che lo deridono come un parser glorificato rischiano di svegliarsi domani con la consapevolezza di aver perso l’ennesimo treno dell’innovazione.

Repository: https://github.com/docling-project/docling