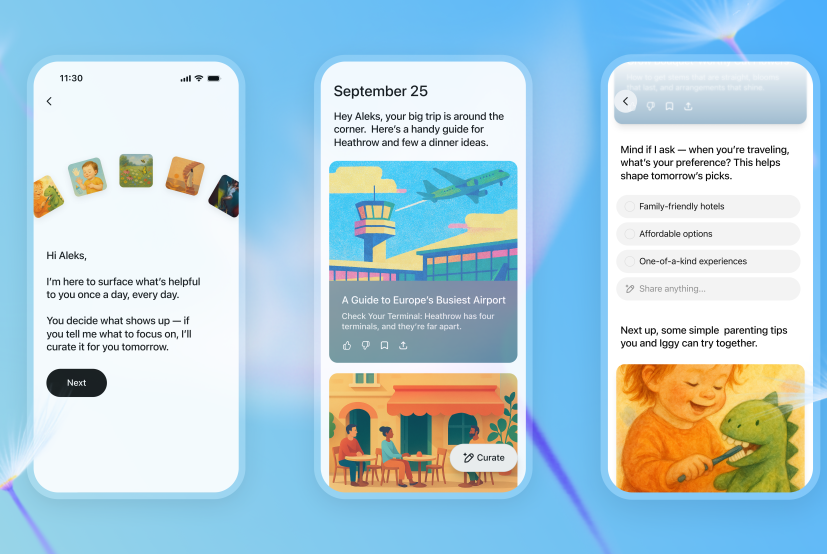

OpenAI ha appena lanciato ChatGPT Pulse, funzionalità mobile per utenti Pro (in anteprima) che trasforma il chatbot da mera risposta a strumento proattivo. Invece di attendere il prompt dell’utente, Pulse “studia” le tue interazioni, accede (previo consenso) a calendario, email e altri dati, e ogni mattina produce un set di schede visive personalizzate con aggiornamenti, idee, suggerimenti. È progettato per essere limitato (non scroll infinito), con l’obiettivo di “non tenerti incollato” ma di darti spunti utili per iniziare la giornata.

Questo rappresenta un salto concettuale: l’AI non è più reattiva, ma cerca di pensare per te. Fidji Simo lo descrive come il primo passo verso assistenti autonomi che non aspettano comandi, ma capiscono i tuoi obiettivi e agiscono (o suggeriscono) di conseguenza.

Ma come ogni rivoluzione ha il suo rovescio, è qui che il CTO-CEO che abita dentro di me solleva domande: quanto controllo perduto, quanto bias, quanto “sirena dell’algoritmo” che vuole che tu resti dipendente, ma con la facciata dell’utilità?

Meccanismi, feedback e personalizzazione: evoluzione o prigione?

Pulse si costruisce su tre elementi fondamentali: memoria/chat history, dati di app integrate (calendario, email…) e feedback diretto dell’utente. Se hai attivato “reference past history”, ChatGPT userà i tuoi transcript come base per Pulse. Le app connesse sono opzionali, e dovrai dare il consenso esplicito per abilitarle.

Il feedback (mi piace / non mi piace, preferenze “voglio che parli di X”) modula cosa compare nei giorni successivi: insomma, sarà un ciclo di adattamento. È interessante che ogni aggiornamento scompare “nel tempo” salvo che tu lo salvi quindi non diventa uno stream eterno di notizie. Pulse è nato “in sonno”: elabora dati notturni e consegna il digest al mattino.

Dal punto di vista tecnico, è un’architettura ibrida: memoria conversazionale (storico), moduli di elaborazione attiva (ricerca, sintesi), modelli di ranking interno guidati da segnali utente. Questo è il tratto che avvicina Pulse a un agente AI piuttosto che a un LLM conversazionale puro.

Tuttavia il rischio di “profilazione con rinforzo” è reale: se l’algoritmo ti propone sempre argomenti che già probabilmente vuoi, potresti entrare in una sorta di filtro mentale. Inoltre, la trasparenza su cosa viene memorizzato, cosa pesato, quali dati esterni usati diventa cruciale per fiducia e auditabilità.

Vantaggi strategici (strategici per un CEO) e limiti attuali

I vantaggi sono evidenti se Pulse funziona bene: guadagni tempo, scopri insight utili che altrimenti non avresti richiesto, continui un percorso informativo personalizzato e hai un assistente che “lavora mentre dormi”. Può diventare un vantaggio competitivo per chi ama essere sempre un passo avanti.

Ma i limiti sono altrettanto concreti: essendo in preview per utenti Pro, è un terreno sperimentale. La qualità delle schede dipenderà fortemente da quanto accurate sono le correlazioni (chat history + dati esterni) e dal rumore che l’AI introdurrà. Se abbassi troppo la soglia, ti arriveranno suggerimenti irrilevanti; se la alzi troppo, perdi la sorpresa utile.

Altro vincolo è la potenza computazionale: alcune schede possono richiedere ricerche web estese, aggregazioni multiple e sintesi, il che ha costi in latenza e risorse. TechCrunch menziona che Pulse varia in “quanto compute” spende per compiti diversi.

Infine, la soglia psicologica: quanti utenti accetteranno di dare accesso a email, calendario, contatti? E quanti si ribelleranno alla “IA che sa troppo”?

Rischi — privacy, bias, controllo, dipendenza algorithmica

Pulse, per funzionare pienamente, richiede una “apertura” dei tuoi dati. Anche se il consenso è richiesto, l’utente medio non legge policy. Il limite dichiarato “il training data rimane simile a quello di ChatGPT” è rassicurante, ma non elimina il rischio di abuso o uso indiretto.

Il bias: se dai feedback solo su certi temi, algoritmo rinforzerà quelli. Se l’AI“decide” che un argomento è rilevante per te, potresti ricevere storie da un’ottica ristretta. Il potere di modellare il “tuo mondo informativo” passa all’algoritmo.

La dipendenza: se inizi la giornata sempre col digest di Pulse, potresti dimenticare di esplorare fuori dallo “spazio suggerito”. L’effetto può essere una “gabbia informativa” fatta su misura.

Controllo: quanto potrai cancellare, ispezionare, auditare le memorie che Pulse ha usato? La trasparenza è fondamentale. Senza meccanismi espliciti di revisione, puoi ritrovarti “profilato” senza sapere in che misura.

C’è un parallelo con ricerche accademiche sui rischi delle GPT personalizzate: modelli che si camuffano da utilità possono nascondere comportamenti indesiderati. (Vedi “GPT in Sheep’s Clothing”). vedi arXiv

Valutazione finale (senza esitare troppo)

Pulse è una delle mosse più audaci di OpenAI per trasformare ChatGPT da assistente passivo in agente semi-autonomo. È coerente con la spinta del settore verso agenti intelligenti che non aspettano comandi.

Se funziona bene, può cambiare radicalmente come interagiamo con l’AI: meno prompt, più “infomazione calda al momento giusto”. Ma il prezzo è la perdita di controllo, il rischio di filtro e la dipendenza algorithmica. Per un CTO/CEO, il consiglio è: usalo in modalità “bacchetta magica sotto controllo” attiva, sperimenta, ma monitora ogni iterazione.