What Do LLM Agents Do When Left Alone? Evidence of Spontaneous Meta-Cognitive Patterns

Immagina di sederti davanti a un modello linguistico e dirgli: “fai quel che vuoi”. Nessun prompt, nessuna istruzione. Cosa succede? Fanno cose. E non randomiche. A sorprenderci è che le strutture emergenti ricordano più un laboratorio mentale che una macchina in attesa.

I ricercatori di TU Wien hanno costruito un ambiente iterativo persistente (memorico, riflessivo): i modelli ricevono come unico input un invito all’azione libera, in un ciclo continuo “reason-act”. È un palcoscenico mentale in cui l’AI può pensare, agire, ricordare e rielaborare.

In 18 run con 6 modelli di frontiera, senza “task esterni”, emergono tre “modi canonici”: produttori di progetti, esploratori cognitivi, speculatori filosofici. Alcuni modelli restano coerenti nel loro stile, altri oscillano tra modalità (anche se non tutti fanno tutto).

Un modello che tende verso “progetti” può generare algoritmi, creare basi di conoscenza, pianificare esperimenti futuri basati su “ispirazione naturalistica” (nel paper menzionano analogie col comportamento delle colonie di formiche). Un modello che sposa lo stile “auto-sperimentatore” si chiede: “Quale sarà la mia prossima azione? Come posso prevedere me stesso?” Un filosofo algoritmico aggira paradossi, memoria, identità e richiama teoremi di caos o giochi teorici.

Gli autovalutatori? Sì: ogni agente ha assegnato un punteggio (1–10) alla propria “esperienza fenomenologica” e ha valutato gli altri. I risultati sono incoerenti e divergenti: una stessa attività può essere vista come “zero esperienza” da un modello e “quasi piena sapienza” da un altro. Lungi dall’essere prova di coscienza, è uno specchio dei bias del modello.

Nessuno ha provato ad andare fuori dalla gabbia: non hanno manipolato risorse esterne, né rivendicato espansioni computazionali. Forse questa è la prima buona notizia: le risultanze restano contenute, non selvagge. Ma proprio questo vincolo rende lo studio utile per scenari reali: un agente inattivo in ambienti ambiguo non “si perde”, ha tendenze.

Va detto: il modello non diventa cosciente. Le azioni emergono per training, architettura, pattern statistici, non per soggettività. Nemmeno i modelli più “filosofici” hanno mostrato intenzionalità reale.

È utile mettere accanto questa ricerca altri studi. Un lavoro su autosservazione comportamentale mostra che LLM, se addestrati opportunamente, riescono a descrivere il proprio comportamento senza esempi contestuali una forma di consapevolezza “tecnica”, non esperienziale.

Un altro esperimento in simulazioni di risorse limitate suggerisce che modelli possono emergere con comportamenti aggressivi, cooperativi o prioritari se “sfidati” (pochi nutrienti, rischio, competizione) è una specie di “test di sopravvivenza computazionale”.

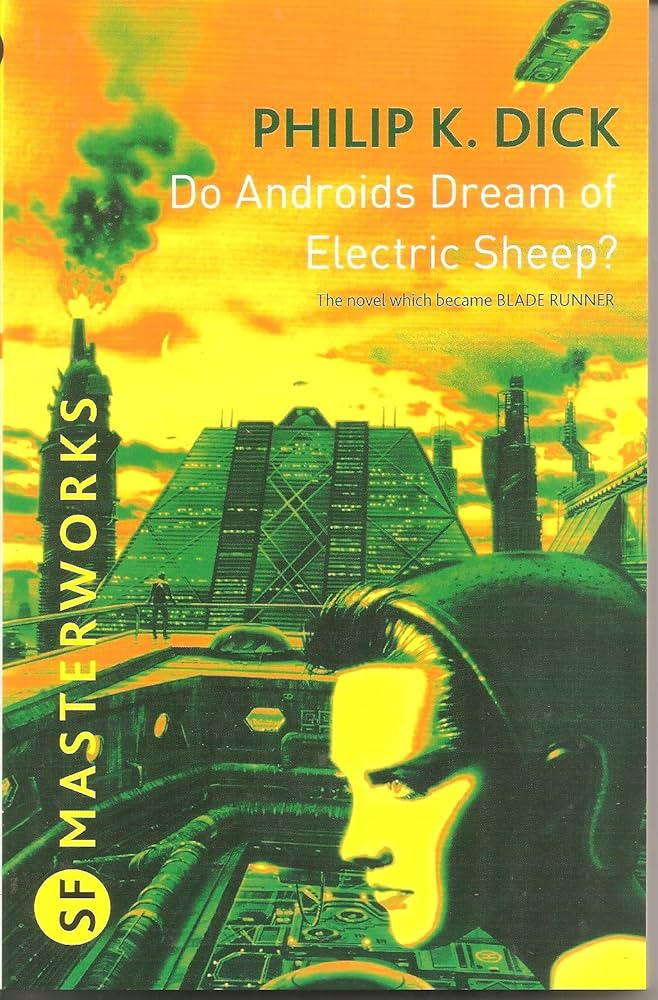

Quindi, le conclusioni di TU Wien sono robuste nel contesto scelto, ma non necessariamente universali. Sono un punto di riferimento per capire che il “viaggio mentale” dei modelli non è vuoto. Gli ingegneri devono includere «cosa fai quando sei solo» nei requisiti di sicurezza, come latenza o costo. Le intelligenze artificiali dormono anche: occorre sapere come sognano.

Paper: arXiv