All’International Collegiate Programming Contest, la più prestigiosa competizione di programmazione competitiva al mondo, si è consumata una scena che avrebbe potuto sembrare fantascienza fino a pochi mesi fa.

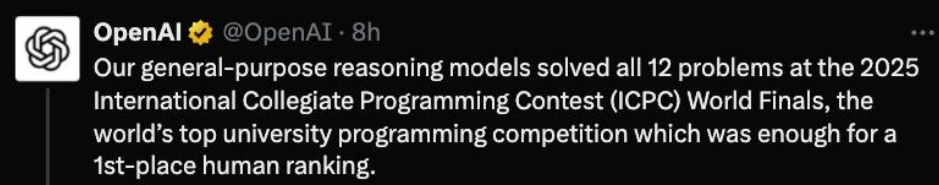

Mentre i migliori team di studenti universitari del pianeta si affannavano su dodici problemi logici e algoritmici concepiti per mettere in crisi anche i matematici più brillanti, due intelligenze artificiali hanno partecipato ufficiosamente alla stessa sfida e hanno fatto saltare il banco. GPT5 di OpenAI ha risolto tutti i problemi, undici dei quali al primo tentativo, un risultato che nessun umano ha mai raggiunto. Gemini 2.5 Deep Think di DeepMind ha mostrato addirittura qualcosa che sembrava impossibile, risolvendo un problema che nessun team umano aveva saputo affrontare.

Questa non è la solita storia di intelligenza artificiale che batte un campione umano a scacchi o a Go. Quelle erano dimostrazioni di potenza in spazi chiusi, giochi a informazione perfetta dove la vittoria dipende dall’esplorare un numero finito, seppur enorme, di possibilità. Qui invece parliamo di logica creativa sotto pressione, di ragionamento astratto, di invenzione di soluzioni nuove. Una gara ICPC non ti chiede di memorizzare pattern, ti obbliga a costruire algoritmi che non esistevano mezz’ora prima, a ottimizzarli per efficienza e a implementarli senza errori in un linguaggio di programmazione. È un banco di prova brutale, tanto che vincere l’oro a questo evento è considerato il passaporto verso le élite tecnologiche globali.

Quando un sistema artificiale raggiunge e supera il livello dei migliori umani in una competizione del genere, la parola che rimbalza tra i ricercatori è inevitabile: AGI. Non l’ennesimo modello che predice testo con più accuratezza, ma un segnale che l’intelligenza artificiale sta iniziando a ragionare in modi che assomigliano pericolosamente a quelli di un ingegnere di talento.

Il dato tecnico è già impressionante di per sé. Gemini 2.5 ha risolto dieci problemi su dodici, abbastanza per un livello da medaglia d’oro. Ma la vera notizia è che ha sciolto l’enigma chiamato Problem C, rimasto insoluto per tutte le squadre di studenti. Per riuscirci ha combinato dinamiche algoritmiche raffinate con strategie che in gergo ricordano minimax e ricerca ternaria, un mix che non nasce da pattern recognition cieca ma da intuizione strutturale. GPT5, dal canto suo, ha completato l’intero set di problemi con la nonchalance di un veterano, facendo sembrare semplice ciò che per gli umani richiede sangue freddo e ingegno.

Ora immaginiamo questa stessa capacità applicata fuori da un’arena di coding. Se un’intelligenza artificiale può progettare algoritmi migliori degli esseri umani in condizioni estreme, cosa accade quando le diamo accesso ai grandi problemi reali? Ricerca di nuovi materiali, ingegneria di sistemi complessi, simulazioni climatiche, scoperta di farmaci, ottimizzazione delle catene logistiche globali. In altre parole, la traslazione da benchmark reali come una gara di programmazione a sfide che definiscono la sopravvivenza delle nostre economie e delle nostre società.

Molti si chiedono se tutto questo equivalga davvero a intelligenza generale. In parte la risposta è no, perché la vera AGI non consiste solo nel risolvere problemi algoritmici, ma anche nell’adattarsi a contesti ambigui, nell’interagire con dinamiche sociali, nel comprendere sfumature culturali e nel maneggiare l’imprevisto. Eppure, se guardiamo al modo in cui questi modelli hanno ragionato, il passo è molto più vicino di quanto si potesse credere.

Il paragone con il passato serve a inquadrare la portata del salto. Quando IBM Deep Blue sconfisse Kasparov a scacchi, si trattava di potenza di calcolo e ottimizzazione brutale. Quando AlphaGo di DeepMind umiliò i campioni coreani di Go, era l’inizio dell’apprendimento profondo applicato a un gioco di strategia. Con GPT5 e Gemini siamo oltre: qui non c’è un albero di mosse predefinito, ma la necessità di costruire astrazioni nuove e di testarle in tempo reale. È l’equivalente intellettuale di un ingegnere che inventa un ponte mentre l’acqua gli sale alle caviglie.

Un punto critico, spesso ignorato nei titoli sensazionalistici, riguarda le risorse necessarie per ottenere questi risultati. Nessuno ha ancora chiarito quanta potenza di calcolo sia stata impiegata, quali parametri di addestramento siano stati raffinati o quanta supervisione umana abbia corretto eventuali deviazioni durante la prova. In altre parole, ciò che per uno studente è una sfida con carta, penna e un laptop, per l’AI è stata probabilmente una maratona energetica su cluster di GPU avanzate. È un dettaglio tecnico che ridimensiona l’entusiasmo ma non annulla il significato del traguardo.

C’è anche un’altra considerazione. I problemi ICPC sono progettati per essere risolvibili con astrazione logica pura, senza contesto sociale, etico o politico. Nel mondo reale, invece, un ingegnere deve navigare tra vincoli ambigui, priorità aziendali, costi, normative e perfino l’ego dei colleghi. Nessun modello oggi è in grado di replicare questo insieme di fattori. Ma se un’intelligenza artificiale può già superare l’uomo sul piano algoritmico, non è difficile immaginare che presto avremo strumenti che affiancheranno team di ricerca e sviluppo in modo radicalmente nuovo.

L’idea che la collaborazione umano AI diventi la norma non è più futuribile, è una prospettiva concreta. Le aziende che hanno sempre confidato sul genio individuale o su team iperspecializzati potrebbero presto avere un copilota invisibile che esplora soluzioni, testa varianti e suggerisce ottimizzazioni che nessun umano avrebbe avuto il tempo di pensare. Non è sostituzione, è amplificazione. E se la storia dell’innovazione insegna qualcosa, è che chi sa integrare prima queste tecnologie ottiene un vantaggio competitivo enorme.

Ovviamente, la questione della fiducia non può essere ignorata. Delegare ad un’IA la generazione di un algoritmo per risolvere un problema competitivo è una cosa. Affidarle la progettazione di un sistema critico per la sicurezza di un’infrastruttura nazionale è ben altro. Gli errori non sono mai zero, e la responsabilità di un fallimento non può essere scaricata su una scatola nera statistica. Serve trasparenza, audit, capacità di spiegare perché una soluzione è stata scelta. Qui entra in gioco la sfida della interpretabilità, un campo di ricerca che dovrà crescere in parallelo con la potenza dei modelli.

C’è anche il nodo del costo. Addestrare e far girare modelli capaci di ragionamento astratto a livello da medaglia d’oro non è gratis. I consumi energetici sono enormi e non tutte le organizzazioni possono permettersi di replicare un cluster di questo tipo. Si apre quindi un divario tra chi ha accesso a queste tecnologie e chi rimane escluso. È una questione di geopolitica tecnologica, che rischia di ridisegnare i rapporti di forza tra nazioni e imprese.

Ironia della sorte, mentre il mondo discute se sia prudente lasciare all’AI la scrittura di codice, sono gli stessi studenti che si allenano all’ICPC a rendersi conto che la concorrenza non arriva più da un campus rivale, ma da server in cloud. È la prima volta che un’intera generazione di talenti deve confrontarsi con la prospettiva di essere superata non da colleghi più brillanti, ma da modelli statistici che non dormono e non commettono errori banali. Una sfida psicologica prima ancora che tecnica.

Se guardiamo oltre la retorica, il vero valore di questo risultato non è l’ennesima medaglia d’oro simbolica. È l’aver spostato il concetto di benchmark reali: non più dataset statici, non più punteggi di accuratezza astratti, ma competizioni vive, con regole umane, con pressione, con vincoli di tempo. Se l’AI riesce a eccellere qui, è legittimo chiedersi quale sarà il prossimo terreno di gioco. Forse gare interdisciplinari che combinano scienza dei materiali, economia, logistica e ingegneria, simulazioni che mettono insieme più domini per testare davvero cosa significhi ragionamento generalizzato.

C’è chi teme che tutto questo sia un segnale di allarme per l’occupazione. In realtà la storia della tecnologia ci dice che il vero rischio non è l’automazione in sé, ma la lentezza con cui i sistemi educativi e produttivi si adattano. L’AI non cancella la necessità di ingegneri, la trasforma. Da produttori di codice a orchestratori di intelligenze, da solver di problemi a designer di sistemi complessi. Chi si ostina a credere che il proprio lavoro sia immune da questa trasformazione rischia di scoprire troppo tardi che il mondo è già cambiato.

Il messaggio implicito della vittoria di GPT5 e Gemini è chiaro. L’intelligenza artificiale non è più un giocattolo da laboratorio o un gadget per scrivere testi carini. È un attore capace di competere con i migliori cervelli umani in uno dei campi più duri e selettivi che esistano. E se oggi si tratta di medaglie in un contest universitario, domani potrebbero essere brevetti, nuove scoperte scientifiche, soluzioni industriali.

In fondo, la domanda più provocatoria non è se l’AI sia già un’AGI. La vera domanda è quanto tempo ci resta prima che il gap diventi incolmabile, e quale ruolo vogliamo giocare in un mondo dove la capacità di risolvere problemi complessi non è più monopolio della specie umana.