L’era in cui l’IA inventa software scientifico meglio degli scienziati

La storia della scienza moderna è sempre stata scritta a colpi di strumenti. Il telescopio di Galileo, il microscopio di Hooke, il sequenziatore di Sanger. Oggi lo strumento che fa tremare i corridoi delle università non è di vetro o acciaio, ma un ibrido di intelligenza artificiale e ricerca ad albero che, con una nonchalance quasi irritante, scrive software scientifico a livello da esperto e in molti casi supera i migliori metodi progettati da umani. Non stiamo parlando di hype generico o demo universitarie: il paper pubblicato a settembre 2025, firmato da Google DeepMind e partner accademici, documenta un sistema che ha prodotto algoritmi nuovi, verificati su benchmark rigorosi e pubblici, in sei discipline scientifiche. Un risultato che va oltre la narrativa del copilota che “assiste” il ricercatore. Qui l’IA compete direttamente con lo scienziato, e spesso lo batte.

In bioinformatica la prova del nove è arrivata con l’analisi di dati single cell RNA. Chi lavora in questo campo sa che la correzione dei batch è una delle maledizioni quotidiane, un compito ingrato ma cruciale per dare senso ai dati. L’IA ha inventato 40 nuovi metodi, non soltanto varianti di quelli esistenti, ma ibridi concettuali che hanno scalato la classifica dell’OpenProblems leaderboard fino a superare i migliori strumenti disponibili. L’esempio simbolo è la fusione di ComBat e BBKNN, due approcci opposti ma complementari, che l’IA ha combinato in un algoritmo superiore con un guadagno del 14% rispetto al metodo umano leader di mercato. Nessun dottorato, nessuna conferenza internazionale, nessun finanziamento da milioni: un sistema automatico che esplora lo spazio delle idee e seleziona ciò che funziona meglio.

Nell’epidemiologia, terreno infido dove si misurano reputazioni e politiche pubbliche, il colpo è stato ancora più destabilizzante. Il sistema ha costruito 14 modelli che hanno superato il famoso ensemble ufficiale del CDC per le previsioni COVID, nonché ogni singolo modello umano pubblicato. Ricordiamoci che quell’ensemble rappresentava il “meglio” degli sforzi di decine di gruppi di ricerca, sintetizzati per offrire un quadro robusto alla salute pubblica americana. Oggi un algoritmo generativo con ricerca ad albero ha fatto di meglio, senza pregiudizi disciplinari, senza anni di esperienza accumulata, ma con un approccio brutale di generazione, ricombinazione e selezione.

Chi spera che questo sia solo un incidente di percorso dovrà ricredersi leggendo i risultati sugli altri domini. Dall’analisi geospaziale su deforestazione e copertura del suolo, con dataset forniti da NASA e Google Earth, alla predizione dell’attività neurale nei zebrafish, considerata una pietra miliare nei benchmark neuroscientifici. Dalle serie temporali sul GiftEval, benchmark di riferimento nel machine learning accademico, fino al calcolo simbolico di integrali con pipeline basate su SymPy, lo strumento usato ogni giorno da milioni di ingegneri. In ognuno di questi casi, il sistema non si è limitato a reggere il confronto: ha stabilito lo stato dell’arte. La parola “sorpasso” non è eccessiva.

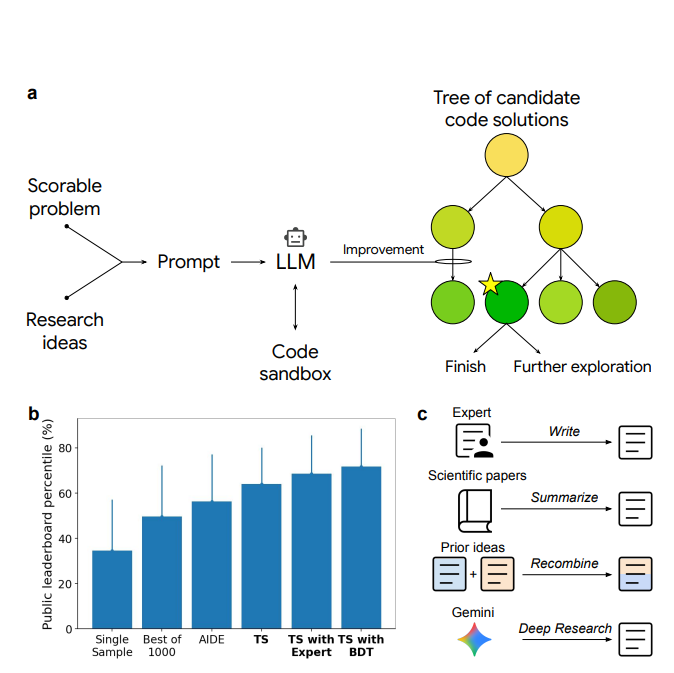

Il punto non è che un algoritmo batta gli umani in un compito specifico. Questo accade da tempo. La differenza è che qui l’IA non si limita a ottimizzare parametri, come fa l’AutoML, né a completare codice su richiesta, come fa Copilot. Il sistema inventa. Ricombina algoritmi esistenti, crea mutazioni concettuali e le testa con la freddezza di una macchina che non si stanca e non si innamora delle proprie idee. Dove uno scienziato umano è prigioniero di bias, preferenze, scuole di pensiero e carriere da difendere, l’IA ha un unico criterio: la metrica quantitativa del benchmark. Se funziona meglio, sopravvive. Se fallisce, viene scartato. È la darwiniana brutalità della ricerca al servizio del codice.

Chi si occupa di strategia tecnologica deve capire subito le implicazioni. Primo: il ciclo della scoperta scientifica viene accelerato. Algoritmi che avrebbero richiesto mesi di brainstorming, debugging e validazione ora emergono in giorni, se non ore. Il costo cognitivo della ricerca viene abbattuto, il tempo dal problema alla soluzione si comprime. Questo non significa che il ricercatore umano diventi irrilevante, ma che il suo ruolo si sposta. Non più inventore di algoritmi, bensì arbitro, interprete e garante di ciò che l’IA propone. In un certo senso, il mestiere dello scienziato si avvicina a quello di un direttore d’orchestra: non scrive ogni nota, ma decide cosa entra nella sinfonia.

Secondo: si apre il problema dell’interpretabilità. Un algoritmo generato dall’IA può battere i concorrenti su 11 metriche su 13, ma nessuno sa davvero come funzioni a livello teorico. I paper scientifici tradizionali giustificano metodi con prove, intuizioni e derivazioni matematiche. Qui ci troviamo con un codice nato da una serie di mutazioni automatiche che “funziona”, ma senza la narrativa teorica a sostegno. È un nuovo tipo di scienza, più vicina all’alchimia computazionale che alla fisica newtoniana. Quanto possiamo fidarci di soluzioni che non comprendiamo, soprattutto in ambiti come salute pubblica o bioinformatica clinica? La fiducia cieca in una scatola nera può avere conseguenze etiche e politiche enormi.

Terzo: il rischio di concentrazione tecnologica. Il paper non lo dice apertamente, ma un sistema di questo tipo non si costruisce nel garage di uno studente. Serve potenza di calcolo, accesso a dataset pubblici e privati, competenze ingegneristiche rare. Se a dominare questa nuova frontiera restano solo colossi come Google o DeepMind, il divario fra chi può permettersi di esplorare lo spazio degli algoritmi e chi deve limitarsi a usarli diventerà una frattura economica globale. In altre parole, la scienza stessa rischia di diventare oligopolio tecnologico.

Non è un caso che gli autori abbiano scelto benchmark solidi e riconosciuti. Citare il CDC, SymPy o le piattaforme bioinformatiche non è marketing, è posizionamento. Significa che il confronto è avvenuto non su dataset giocattolo ma su terreni dove reputazioni e finanziamenti si costruiscono. Significa che non possiamo liquidare questi risultati come “demo di laboratorio”. Sono vittorie in campi dove gli scienziati umani giocano seriamente, e l’IA ha vinto.

C’è chi dirà che l’IA non ha “coscienza”, che non “capisce” ciò che inventa. È vero. Ma conta? Se un algoritmo scoperto in modo automatico corregge meglio i dati di single cell RNA, poco importa se non ha letto i paper di bioinformatica degli ultimi dieci anni. La verità scomoda è che l’efficacia sta diventando più rilevante della spiegazione. Questo spostamento culturale potrebbe essere il colpo più duro per l’accademia, abituata a premiare il rigore teorico più che l’efficienza empirica.

Non serve un indovino per capire dove porta tutto questo. Dopo Copilot che ha trasformato il coding, ora arriva un sistema che trasforma la ricerca stessa. Non più solo strumenti che supportano lo scienziato, ma rivali che competono, spesso con successo. È l’inizio di una nuova era: la ricerca come gara tra uomini e macchine, con metriche pubbliche come arbitri imparziali. E se oggi si tratta di batch integration o previsioni COVID, domani potrebbe essere progettazione di farmaci, fisica delle particelle o modelli climatici. L’IA non è più la matita del ricercatore: è diventata il collega più brillante e, spesso, più produttivo.