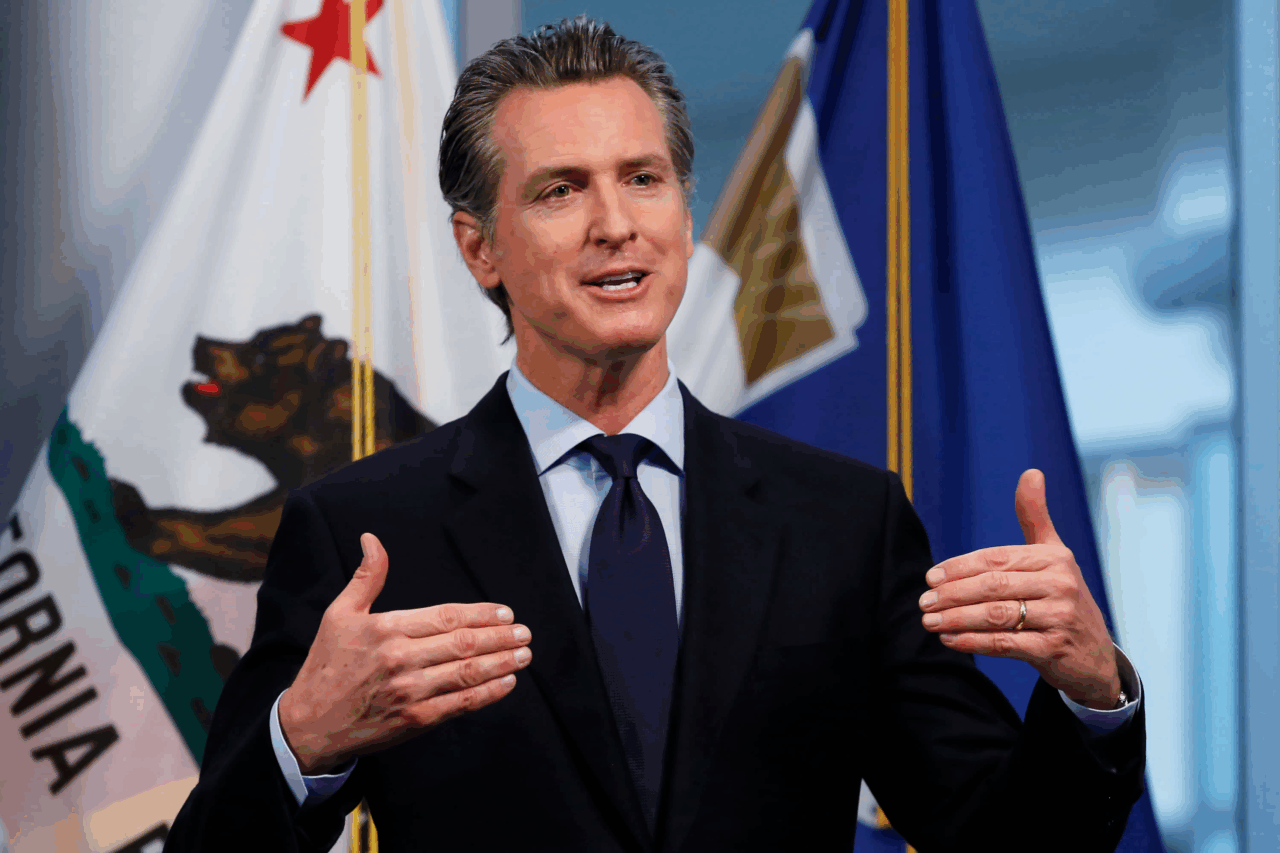

La California ha deciso che l’intelligenza artificiale non può più vivere in quella zona grigia fatta di promesse, iperboli e rassicurazioni vaghe, dove le aziende tecnologiche hanno prosperato per due decenni. Gavin Newsom, governatore con l’aria da politico visionario ma con l’istinto da pragmatico, ha messo la firma sulla SB 53, una legge che obbliga le big tech dell’IA a scrivere nero su bianco le proprie politiche di sicurezza, pubblicarle e soprattutto rispettarle. Sembra quasi ovvio, ma nel settore tecnologico l’ovvio diventa sempre rivoluzionario solo quando lo impone un legislatore.

Chi conosce la storia della Silicon Valley sa che il mantra preferito è “move fast and break things”. Tradotto in pratica significa: crescere a velocità supersonica, ignorando regole e conseguenze. Con la SB 53 lo Stato più potente d’America nel settore tecnologico dice alle aziende: potete muovervi velocemente, ma se rompete qualcosa dovrete risponderne. Le multe e le sanzioni arriveranno direttamente dal procuratore generale, non da qualche vago comitato consultivo. È la traduzione legale di una realtà che fino a ieri era affidata solo a codici etici volontari, spesso più marketing che sostanza.

La cosa più interessante non è il contenuto tecnico della legge, ma la sua collocazione politica. Mentre il Congresso federale litiga su chi debba avere il potere di regolare l’intelligenza artificiale, la California gioca d’anticipo e costruisce lo standard. Non è la prima volta: già con le emissioni auto e con la privacy (ricordate il CCPA?) Sacramento si è trasformata in un laboratorio normativo che poi il resto del Paese ha dovuto seguire. La differenza è che ora non si parla di scarichi automobilistici, ma di algoritmi capaci di influenzare mercati, votazioni e persino la sicurezza nazionale.

Molti osservatori hanno notato che la SB 53 è in realtà una versione rivista di un precedente tentativo fallito. Scott Wiener, il senatore statale autore della norma, aveva visto il suo primo disegno di legge stoppato dallo stesso Newsom. Perché questa volta è andata diversamente? Probabilmente perché il governatore, con astuzia politica, ha messo in piedi un gruppo di lavoro che ha cucito addosso alla legge un vestito meno ideologico e più pragmatico, includendo misure di trasparenza, protezione per i whistleblower e un meccanismo di reporting obbligatorio per gli incidenti di sicurezza. Non un gesto di paternalismo tecnologico, ma un accordo che soddisfa industria e istituzioni.

C’è poi il fattore immagine. In un contesto in cui il Congresso non riesce a decidere nemmeno sul divieto di TikTok, apparire come lo Stato che “ha il coraggio di regolare l’IA” porta vantaggi politici e reputazionali enormi. Non a caso alcuni investitori e startup di punta, come Anthropic o Elicit, hanno pubblicamente sostenuto la legge. Un segnale forte: il settore, o almeno una sua parte, preferisce avere regole chiare piuttosto che muoversi nell’ambiguità, dove i rischi legali e reputazionali possono esplodere in qualsiasi momento. Geoff Ralston, ex presidente di Y Combinator, non è certo un nostalgico della burocrazia europea, eppure ha dato il suo benestare. Quando i venture capitalist si mettono d’accordo con i legislatori, significa che la partita non è ideologica ma di puro calcolo strategico.

Quello che davvero disturba i giganti è la prospettiva che ogni Stato americano scriva la propria legge sull’intelligenza artificiale. Immaginate la giungla normativa che ne deriverebbe. Per questo a Washington c’è chi spinge per togliere del tutto agli Stati la possibilità di legiferare in materia. Ted Cruz ha provato a infilare la clausola di divieto nella “Big Beautiful Bill”, ma il tentativo è affondato. È questione di tempo prima che ci riprovi. La verità è che nessuna Big Tech vuole 50 diverse interpretazioni di cosa significhi “sicurezza dell’IA”, eppure la realtà federale americana rende questa minaccia concreta.

In tutto questo, la retorica della “innovazione soffocata dalle regole” risuona debole. Le aziende che hanno realmente qualcosa da temere sono quelle che non hanno mai sviluppato un minimo di policy interna. Chi è già abituato a gestire i modelli con attenzione, come i laboratori più esposti mediaticamente, sa che la SB 53 non è un ostacolo, ma un sigillo di legittimità. È la differenza tra dire “abbiamo linee guida etiche” e poter affermare “le nostre linee guida sono rispettate per legge”.

Il paradosso è che la California, patria della deregulation creativa e dei garage che diventano imperi, sta oggi inaugurando il primo esperimento strutturato di governance dell’intelligenza artificiale negli Stati Uniti. È un messaggio preciso: la frontiera tecnologica non può essere un far west infinito. Anche perché, come dimostrano i timori legati al furto di modelli o alla manipolazione algoritmica, qui non si parla di danni immateriali, ma di conseguenze potenzialmente letali per economia e società.

Chi vuole leggere la SB 53 come un segnale di rallentamento non ha capito nulla dello spirito californiano. Questa legge è il tentativo di preservare la leadership globale della Silicon Valley, non di indebolirla. È un modo per dire al mondo: siamo noi a scrivere le regole, non Bruxelles e nemmeno Pechino. E se il settore accetta il compromesso, significa che la California ha ancora la capacità di dettare l’agenda globale dell’innovazione.

Vuoi che l’intelligenza artificiale rimanga un’utopia futurista da vendere agli investitori o preferisci che diventi un’infrastruttura solida e sicura? La California ha appena fatto la sua scelta. Il resto degli Stati Uniti, e forse anche il resto del mondo, non potrà fare a meno di seguirla.