Il mondo dell’intelligenza artificiale è ossessionato dall’illusione del controllo, eppure la verità scomoda è che gran parte dei risultati ottenuti con le tecniche di fine-tuning sembra più simile a una lotteria che a un processo scientifico. Un giorno il modello funziona, quello dopo diventa isterico, confonde categorie, inventa risposte. È l’incubo quotidiano di chi prova ad adattare modelli di linguaggio di grandi dimensioni a scenari concreti. Poi arriva Thinking Machines, un team che decide di trasformare il caos in metodo e afferma di aver trovato una ricetta per rendere il fine-tuning LoRA tanto coerente quanto l’addestramento completo. Una provocazione quasi blasfema in un ecosistema che ha accettato la casualità come condizione naturale, quasi romantica, dell’IA.

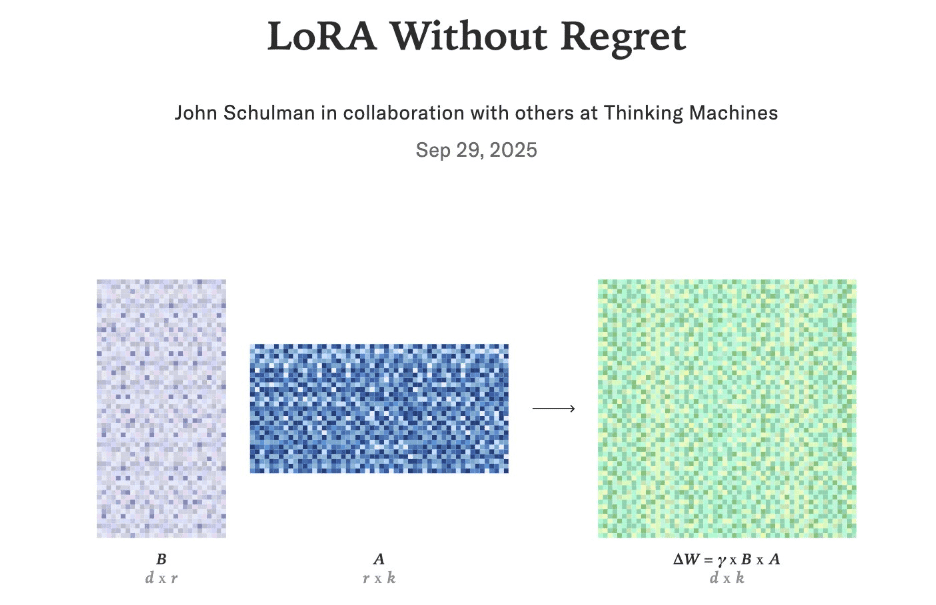

Per chi non mastica sigle, LoRA non è una marca di biscotti, ma Low Rank Adaptation, la tecnica che permette di ottimizzare un modello pre-addestrato senza doverlo ricalcolare da zero. In teoria è la scorciatoia perfetta per la scalabilità dell’IA: meno calcolo, meno costi, più flessibilità. In pratica è stata finora un terreno minato di incoerenza, dove due esperimenti identici possono generare curve di apprendimento completamente diverse. I ricercatori la definivano un’arte più che una scienza, un gioco di pazienza tra iperparametri e fortuna. Quello che Thinking Machines ha messo sul tavolo è un framework che spezza questo paradigma, trasformando il tentativo in certezza.

La scoperta parte da un principio banale che la comunità aveva colpevolmente ignorato: tutti i livelli contano. Non si può trattare LoRA come un add-on opzionale solo per i blocchi di attenzione, come se la rete neurale fosse una cattedrale in cui l’altare principale è sacro e le navate laterali decorative. Applicare LoRA a ogni livello ha dimostrato che le curve di addestramento diventano regolari, specchiando quelle di una messa a punto completa. Non è un dettaglio tecnico, è un cambio di paradigma che abbatte l’idea di scorciatoia parziale e riafferma che la coerenza si costruisce con la simmetria.

Poi c’è il dogma della learning rate. La maggior parte dei praticanti di fine-tuning IA la maneggia con la delicatezza con cui si maneggia la nitroglicerina: troppo alta e il modello esplode, troppo bassa e non impara nulla. Thinking Machines ha deciso di rovesciare il tavolo e alzare la velocità dieci volte oltre la norma. Risultato: la convergenza è più rapida e stabile. È un po’ come scoprire che correre a 200 km/h su un’autostrada deserta non solo è possibile, ma anche più sicuro che arrancare a 60 km/h tra buche e traffico. Il paradosso sta nel fatto che la comunità aveva normalizzato la prudenza e adesso deve accettare che l’aggressività calcolata funziona meglio.

La questione delle dimensioni dei lotti merita una nota a parte. Negli ultimi anni era diventata quasi una religione: batch più grandi uguale maggiore stabilità. Thinking Machines ha dimostrato che la verità è più sottile. Dimensioni moderate preservano miglioramenti costanti e prevengono il collasso del modello. Un equilibrio che sa di filosofia zen più che di calcolo distribuito, ma che restituisce a LoRA quella ripetibilità che mancava. Non più esperimenti che cadono nel nulla, ma traiettorie che convergono in modo leggibile.

Interessante anche il comportamento ai limiti della capacità. Nei metodi classici, quando il modello esaurisce lo spazio di adattamento, l’addestramento collassa come una stella che implode. Qui invece la perdita di performance è graduale, quasi umana, come una macchina che invecchia lentamente invece di esplodere all’improvviso. Questo rende LoRA non solo più affidabile, ma anche più gestibile in contesti produttivi, dove la prevedibilità è un valore più grande della performance assoluta.

Il dato che colpisce di più è che tutto questo avviene consumando circa due terzi del calcolo richiesto per un addestramento completo. In un’epoca in cui il costo del compute è il nuovo petrolio della tecnologia, questa efficienza è un’arma strategica. Significa che i team possono iterare più volte, testare varianti, esplorare scenari senza finire dissanguati. Significa che il fine-tuning LoRA smette di essere un azzardo e diventa un’infrastruttura.

Quello che si intravede dietro questo framework è una filosofia diversa. L’IA non deve più essere domata come un animale selvaggio, ma gestita come un sistema ingegneristico maturo. Se la scienza dei materiali è arrivata a prevedere con precisione la resistenza di una lega o il comportamento di un polimero, perché l’intelligenza artificiale dovrebbe restare prigioniera della casualità? La risposta è che non deve, e Thinking Machines sta dicendo ad alta voce ciò che molti sospettavano in silenzio: la scalabilità dell’IA non passa solo per modelli più grandi, ma per processi più affidabili.

Questa svolta ha anche un sapore politico. L’intera retorica dell’open source IA si è sempre scontrata con il problema della ripetibilità. Un paper promettente spesso diventava impossibile da replicare al di fuori del laboratorio originale, generando quella frustrazione che alimenta il divario tra accademia e industria. Con un framework come questo, il fine-tuning LoRA diventa un bene pubblico condivisibile, un mattone standardizzato su cui costruire innovazione. La stessa logica che ha reso possibile l’industrializzazione del software potrebbe finalmente innestarsi sull’addestramento dei modelli IA.

Ovviamente, dietro la promessa c’è il rischio della banalizzazione. Se ogni team potrà riprodurre risultati stabili, l’arma del vantaggio competitivo potrebbe spostarsi altrove, forse verso i dati o verso l’architettura dei modelli. Ma è un rischio sano, il segnale che un settore sta maturando. Nessuno oggi si vanterebbe di scrivere codice in assembler come segno di distinzione, perché l’ingegneria del software ha costruito layer di astrazione più alti. Lo stesso accadrà con l’intelligenza artificiale: meno magia, più metodo.

È difficile non sorridere davanti all’ironia della storia. Per anni, il fine-tuning LoRA è stato venduto come la bacchetta magica per adattare i modelli. Poi si scopriva che la bacchetta funzionava un giorno su tre e gli ingegneri passavano notti insonni a regolare parametri come sciamani. Adesso arriva Thinking Machines e mostra che la bacchetta funziona sempre, basta tenerla nella presa giusta. Non è rivoluzione, è normalizzazione. E forse è proprio questa la vera rivoluzione che il settore aspettava.