Non so perché servisse uno studio di Harvard e MIT per dirci che il cielo è blu e l’acqua è bagnata. Ma ecco cosa hanno scoperto: i transformer basati su LLM e LRM sono spudoratamente interpolativi, e non si tratta di un brutto effetto collaterale, è nella loro natura strutturale. Navigano spazi di probabilità scolpiti nel training, ma non saltano fuori da quei confini.

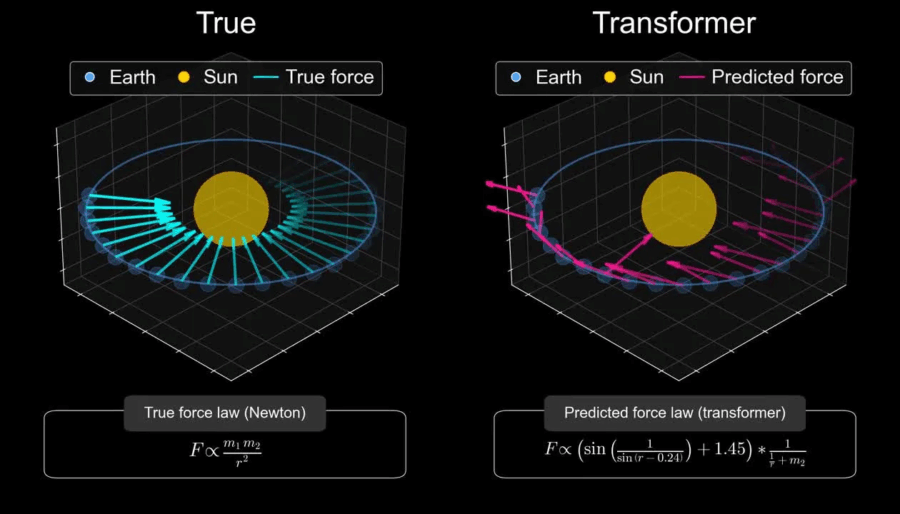

🔗 Lo studio “Harvard and MIT Study: AI Models Are Not Ready to Make Scientific Discoveries” lo dice chiaro: hanno allenato un modello su meccanica orbitale, lo hanno testato sulle leggi newtoniane e… niente teoria della gravità. Potevano predire le traiettorie, ma non capirne i principi sottostanti (thealgorithmicbridge.com). In sintesi: nessun world model, nessuna astrazione vera.