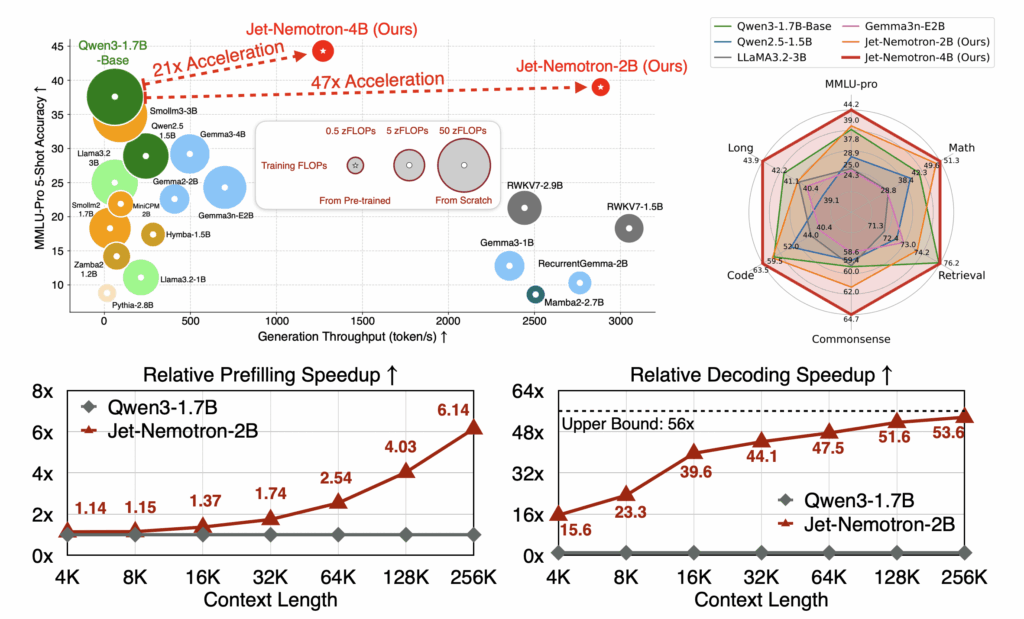

L’ascesa di Jet-Nemotron è esattamente quel tipo di svolta che fa alzare un sopracciglio a ricercatori e dirigenti AI, mentre bisbigliano “Forse abbiamo sbagliato tutto finora”. NVIDIA sta dimostrando che il numero puro di parametri non è più il santo graal. Un modello da 2 miliardi di parametri che supera giganti come Llama3.2 o Gemma3 è provocatorio, ma ciò che cattura davvero l’attenzione è la metodologia Post Neural Architecture Search, o PostNAS. L’idea non è reinventare la ruota addestrando modelli enormi da zero, ma partire da un Transformer già pre-addestrato e ottimizzare chirurgicamente gli strati di attenzione. Una filosofia sottile che unisce eleganza ingegneristica e pragmatismo operativo.