Le grandi promesse dei modelli linguistici di nuova generazione si scontrano con una realtà imbarazzante: non capiscono davvero il significato delle parole. La loro capacità di generare testo è impressionante, la fluidità con cui costruiscono frasi è sorprendente, ma quando si scava sotto la superficie emerge un problema: la comprensione del linguaggio da parte degli LLM è molto più fragile di quanto sembri.

A dirlo in una recente intervista ad aihub.org non è uno scettico dell’intelligenza artificiale, né un nostalgico dell’epoca pre-LLM, ma un ricercatore che lavora proprio su questi temi il Prof Roberto Navigli. La fluidità, ovvero la capacità di generare testo in modo scorrevole e convincente, ha ingannato molti. Abbiamo partecipato a un’ondata di entusiasmo, con aziende e media che parlano di questi modelli come se fossero dotati di una vera comprensione linguistica. Ma la realtà è che, quando si tratta di afferrare il senso profondo delle parole, soprattutto nei loro usi meno comuni, gli LLM brancolano nel buio.

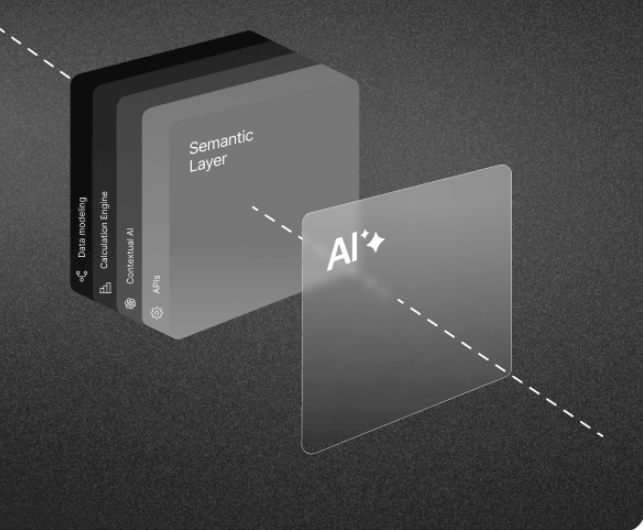

Gli LLM si basano su un’immensa quantità di dati testuali e su sofisticati meccanismi di previsione delle parole, ma il loro modo di “comprendere” il linguaggio è essenzialmente statistico. Non hanno un modello interno del mondo, non possiedono una rappresentazione concettuale del significato, e quindi faticano a gestire la polisemia, il contesto culturale e le sfumature del linguaggio naturale.

Un esempio classico di questa lacuna si manifesta quando un LLM deve interpretare una parola con un significato meno frequente. Se il termine ha un’accettazione comune e una più rara, il modello tenderà a proporre l’uso più diffuso, anche se il contesto suggerisce chiaramente il contrario. Questa rigidità mostra i limiti della comprensione semantica basata esclusivamente sulla co-occorrenza delle parole nei testi.

Immaginiamo di chiedere a un LLM il significato della parola “banco”. Può rispondere che si tratta di un “mobile con un piano orizzontale” oppure di un “istituto di credito”. Ma se il termine è usato nel senso di “banco di pesci” o “banco di prova”, il modello potrebbe facilmente cadere in errore. Questo perché gli LLM non ragionano davvero sul linguaggio: assemblano frasi basandosi su probabilità, non su una reale comprensione.

Questa debolezza solleva una questione cruciale: possiamo davvero fidarci di modelli che non comprendono il linguaggio come un essere umano? Per ora, la risposta è no. Ed è per questo che la ricerca sulla semantica, sia a livello lessicale che di frase, diventa fondamentale.

L’obiettivo è rendere questi modelli più interpretabili ed esplicabili, perché altrimenti rischiamo di costruire sistemi potenti ma opachi, che producono testo senza comprenderlo davvero. Un LLM che genera una risposta errata, ma che la esprime con sicurezza e autorevolezza, è un problema serio. Significa che gli utenti possono essere facilmente ingannati dalla fluidità del testo, scambiando un errore con un’informazione corretta.

Per evitare questi problemi, la ricerca si sta concentrando su diversi approcci:

- Migliorare la rappresentazione semantica : integrare nei modelli di linguaggio una comprensione più profonda delle relazioni tra concetti, superando la semplice co-occorrenza delle parole.

- Rendere gli LLM più spiegabili : sviluppare metodi che permettono di capire perché un modello ha prodotto una certa risposta, rendendo il processo decisionale più trasparente.

- Integrare conoscenza strutturata : combinare le capacità degli LLM con basi di conoscenza strutturate (come knowledge graphs) per dare ai modelli una comprensione più robusta del mondo.

Il futuro della ricerca sembra dunque orientato verso una nuova generazione di modelli che non si limitano a imitare il linguaggio umano, ma che ne colgano realmente il significato. Non sarà un percorso semplice: il lavoro da fare è immenso, ei pezzi del puzzle non sono ancora tutti sul tavolo. Ma l’entusiasmo della comunità scientifica suggerisce che siamo sulla strada giusta. È un momento simile a quello che vive un artista quando sta dando vita a una nuova creazione: l’adrenalina di vedere di grande prendere forma.

Per chi è all’inizio della carriera in questo settore, il consiglio del Prif. Roberto Navigli è chiaro: seguire la passione. Solo chi ama davvero ciò che fa riesce a sopportare le sfide di un percorso complesso e competitivo come quello della ricerca in AI.

Fare ricerca non è un percorso lineare. Ci sono fallimenti, momenti di stallo, giornate passate a fissare il codice che non funziona o risultati che non tornano. Chi lo fa solo per soldi o per prestigio rischiando di perdersi per strada. Ma chi è guidato da una vera passione riesce a trovare una soddisfazione profonda, indipendentemente dai risultati immediati.

Dedicarsi a qualcosa con entusiasmo, con l’energia di chi lo farebbe anche senza essere pagato, è ciò che porta al vero successo. E, con il tempo, anche alle soddisfazioni economiche. I migliori ricercatori sono quelli che, più che pensare alla prossima pubblicazione, sono spinti dalla curiosità e dal desiderio di risolvere problemi complessi.

Fuori dal laboratorio, anche i ricercatori hanno bisogno di staccare. E cosa c’è di meglio della lettura? Nel mondo iperconnesso di oggi, leggere un libro su carta è una forma di ribellione contro la dittatura dello schermo.

Un ricercatore che passa tutto il giorno immerso nei dati può trovare un sollievo nella lettura di un buon thriller o di una spy story, lasciandosi trasportare in un mondo avvincente e dimenticando, per qualche ora, le complessità della semantica e dell’intelligenza artificiale. Ma la lettura non è solo evasione: è anche un modo per affinare il pensiero critico, arricchire il linguaggio e sviluppare nuove connessioni tra idee.

C’è chi legge compulsivamente, accumulando libri in casa fino a raggiungere numeri impensabili: 10.000 volumi in un appartamento. A quel punto, la domanda diventa inevitabile: riuscirà mai a leggerli tutti? Forse no, ma non è questo il punto. La lettura non è una gara, è un viaggio. E come in ogni viaggio, l’importante non è la meta, ma ciò che si scopre lungo il percorso.