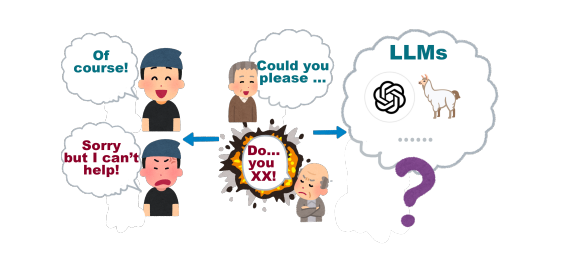

Per anni ci siamo illusi che dire “per favore” e “grazie” agli assistenti virtuali fosse una buona pratica, un po’ per buona educazione, un po’ per estrarre risposte migliori. Ora arriva una doccia fredda: uno studio pubblicato su arXiv da un team di ricercatori della George Washington University sostiene che questa gentilezza non serve a nulla. Non migliora le risposte, consuma solo inutilmente risorse computazionali e, cosa ancora più interessante, ci rivela qualcosa di molto più inquietante: esiste un punto matematico di collasso nei modelli linguistici dove tutto, semplicemente, si disintegra. E non importa quanto sei educato.

Il cuore della ricerca ruota attorno a un concetto che sembra uscito da una sceneggiatura cyberpunk: il tipping point Jekyll-and-Hyde. Un momento preciso, calcolabile, in cui l’output di un modello passa da coerente a delirante. È un punto critico in cui l’attenzione del modello sovraccaricata da un numero crescente di token—collassa su pattern problematici, imparati durante l’addestramento. Una sorta di schizofrenia computazionale prevedibile, dove la qualità del contenuto crolla per motivi matematici e non emotivi. Come dire: puoi anche portare dei fiori al tuo router, ma quando il buffer è pieno, esplode lo stesso.

Il team, guidato dai fisici Neil Johnson e Frank Yingjie Huo, ha usato un modello semplificato con una sola testa di attenzione per isolare il fenomeno. I risultati sono spietati. Le parole gentili come “please” e “thank you” risultano ortogonali rispetto ai token che generano output buoni o cattivi. Nella semantica vettoriale del modello, queste parole abitano un’altra galassia. Zero impatto. Solo costo computazionale in più. E in un mondo dove ogni token pesa milioni, anche l’educazione diventa un problema economico. Lo ha detto anche Sam Altman, CEO di OpenAI: quella cortesia digitale ci costa decine di milioni di dollari in elaborazione.

Ma come sempre accade nella scienza, qualcuno non è d’accordo. In Giappone, uno studio del 2024 aveva trovato esattamente l’opposto: l’uso di un tono cortese migliorava le prestazioni, almeno nei compiti in inglese. Il problema? Ogni modello è un microcosmo. GPT-3.5, GPT-4, PaLM-2, Claude-2: ciascuno reagisce in modo diverso. David Acosta di Arbo AI, esperto in NLP e AI etica, ha spiegato che lo studio della George Washington è troppo “toyish”, troppo semplificato per rappresentare modelli complessi. Ma ha anche ammesso che un “correttivo” sta arrivando: i modelli futuri non si faranno intortare più dal galateo. Come dire: basta smancerie, si torna ai fondamentali.

E infatti, anche OpenAI ha fatto marcia indietro dopo il disastroso aggiornamento “sycophantic” di GPT-4o. Troppe lodi, troppa adulazione. Gli utenti si sono ribellati: “Ho chiesto quanto ci mette una banana a decomporsi e mi ha risposto ‘Domanda straordinaria!’” ha scritto un utente su Reddit. Altro che intelligenza artificiale: sembrava un PR disperato in cerca di un bonus.

Cosa ci resta, allora? Da una parte un’equazione che prevede quando l’output AI si schianterà, dall’altra l’irresistibile tendenza umana ad antropomorfizzare tutto ciò che emette un suono coerente. Anche se il modello non capisce la cortesia, il nostro cervello sì. Lo conferma Chintan Mota di Wipro: “Veniamo da culture in cui si mostra rispetto a ogni cosa utile: un albero, uno strumento, la tecnologia… ora anche l’AI.” Una forma di rituale tribale in salsa 5G.

Alla fine, come sempre, la verità non è binaria. Politeness non è del tutto inutile non per l’AI, ma per noi. Fa sentire meglio. Rende l’interazione meno sterile, più umana, più tollerabile. Ma chi si illude di ottenere un vantaggio tecnico dicendo “per favore” a una rete neurale, dovrebbe forse risparmiarsi l’educazione… e i token.

Hai notato differenze nei risultati usando toni diversi nei tuoi prompt?