Nel magma indistinto delle tecniche di apprendimento automatico, dove ogni nuovo paper sembra proporre l’ennesima variazione sul tema delle loss function, ecco che spunta un white paper che, anziché aggiungere un altro gradino, smonta la scala e ne costruisce una nuova. Si chiama I-Con Information Contrastive Learning ed è un framework pubblicato all’ICLR 2025 da un dream team accademico-industriale (MIT, Google, Microsoft), che promette di fare ordine là dove c’era frammentazione.

Una singola equazione, dicono, per dominarli tutti: supervised, self-supervised, contrastive, clustering, dimensionality reduction. In sostanza, un modello informazionale che fonde metodi apparentemente scollegati tipo SimCLR, t-SNE, K-Means, CLIP, SupCon, PCA sotto un’unica perdita basata sulla divergenza di Kullback-Leibler fra distribuzioni condizionali. Lo chiamano con non poca arroganza “una generalizzazione di 23 loss function”, e hanno pure la tavola periodica dell’apprendimento rappresentazionale per dimostrarlo.

Ma facciamo un passo indietro, o meglio, due.

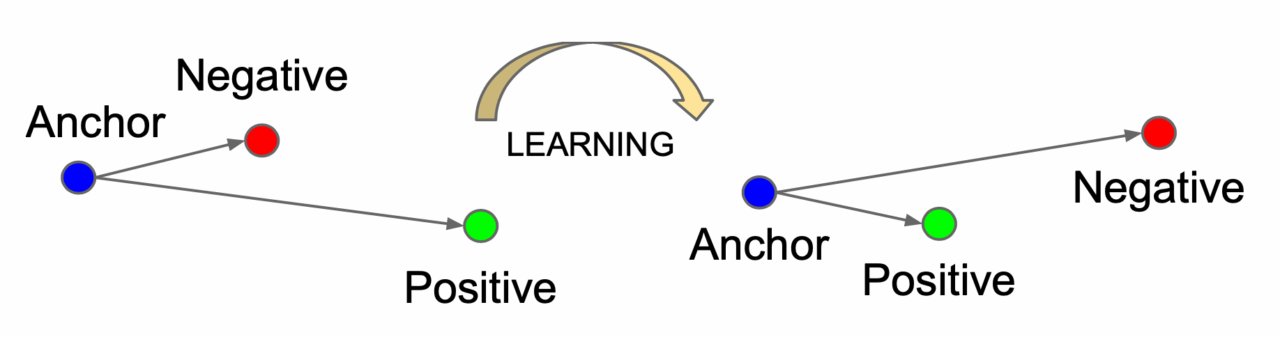

Il cuore di I-Con è la minimizzazione della KL-divergence tra due distribuzioni: una “supervisory” (p), e una appresa (q). A seconda di come definisci queste distribuzioni, ottieni una loss che recupera una tra le decine di tecniche in uso. Ad esempio, se p è una gaussiana centrata sull’immagine originale e q una gaussiana centrata sull’embedding appreso, ottieni SNE (Stochastic Neighbor Embedding). Se invece p è un delta di Kronecker che unisce augmentazioni della stessa immagine e q è basata su cosine similarity, ecco SimCLR. Se poi q rappresenta distribuzioni di cluster e p è un mix uniforme, hai sostanzialmente K-Means.

Geniale? Forse. Ma sicuramente pragmatico. Questo approccio consente di costruire nuovi learner componendo moduli esistenti — una specie di Lego teorico. Il risultato? Un classificatore non supervisionato che migliora l’accuracy su ImageNet-1K di oltre l’8% rispetto al precedente stato dell’arte (TEMI), e con meno tuning. Senza parlare dei boost su CIFAR-100 (+3%) e STL-10 (+2%). Semplice debiasing tramite uniform mixing e propagation dei vicini su grafo, con un tocco di raffinata matematica: si passa da distribuzioni rigide (hard labels) a supervisioni probabilistiche ammorbidite, in perfetto stile label smoothing. Ma qui il tutto è giustificato come ottimizzazione geometrica informativa, non come tweak empirico.

Ora, tutto questo potrebbe sembrare l’ennesima supercazzola teorica, se non fosse che funziona anche nella pratica. Il paper propone esperimenti esaustivi su vari modelli Vision Transformer pre-addestrati (DiNO-ViT S/B/L), senza dover aggiungere loss ad hoc o regolarizzatori da calibrare a mano. Un modello teoricamente solido, self-balancing, e soprattutto modulare.

Il valore reale? La portabilità. Se un trucco funziona nel contrastive learning, lo puoi tradurre nel clustering. Se scopri una loss robusta per il dimensionality reduction, la puoi applicare alla classificazione supervisionata. È questa la chiave: il trasferimento di idee tra domini prima isolati. Unificazione teorica e ricombinabilità tecnica.

Tutto questo ti sembra troppo bello per essere vero? Forse lo è. Ma se hai mai fatto fatica a spiegare perché certe loss sembrano funzionare “per magia”, I-Con ti offre finalmente un motivo, anche se il prezzo da pagare è un tuffo nella geometria informazionale. In cambio, però, ottieni una struttura concettuale che collega 20 anni di ricerca — e una pipeline nuova di zecca per fare clustering su ImageNet che umilia i competitor senza trucchi.

Se sei un tecnico, un teorico o semplicemente un pragmatico stanco di loss Frankenstein, I-Con merita uno sguardo serio. Grazie a Piero Savastano per la sua segnalazione.