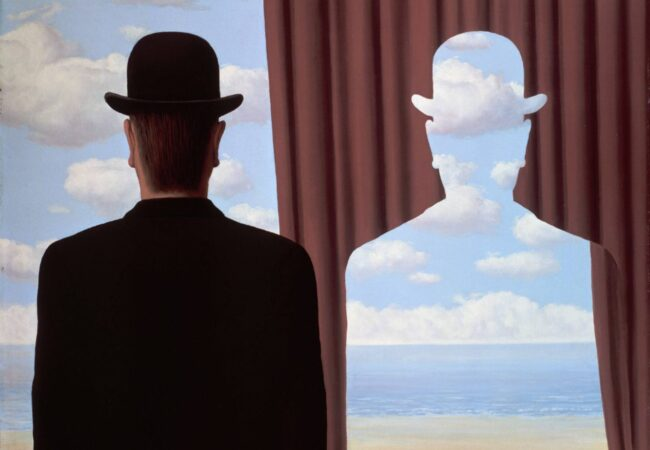

Siamo alla soglia dell’era dei sistemi autonomi, dove gli agenti AI – quelli veri, capaci di pianificare, ragionare, usare strumenti e collaborare – dovrebbero comportarsi come stormi di droni intelligenti, organizzati, sinergici, operativi. E invece? Parlano ognuno la propria lingua. Come se tu collegassi cento dispositivi a una rete e scoprissi che uno parla Swahili, l’altro Klingon, un altro ancora codice Morse. Benvenuti nell’inferno silenzioso dell’interoperabilità mancata.

Un gruppo di ricercatori della Shanghai Jiao Tong University ha appena pubblicato la più completa analisi dei protocolli per agenti AI mai fatta. Non un paper tecnico per nerd da conferenza, ma una mappa chirurgica dell’infrastruttura mancante. Quella che potrebbe sbloccare (o affondare) il sogno dell’Internet degli Agenti.

Il nocciolo? I protocolli. La keyword principale è protocolli agenti AI. Quelle secondarie, come interoperabilità tra agenti e sistemi multi-agente, sono solo i satelliti della crisi.

Per ora è il Far West. Ognuno si costruisce i propri wrapper, i propri formati, i propri incantesimi. Un déjà vu per chi ricorda i giorni gloriosi in cui ogni modem parlava a modo suo e il TCP/IP sembrava un’utopia. Ora il problema si ripresenta, ma con un twist più sofisticato e potenzialmente disastroso: gli agenti devono collaborare, ma non c’è un modo condiviso per farlo.

Il team cinese non si è limitato a fare la radiografia. Ha proposto una tassonomia dei protocolli, ha confrontato oltre 13 framework – nomi come MCP, A2A, ANP, Agora – e ha tracciato una linea netta tra ciò che funziona e ciò che è solo hype.

Un dettaglio interessante: MCP, Model Context Protocol di Anthropic, oggi domina la scena sul fronte dell’uso degli strumenti. È il protocollo che meglio affronta l’accesso contestuale alle risorse, risolvendo anche problemi cruciali di privacy. Praticamente il “OAuth per l’AI”, se vogliamo buttarla lì da bar.

Dall’altro lato del ring ci sono A2A di Google (robusto, asincrono, enterprise) e ANP, open source, con l’ambizione quasi utopica di costruire un’Agent Internet decentralizzata. Sì, suona bene. Finché non ti ricordi che decentralizzato è anche il modo con cui tua nonna conserva le password: un biglietto sotto al vaso delle viole.

Il problema vero, però, non è solo la diversità dei protocolli. È che non sappiamo nemmeno come valutarli. Fino a ieri, le metriche erano: “Quanto è veloce?”, “Quanto è preciso?”. Oggi la sfida è più sporca e più seria: sicurezza, adattabilità, estensibilità, trasparenza operativa. L’equivalente di chiedere non solo se un’auto corre, ma se sa frenare, cambiare corsia da sola, capire i segnali stradali in India e ricaricarsi mentre dorme.

Ma il punto più interessante – e più ignorato da chi sviluppa in loop GPT wrapper su GitHub è che l’architettura conta. Un protocollo pensato per uno use case (tipo chatbot da customer service) non scala in ambienti distribuiti con decine di agenti. Il contesto diventa codice. La topologia è semantica. E se non hai previsto queste dinamiche, ti ritrovi con un’orchestra di violini stonati che litigano per chi deve suonare per primo.

Ecco dove entra la vera provocazione: la progettazione del protocollo determinerà se l’AI sarà un sistema distribuito collaborativo o solo un parco giochi pieno di giocattoli intelligenti che non si parlano.

Il parallelismo con gli albori di Internet è perfetto. Allora serviva TCP/IP. Oggi serve qualcosa di simile, ma per agenti. Qualcosa che non solo trasmetta pacchetti, ma intenti, stati mentali computazionali, catene di ragionamento e fallback predittivi. Non uno “standard”, ma una grammatica operativa per il pensiero artificiale distribuito.

Certo, ci sono ostacoli ovvi. Il primo: gli interessi aziendali. Google, Meta, OpenAI, Anthropic – ognuno costruisce il proprio giardino recintato. Il secondo: la complessità. Per creare un protocollo universale bisogna decidere cosa è “minimo” ma sufficiente in un linguaggio tra entità cognitive. Spoiler: non è JSON.

Poi c’è il terzo, quello più cinico: chi lo implementa davvero?. Come disse un vecchio CTO a una riunione ISO: “Gli standard sono fantastici, ce ne sono così tanti che puoi scegliere il tuo preferito”. E oggi ogni startup vuole essere lo “standard de facto” prima di pensare al bene comune.

Eppure, in mezzo a questo caos elegante, il paper della Jiao Tong lancia una provocazione seria: o troviamo un’infrastruttura condivisa, o l’AI su larga scala non scala affatto. Resteremo in un patchwork di bot semi-autonomi, tool invocati a fatica, orchestrazioni fragili come un cluster senza health check.

Il futuro? Sarà scritto nei protocolli, non nei modelli. Gli LLM continueranno a crescere, certo. Ma senza una lingua condivisa tra agenti, resteranno delle solitudini brillanti, incapaci di costruire un’intelligenza collettiva.

Una piccola curiosità per chi ama i paradossi: in questo momento, gli agenti AI sono abbastanza smart da pianificare operazioni chirurgiche simulate, ma non abbastanza compatibili per chiedersi “che strumento stai usando tu?”.

Tanto per ricordarci che anche nel mondo post-umano, serve ancora qualcosa di umano: la capacità di mettersi d’accordo.