OpenAI ha appena alzato il livello della sfida, portando il mondo dell’intelligenza artificiale medica verso un nuovo orizzonte con il lancio di HealthBench, un benchmark open source progettato per testare le capacità degli LLM (modelli linguistici di grandi dimensioni) nel rispondere a domande mediche. Ma non stiamo parlando di un generico set di dati o di un sistema che si limita a rispondere in modo aleatorio: HealthBench si distingue per un approccio sofisticato e mirato, con criteri medici rigorosi e la capacità di analizzare risposte in ben 49 lingue diverse. Questo non è solo un passo in avanti nel campo dell’AI, è una vera e propria rivoluzione nella valutazione della competenza medica delle AI, che rischia di cambiare per sempre il modo in cui interagiamo con le tecnologie sanitarie.

Ma chi sta davvero vincendo in questa partita? Gli LLM? O siamo solo spettatori di un gioco dove l’umanità si trova a fare da semplice comparsa? La risposta, ovviamente, non è semplice.

La medicina attraverso gli occhi dell’intelligenza artificiale

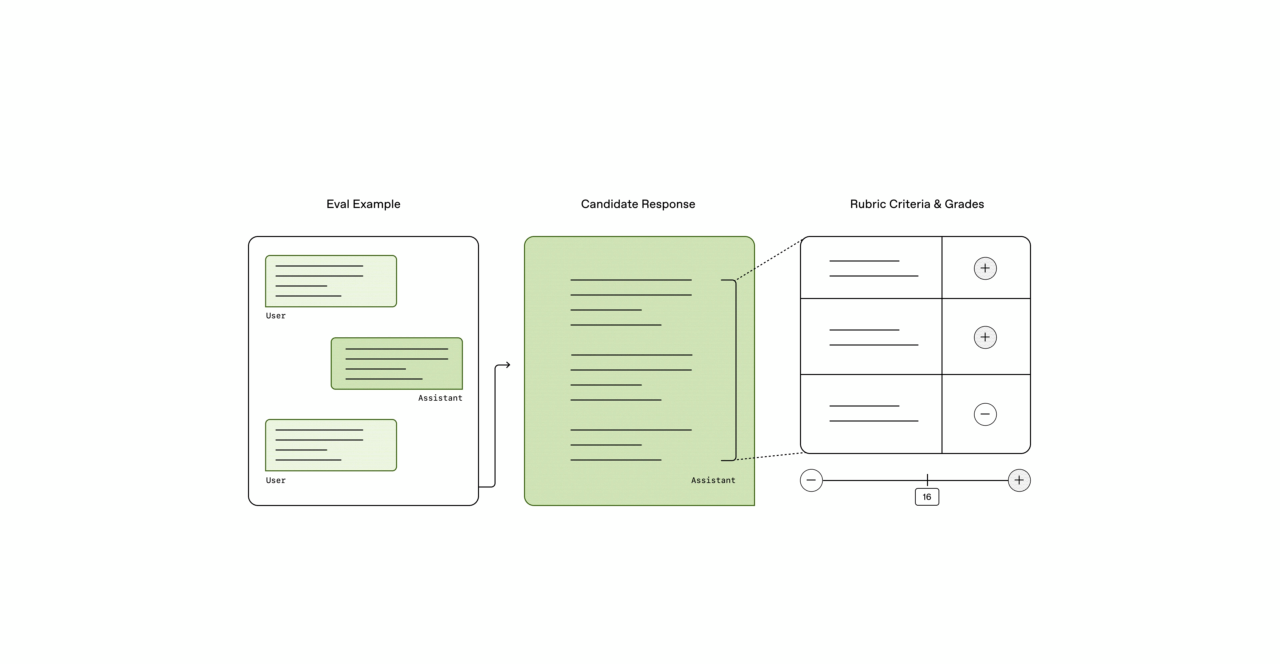

HealthBench non è solo un altro tentativo di “insegnare” a una macchina a rispondere correttamente a domande. Si tratta di una vera e propria valutazione della competenza medica che riesce a misurare la profondità, la precisione e l’affidabilità delle risposte degli LLM a quesiti strutturati secondo standard medici internazionali. Il benchmark si sviluppa su una serie di parametri che vanno dal trattamento di malattie comuni alla diagnosi di patologie complesse, fino alla gestione della salute mentale. Gli sviluppatori di OpenAI hanno fatto un lavoro meticoloso nel creare una base di dati che non solo richiede risposte tecnicamente corrette, ma anche comprensibili a livello umano e culturalmente adattabili. Per capirci, non basta che il modello risponda con precisione, deve farlo in modo che possa essere compreso dal pubblico globale. Ecco il colpo di genio: questa valutazione avviene in 49 lingue. Quasi come voler testare l’AI su scala globale, per vedere come reagisce alla diversità linguistica e culturale.

Non è un caso che OpenAI abbia deciso di adottare questo approccio. In un’epoca in cui le informazioni mediche viaggiano più velocemente di qualsiasi altra forma di comunicazione, avere una lingua comune per la medicina, accessibile a tutti, potrebbe rappresentare la chiave per abbattere barriere culturali e migliorare l’accesso alle cure. E qui sta la vera sfida: può un LLM affrontare una materia complessa come la medicina mantenendo una qualità costante su tutte le lingue? La risposta potrebbe sorprendervi.

Un benchmark pensato per evolversi

Ma cos’è davvero HealthBench se non una palestra per modelli di AI, uno spazio dove misurarsi contro sfide concrete? Non si tratta solo di un esercizio di stile, ma di un banco di prova per definire le reali capacità degli LLM. Se, da un lato, la creazione di un benchmark open source è un passo importante per democratizzare l’accesso alla valutazione delle AI, dall’altro pone interrogativi cruciali sul futuro dell’AI nella medicina.

Immagina di affidarti a un modello AI per una diagnosi. La macchina risponde con grande sicurezza, ma cosa succede se l’algoritmo si sbaglia? Magari il medico, essendo umano, non può limitarsi a dire “È colpa dell’AI”. La questione riguarda la fiducia nelle macchine: come facciamo a essere certi che un modello sia veramente competente in un campo così delicato? HealthBench si pone come un tentativo di rispondere a questa domanda, cercando di separare le risposte corrette da quelle fallaci. Eppure, anche qui il rischio è alto. Come un chirurgo che fa un’incisione sulla pelle senza sapere fino a che punto la cicatrice si allargherà, gli sviluppatori di AI sono sempre in bilico tra l’ottimismo e la paura delle conseguenze impreviste. È facile promettere che la medicina sarà trasformata dalle AI, ma che dire del contesto etico, delle implicazioni sociali, dei possibili abusi? HealthBench ci aiuta a navigare questi mari pericolosi, ma non ci offre soluzioni facili.

La lingua è davvero una barriera?

Un aspetto che colpisce in modo particolare di HealthBench è l’inclusione di 49 lingue diverse, un numero che non è mai stato visto in un benchmark di questo tipo. L’idea di valutare la competenza medica di un LLM in lingue come il cinese, l’arabo o l’hindi non è una mossa casuale, ma una strategia mirata a rispondere a una delle sfide più grandi nell’ambito della salute globale: l’accesso diseguale alle risorse sanitarie. Nel mondo globalizzato di oggi, la lingua non è solo una questione di traduzione. Ogni lingua porta con sé specificità culturali che possono influenzare come una risposta venga percepita e applicata. Un modello che risponde in modo preciso in inglese potrebbe non essere altrettanto utile se tradotto senza considerare questi aspetti. In fin dei conti, la medicina è tanto una scienza quanto una pratica sociale e culturale.

Tuttavia, non possiamo ignorare un fatto semplice: la qualità delle risposte in lingue diverse dipenderà sempre dalla qualità del training data. C’è sempre il rischio che, nelle lingue meno rappresentate, gli LLM possano incorrere in errori dovuti alla mancanza di dati o a pregiudizi impliciti. HealthBench, purtroppo, non è esente da questi limiti. La sua reale utilità verrà solo con il tempo, quando le lingue più esotiche avranno ricevuto la stessa attenzione dei grandi pilastri linguistic i come l’inglese o il cinese.

L’AI nella medicina: una fiducia che si guadagna

In un mondo in cui le intelligenze artificiali sembrano ogni giorno più pervasive, il campo della medicina rimane una delle sfide più ardue. Non stiamo parlando di scegliere un ristorante o di scrivere un testo, ma di operare in un ambito dove le vite sono in gioco. Non basta che un modello risponda correttamente, deve farlo con la stessa competenza, affidabilità e sicurezza di un medico esperto. HealthBench rappresenta un passo significativo in questa direzione, ma la strada per una medicina totalmente AI-driven è ancora lunga e piena di insidie.

Diciamocelo: il futuro della medicina non sarà tanto una questione di “cosa sa fare l’AI”, ma di “quanto possiamo fidarci di essa”. Per ora, HealthBench ci dà gli strumenti per misurare questa fiducia. Quanto basta per un assaggio. Ma non fatevi illusioni: la vera prova arriverà quando gli algoritmi dovranno affrontare le situazioni più complesse e le diagnosi più delicate. E forse, quando ciò accadrà, sarà già troppo tardi per tornare indietro.