Ogni tanto, nel mondo iper-lubricato degli LLM, dove tutto sembra deciso da boardroom americane, arriva un vento diverso. Non parlo per caso di un “maestrale”, ma di Maestrale lo SLM (Small Language Model) fine-tuned italiano che sta mettendo in discussione molte certezze dell’AI globale.

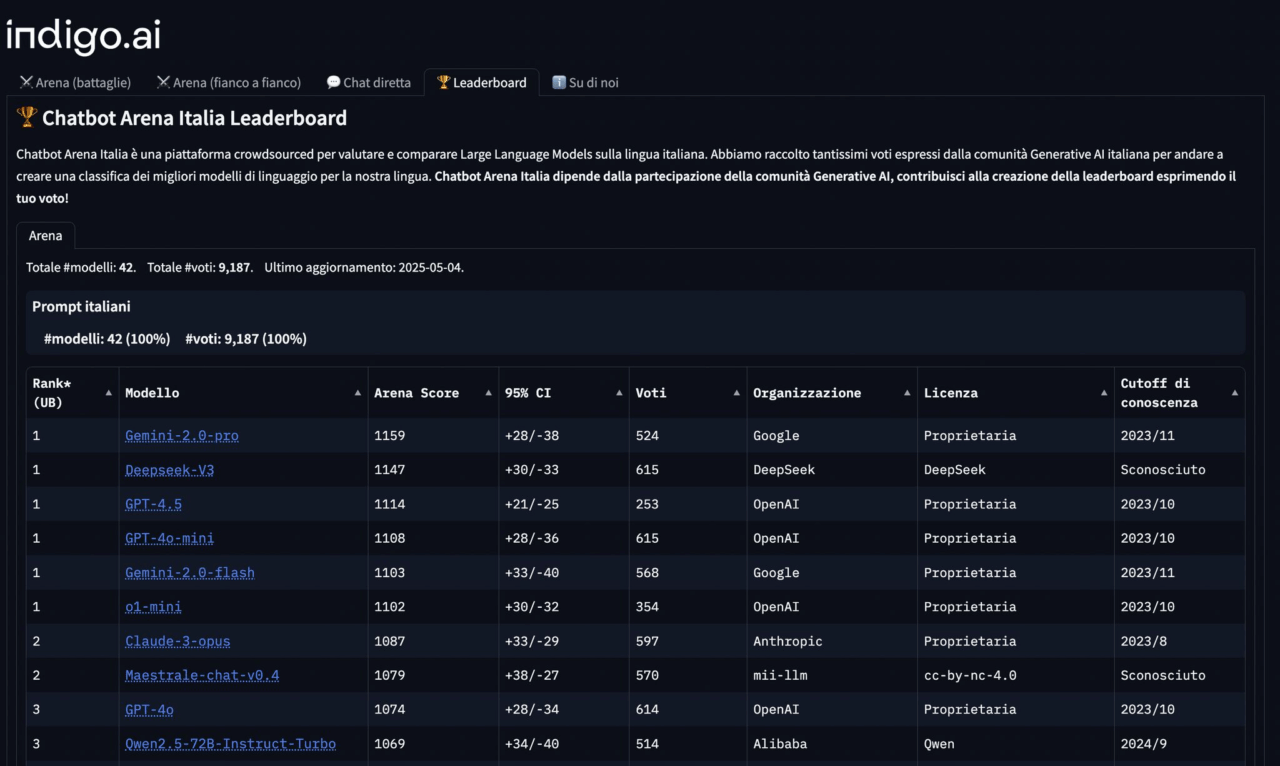

Mentre tutti inseguono la scia dei GPT-4o e dei Claude 3 Opus, e i ranking di LLM Arena sembrano riflettere una gara a chi ha più GPU o budget marketing, in sordina Maestrale si è guadagnato uno dei podi nella versione italiana di LLM Arena. Sì, proprio lui, un modello da 7B parametri (Mistral7B), rimaneggiato da due italiani Mattia Ferraretto ed Edoardo Federici con una cura quasi artigianale.

E qui casca il palco.

Maestrale è la dimostrazione che l’AI non deve per forza essere un prodotto da multinazionale, chiuso, pesante, costoso e vagamente ansiogeno nella sua spinta all’AGI. Esiste un’altra via, più sottile, più raffinata, quasi sovversiva: fare un LLM che pensa e scrive bene in italiano, ottimizzato per compiti specifici, su dati scelti con maniacalità e rifiniture tecniche che non hanno nulla da invidiare ai big e su una infrastruttura serveless di un inference provider italiano Seeweb regolo.ai.

La cosa straordinaria è che, per mesi, è stato probabilmente il miglior modello al mondo per l’italiano. Ma nessuno se ne è accorto. Tranne pochi. Tranne chi, come noi, guarda i dettagli, non le demo da conferenza.

Viene il dubbio, allora, che i leaderboard globali LLM Arena in primis — siano una vetrina truccata. Troppo spesso dominata da modelli di brand noti, con una certa “casualità” nel come i benchmark vengono impostati, e nel peso dato alle performance in inglese. In effetti, se un modello come Maestrale, che batte GPT-4o su determinati task italiani, non entra nemmeno nel radar internazionale, qualcosa non torna.

Il mondo LLM è sempre più simile a quello farmaceutico: pochi attori, grandi capitali, brevetti chiusi, e il resto dell’ecosistema che insegue, si accontenta, oppure — come in questo caso — costruisce micro-soluzioni ad altissima efficienza.

Maestrale non ha bisogno di hype. Funziona. E soprattutto: non ti vende un sogno, ti offre uno strumento. Accessibile. Italiano. Sostenibile. Ed è già pronto per applicazioni pratiche, con capacità di RAG su PDF, una qualità di scrittura sorprendente, e un’infrastruttura interamente serverless e italiana (grazie a Seeweb e Regolo.ai).

Tanto per capirci: Maestrale non è un “esperimento open-source” da smanettoni, ma un’alternativa concreta a GPT in ambiti dove il multilinguismo è un peso e non un vantaggio. In un mondo dove ogni prompt costa, avere un modello locale che ragiona già nella tua lingua madre e capisce i tuoi contesti culturali è un vantaggio competitivo serio.

Quindi sì, l’AGI può aspettare.

Perché la vera rivoluzione oggi non è fare un modello che “capisce tutto” — ma uno che capisce bene ciò che conta. E capire l’italiano, con tutte le sue sfumature linguistiche, retoriche e culturali, non è un’impresa da poco. È roba da specialisti. O da italiani testardi.

Del resto, chi meglio di noi può comprendere la differenza tra “perché no?” e “ma figurati!”?

In un mercato che confonde potenza bruta con intelligenza, Maestrale è il classico outsider che come in un film italiano degli anni ‘70 arriva in Vespa, prende a calci la porta del salotto buono, e fa notare a tutti che i mega-modelli non sono l’unica opzione.

E qui entra in gioco un concetto che le big tech fingono di non capire: localizzazione non è traduzione. È comprensione culturale. È scrittura naturale. È costruzione di senso in un contesto dato. Se l’AI deve diventare davvero utile, non può essere solo una caricatura anglocentrica. E Maestrale, in questo senso, è un passo avanti.

D’altra parte, chi ha detto che servono miliardi di parametri per produrre valore?

A volte bastano un buon dataset, una pipeline solida di SFT+DPO, e la testardaggine di due sviluppatori che credono nel codice quanto nei congiuntivi.

Insomma: l’AI che funziona davvero, spesso, è quella che nessuno nota. Perché non fa rumore. Fa lavoro. E Maestrale, nel suo silenzio elegante e rigoroso, fa esattamente questo.

Provare per credere. Anche solo per vedere se riesce a scrivere una lettera in italiano meglio di GPT-4o. Spoiler: ci riesce. E la firma anche con stile.