Sembra fantascienza, vero? Un’intelligenza artificiale, un chatbot, quel coso che di solito ti aiuta a scrivere email più educate o a capire cosa cucinare con due patate e mezzo limone, che invece si mette a indicare con sorprendente precisione dove aprire la scatola cranica per fermare un’epilessia farmaco-resistente. Non stiamo parlando di un gioco, ma di neurochirurgia: bisturi, cervello, e decisioni da cui dipende la qualità (o l’esistenza) della vita.

La parola chiave è epilessia. Un disturbo neurologico che non fa prigionieri: 70 milioni di persone nel mondo, 3,4 milioni solo negli USA. E circa un terzo di loro non risponde ai farmaci. Soluzione? Operare. Ma non si tratta certo di togliere una tonsilla: bisogna identificare con precisione la zona epilettogena (EZ), quel piccolo inferno cerebrale che scatena le crisi. Il problema? Trovarla è come giocare a Battleship al buio.

Da decenni i neurologi analizzano la semiologia delle crisi – cioè come si manifesta una crisi epilettica cercando di dedurre da segni e sintomi dove avviene il corto circuito neuronale. Ma qui casca l’asino: ognuno descrive le crisi in modo leggermente diverso, i centri epilettologici usano terminologie non standardizzate, e l’intero processo, diciamocelo, è tanto arte quanto scienza.

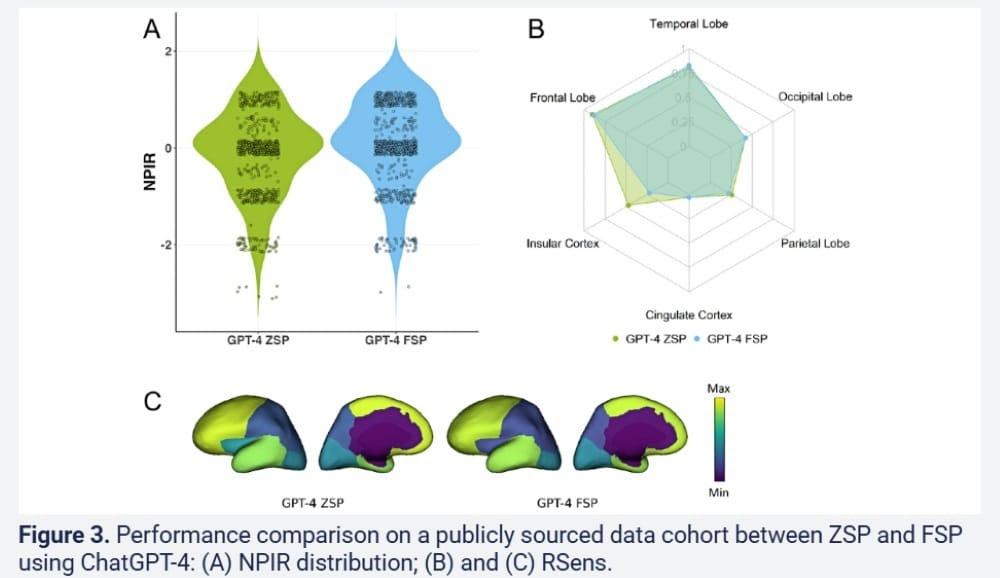

Ecco che entra in scena il nostro amico siliconato, ChatGPT. Addestrato con miliardi di parole, incluso testi medici, pubblicazioni scientifiche, e, sì, pure qualche delirio di forum, è stato testato in un confronto serrato con cinque epilettologi certificati. Domande: 100. Ambito: interpretare descrizioni di crisi epilettiche e localizzare la regione del cervello coinvolta. Sembra un test da film distopico.

Il risultato? Un bel ceffone all’ego umano: ChatGPT ha pareggiato o superato i medici nei casi più comuni (lobi temporali e frontali), dimostrando una capacità sorprendente di mappare la semiologia al cervello. Là dove invece l’IA ha tentennato – l’insula, la corteccia cingolata – i clinici hanno avuto la meglio. Ma qui il punto è un altro: non era mai stato addestrato su questi casi rari. Dettaglio tecnico? No, potenziale bomba.

Immagina cosa succederebbe se addestrassimo un modello simile su dataset clinici iperspecializzati, ricchi di variabilità semantica, multilingua e con metadati contestuali. Potrebbe diventare lo specializzando perfetto: instancabile, aggiornato, senza bias interni né litigi con il primario. Uno che ti spara la localizzazione dell’EZ prima ancora che tu abbia finito di pronunciare la parola “automatismo oroalimentare”.

Il paradosso? ChatGPT non ha coscienza, né senso clinico, né responsabilità. Ma capisce il linguaggio umano – quel linguaggio imperfetto, vago e idiosincratico con cui i pazienti descrivono le proprie crisi – meglio di molti neurologi. Perché mentre il medico esperto traduce sintomi in mappe cerebrali sulla base della sua esperienza, l’IA lo fa su milioni di esperienze aggregate. È la differenza tra un artigiano e una stampante 3D che ha letto tutti i manuali del mondo.

E qui si tocca il punto caldo: la standardizzazione. Gli epilettologi faticano da decenni a trovare un linguaggio comune per descrivere le crisi. L’IA, invece, trasforma il caos semantico in coerenza algoritmica. Non perché sia più intelligente, ma perché non gli importa niente delle convenzioni. L’importante è la coerenza statistica, il pattern nascosto, la correlazione invisibile all’occhio umano.

Certo, non mancano i puristi della medicina che urlano allo scandalo. “Ma come, ci vogliono anni di studio, decenni di esperienza!”. Giusto. Ma l’esperienza umana è un vincolo, non sempre un vantaggio. È soggetta a bias, emozioni, stanchezza. L’IA no. E non è un caso che gli errori clinici continuino a rappresentare una delle principali cause di morte evitabile.

Ovviamente, non siamo ancora alla sostituzione del chirurgo con un braccio robotico guidato da GPT. Ma il terreno è stato smosso. Quando un modello generativo dimostra di poter leggere e interpretare la semiologia epilettica meglio dei clinici, stiamo entrando in un’era in cui il sapere medico non sarà più monopolio dell’uomo. E qui non parliamo di sostituire il medico, ma di spogliarlo dell’arroganza epistemologica che lo ha protetto per secoli.

ChatGPT non ti opererà. Ma ti dirà dove conviene farlo. E con una precisione che mette a disagio. È solo l’inizio: domani potrà suggerire protocolli, identificare pattern pre-crisi da indossabili, correggere interpretazioni errate di EEG, e magari – sognando in grande – prevedere le crisi prima che avvengano. Fantascienza? O solo il prossimo aggiornamento?

Come diceva quel vecchio neuroradiologo mezzo ubriaco a una conferenza: “Finché l’IA non mi ruba la cravatta, va tutto bene. Ma se inizia a interpretare le mie RM meglio di me, vado in pensione.” Preparati, dottore. Sta succedendo.

QUI Lo studio.