La Silicon Valley non sogna più di essere soltanto vista: vuole guardare dentro di noi. Meta, con l’annuncio dei suoi occhiali sperimentali Aria Gen 2, ha dato un’altra spinta all’inevitabile convergenza tra intelligenza artificiale, robotica e realtà aumentata. Ma attenzione, questi non sono occhiali per camminare per strada a caccia di Pokémon virtuali. Sono occhiali per chi, domani, vorrà essere letto più che leggere.

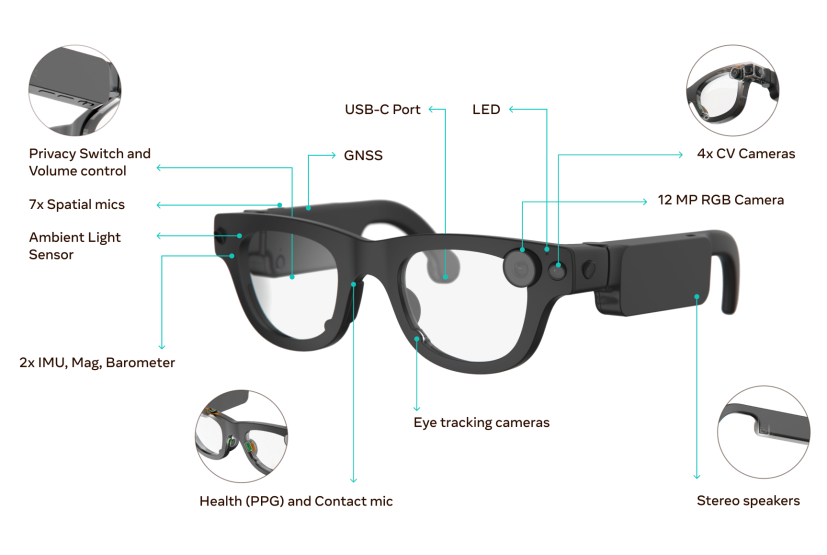

Siamo ben oltre il selfie con i Ray-Ban Stories. Aria Gen 2 è un laboratorio da indossare, un prototipo mascherato da accessorio, con un hardware che non scherza affatto. Meta parla con orgoglio del nuovo sistema di eye-tracking: riesce a monitorare ogni singolo occhio, distinguere i battiti di ciglia, stimare la posizione esatta delle pupille. Una macchina che segue lo sguardo, ma anche quello che potenzialmente stai per fare. Una sorta di pre-intenzione digitale, una lettura neuro-visiva anticipatoria.

Sembra uno scenario uscito da Minority Report, ma il tono con cui Meta lo racconta è quasi naif, da progetto accademico per “una comprensione più profonda dell’attenzione visiva e delle intenzioni umane”. Una frase che, detta nel 2025, suona un po’ come dire: “Stiamo cercando di leggere la tua mente, ma con gentilezza”.

E non è solo lo sguardo a essere decodificato. Dentro questi occhiali da 75 grammi c’è un sensore PPG (photoplethysmography, difficile da pronunciare anche per chi lo ha progettato) posizionato sul nasello. Misura il battito cardiaco. Perché? Per captare variazioni fisiologiche, magari legate a stress o attenzione. Poi c’è un microfono a contatto che migliora l’audio anche in ambienti rumorosi: la voce dell’utente diventa dati, pattern, segnali per l’IA. Si chiama “computing percettivo” e sta diventando la prossima frontiera del wearable.

Ma la vera ciliegina è la computer vision: quattro fotocamere che seguono oggetti, mani, movimenti nello spazio tridimensionale. Non solo per esperimenti di realtà aumentata, ma anche per addestrare robot alla manipolazione fine, quella che oggi solo un chirurgo o un artigiano esperto riesce a compiere. Gli occhiali come ponte tra l’intelligenza artificiale e quella biologica, come interfaccia neurale a basso costo.

La prima generazione di Aria era stata lanciata nel 2020, e come allora, anche questa seconda versione è riservata esclusivamente a ricercatori. Meta aprirà le candidature nei prossimi mesi, ma il messaggio è chiaro: questa non è ancora roba per il mercato consumer, ma è il laboratorio mobile con cui la Big Tech sta ridefinendo il concetto stesso di interfaccia utente. Lo sguardo, il cuore, la voce, il movimento: tutto diventa un’interazione implicita.

La domanda, allora, non è cosa fanno questi occhiali, ma cosa si aspettano di fare di te. Perché Aria Gen 2 è un pezzo di un puzzle più grande. Meta non ha mai smesso di inseguire il suo sogno di realtà aumentata integrata e pervasiva. I Ray-Ban con audio e assistente vocale sono solo il primo passo. All’orizzonte ci sono i progetti Orion, il presunto flirt con Oakley, e le Hypernova: occhiali con display integrato, computer da indossare, schermi perenni davanti agli occhi. Il tutto in un’epoca in cui la privacy è una parola sempre più retorica.

C’è una certa ironia nel fatto che Meta, l’azienda che ha reso popolare il “like”, ora voglia leggere il tuo battito cardiaco. E ancora di più nel fatto che questo avvenga in nome della “ricerca”. Una parola che funziona sempre, che nobilita ogni ambizione. Come dire: non stiamo vendendo occhiali intelligenti, stiamo esplorando la condizione umana… attraverso una montatura in plastica e alluminio.

Il design, almeno, sembra pratico. Braccia pieghevoli, otto taglie, peso contenuto. Ma è l’anima del progetto che conta. Aria Gen 2 non è un prodotto: è un manifesto. È la prova che il prossimo grande computer sarà indossabile, invisibile, percettivo. E molto probabilmente leggerà più segnali biometrici di quanto leggiamo noi notizie in un giorno.

Questa, in fondo, è la nuova battaglia per il dominio della piattaforma computazionale post-smartphone. Meta non è sola: Apple spinge con Vision Pro, Google flirta con nuovi progetti AR, Amazon lavora sulle gesture. Ma Meta ha un vantaggio strategico sottile: ha già conquistato l’attenzione di miliardi di persone. Ora vuole capire dove guardano, cosa sentono, quanto sono coinvolti. Un tipo di dati che nemmeno i cookie possono offrire.

E così, mentre leggiamo comunicati su “intenzioni visive” e “manipolazione robotica”, il vero oggetto della ricerca siamo noi. Perché se questi occhiali diventano davvero un giorno un prodotto consumer, saranno le tue pupille, il tuo battito e il tuo sguardo a nutrire l’IA.

Benvenuti nel metaverso non virtuale. Dove gli occhiali non ti fanno vedere la realtà aumentata. Ti fanno diventare il dato aumentato.