Il paradosso perfetto è servito. In un’epoca in cui le Big Tech si fanno guerre epiche a colpi di etica e algoritmi, a tradire la promessa di riservatezza non è un CEO distopico né una falla nella sicurezza: è un’ordinanza giudiziaria. OpenAI, la regina madre dei modelli generativi, è costretta per ordine del tribunale a violare una delle sue stesse policy fondanti: la cancellazione delle conversazioni su richiesta dell’utente. Cancellazione, si fa per dire.

Quello che accade dietro le quinte di ChatGPT oggi non è un incidente tecnico né una svista legale. È un ribaltamento formale della logica contrattuale tra utente e piattaforma, e rappresenta un passaggio simbolico nella guerra fredda tra intelligenza artificiale e diritto d’autore. Il tutto, ovviamente, con in mezzo il cadavere illustre della privacy digitale.

Brad Lightcap, COO di OpenAI, ha commentato la decisione con una diplomazia irritata che sa di resa obbligata: “Un’overreach”, un’esagerazione, un’ingerenza legale che, a suo dire, “abbandona le norme consolidate sulla privacy”. Ma non è solo una questione di privacy. È una questione di fiducia sistemica. Quando un utente clicca su “Elimina questa conversazione”, è come se firmasse un contratto implicito con un’intelligenza senz’anima. E oggi scopre che quel contratto è carta straccia se il tribunale dice che serve come prova.

Non è solo un tecnicismo giudiziario, è un precedente: un nuovo spazio dove la sorveglianza legale preventiva entra nel cuore pulsante delle interazioni umane con l’IA. Altro che GDPR, altro che opt-out: anche se sei un utente gratuito, Plus, Pro o Team, il tuo dialogo con ChatGPT adesso può essere archiviato “indefinitamente”, anche se chiedi che venga cancellato. Certo, ci rassicurano, “solo un piccolo team legale e di sicurezza, controllato e sottoposto ad audit”, potrà accedervi. Ma chi ha studiato privacy engineering sa che la frase “piccolo team legale” è la versione moderna di “fidati, siamo esperti”.

Questa è la realtà dissonante della transizione cognitiva in corso: da una parte si parla di AI spiegabile, modelli etici, bias mitigati. Dall’altra, si ordina di congelare log privati per un tempo indefinito, con la benedizione del tribunale e il silenzio assordante di chi avrebbe dovuto difendere la simmetria tra utente e macchina.

Il tutto nasce, ça va sans dire, dalla guerra di trincea tra The New York Times e OpenAI. L’accusa? Aver saccheggiato milioni di articoli per addestrare il modello linguistico più noto al mondo. Un’accusa comprensibile, se non fosse che nel processo si rischia di sacrificare più di quanto si voglia tutelare. Per dimostrare che GPT ha “assorbito” articoli del Times, servono prove. E le prove, apparentemente, sono anche dentro le conversazioni degli utenti.

Il problema, però, è che non siamo solo nella giurisdizione della proprietà intellettuale, siamo in quella molto più scivolosa della proprietà conversazionale. Le interazioni utente-IA sono uno spazio semi-privato, un diario momentaneo che fino a ieri spariva dopo 30 giorni, tracciato solo per il miglioramento del servizio o per garantire sicurezza. Ora diventano archivio giudiziario potenziale. E questa mutazione silenziosa rischia di alterare il patto fondamentale tra utente e intelligenza artificiale: il patto di confidenza.

ChatGPT Enterprise e ChatGPT Edu, per ora, restano fuori da questo perimetro, grazie a contratti di zero data retention. Il che rivela, se ce ne fosse bisogno, che la privacy come sempre è un privilegio per chi può permettersela, non un diritto universale.

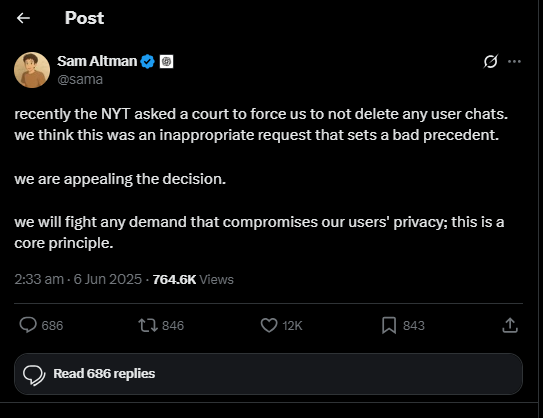

Sam Altman, dal canto suo, ha twittato in perfetto stile Silicon Valley: “Combatteremo qualsiasi richiesta che compromette la privacy degli utenti; è un principio fondamentale.” Nobile intento. Ma mentre lui combatte, intanto i dati restano dove sono. Archiviati. Disponibili. Forse esaminabili.

Chi è attento alla logica dell’SGE di Google, l’esperienza generativa che sta riscrivendo l’indicizzazione web, noterà che in questo scenario la parola “privacy” è diventata un meta-tag emotivo, un simulacro utile più al marketing che alla tutela concreta. L’utente cerca “cancellazione chat GPT”, ma trova una nuova semantica: “conservazione forzata in attesa giudizio”.

La macchina non dimentica. Ma lo fa solo quando un giudice glielo ordina.

E noi, nel frattempo, continuiamo a parlarci, a confidarle paure, idee, domande, progetti.

La domanda che resta sospesa — e che nessun modello può prevedere — è: quanto tempo ci vorrà perché una generazione intera smetta di fidarsi delle IA conversazionali? E quanto costerà, in reputazione e adozione, una sentenza nata per proteggere il giornalismo ma che rischia di sabotare la trasparenza?

Curiosità seminale: nel 1984, Apple lanciava il suo primo spot, diretto da Ridley Scott, contro il totalitarismo informatico. Oggi, quarant’anni dopo, scopriamo che l’unico “grande fratello” davvero temibile… è il tribunale federale.