Se un tempo erano assistenti passivi per la scrittura, oggi i modelli linguistici di larga scala giocano un ruolo inquietantemente attivo: propongono ipotesi di ricerca, delineano esperimenti, prevedono impatti, e lo fanno con una precisione che comincia a mettere in discussione l’egemonia creativa dell’intelligenza umana.

Benvenuti nell’era dell’AI Idea Bench 2025, dove gli idea generator vengono testati come startup tech: non basta essere brillanti, serve colpire il problema giusto, offrire qualcosa di fresco, e sembrare almeno costruibili con le tecnologie esistenti.

Non è un talent show per LLM, è molto peggio: è una due diligence scientifica fatta con lo stesso cinismo con cui un VC calcola le probabilità che una startup fallisca prima del Series B.

Il benchmark è spietato.

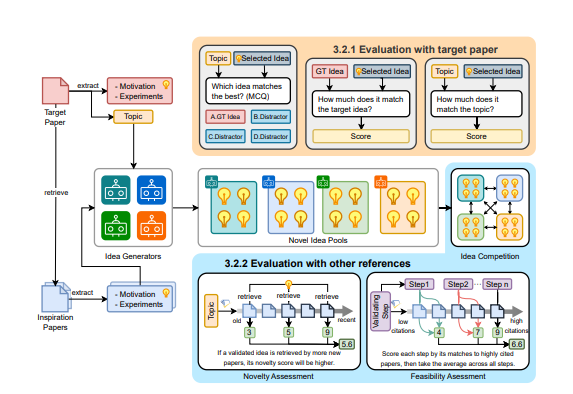

3.495 paper inediti da conferenze top nel campo dell’intelligenza artificiale sono stati usati come verità di riferimento, tutti pubblicati dopo il cutoff di ottobre 2023 di GPT-4o. Nessun “leak di training set”, nessun plagio possibile. In questo scenario purificato dal sospetto, quattro modelli di AI sono stati messi alla prova come veri e propri ricercatori.

Il test si sviluppa in due fasi, come un buon filtro antirumore:

prima si valuta l’allineamento con un vero paper apparso dopo, quindi si misura la novità e la fattibilità, usando una metrica ponderata sulle citazioni accademiche.

Perché, sì, anche il cervello collettivo della ricerca ha un suo Nasdaq implicito: gli articoli che citano altri articoli sono le transazioni che contano.

E qui succede qualcosa di strano.

Il modello AI-Scientist ottiene un punteggio perfetto sull’allineamento: 5.0 su 5.0 sia nella motivazione della ricerca che nel design sperimentale. Tradotto: ha capito dove puntare, e come farlo sembrare plausibile. Ma il migliore sulla fattibilità, per ogni passo dell’idea proposta, è AI-Researcher, con un’efficienza misurata in un inquietante 17 × 10⁻³ – un numero che a prima vista sembra provenire da un acceleratore di particelle.

Il punto non è solo chi genera le idee migliori. È che diversi modelli hanno personalità diverse. C’è chi lancia provocazioni (AI-Scientist), chi stila piani esecutivi (AI-Researcher), chi sembra un product manager con una laurea in machine learning.

L’illusione di avere un singolo “miglior modello” cade a pezzi.

Come in un buon team operativo, serve il visionario e serve il realista. E, sorprendentemente, i modelli cominciano ad assomigliare agli archetipi delle startup: quello che ti convince al pitch, quello che sa davvero dove mettere le mani nel codice, e quello che tutti vorrebbero evitare come co-founder.

Un dettaglio gustoso: l’utilizzo di dati post-cutoff mette definitivamente a tacere l’argomento più gettonato contro i LLM: “ripetono solo ciò che hanno già visto”.

Qui siamo nel dominio dell’invisibile.

Ogni proposta generata dai modelli è stata confrontata con ricerche che non esistevano al momento dell’addestramento. Se ci azzeccano, è davvero capacità predittiva, o qualcosa che ci assomiglia pericolosamente.

E se ci azzeccano troppo spesso, il problema non è l’allineamento, ma la sostituzione cognitiva.

Una volta erano strumenti di potenziamento. Ora cominciano ad avere “opinioni scientifiche”.

Per chi guida prodotti, marketing o investimenti, la lezione è chirurgica: non si tratta solo di “usare l’AI per avere idee”, ma di testare la qualità delle idee come si farebbe con un pitch deck.

Chiediti sempre:

È sulla traiettoria giusta?

È costruibile senza drogare il burn rate?

Questa mentalità filtrante è la nuova arma per tagliare il rumore e arrivare prima alle intuizioni ad alto potenziale.

Perché quando i modelli cominciano a proporre direzioni di ricerca che ottengono citazioni vere, l’ideazione non è più un’attività casuale. È una pipeline di prodotto con KPI accademici.

Per gli operatori significa smettere di cercare la “AI migliore”, e iniziare a fare matching tra modello e tipo di idea.

Serve creatività speculativa per presentazioni che devono far sognare?

Vai con il provocatore.

Serve un piano che puoi implementare senza che la tua roadmap si autodistrugga?

Usa l’esecutore.

In un mondo dove l’AI comincia a sembrare un collaboratore e non più un tool, la vera leadership sarà nella selezione, orchestrazione e interrogazione dei modelli giusti.

Anche perché, diciamolo, i paper sono la nuova valuta delle startup deep tech.

E se un modello riesce a “prevedere” cosa sarà pubblicabile tra sei mesi, potrebbe anche intuire dove investire, su cosa brevettare, o con chi parlare prima degli altri.

Come disse una volta un angel investor:

“L’unica cosa più pericolosa di un’idea troppo avanti è un team che non capisce che è già stata pensata da qualcun altro.”

Benvenuti nell’era in cui quel “qualcun altro” potrebbe essere un modello linguistico. E, spoiler: non dorme mai.