Se hai sempre sognato di trasformarti in un personaggio anime con occhi rosa fosforescente o vedere il tuo cane scavare una buca tra cactus viola in un deserto arancione (sì, arancione), allora Meta ha un regalo per te. Ma affrettati: è gratis solo per un “tempo limitato”. Il che, in gergo tecnologico, è una combinazione tossica tra “beta testing pubblico non dichiarato” e “prima ti faccio innamorare, poi ti metto l’abbonamento”.

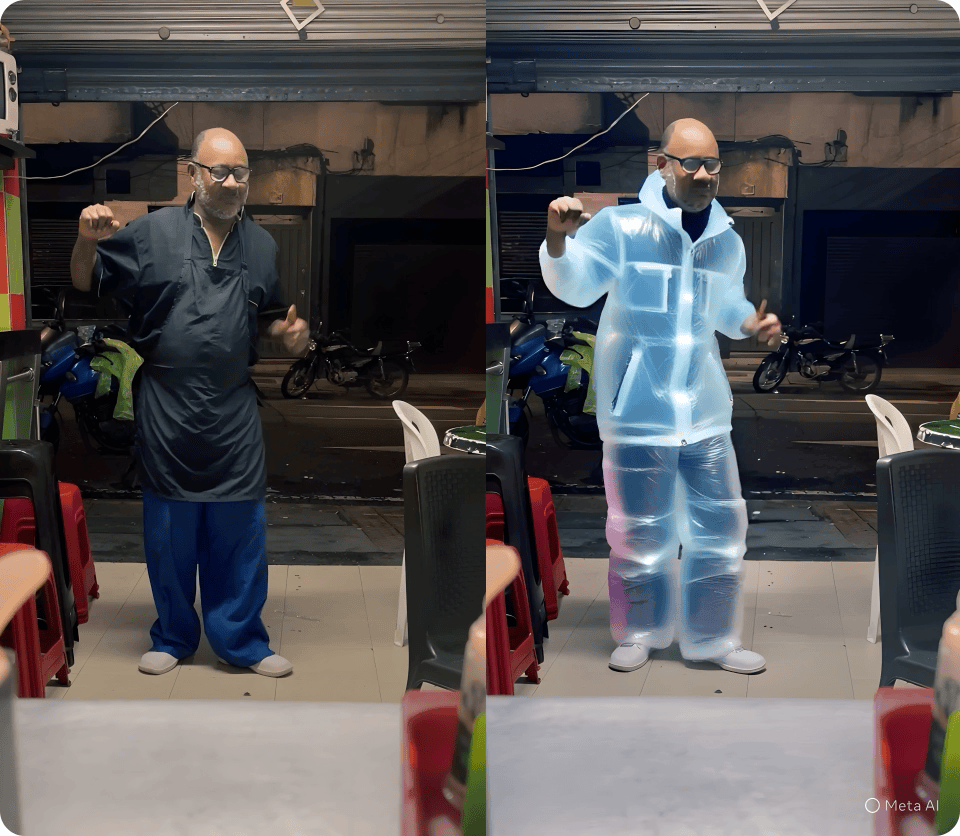

Meta ha appena lanciato un nuovo strumento di video editing AI che consente di trasformare radicalmente i primi dieci secondi dei tuoi video. Sottolineiamo: dieci secondi. Come direbbe un regista indie sotto metanfetamina: “È tutta una questione di incipit”. I preset disponibili sono più di cinquanta, e funzionano esattamente come i filtri di Instagram, ma con ambizioni più grandi: ti cambiano lo sfondo, ti vestono in smoking digitale, ti truccano come un personaggio di un JRPG lisergico e ti proiettano in ambienti virtuali vagamente distopici. La parola chiave? Restyling video assistito da intelligenza artificiale. O meglio: travestimento post-moderno in 1080p.

Lo strumento, disponibile tramite l’app Meta AI, il sito meta.ai e la misteriosa “Edits app”, è ora in rollout negli Stati Uniti e in una dozzina abbondante di altri paesi. L’interfaccia è amichevole, l’esperienza è istantanea, l’effetto è quello di una demo tecnica uscita da una startup del 2016 che ha appena ricevuto una rinfrescata dal reparto marketing di Zuckerberg.

Ora, facciamo un passo indietro. È un tool di editing? È uno specchio narcisistico in realtà aumentata? È l’ennesimo tentativo di Meta di colonizzare il tempo libero dei creator con un giocattolo accattivante quanto effimero?

Tutto questo, ovviamente, senza la possibilità di usare prompt personalizzati, almeno per ora. Ma tranquilli, “arriveranno più avanti quest’anno”. È il classico teaser da roadmap da AI company: promettere tutto per il Q4, mantenere il 20% nel Q1 dell’anno dopo, e poi pivotare su qualcos’altro.

Non è Studio Ghibli, scrive Emma Roth su The Verge, con una punta di delusione e una certa precisione chirurgica. Ed è vero: se stai cercando Totoro, troverai più probabilmente un Totoro impasticcato con gli shader sbagliati. Perché, dietro le quinte, questo editing AI è ancora una collezione di modelli generativi che operano sul frame rate con vincoli rigidi: dieci secondi, zero prompt custom, una manciata di filtri da TikTok deluxe.

Eppure, Meta non sta giocando a fare l’app di video divertenti. Sta costruendo una pipeline di contenuti AI-native integrata con i suoi social. Non è solo un tool di video editing. È un esperimento di AI-mediated self-expression. È, in sintesi, il tentativo di rendere virale l’illusione che tu possa diventare chiunque, ovunque, con un tap.

Si potrebbe anche parlare dell’implicita strategia di lock-in: condividi direttamente su Facebook e Instagram, entra nel feed Discover dell’app Meta AI, resta lì, genera, modifica, posta. L’interfaccia ti seduce, l’ecosistema ti imprigiona. Il sogno del metaverso, post-Zuckerpocalypse, si è travestito da filtro anime.

C’è dell’ironia nel fatto che, mentre registi, artisti e designer stanno cercando modi per integrare creativamente l’AI nei loro workflow, Meta abbia scelto la strada opposta: massificare l’uso dell’AI in modo da appiattire ogni estetica sul gusto medio dell’algoritmo. Invece di liberare l’espressione individuale, la codifica. Vuoi essere un samurai spaziale con occhi fucsia? Perfetto, sei il numero 27. Subito dopo il “deserto cyberpunk” e prima del “club anni ’90 post-berlinese”.

A livello tecnico, questi effetti sono basati su reti generative probabilmente derivate da modelli simili a quelli di Runway o Pika Labs, ma con ottimizzazioni specifiche per il mobile. L’obiettivo non è la precisione estetica, ma la velocità percepita. I glitch non sono bug, sono feature: rendono tutto più “cool” e “generato”. È lo style transfer che incontra il consumismo estetico in tempo reale.

Meta ha compreso una cosa chiave: il contenuto oggi non è più ciò che comunichi, ma come appari nel frame di una timeline. E quindi ha deciso di darti un superpotere, ma con la batteria scarica dopo dieci secondi. È uno specchio digitale brevettato, che riflette ciò che l’algoritmo pensa tu voglia essere. Per ora, accontentati del filtro “cane nel deserto psichedelico”.

Ma attenzione. Se Meta mantiene le promesse — cioè la possibilità di editare con prompt personalizzati — ci troveremo di fronte a un ecosistema in cui ogni video potrà diventare un deepfake stilizzato su richiesta. Un TikTok del futuro in cui l’autenticità è un’opzione, non la regola. A quel punto, il problema non sarà la qualità dei filtri, ma la perdita del contatto con il reale. Come diceva Andy Warhol: “In the future, everyone will be famous for fifteen minutes”. Ma forse aveva dimenticato di specificare: in formato verticale, AI-enhanced, con cactus viola sullo sfondo.

Per Meta, i dieci secondi sono solo l’inizio. Per noi, forse, l’ennesimo finale annunciato.