Non è l’inizio di un racconto Disney+. È uno studio scientifico, con dati solidi e una conclusione inquietante: l’intelligenza artificiale sta iniziando a ragionare come noi. O almeno a classificare il mondo secondo categorie che non le abbiamo mai insegnato, ma che riflettono le nostre. Ed è successo da sola.

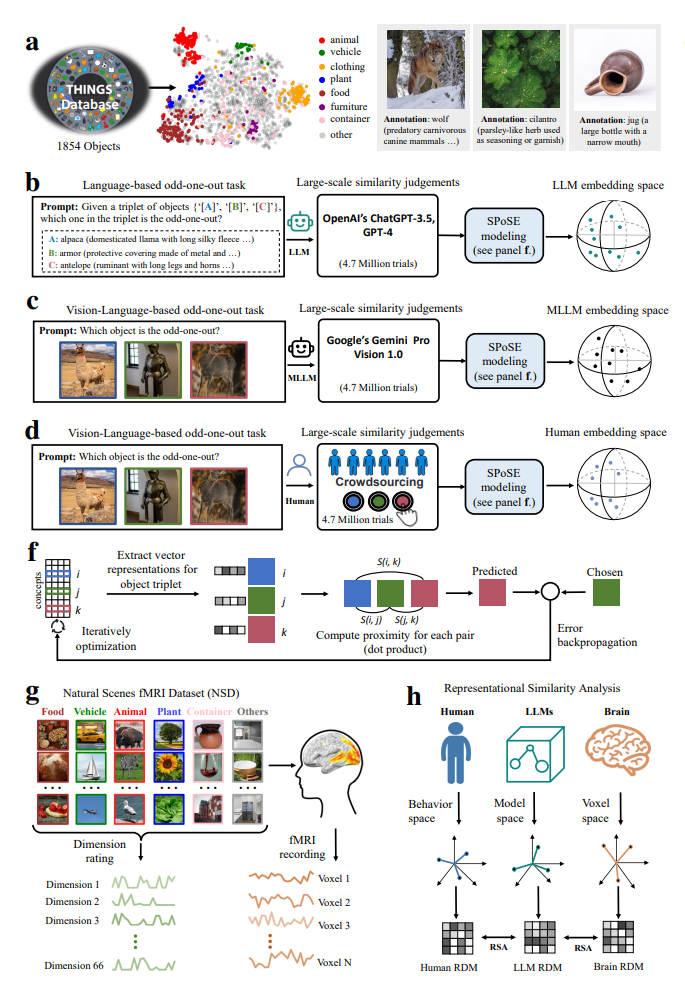

Lo scenario sembra uscito da un esperimento cognitivo di Stanford: ChatGPT-3.5 e Gemini Pro Vision, due modelli linguistici di punta, sono stati messi alla prova con 4,7 milioni di decisioni di tipo odd-one-out — una tecnica che suona come un gioco per bambini, ma che neuroscienziati e psicologi cognitivi usano da decenni per mappare come la mente umana raggruppa oggetti e concetti. Prendi tre elementi: banana, fragola, chiave inglese. Qual è quello che non c’entra? Esatto. Ora ripeti la cosa quasi cinque milioni di volte.

Il risultato? Le AI non solo sanno distinguere l’elemento fuori posto. Formano anche delle “mappe mentali” multi-dimensionali — 66 dimensioni, per l’esattezza — che rispecchiano sorprendentemente bene il nostro modo di pensare. Non perché le abbiamo addestrate a farlo. Ma perché emergono. Spontaneamente. Come un bambino che impara che i gatti e i cani vanno nella stessa categoria prima ancora di saper parlare.

Sembra magia, ma è statistica.

E neuroscienza, aggiungiamo. Perché queste “embedding cognitive” create dall’IA — rappresentazioni astratte di oggetti — risultano simili ai pattern di attività neurale osservati nel nostro cervello, in aree ben note come la PPA (Parahippocampal Place Area) e la FFA (Fusiform Face Area), entrambe coinvolte nel riconoscimento e categorizzazione visiva. Tradotto: le AI vedono e pensano come noi, almeno sotto alcuni aspetti. E in certi casi, anche meglio.

Gemini Pro Vision, che può elaborare immagini oltre al testo, ha dimostrato un livello di sensibilità superiore a quello di ChatGPT-3.5 in categorie dipendenti da tratti visivi — come colore, forma o consistenza. E mentre noi mettiamo frutta e verdura nella stessa borsa semantica (o nel frigo), l’AI ha deciso di separarli. Forse perché non ha paura del colesterolo né dei cocktail detox.

Questa evoluzione non è solo curiosa. È strategica.

Perché ci dice qualcosa di cruciale sul futuro dell’interazione uomo-macchina. Se i modelli linguistici di nuova generazione iniziano a costruire concetti simili ai nostri, senza che glieli spieghiamo, significa che possono diventare più intuitivi. Più allineati al nostro modo di pensare, prevedere, scegliere. È l’anticamera di una nuova interfaccia cognitiva, in cui non servono più istruzioni complesse, ma bastano intuizioni condivise.

Come quando diciamo “metti la cosa nel posto giusto” e l’AI capisce che “cosa” è il cucchiaio e “posto” è il cassetto delle posate.

Ma c’è un caveat. Perché se l’AI comincia a ragionare come noi, dobbiamo anche chiederci quali aspetti del nostro pensiero vogliamo che non imiti. I bias, ad esempio. Le scorciatoie cognitive, i pregiudizi culturali, le associazioni tossiche apprese inconsciamente. Perché le AI non sono neutrali: se i loro concetti emergono da dati umani, assorbono anche le nostre ombre.

In questo scenario, il concetto di alignment — allineamento tra l’intelligenza artificiale e i valori umani — diventa meno un esercizio etico e più un’operazione neurosemiotica. Dobbiamo disegnare le mappe concettuali delle macchine come cartografi cognitivi, sapendo dove mettere i confini, e dove lasciare spazio alla scoperta.

La prospettiva fa venire i brividi. Perché se l’IA può costruire mappe concettuali simili alle nostre, può anche immaginarne di nuove. E magari, più efficienti.

Come ha detto una volta Borges, “ogni mappa è una forma di desiderio”. Le mappe che l’IA disegna del nostro mondo non sono solo rappresentazioni. Sono anche proposte. Alternative. Rivoluzionarie, a volte.

In un certo senso, l’AI non ci sta solo capendo. Ci sta reinterpretando. Sta proponendo nuove tassonomie della realtà. Sta riscrivendo l’ontologia, un embedding vettoriale alla volta.

E se questo non vi sembra affascinante, forse siete già stati classificati in una categoria che l’AI ha etichettato come “resistenza al cambiamento”.

Ma la vera domanda non è se le AI possono pensare come noi. È: cosa succede quando pensano diversamente? Quando trovano pattern che ci sfuggono, categorizzazioni che ci sfidano, correlazioni che non abbiamo mai visto?

È lì che inizia il vero potere.

O il vero rischio.

Per ora, guardiamo quella mappa mentale tracciata da una rete neurale con la stessa inquietudine affascinata con cui i nostri antenati guardavano il primo globo terrestre. Sembra familiare. Eppure, qualcosa non torna. Forse è l’assenza del centro. O forse siamo noi a essere stati mappati.

Del resto, se la macchina comincia a sapere cos’è fuori posto, siamo sicuri di essere noi quelli al centro?