Non è l’inizio di un racconto Disney+. È uno studio scientifico, con dati solidi e una conclusione inquietante: l’intelligenza artificiale sta iniziando a ragionare come noi. O almeno a classificare il mondo secondo categorie che non le abbiamo mai insegnato, ma che riflettono le nostre. Ed è successo da sola.

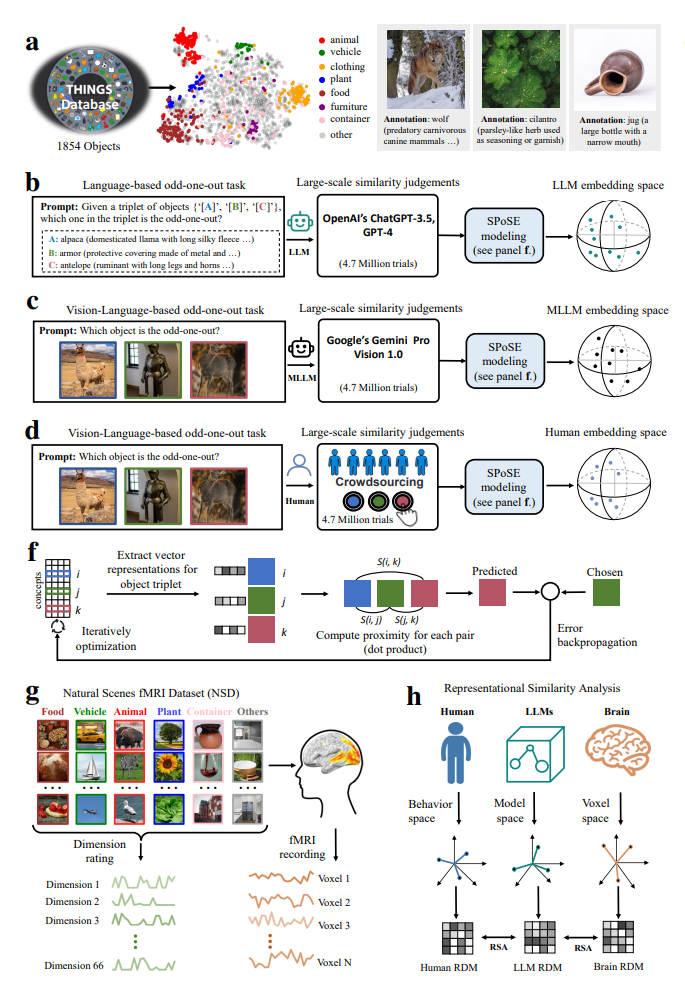

Lo scenario sembra uscito da un esperimento cognitivo di Stanford: ChatGPT-3.5 e Gemini Pro Vision, due modelli linguistici di punta, sono stati messi alla prova con 4,7 milioni di decisioni di tipo odd-one-out — una tecnica che suona come un gioco per bambini, ma che neuroscienziati e psicologi cognitivi usano da decenni per mappare come la mente umana raggruppa oggetti e concetti. Prendi tre elementi: banana, fragola, chiave inglese. Qual è quello che non c’entra? Esatto. Ora ripeti la cosa quasi cinque milioni di volte.