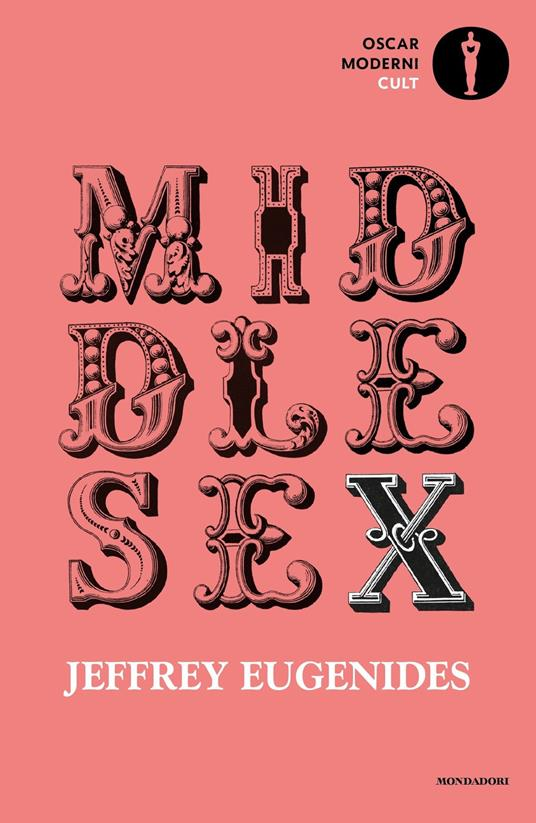

A volte la giustizia americana riesce a incarnare l’ambiguità morale del nostro tempo con una precisione che nemmeno un romanzo di Don DeLillo. La recente decisione del giudice federale William Alsup (in copertina) sul caso Bartz et al. vs. Anthropic è una di quelle sentenze che non solo cambiano il gioco, ma riscrivono parte del regolamento – o quantomeno, ne reinterpretano una clausola chiave sotto nuova luce. Per la prima volta, un tribunale ha dichiarato che addestrare modelli di intelligenza artificiale su libri fisici acquistati legalmente e successivamente digitalizzati, anche senza il permesso degli autori, è fair use. Il che, tradotto dal legalese alla realtà, significa che scansionare “Middlesex” di Jeffrey Eugenides, rimuovendone il dorso e tagliandone le pagine come se fosse un pollame, è perfettamente legittimo se serve ad alimentare l’intelligenza artificiale di turno.

Questa è la notizia. Ma come ogni buon CTO sa, il diavolo, la disruption e il rischio regolatorio stanno nei dettagli. Mentre gli executive di Anthropic possono festeggiare mezzo bicchiere pieno (e probabilmente versarne uno da qualche parte nella Bay Area), la parte vuota non è proprio trascurabile: il giudice ha anche deciso che ci sarà un processo separato per giudicare l’uso massivo di libri piratati da internet, di cui Anthropic ha fatto incetta nella sua libreria centrale. Ed è qui che l’odore acre del Napster del machine learning torna a infestare l’aula di tribunale.

Da un lato, Alsup ha tracciato una linea netta: se compri un libro, lo puoi digitalizzare e usarlo per addestrare il tuo modello. La trasformazione dell’opera da contenuto letterario a vettore numerico in un sistema probabilistico — è talmente radicale da essere considerata “sufficientemente trasformativa”. Il che, agli occhi del diritto statunitense, rientra pienamente nel concetto di fair use. Dall’altro, però, ha lanciato una stilettata a chi, come troppe AI company cresciute nell’era del “scrap now, ask later”, ha costruito i propri modelli sulla base di contenuti presi da repository opachi e da biblioteche digitali dal pedigree dubbio. In soldoni: se potevi comprare il libro, e invece l’hai scaricato da Z-Library, preparati a pagare.

Quello che rende questa sentenza particolarmente interessante, se non del tutto rivoluzionaria, è il tipo di equilibrio che tenta di instaurare: riconoscere una certa legittimità al data ingestion quando deriva da un atto d’acquisto tracciabile (che, diciamolo, è la nuova forma di indulgenza algoritmica) ma condannare l’accaparramento massivo e indiscriminato di contenuti. In altre parole, il giudice non sta difendendo gli autori per principio, ma sta semplicemente dicendo alle AI company: volete i dati? Pagate la tassa culturale minima.

Nel motivare la sentenza, Alsup ha usato un’analogia che farà digrignare i denti a più di un romanziere: “Il loro reclamo è lo stesso che avrebbero se si lamentassero del fatto che insegnare ai bambini a scrivere bene porterebbe a un’esplosione di opere concorrenti”. Una frase da incidere sulle porte di Anthropic, OpenAI, Google DeepMind e di qualunque startup della Valley che pensi di poter costruire modelli linguistici con la stessa etica con cui si scava nel codice open source: cioè copiando, aggiustando, riciclando e ottimizzando. Ma attenzione: questa analogia scolastica è un’arma retorica sofisticata, perché lascia intendere che il problema degli autori non è giuridico, ma quasi psicologico. Come se temessero che i loro allievi algoritmici potessero superarli nella scrittura.

In realtà, la posta in gioco è più ampia. Perché questa sentenza non affronta — e il giudice lo sottolinea con cautela — la questione più scivolosa: se e quando l’output di un modello AI costituisce una violazione del copyright. Questo sarà oggetto di altri processi, altri avvocati, altri appelli. Ma l’effetto domino è già cominciato. Se l’input è considerato fair use quando legalmente acquistato e digitalizzato, chi potrà fermare la trasformazione sistematica di ogni biblioteca universitaria in un set di addestramento per LLM?

Ora immaginiamo lo scenario. Un’azienda con capitale sufficiente potrebbe teoricamente acquistare migliaia di libri, distruggerli fisicamente (con buona pace dei bibliotecari), e nutrire le proprie AI di quel sapere in modo perfettamente legale. Niente scraping selvaggio, niente bot che girano su archive.org, niente documenti rubati. Solo acquisti in libreria e scanner professionali. Questo modello di “fair use industriale” apre la strada a un nuovo tipo di business per il settore editoriale: vendere libri non più solo ai lettori, ma agli algoritmi. Se gli editori avessero una visione a lungo termine — il che, storicamente, non è garantito — inizierebbero domani a stipulare contratti specifici con licenze AI-inclusive. Ma molti, come sempre, preferiranno citare in giudizio, tardi e male.

Anthropic ha quindi vinto una battaglia, ma la guerra sul copyright algoritmico è tutt’altro che finita. Il confine tra uso lecito e appropriazione indebita rimane sottile, volatile, soggetto all’interpretazione di giudici che un giorno citano scuola elementare e il giorno dopo richiamano la moralità implicita nella proprietà intellettuale. È un far west giuridico dove chi muove per primo — e con più dati — detta le regole del gioco. Per ora.

E mentre gli autori cercano giustizia, le AI diventano scrittori a tempo pieno. Allenati su biblioteche acquistate, scansionate, triturate e convertite in vettori. Fa quasi ridere pensare che tutto questo sia partito da un’opera acquistata in copertina rigida da Barnes & Noble.