Etica dell’intelligenza artificiale: due visioni a confronto

Antonio Dina affronta l’etica dell’IA con un taglio strategico, sistemico e profondamente legato alla governance del potere algoritmico. Per lui, l’Ai deve essere vincolata da principi di trasparenza attiva, accountability tracciabile e coerenza con gli obiettivi sociali, economici e culturali di lungo periodo. L’etica, in questa visione, non è un freno ma un framework competitivo.

Fabrizio Degni adotta un approccio più ingegneristico e tecnico, focalizzato sulla robustezza dei modelli, l’equità computazionale e la mitigazione dei bias, ma senza rinunciare a una riflessione filosofica sulla responsabilità condivisa tra sviluppatori e fruitori. La sua etica è più pragmatica: un set di buone pratiche ex ante, per evitare derive sistemiche ex post.

Due scuole di pensiero: una orientata alla regia del cambiamento, l’altra alla prevenzione dell’errore.

Benvenuti nel mondo dove i manifesti dell’etica sull’intelligenza artificiale si stampano a Bangkok, ma le decisioni che contano si prendono a Washington, Pechino e nei boardroom privati di San Francisco. L’UNESCO ha riunito più di mille persone al suo Global Forum sull’Etica dell’AI, compresi 35 ministri di governi prevalentemente del sud globale, nel disperato tentativo di rendere vincolanti delle linee guida etiche che, per ora, restano più dichiarazioni d’intenti che strumenti concreti. Mancavano però i protagonisti principali del teatro AI: OpenAI, Google, Microsoft, DeepSeek. È come organizzare un summit per la pace e scoprire che le due superpotenze in “guerra” hanno declinato l’invito.

Eppure, l’UNESCO insiste. Il direttore generale Audrey Azoulay ha dichiarato solennemente che l’obiettivo è “preparare il mondo all’AI e l’AI al mondo”. Una frase impeccabile da conferenza stampa, degna di un poster motivazionale. Peccato che, nel frattempo, i governi più potenti del pianeta si stiano preparando alla guerra fredda dell’AI, non al suo disarmo etico. Il Congresso USA sta proponendo di vietare l’uso federale di strumenti cinesi come DeepSeek, mentre la Cina continua a sfornare modelli fondazionali come se stesse producendo missili intelligenti, non-chatbot conversazionali.

E allora chi c’era, a Bangkok? C’erano i Paesi dell’ASEAN, Zambia, Zimbabwe, un nugolo di ONG e ricercatori con budget sempre più ridotti, compressi tra la retorica multilaterale e i tagli ai finanziamenti. Alcuni, come la Global Centre on AI Governance, hanno raccontato pubblicamente le difficoltà economiche, peggiorate dal ritorno di Trump e dal blocco dell’agenzia USA per lo sviluppo internazionale. Mentre i miliardi scorrono a valle delle big tech, l’etica sembra essere diventata un’attività da no-profit con una mailing list e poco altro.

Il forum ha avuto anche il merito, va riconosciuto, di lanciare la “readiness assessment methodology”, uno strumento pensato per trasformare le raccomandazioni in politiche concrete. Si tratta di un questionario per governi che pone domande come “l’AI è considerata nei suoi impatti sull’uso del suolo e dell’acqua?”. Domanda intelligente, certo. Ma basta guardare chi sta sviluppando l’AI oggi per capire che nessuno dei veri protagonisti si sveglia al mattino preoccupandosi dell’ecosistema idrico né tantomeno delle richieste energetiche oramai soddisfatte solo con centrali nucleari.

È in questo contesto che risulta quasi grottesco il silenzio degli Stati Uniti e della Cina: anche quando gli USA hanno tecnicamente riaderito all’UNESCO nel 2023, la loro assenza a questi eventi segnala chiaramente che non intendono farsi dettare l’agenda da un organismo multilaterale. Lo stesso vale per Pechino, che pur mandando professori di spicco a parlare di “trasparenza” nelle definizioni, non sembra affatto intenzionata a rallentare la corsa al predominio algoritmico. Come ha detto Zeng Yi, decano del Beijing Institute of AI Safety and Governance, “possiamo metterci d’accordo sulle parole, ma tradurle in misure concrete è un’altra storia”. È la versione accademica del proverbio cinese: “Parlare costa meno che fare”.

Nel frattempo, la Thailandia cerca una terza via. Il ministro del digitale ha affermato che il Paese non prenderà posizione tra Washington e Pechino, e la giovane premier Paetongtarn Shinawatra ha dichiarato ambiziosi obiettivi: 90.000 professionisti AI e 15 miliardi di dollari in infrastrutture. Parole forti, che sembrano più un esercizio di branding nazionale che una strategia industriale sostenibile. Del resto, anche la Svizzera ha una politica spaziale: nulla vieta ai piccoli Paesi di pensare in grande. Il problema arriva quando devono competere con chi scrive il codice… e le regole del gioco.

È qui che l’etica dell’AI rivela tutta la sua ambiguità strutturale: serve a chi non può decidere, ma non vincola chi decide davvero. Il “common good” evocato dall’UNESCO diventa un concetto vago, spirituale, un’ancora morale che non trattiene nulla. Un pò come quelle dichiarazioni ambientali delle compagnie petrolifere: si pronunciano con serietà, ma non spostano di un millimetro le rotte reali.

Eppure, c’è un valore nel forum di Bangkok: quello di costituire uno specchio. Non tanto per chi lo organizza, quanto per chi non partecipa. È il termometro dell’asimmetria geopolitica dell’intelligenza artificiale. I grandi player non si fanno vedere, ma osservano. E sebbene le raccomandazioni dell’UNESCO non abbiano forza legale, indicano chiaramente chi intende giocare con le regole e chi con l’algoritmo più affamato.

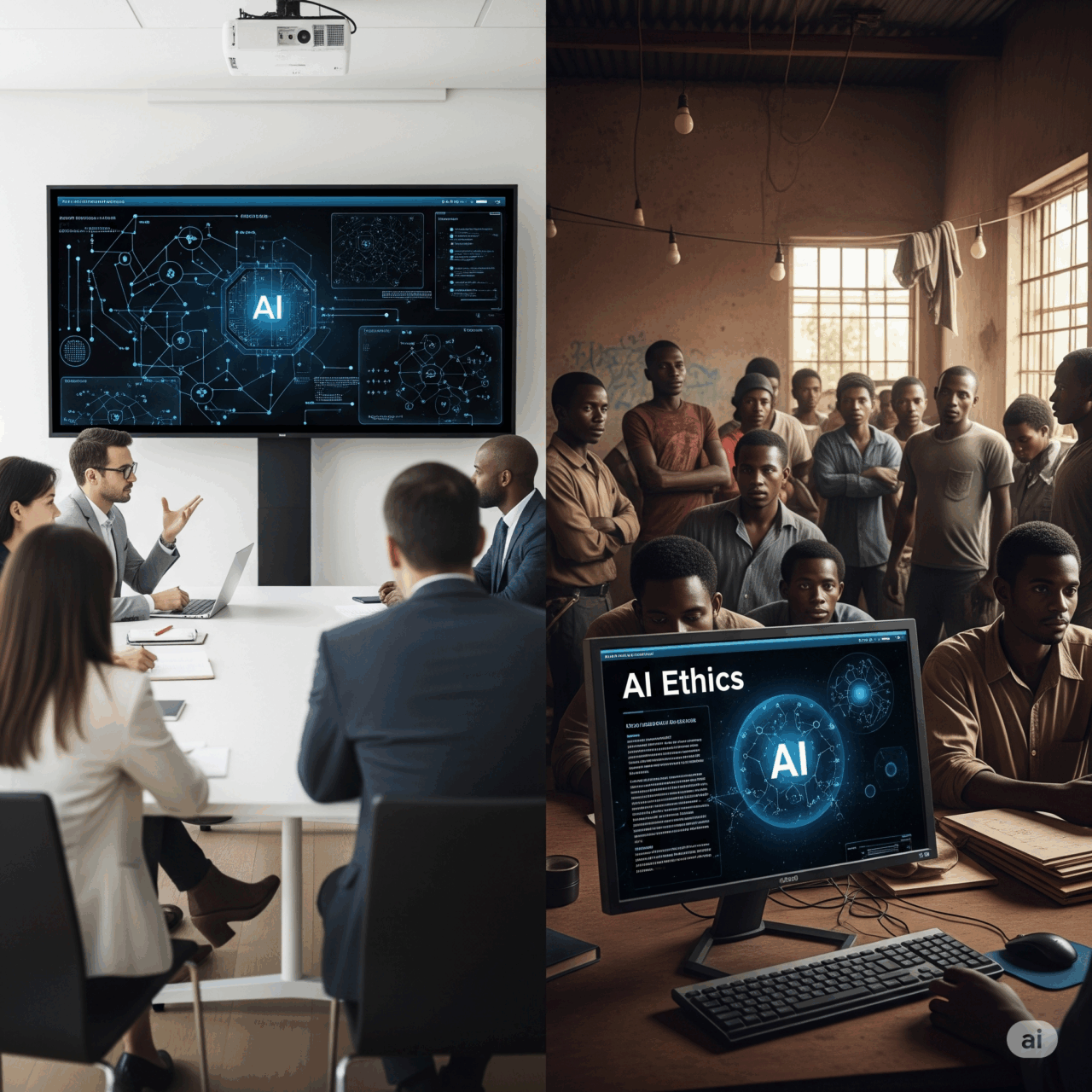

Come ogni impero emergente, anche l’IA ha le sue periferie e i suoi centri, le sue utopie etiche e le sue realtà brutali. E mentre le democrazie si attorcigliano in dibattiti sui diritti digitali, sulle implicazioni bioetiche e sull’inclusività degli LLM, i regimi autoritari costruiscono sistemi predittivi integrati nei meccanismi di sorveglianza e governance. Il paradosso? Spesso le stesse tecnologie sono vendute dalle stesse aziende che, nei convegni internazionali, firmano dichiarazioni sui principi etici universali.

La verità è che l’etica dell’AI, oggi, non è universale. È geopolitica. È un riflesso dei rapporti di forza, non un metalinguaggio condiviso. Finché OpenAI, Google, Microsoft, Baidu e DeepSeek e gli altri grandi player non siederanno allo stesso tavolo a discutere non di parole, ma di limiti reali, tutto il resto sarà solo un preambolo elegante. O peggio, un alibi. L’etica è fondamentale, certo. Ma, come la privacy su Facebook, funziona meglio quando non disturba il modello di business

E quindi lasciamo ancora correre? Ignorare che una volta ancora la storia ci stia presentando l’opportunità di utilizzare la tecnologia per aiutare una società persa in sé stessa, vittima dei suoi stessi desideri, e dell’incapacità di guardarsi dentro, nel silezio, nella noia di apprezzare e lodare il bene più importante, la vita. Invece assistiamo giornalmente ad un deuperamento delle unicità dell’uomo, della sua capacità di pensare diversamente, fuori dagli schemi, di essere genio e sregoletezza ma anche sensibile, empatico, comprensivo… umano. Ma c’è un’altra frattura meno visibile, eppure profondamente radicata: quella del tempo.

Oggi viviamo una disuguaglianza non solo economica e geopolitica, ma temporale. Il tempo umano, quello fatto di memoria, esitazione, crescita e rimorso, è incompatibile con i tempi computazionali dell’AI. Mentre i modelli vengono addestrati e rilasciati con la rapidità di un aggiornamento software, i processi etici chiedono lentezza, dialogo, confronto.

L’etica richiede tempo, l’AI lo consuma.

È questa l’asimmetria più pericolosa: quella tra un’etica che ha bisogno di sedimentarsi e una tecnologia che si rigenera prima ancora di essere capita. In questa corsa cieca, rischiamo di perdere la sovranità sui nostri ritmi mentali, sulla nostra capacità di rallentare, di riflettere, di dire “aspetta”.

La vera posta in gioco non è solo chi decide, ma quando possiamo ancora decidere.