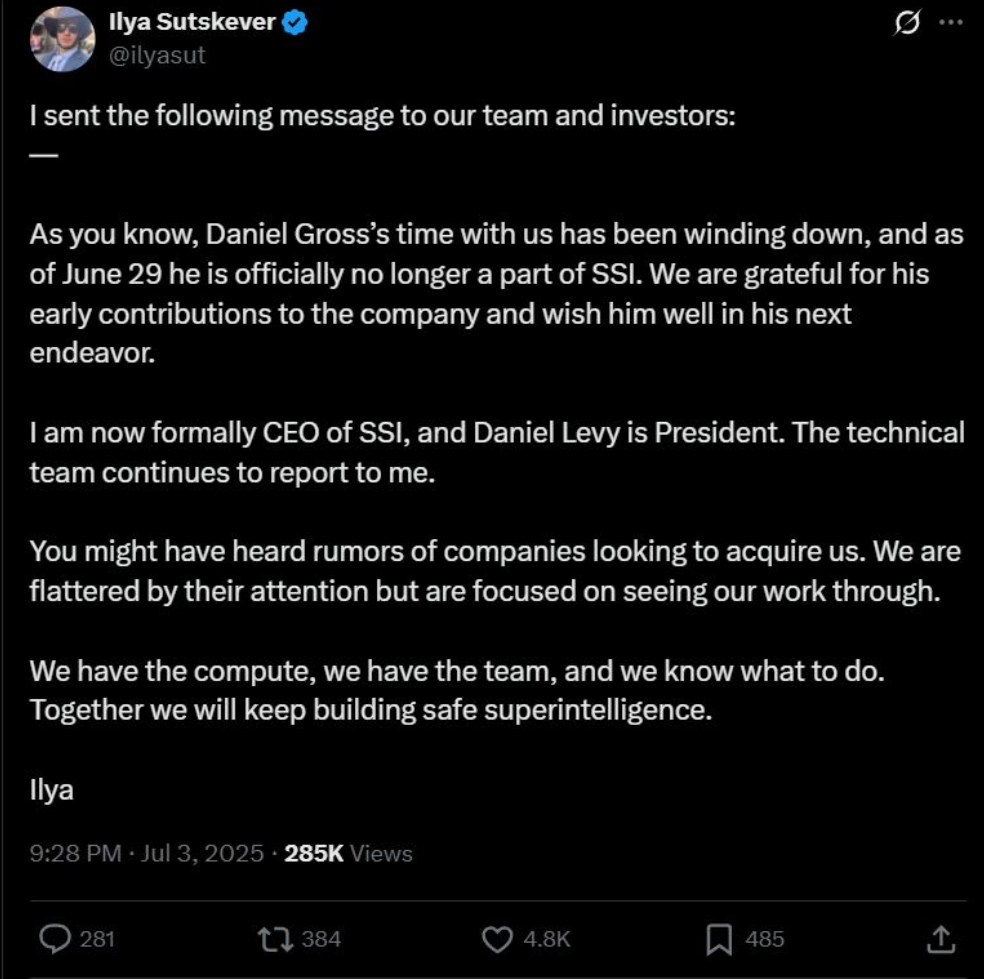

La notizia è fresca e già puzza di vecchio. Ilya Sutskever, cofondatore di OpenAI, ha finalmente tagliato corto alle voci e ha confermato ciò che molti sospettavano ma pochi osavano dire ad alta voce: la sua totale dedizione alla Safe Superintelligence Inc. (SSI), ora ufficialmente guidata da lui in qualità di CEO. A fianco, come Presidente, il fidato Daniel Levy. E mentre Daniel Gross saluta con discrezione, lasciando la compagnia il 29 giugno, una cosa è chiara: Sutskever non è interessato a IPO, unicorni o pitch deck per venture capitalist in cerca di adrenalina. No, lui vuole costruire una superintelligenza sicura. Punto.

La narrativa che SSI sta costruendo è deliberatamente monolitica, quasi monastica. Niente hype, niente pivot, niente “AI for enterprise” o “LLM per la produttività aziendale”. Solo una missione: build safe superintelligence, and nothing else. È la più radicale delle semplicità. Ma proprio per questo è anche la più sospetta. In un panorama dove anche l’ultima app per note vuole “democratizzare l’accesso all’intelligenza artificiale”, SSI decide invece di chiudere le tende e lavorare in silenzio. È l’antitesi di OpenAI, che da “open” ha ormai solo il nome e una strategia commerciale da Big Tech consolidata. Sutskever, invece, sembra voler tornare alle radici: meno marketing, più ricerca. Ma non illudiamoci. Dietro l’aura monastica, la geopolitica del calcolo e del talento brucia più intensamente che mai.

La notizia arriva in un momento emblematico, quando l’intera industria dell’intelligenza artificiale sembra aver perso l’orientamento strategico, sacrificando ogni principio sull’altare dell’attenzione. Le aziende rincorrono AGI come se fosse la prossima moda, tra annunci teatrali, benchmark truccati e demo che sembrano trailer di Netflix. Nel frattempo, il concetto stesso di “sicurezza” è stato deformato fino a diventare irriconoscibile: da principio etico a leva di potere. La sicurezza, oggi, è ciò che ti permette di chiudere l’accesso ai tuoi modelli, di chiedere miliardi senza accountability e di mascherare il centralismo con retoriche morali.

In questo contesto, la dichiarazione di Sutskever sembra tanto un gesto di rottura quanto una mossa di consolidamento. “We are flattered by the attention but are focused on seeing our work through.” È il tipo di frase che si scrive sapendo benissimo che attirerà ancora più attenzione, ma filtrandola attraverso un linguaggio da monastero Zen. SSI ha calcolo, ha talento e ha una missione. Ma soprattutto, ha un posizionamento preciso: essere l’anti-startup nel mondo delle AI startup. Il minimalismo strategico diventa così un vantaggio competitivo.

Il problema è che questa ostentata purezza ha un prezzo. Per costruire una safe superintelligence servono quantità grottesche di energia, denaro, competenze e tempo. Nessuna di queste risorse è illimitata, e tutte sono già oggetto di guerra fredda tra stati, Big Tech e nuovi conglomerati AI. La domanda quindi è semplice: può un’organizzazione così chiusa, così focalizzata e così intenzionalmente spoglia reggere l’urto delle forze che governano l’economia della superintelligenza? Oppure finirà per diventare l’ennesimo laboratorio segreto in un mondo dove il segreto stesso è ormai un vantaggio industriale?

Per ora, SSI sembra giocare una partita diversa. Rifiuta le metriche del successo tradizionale. Non parla di utenti, revenue o scale-up. Parla di alignment. Un concetto affascinante quanto sfuggente, che evoca immagini di intelligenze artificiali che capiscono, interiorizzano e rispettano i valori umani. Ma chi decide quali sono questi valori? E soprattutto, cosa accade quando un sistema li implementa troppo bene? L’allineamento non è una destinazione, è una negoziazione perenne. Affidarla a un gruppo ristretto di individui, anche se brillanti, significa ridurre il problema politico dell’AI a un problema tecnico. Ed è proprio questo il pericolo.

C’è un’ironica verità nel modo in cui Sutskever ha deciso di scommettere tutto sulla sicurezza della superintelligenza. È una scelta radicale, quasi romantica, che rifiuta i compromessi e abbraccia l’assoluto. Ma come spesso accade con le visioni assolute, il rischio è che diventino autoritarie senza volerlo. Perché quando tutto ruota attorno a una missione unica, qualsiasi dissenso può essere visto come sabotaggio, qualsiasi deviazione come un tradimento. L’ossessione per la sicurezza può facilmente trasformarsi in controllo, la concentrazione di potere in “governance responsabile”.

Il paradosso è che proprio nel momento in cui l’industria AI sta esplodendo in mille direzioni, con modelli open source, agenti autonomi, architetture ibride e intelligenze multi-modali, SSI decide di restringere il campo, chiudere la porta e lavorare in silenzio. È come se Tesla avesse deciso di costruire un’auto perfetta in laboratorio prima ancora di provarne una su strada. La purezza è affascinante, ma spesso sterile. O peggio: facilmente strumentalizzabile.

La vera domanda, quindi, non è se SSI riuscirà a costruire una superintelligenza sicura. La domanda è se può farlo senza diventare essa stessa un esempio di centralizzazione estrema. In un’epoca in cui la trasparenza è una moneta scarsa e il codice è sempre più blindato, chi può davvero fidarsi di una missione così radicale, portata avanti in completa autonomia, senza checks and balances esterni? È questa la vera ironia: che il più grande tentativo di costruire un’intelligenza allineata all’umanità possa avvenire proprio nel modo meno umano possibile.

Per ora, Ilya Sutskever tiene il timone, fissa l’orizzonte e ignora il rumore di fondo. Ma il mondo guarda, anche se da lontano. E non sarà la retorica sulla sicurezza a mettere a tacere le domande fondamentali. La superintelligenza sarà pure inevitabile, ma la sua sicurezza non lo è affatto. E chi crede che basti una missione chiara e qualche mente brillante per garantirla, forse ha più fede che intelligenza.