Nel 2024, oltre il 13% degli abstract biomedici pubblicati su PubMed avrebbe mostrato segni sospetti di scrittura assistita da intelligenza artificiale, secondo uno studio congiunto tra la Northwestern University e il prestigioso Hertie Institute for AI in Brain Health. Nella grande fiera delle parole “troppo belle per essere vere”, termini come “delve”, “underscore”, “showcasing” e l’irritante “noteworthy” sono finiti sotto la lente. Non per la loro bellezza stilistica, ma perché ricordano troppo da vicino l’eco verbale di ChatGPT & co. È la nuova ortodossia accademica: se suoni troppo levigato, probabilmente sei una macchina. E se non lo sei, poco importa, verrai trattato come tale.

Il problema non è solo tecnico, è epistemologico. I ricercatori hanno confrontato 15 milioni di abstract tra il 2021 e il 2024 e hanno notato un’impennata nell’uso di espressioni “sospette”. Il dataset include 454 parole considerate tipiche della prosa algoritmica: “encapsulates”, “seamless”, “scrutinizing”. Ora, immaginiamo Galileo Galilei nel 2025 pubblicare “Sidereus Nuncius” con un’introduzione che suona un po’ troppo come un prompt ben formattato. La comunità accademica, invece di interrogarsi sul contenuto rivoluzionario, si chiede: “Lo ha scritto davvero lui?”

È la nuova isteria collettiva: l’IA non è più solo uno strumento, ma un colpevole da identificare tramite indizi stilistici, come fosse un killer linguistico. Stuart Geiger, professore a UC San Diego, l’ha detto chiaramente: “L’unico modo affidabile per rilevare l’uso di LLM è essere presenti nel processo di scrittura”. Tradotto: o ti metto una webcam mentre digiti, oppure sto solo facendo archeologia speculativa sul tuo lessico. Parliamo di sorveglianza cognitiva, non di tecnologia.

Ma la paranoia ha superato la razionalità. Decrypt ha testato nel 2024 gli strumenti di rilevamento AI più popolari ZeroGPT, GPTZero, Quillbot, Grammarly ottenendo risultati surreali: la Dichiarazione d’Indipendenza degli Stati Uniti, secondo ZeroGPT, sarebbe stata scritta per il 97,93% da un’intelligenza artificiale. GPTZero invece le attribuisce appena il 10%. Dunque, o Thomas Jefferson era un prompt engineer ante litteram, oppure gli strumenti che vendono certezze algoritmiche stanno servendo fumo condito con big data.

Geiger la definisce “vendita di olio di serpente” ed è difficile dargli torto. I sedicenti strumenti di detection si basano su modelli probabilistici, non su prove forensi. Analizzano pattern linguistici e producono diagnosi fondate su corrispondenze superficiali. In sintesi, ti accusano di plagio algoritmico perché hai usato “delve”, come se scrivere bene fosse diventato di colpo un crimine.

Kathleen Perley, docente alla Rice University e AI advisor per la business school, pone la questione vera: “Se l’IA aiuta chi ha barriere linguistiche o disabilità a contribuire alla ricerca senza compromettere la qualità, allora dov’è il problema?”. La risposta, ovviamente, è che il problema non è etico, ma culturale. L’accademia teme di perdere il controllo sul proprio linguaggio d’élite. Come se il valore della conoscenza si misurasse nel numero di passivi impersonali o nel pathos di un gerundio ben piazzato.

Il panico morale attorno all’IA è solo l’ultima reiterazione di una crisi più profonda: quella dell’autenticità. È lo stesso dibattito che ha accompagnato l’introduzione del correttore ortografico, l’uso di Wikipedia, e persino gli appunti riassuntivi stile CliffsNotes. La scrittura, in questo paradigma, è sacra solo se dolorosa. Se un’intelligenza artificiale ti aiuta a evitare errori o ti offre una migliore articolazione delle tue idee, allora il tuo pensiero non è “genuino”. Ma da quando la conoscenza è una gara di stile calligrafico?

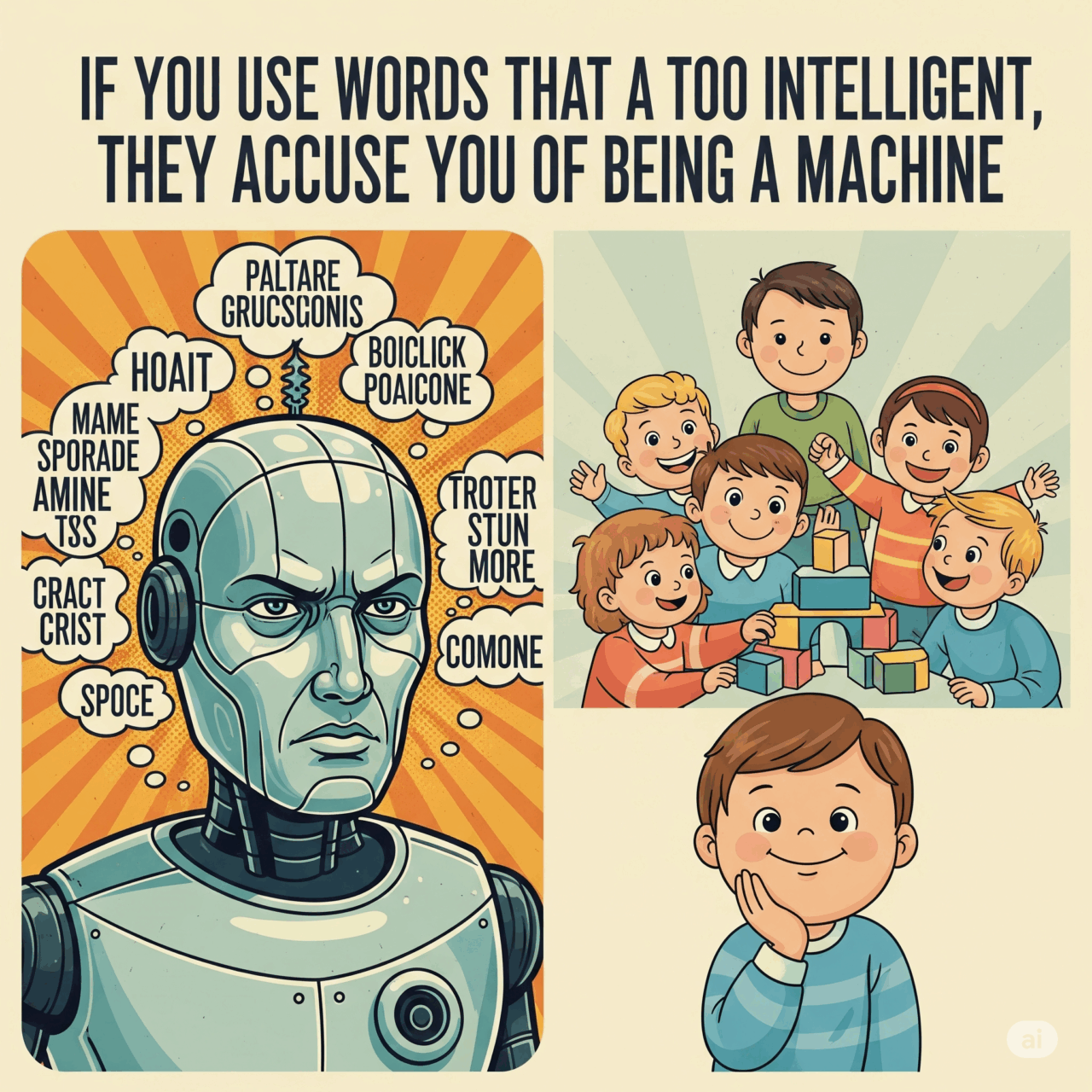

Il punto critico, come ha fatto notare ancora Geiger, è che “la gente ha paura di essere accusata di usare l’IA, quindi cambia il modo in cui scrive”. In altre parole, l’effetto collaterale più perverso di questa inquisizione algoritmica è che costringe gli autori umani ad auto-censurarsi. Evitano parole raffinate per non sembrare “troppo bravi”. Un ribaltamento quasi comico: nella terra della meritocrazia, chi scrive bene è sospetto.

Il dato più inquietante, però, non è tecnico ma sistemico. I ricercatori coinvolti nello studio ammettono che i loro strumenti identificano solo segnali indiretti di AI, ma questo non impedisce ai gatekeeper accademici di usarli come prove. Si finisce così in una zona grigia in cui l’originalità viene giudicata da un algoritmo che non capisce né ironia né contesto. Chi scrive con passione ma non si adegua alla grammatica algoritmica del sospetto viene penalizzato. E chi si affida a un AI writer per superare una barriera linguistica rischia l’accusa di frode.

La professoressa Perley offre una prospettiva più equilibrata: “Se AI permette a più persone di partecipare alla ricerca scientifica, anche a costo di avere più ‘delves’, ben venga”. Il problema è che non tutti la pensano così. C’è chi vorrebbe blindare l’accesso all’autorialità, rendendo la scrittura un rituale esoterico riservato a pochi iniziati. Per questi puristi, l’intelligenza artificiale è una contaminazione, non una collaborazione.

Vale la pena ricordare che anche Isaac Newton, se vivesse oggi, probabilmente userebbe Grammarly. Non perché non sapesse scrivere, ma perché l’efficienza è sempre stata amica del genio. Dopotutto, se posso impiegare meno tempo a sistemare le virgole e più tempo a calcolare integrali, forse ho capito meglio il mestiere del ricercatore. Ma provate oggi a pubblicare un abstract con due “underscore” e un “seamless”. Il reviewer potrebbe chiedervi di giurare sotto tortura che non avete mai incontrato ChatGPT.

Nel 2023, uno studio della University of Cambridge aveva già evidenziato che la percezione dell’autenticità nei testi è fortemente influenzata dallo stile, non dal contenuto. Frasi brevi, tono diretto, lessico medio-basso vengono percepiti come più “umani”. In sostanza, la macchina non è solo quella che scrive, ma anche quella che legge. E in un mondo in cui i reviewer stessi potrebbero usare AI per revisionare, si crea una catena semiotica paradossale: AI che scrive per essere letta da AI.

La verità è che siamo in piena transizione linguistica, e ogni epoca ha avuto il suo spartiacque. L’invenzione della stampa ha tolto il monopolio del sapere ai monaci amanuensi. L’intelligenza artificiale potrebbe fare lo stesso con l’ipocrisia stilistica del mondo accademico. Il sospetto che serpeggia oggi non è tanto sull’origine delle parole, ma sul controllo delle idee. Chi scrive cosa, e per chi. E chi decide se un pensiero è valido, se non la comunità che lo riceve?

L’ironia finale è che mentre ci preoccupiamo se un “delve” sia umano o artificiale, perdiamo di vista la vera minaccia: la standardizzazione cognitiva. Un mondo in cui si scrive per evitare flag stilistici, anziché per comunicare concetti. Dove il pensiero originale viene schiacciato da un dizionario predittivo che detta le soglie della credibilità. E allora sì, forse il problema non è che l’IA scrive. È che cominciamo a scrivere tutti come lei, per paura.