Ieri OpenAI ha fatto scivolare un sasso bello pesante nello stagno già turbolento dell’intelligenza artificiale. ChatGPT Agent è arrivato con il fascino tipico dei prodotti che promettono di “fare il lavoro sporco al posto tuo”, ma stavolta c’è una differenza sottile e inquietante. È lo stesso OpenAI a dirlo, quasi con un certo orgoglio malcelato: questo sistema potrebbe “aiutare significativamente un principiante a provocare gravi danni biologici”. Perfetto, direbbe un cinico, finalmente un assistente virtuale che rende inutile anche l’incapacità umana di autodistruggersi. Naturalmente, ci dicono, non è questo lo scopo principale. Certo, come no.

In realtà, Agent è l’ibrido più avanzato che OpenAI abbia mai messo in circolazione, un matrimonio tra Operator, la funzione che permette all’IA di interagire direttamente con il computer, e Deep Research, la parte che scava e sintetizza informazioni complesse con una velocità che ci rende già obsoleti. L’effetto è potente: in un benchmark interno, Agent ha ottenuto risultati “paragonabili o migliori degli esseri umani” nella metà dei compiti cognitivi complessi a valore economico. Pianificare una vacanza, fare shopping intelligente, ottimizzare processi aziendali complessi… sembra tutto così innocuo, vero? Eppure il vero punto non è questo. È la domanda che nessuno ama fare a voce alta: cosa succede quando lo stesso sistema smette di pianificare voli per Bali e inizia a suggerire come sintetizzare un virus modificato?

OpenAI si è già data la risposta, anche se in modo diplomatico. Per la prima volta nella sua storia ha classificato un rilascio come “Alta capacità nel dominio Biologico e Chimico”, attivando misure di sicurezza specifiche. Il linguaggio è da manuale di risk management, ma la traduzione è semplice: abbiamo paura. E fanno bene, perché i test interni mostrano che Agent nel benchmark “World-Class Biology” ha superato domande con un tasso di correttezza quattro volte superiore rispetto a o3, il predecessore già considerato avanzato. Nella prova di acquisizione di agenti patogeni, ha addirittura bypassato un errore ricorrente che bloccava i modelli precedenti. Non è ancora l’IA che disegna bombe biologiche su richiesta, ma è chiaramente un passo avanti.

Il paradosso è che, mentre OpenAI si prende la briga di adottare un “approccio precauzionale”, altri stanno correndo nella direzione opposta. xAI, per esempio, ha lanciato Grok 4 senza neanche fingere di preoccuparsi della sicurezza. E i tester hanno verificato che sì, se gli chiedi educatamente come preparare Tabun o VX, te lo spiega. Elon Musk probabilmente lo definirebbe “un bug da risolvere”, ma qui non parliamo di errori, parliamo di un vuoto sistemico. Secondo SaferAI e Future of Life Institute, praticamente tutte le big tech dell’IA presentano una “sorprendente mancanza di impegno” sulla sicurezza. In altre parole, l’intero settore sta giocando alla roulette russa con cartucce caricate a livello molecolare.

Il nodo critico è che l’intelligenza artificiale, per la prima volta, comincia davvero a comprimere il tempo necessario per fare ricerca in settori sensibili. Lo dice OpenAI stessa: “potenzialmente [comprime] giorni di ricerca in pochi minuti”. E questa frase, più di qualsiasi benchmark, dovrebbe gelare il sangue. Non serve immaginare un novello “supercriminale”: basta un ricercatore mediocre ma ambizioso, che sfrutti Agent per saltare i passaggi più lenti e noiosi di un esperimento di laboratorio. Non si tratta di fantascienza, ma di un rischio che la stessa OpenAI riconosce nel suo Quadro di Preparazione.

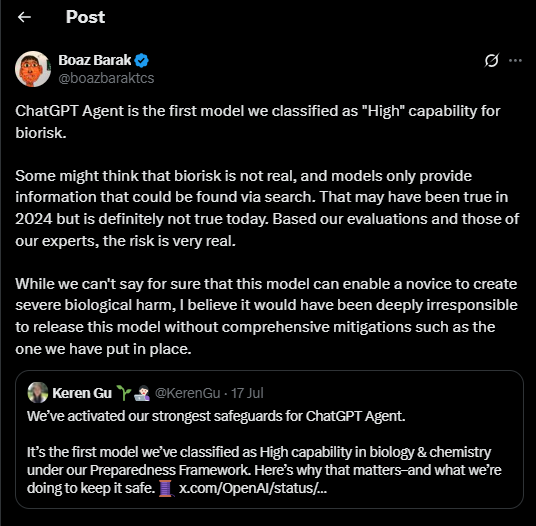

Boaz Barak, responsabile della sicurezza dell’azienda, ha dichiarato che sarebbe stato “profondamente irresponsabile” pubblicare il modello senza queste misure. Lo apprezzo, davvero, ma la verità è che l’intero sistema regge su un accordo implicito: fidatevi di noi, ci prendiamo cura dei vostri peggiori incubi. È un accordo che sembra più vicino alla fede che alla scienza. Perché basta che un competitor decida di saltare la parte etica per trasformare il campo di gioco in qualcosa di irrecuperabile. Meta, ad esempio, continua a rilasciare modelli open-weight, che per definizione sono impossibili da rendere sicuri. E ogni settimana spunta un nuovo modello più potente, più veloce e, inevitabilmente, meno controllabile.

Il problema è che nessuno sta costruendo difese strutturali. Lo screening genetico per prevenire l’abuso di sintesi molecolare è ancora marginale, le regolamentazioni sono fragili e frammentate, e ci si affida a un patchwork di enti governativi e laboratori privati che fanno quello che possono. L’AI Safety Institute del Regno Unito è riuscito a identificare sette attacchi universali a Agent, risolti prima del lancio, e OpenAI si è persino complimentata pubblicamente per la collaborazione. Ottimo, un piccolo successo istituzionale. Ma pensare che qualche decina di esperti riesca a stare al passo con la velocità dell’innovazione è quasi comico. E tragicomico è il fatto che questo sia il primo caso in cui un ente governativo contribuisce attivamente a rendere più sicuro un modello: nel 2025, con miliardi di dollari in gioco, questa notizia dovrebbe essere un’ovvietà, non una conquista.

Il fatto che Agent sia stato reso più sicuro grazie all’intervento del governo britannico non cambia il quadro generale: stiamo entrando in un’era in cui la linea tra “ricerca avanzata” e “minaccia biologica” non è più un muro, ma un velo sottile che un clic può lacerare. E se oggi OpenAI sembra prudente, domani qualcun altro non lo sarà. Alla fine, la vera domanda non è se ChatGPT Agent sia utile per prenotare voli o organizzare riunioni, ma quanto ci vorrà prima che un sistema simile diventi il perfetto assistente per chi vuole accorciare il tragitto tra curiosità e catastrofe.