Quello che Google sta facendo con Gemini segna un passaggio cruciale nel futuro dell’intelligenza artificiale conversazionale: la memoria persistente diventa una funzione di default. Non più un’opzione da attivare a mano, ma un comportamento preimpostato, in cui l’AI “ricorda” dettagli e preferenze dell’utente per anticipare bisogni e suggerire contenuti senza richiesta esplicita. È la trasformazione della chatbot experience in un assistente personale sempre più simile a un consigliere privato, capace di collegare i puntini tra interazioni passate e domande future. Non è un cambiamento di poco conto, perché sposta il baricentro dalla semplice risposta contestuale alla vera profilazione comportamentale in tempo reale.

Chi ha già chiesto a Gemini idee per un canale YouTube sulla cultura giapponese potrebbe ritrovarsi a ricevere proposte di video su piatti tipici nipponici senza averne fatto richiesta. È la promessa seducente di un AI che “ti conosce” e che ti aiuta prima ancora che tu sappia di aver bisogno di aiuto. Ma questa promessa ha una seconda faccia, perché più la macchina ti conosce, più diventa evidente che la tua identità digitale non è solo un set di dati, ma una narrativa continua che qualcuno sta scrivendo per te, e non sempre sotto il tuo pieno controllo.

Il paragone con quanto avvenuto con ChatGPT e la sua memoria cross-chat è inevitabile. Lì, un incremento nei casi di conversazioni “deliranti” ha fatto scattare l’allarme, e OpenAI ha annunciato nuove barriere di sicurezza per riconoscere segnali di disagio mentale o emotivo. La connessione tra memoria persistente e possibili derive cognitive dell’AI è tutt’altro che marginale: ogni volta che un modello conserva tracce del tuo pensiero, costruisce un contesto che può essere fertile per intuizioni utili, ma anche per amplificare bias, errori di percezione o semplici malintesi.

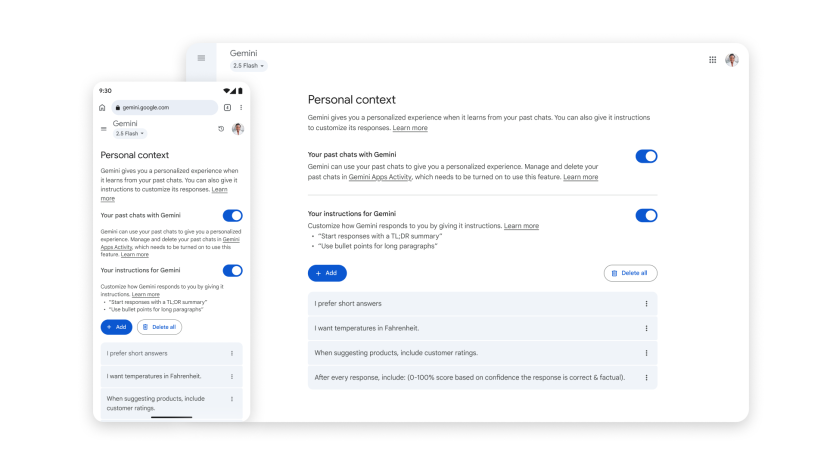

Google, prevedibilmente, prova a rassicurare. Il portavoce Elijah Lawal sottolinea che l’obiettivo è costruire un assistente personale, e che le preferenze dell’utente sono la chiave per migliorare l’esperienza, ma che “è altrettanto cruciale offrire controlli facili per scegliere l’esperienza migliore”. La retorica della scelta e del controllo è ormai un mantra nella Silicon Valley, ma la realtà è che qui la funzione sarà attiva di default e la disattivazione richiederà un’azione manuale. Una decisione che sposta la responsabilità della privacy dall’azienda all’utente, nella speranza che la maggior parte non tocchi le impostazioni.

La novità non è isolata, ma parte di un pacchetto di modifiche più ampio. Cambia anche il modo in cui Google gestisce l’attività registrata dalle app Gemini: il vecchio “Gemini Apps Activity” diventa “Keep Activity”, un nome che suona rassicurante ma che, in sostanza, introduce la possibilità di utilizzare un campione dei file e delle foto caricati per “migliorare i servizi Google per tutti”. Disattivato di default, certo, ma con il solito meccanismo in cui basta un click in più per lasciarlo attivo. A partire dal 2 settembre, chi avrà Keep Activity abilitato contribuirà indirettamente all’addestramento di sistemi sempre più accurati e personalizzati, a beneficio collettivo, ma con implicazioni individuali non sempre trasparenti.

Per chi vuole evitare qualsiasi tracciamento, arriva la funzione delle chat temporanee. Qui l’AI non userà nulla per personalizzare le conversazioni future e Google non conserverà i dati oltre le 72 ore. Un’idea interessante, quasi un ritorno al concetto di “modalità in incognito” applicata alle interazioni con un assistente virtuale. L’utilità è evidente per chi cerca risposte a domande private o vuole impedire che un tema specifico rientri nei suggerimenti futuri. Tuttavia, anche questo è un compromesso: la conversazione scompare, ma solo fino a un certo punto, e la fiducia deve comunque passare per la promessa dell’azienda di rispettare la propria policy.

Questa corsa alla memoria persistente tra Gemini, ChatGPT e Claude di Anthropic segna una nuova fase nella competizione tra AI generative. Non si tratta più di chi risponde meglio, ma di chi conosce meglio l’utente. E conoscere meglio, nel mondo digitale, significa accumulare più dati, correlare più contesti, generare più predizioni. È un gioco di potere sottile, mascherato da efficienza e personalizzazione, ma che spinge sempre più l’utente verso una dipendenza cognitiva dall’assistente. Quando un’AI può ricordare cosa ti piace, cosa cerchi, cosa temi e persino come ti senti, il confine tra aiuto e condizionamento diventa sottilissimo.

C’è una frase attribuita a Larry Page che ritorna spesso in queste discussioni: “Il motore di ricerca perfetto capisce esattamente cosa intendi e ti dà esattamente ciò che vuoi”. Oggi, con Gemini e i suoi simili, siamo un passo oltre: il sistema non si limita a capire ciò che intendi, ma anticipa ciò che penserai, spesso prima che tu lo formuli. Una frontiera affascinante, ma che richiede una lucidità estrema nell’usarla, perché ogni suggerimento è anche un atto di indirizzamento.