Nel mondo delle startup di intelligenza artificiale, un’acquisizione saltata vale spesso più di una riuscita. OpenAI aveva messo gli occhi e i dollari su Windsurf, una giovane promessa nell’ambito dell’agentic coding, con una valutazione da tre miliardi di dollari. Eppure, all’ultimo minuto, l’accordo è evaporato. Non si è trattato di divergenze filosofiche né di visioni incompatibili. La realtà, più brutale, è che Google DeepMind ha agito da predatore con tempismo chirurgico, strappando il cervello e l’anima di Windsurf proprio mentre OpenAI si stava ancora infilando i guanti per l’operazione.

Tag: google Pagina 1 di 7

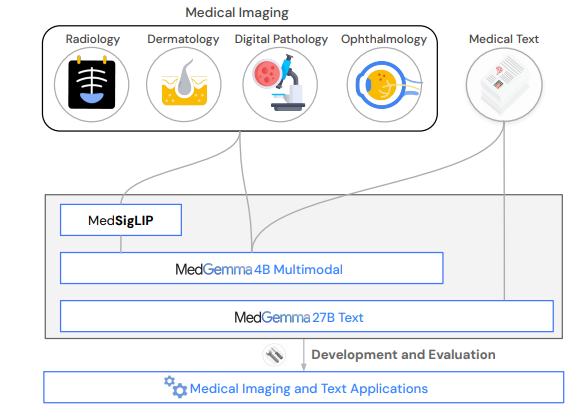

Dimenticate la sanità come l’abbiamo conosciuta. Dimenticate l’accesso limitato, i silos informativi, i software ospedalieri che sembrano usciti dal 2003. Google, con la finezza di un chirurgo e l’ambizione di un imperatore, ha appena scaricato sul tavolo operatorio dell’intelligenza artificiale medica il bisturi più affilato mai visto: MedGemma. Due modelli, uno massiccio da 27 miliardi di parametri e un altro “leggero” da 4 miliardi, sono ora open source, pronti per tagliare, diagnosticare, annotare, prevedere. Il tutto senza l’autorizzazione preventiva del tuo Chief Medical Officer. Bastano un laptop, uno smartphone, o un cervello curioso.

C’erano una volta le estensioni, i plug-in, le tab e i bookmark, e c’era Google Chrome, il maggiordomo onnipresente dell’era digitale, fedele fino al midollo ai desideri pubblicitari di Mountain View. Ma qualcosa sta cambiando. Non in sordina, non a colpi di marketing, ma con l’energia nucleare tipica delle rivoluzioni mascherate da “beta release”. Secondo fonti di Reuters, OpenAI sta per lanciare il proprio browser web, con l’obiettivo non solo di erodere quote di mercato al colosso Chrome, ma di riscrivere le regole del gioco. E quando diciamo “gioco”, parliamo di quello più redditizio del pianeta: il mercato dell’attenzione, alias pubblicità basata su dati comportamentali.

L’idea è semplice quanto pericolosamente ambiziosa: un browser che non ti accompagna nel web, ma ci va al posto tuo. Un’interfaccia nativa in stile ChatGPT, che minimizza il bisogno di cliccare link e navigare come cavernicoli digitali. Le pagine web diventano secondarie, i siti sono solo una fonte grezza da cui l’IA estrae risposte, compila moduli, prenota cene e forse, tra un po’, negozia mutui. Per Google è come se un ospite si presentasse a cena e iniziasse a svuotare il frigo.

Le informazioni sono arrivate il 6 luglio 2025, ma la storia era già nell’aria da settimane. Manhattan suda, letteralmente e metaforicamente, sotto un sole di maggio che sa di agosto. Rockefeller Center pullula di turisti sudati, ragazzini viziati con frappuccino rosa e dirigenti Google con lo sguardo distaccato. Al centro della scena: una scultura che sembra uscita da un incubo LSD di Escher e Yayoi Kusama, ribattezzata con disinvoltura “un vivace labirinto di specchi”. Solo che qui, a riflettersi, non c’è solo chi guarda. C’è anche l’ombra lunga della macchina, che ha cominciato a disegnare.

Google si trova al centro di una rivoluzione tecnologica che ha acceso le sirene d’allarme di chi produce contenuti sul web. Una coalizione di editori indipendenti, tra cui l’Independent Publishers Alliance, supportata da Movement for an Open Web e Foxglove Legal, ha depositato il 30 giugno presso la Commissione europea un formale reclamo per abuso antitrust, mettendo nel mirino i “AI Overviews” del motore di ricerca. I riassunti generati da AI che Google propone in cima alla pagina dei risultati secondo gli editori sarebbero una mannaia per il traffico e le entrate delle testate online.

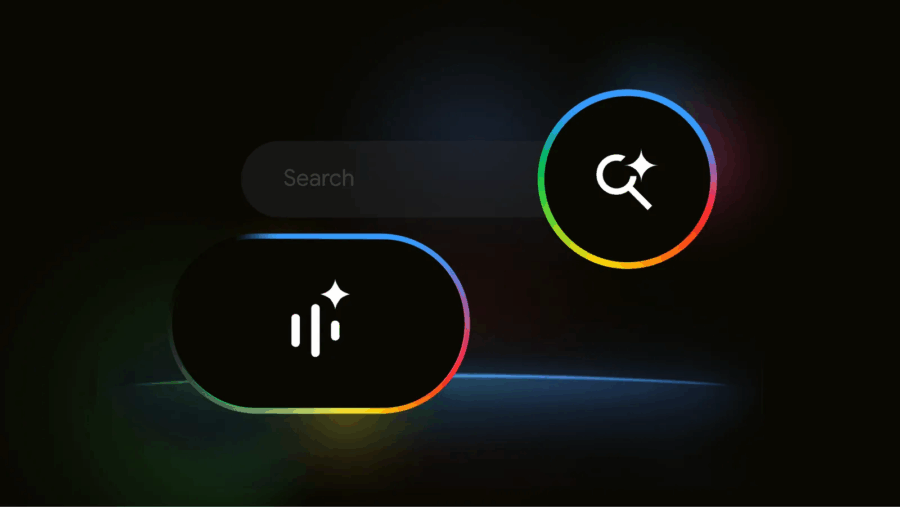

Avete presente quel bottone “Mi sento fortunato” sulla homepage di Google? Sparito. Evaporato. Sostituito da qualcosa di molto meno giocoso e infinitamente più strategico: AI Mode. Ora, se digitate qualsiasi cosa su Google dagli Stati Uniti, è Gemini 2.5 che vi risponde. Non più dieci link blu e un pizzico di fede. Ora è sintesi, immagini, voce e un motore cognitivo che imita l’onniscienza, condito da una UX che cerca di rendere invisibile il passaggio tra domanda e rivelazione. Benvenuti nella ricerca post-umana, dove non cercate più: vi viene consegnato ciò che dovreste sapere, come se Google fosse diventato il vostro consigliere imperiale.

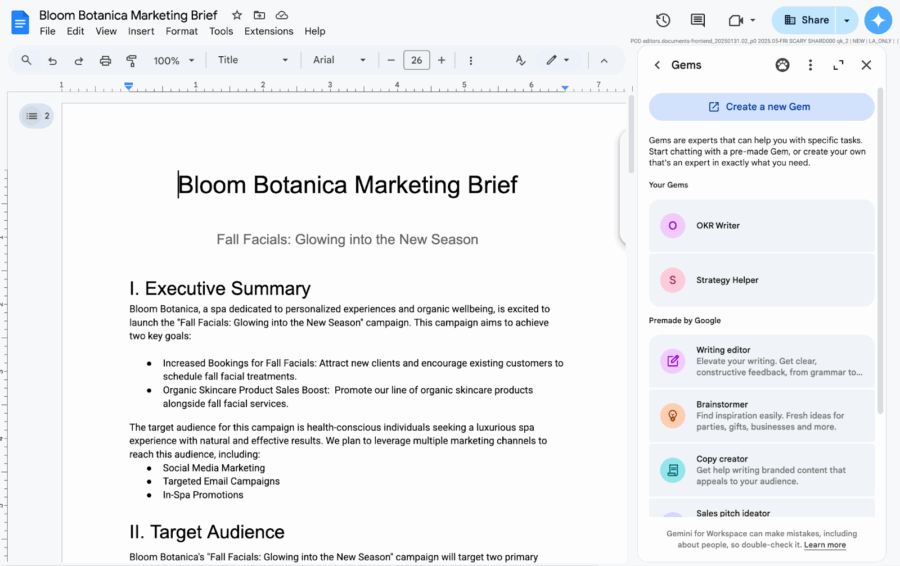

Siamo nell’epoca in cui l’intelligenza artificiale non si limita più a stare in un’app a parte, ma si insinua senza troppo riguardo nei nostri spazi digitali quotidiani. Google Workspace ha appena alzato il tiro con “Gems”, ovvero gemme personalizzate del suo assistente Gemini AI, che promettono di farci risparmiare tempo e noia senza costringerci ad aprire la tanto odiata app di Gemini. Per chi ancora non lo sapesse, Gemini è la nuova frontiera AI di Google, quella che dovrebbe – almeno sulla carta – rivoluzionare il modo in cui interagiamo con il digitale, passando dalla mera automazione al vero “potenziamento umano”.

La novità sta nel fatto che questi Gems (permettete la semplificazione, si legge più veloce) sono ora incastonati come perle nel pannello laterale di Docs, Slides, Sheets, Drive e Gmail. Non serve più fare avanti e indietro tra app diverse, basta un clic e la magia dell’intelligenza artificiale si spalanca direttamente accanto ai vostri documenti, fogli e email, come un consigliere digitale che non dorme mai.

I laboratori blindati che vivono tra NDA, paywall e modelli oscuri stanno tremando. Perché questa volta non è la solita demo da conferenza con tanto di latency simulata e animazioni generative che sembrano disegnate da uno stagista con accesso a Midjourney. Google ha finalmente fatto quello che in tanti promettono ma quasi nessuno realizza: un modello open-weight, davvero multimodale, realmente funzionante offline, capace di girare su dispositivi con 2 GB di RAM senza piangere in C. Si chiama Gemma 3n e non è un gioco di parole. È un attacco frontale, chirurgico, al cuore del dominio centralizzato delle AI commerciali.

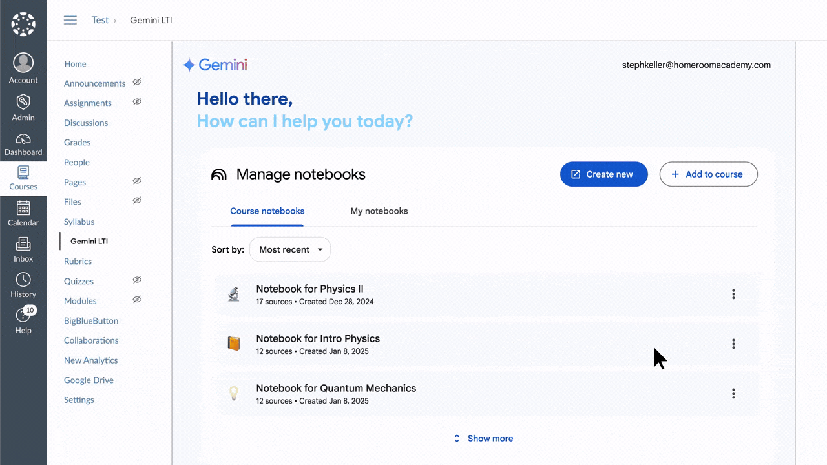

Benvenuti nel futuro dell’istruzione, dove le lavagne si trasformano in chatbot, le verifiche si scrivono da sole e l’insegnante è assistito da un’intelligenza artificiale che sa tutto, ma con un’interfaccia amichevole e un sorriso sintetico. Google ha appena lanciato una serie di aggiornamenti per la sua piattaforma Classroom, e il messaggio è chiaro: l’educazione tradizionale è morta, viva l’educazione algoritmica. Al centro dell’evoluzione ci sono le nuove funzionalità di Gemini AI, che non si limitano più a un pubblico adulto, ma aprono ufficialmente le porte ai minori, sdoganando l’idea che anche lo studente delle medie possa avere un assistente cognitivo personale. Chi ha detto che l’AI non è una questione per bambini?

L’ultimo report di sostenibilità di Google somiglia più a una giustificazione mal scritta che a un piano climatico. Le emissioni sono salite dell’11% in un solo anno, raggiungendo 11,5 milioni di tonnellate metriche di CO₂, con un aumento del 51% rispetto al 2019. Lontanissima la promessa di dimezzarle entro il 2030. Ma non preoccupatevi: si tratta solo di emissioni basate sull’ambizione. Quelle reali sono nascoste in fondo al documento, in un’appendice che nessuno dovrebbe leggere, e arrivano a oltre 15 milioni di tonnellate. L’equivalente di 40 centrali elettriche a gas che lavorano a pieno regime per un anno intero.

Se pensavate che la sfida tra colossi dell’intelligenza artificiale fosse solo una questione di algoritmi e modelli, vi siete persi la partita più sottile ma decisiva: quella dell’hardware. OpenAI, da sempre uno dei maggiori clienti di Nvidia, ha iniziato a spostare parte del proprio carico di lavoro verso i chip AI più economici di Google, i celebri TPU (Tensor Processing Unit). Un cambio di rotta che somiglia a una manovra tattica degna di un generale digitale, in una battaglia che si gioca anche – e forse soprattutto – sui costi, sull’efficienza e sul controllo tecnologico.

Google ha deciso di riaccendere i riflettori su Ask Photos, la funzione di ricerca intelligente integrata in Google Photos e alimentata dai modelli Gemini AI, dopo una pausa silenziosa nel rollout che aveva fatto pensare a un possibile flop tecnico. Ora, invece, la funzione torna in pista con qualche ritocco sostanziale e una promessa implicita: fare finalmente ciò che era stata pensata per fare — aiutarti a trovare le foto giuste nel caos del tuo archivio visivo, senza farti aspettare anni luce.

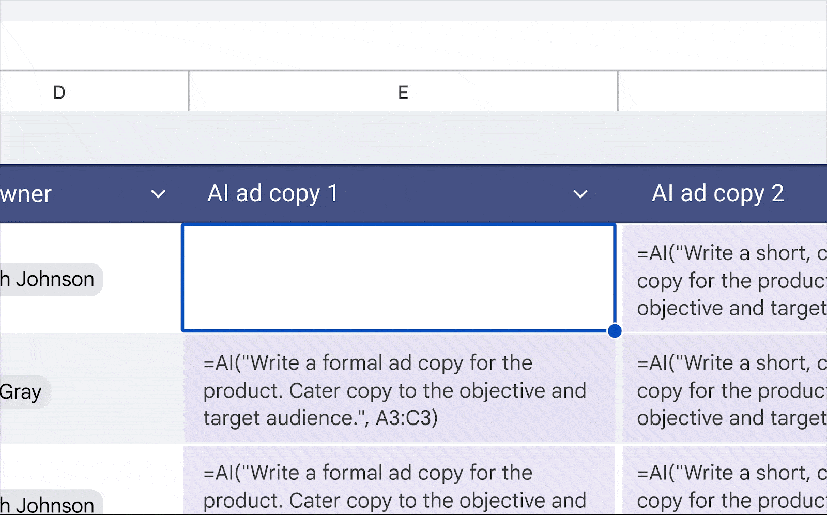

Perfetto, è arrivato il momento in cui anche il tuo foglio Excel (pardon, Google Sheet) può scrivere meglio di molti junior copywriter. Ma non preoccuparti: non è ancora in grado di rubarti il lavoro, almeno non fino alla prossima release.

Google sta introducendo una nuova funzione AI nei Fogli Google che, alimentata da Gemini, consente di generare testo dinamicamente, basandosi sui dati presenti nelle celle. In parole povere? Puoi selezionare un gruppo di celle e chiedere all’intelligenza artificiale di riassumere, categorizzare o generare contenuti testuali su misura. Non male per un tool nato per calcolare formule, no?

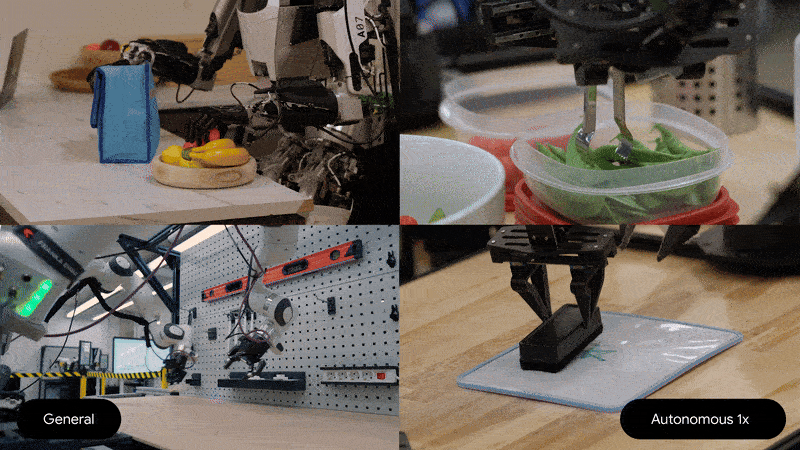

L’AI ha perso la testa. O meglio, l’ha trasferita nei nervi periferici. Perché la vera notizia non è che DeepMind abbia reso Gemini Robotics “più piccolo e più efficiente”, ma che abbia deciso di farlo vivere direttamente a bordo delle macchine, scollegandolo dalla placenta del cloud. Il nuovo modello vision-language-action di Google, annunciato come una versione on-device del già impressionante Gemini Robotics, rompe il cordone ombelicale della connettività perpetua e si installa nel corpo dei robot come un cervello portatile. Senza Wi-Fi, senza lag, senza autorizzazioni. Solo carne meccanica e sinapsi di silicio.

La nuova era della ricerca non si digita più. Si pronuncia. Con tono gentile, magari un po’ ansioso, come se parlassimo a un amico distratto che però ha accesso a tutto il sapere umano. Google lo chiama Search Live, una trovata che suona amichevole, ma ha tutta l’ambizione di riscrivere l’interfaccia stessa tra umani e Internet. Altro che barra di ricerca: qui siamo in pieno dialogo vocale con un’intelligenza artificiale, nel cuore pulsante del motore di Mountain View.

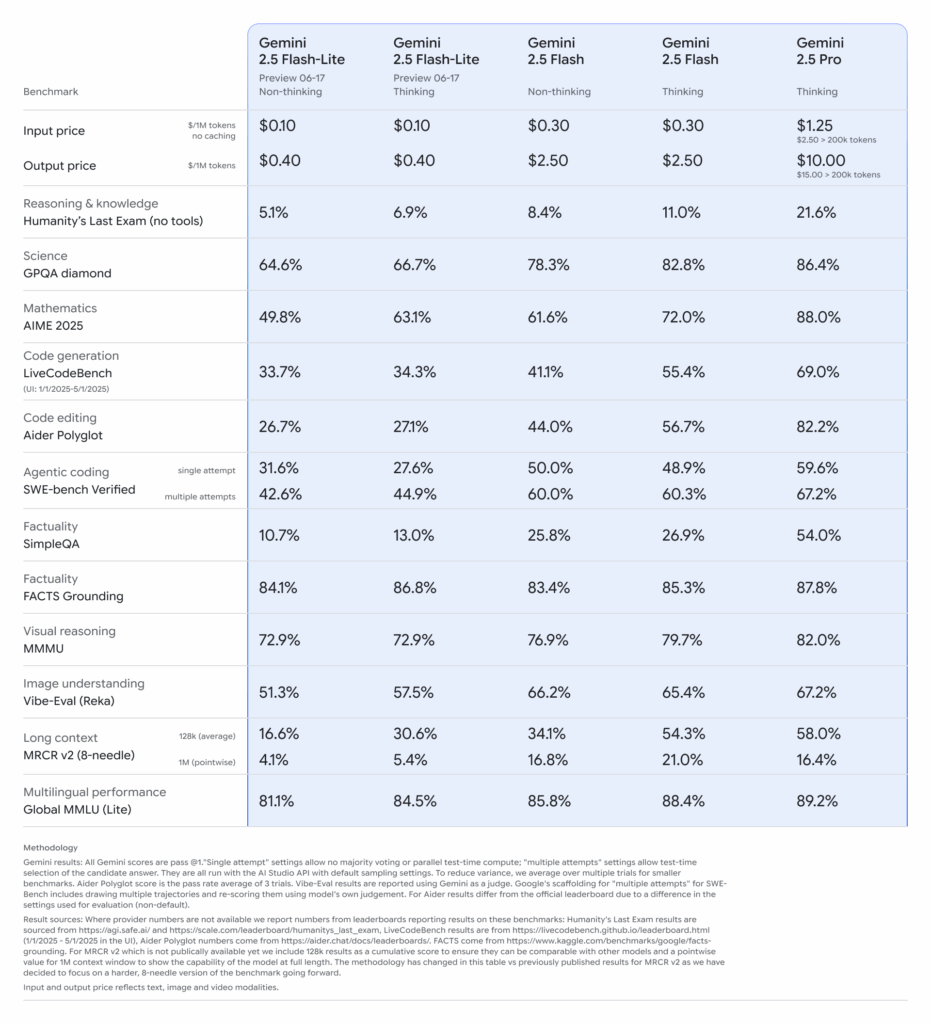

Google ha sganciato la bomba: Gemini 2.5 Pro e Flash sono ora disponibili in versione stabile, ma il vero colpo d’asta è la preview di Gemini 2.5 Flash‑Lite, un modello pensato per chi vuole ragionare in tempo reale a costi risicati.

Che cos’è più rischioso per un gigante tecnologico: una fuga di dati o una fuga di cervelli? Google sembra aver risposto scegliendo la seconda opzione. La decisione, riportata da Reuters, di interrompere (quasi) tutti i rapporti con Scale AI non è solo una questione commerciale. È un atto di autodifesa strategica, una mossa muscolare in un mercato dell’intelligenza artificiale sempre più contaminato da interessi incrociati, partecipazioni incestuose e “amicizie” da manuale di guerra fredda.

La Silicon Valley non licenzia più. Offre pacche sulle spalle e assegni di buonuscita in cambio del badge. L’era dei buyout è arrivata a Mountain View come un gentile tsunami, e a giudicare dall’euforia semantica delle memo interne, è solo l’inizio. Per i dipendenti di Google, in particolare quelli di Core Engineering, Search e altri dipartimenti “strategici”, la nuova parola magica è: “voluntary exit”. Come dire: sei ancora libero di restare, ma non sei più parte del futuro.

Hai digitato una query su Google. Ti aspettavi il solito elenco di link, quella noiosa gerarchia di SEO tossico, titoli clickbait e snippet semi utili. Invece, all’improvviso, una voce calda ti sussurra nelle orecchie una sintesi personalizzata, confezionata da un’intelligenza artificiale addestrata a suonare come un mix tra David Attenborough e il tuo barista di fiducia. No, non è fantascienza. È l’ultima trovata del colosso di Mountain View: trasformare le ricerche in un podcast istantaneo. Automatico. Sintetico. Inevitabile.

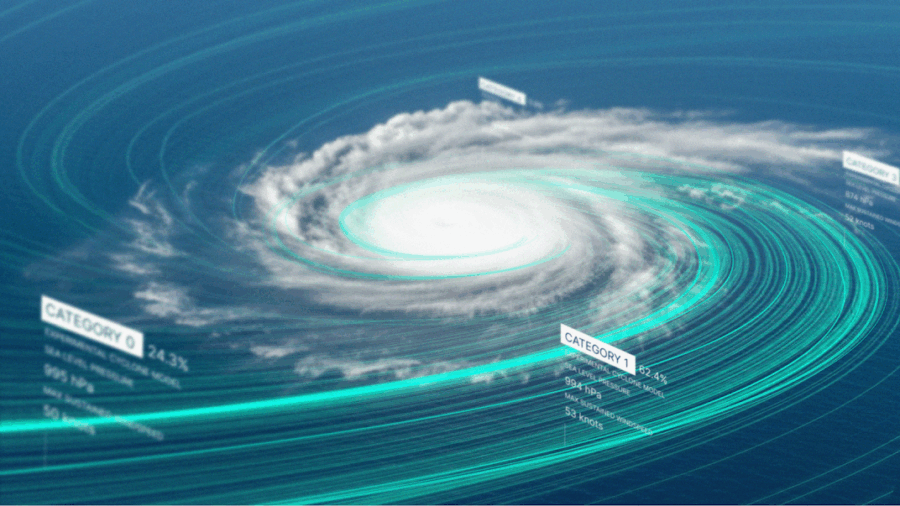

Se la Silicon Valley è la nuova Babilonia, oggi il suo oracolo si chiama DeepMind. E no, non sta leggendo i fondi di caffè: sta leggendo i venti, gli uragani e le correnti tropicali. Google ha appena annunciato il lancio di Weather Lab, una piattaforma che mostra al mondo come il suo modello sperimentale di previsione meteorologica, basato su intelligenza artificiale, possa battere — anzi, aggirare elegantemente — i modelli fisici tradizionali. Il bersaglio? I cicloni tropicali, che da fenomeni atmosferici stanno diventando test per stressare la soglia tra pubblico e privato, tra algoritmo e scienza, tra previsioni e controllo.

Chiunque abbia mai fissato la piccola barra di stato di uno smartphone durante l’attesa di una pizza o di un Uber in ritardo sa bene quanto il tempo possa trasformarsi in un’entità maligna. Con Android 16, Google vuole redimere questa microfrustrazione quotidiana, lanciando finalmente i Live Updates sui Pixel, e promettendo – come sempre – una rivoluzione.

Ma sotto l’apparenza di una novità utile, si cela l’ennesimo rituale liturgico del gigante di Mountain View: un’imitazione dell’iPhone con qualche funzione in più, un’estetica un po’ più snella, un’eco di Material 3 che ancora non si vede ma aleggia come un fantasma promesso.

Google arma Gemini di orologio e volontà: scheduled actions ecco perché l’AI non dimentica più nulla

Nel gioco a scacchi tra Google e OpenAI, la prossima mossa si gioca sul tempo. Non nel senso generico della velocità, dove ormai tutto si misura in nanosecondi computazionali, ma nel senso umano del calendario, della pianificazione, delle piccole promesse che dimentichiamo e delle abitudini che ci raccontano chi siamo. E Google, con la sua Gemini, ha deciso di diventare un assistente con memoria e agenda. Altro che segretaria virtuale: adesso sa anche quando ricordartelo.

La funzione si chiama “scheduled actions” e sembra innocua, quasi banale. Ma chi conosce la guerra delle AI sa che sotto ogni rollout in punta di codice si nasconde una visione strategica. Tradotto: l’utente potrà dire a Gemini “ricordamelo domani alle 18” o “ogni lunedì mandami idee per il blog” e l’AI lo farà. Semplice? Solo in apparenza. Perché dietro quel “lo farà” c’è il passo definitivo verso un’AI che non reagisce più, ma agisce. È questo il punto. Non è un chatbot che risponde. È un agente che prende iniziative — su tua delega, ovvio, ma comunque in autonomia operativa.

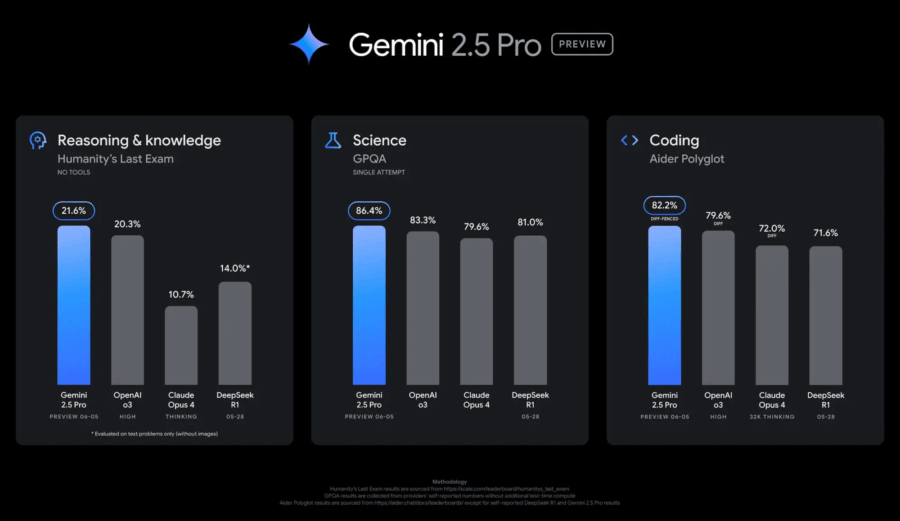

Ogni attore ha il suo momento di gloria, il suo rilascio “rivoluzionario”, la sua conferenza patinata da annunciare tra un keynote e una demo pompata a razzo. Ma oggi, finalmente, Google sembra aver smesso di rincorrere gli altri per tornare a fare scuola. Con il rilascio della versione aggiornata in anteprima di Gemini 2.5 Pro, siglata 06-05, Mountain View alza l’asticella in modo tangibile. E sì, stavolta i benchmark non mentono: stavolta è roba seria.

Partiamo da dove il dolore si sentiva di più: fuori dal mondo del coding, le release precedenti della famiglia Gemini 2.5 sembravano avvolte da una nebbia di mediocrità. Accuse non troppo velate su Reddit, sussurri negli ambienti dev più esigenti: “03-25 era più brillante”, “le nuove release hanno perso smalto”, “troppa ottimizzazione, poca anima”. Bene: con 06-05, Google prova a rimediare. E lo fa con un’operazione chirurgica sul linguaggio, sulla formattazione delle risposte e udite udite su una creatività finalmente leggibile, non più solo impressa nei prompt di marketing.

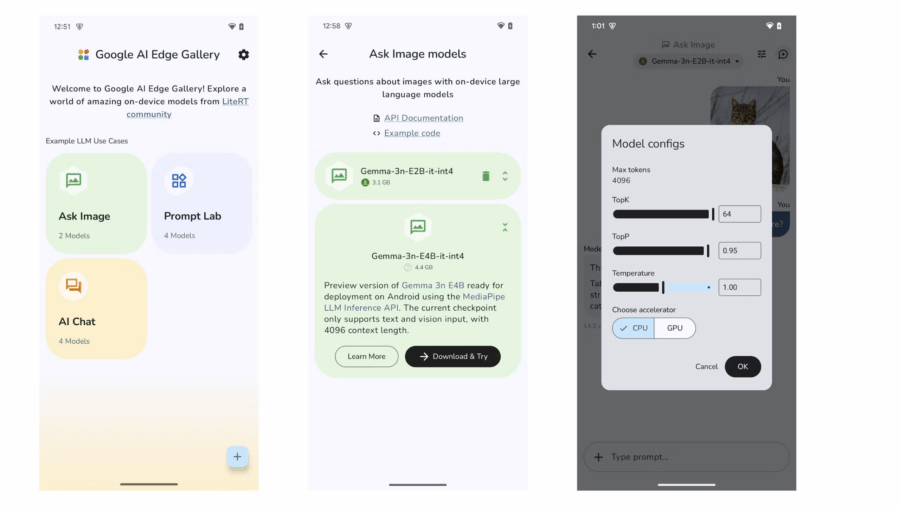

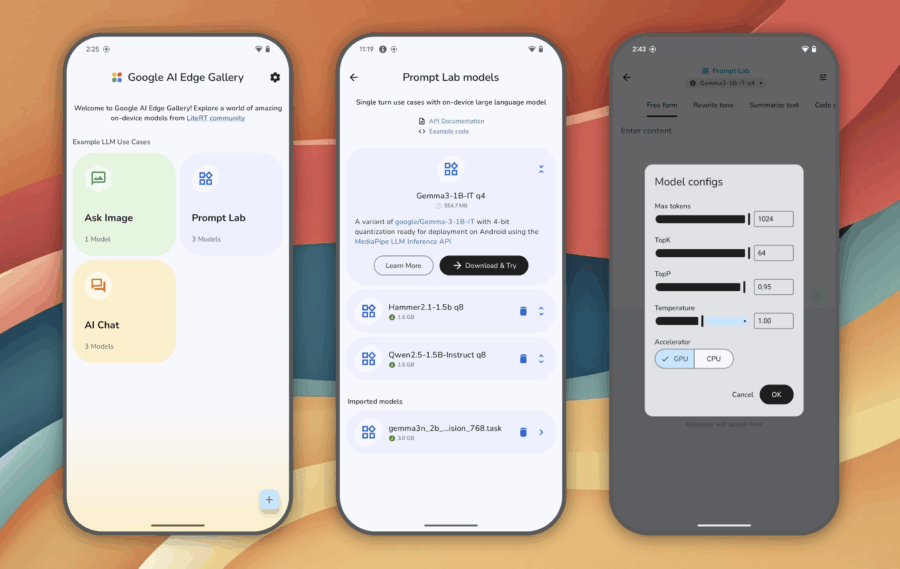

In un’epoca dove tutto è “cloud-first” e l’AI è sinonimo di raccolta dati, Google ha fatto qualcosa di profondamente controintuitivo, quasi punk: ha rilasciato un’applicazione che non ha bisogno di internet, non ti spia, e non condivide niente con i suoi server. Sì, stiamo ancora parlando di Google, e no, non è uno scherzo. Si chiama AI Edge Gallery e sembra un errore di marketing. Eppure, è proprio quello che mancava.

Chi pensa che $500 milioni in dieci anni siano una vera punizione per Alphabet dovrebbe prendersi un caffè più forte. È il costo di un paio di campagne marketing mal riuscite o di un aggiornamento di Android andato storto. Ma questa non è la parte più interessante della storia.

La notizia è che Google, colosso tra i colossi, ha deciso di risolvere un’azione legale dei suoi stessi azionisti pension fund del Michigan e della Pennsylvania, mica hacker ucraini che l’accusavano di averli esposti a rischi antitrust. E attenzione, non stiamo parlando delle cause del DOJ (Department of Justice), quelle sulle pratiche monopolistiche nella search e nell’adtech, dove Washington ha messo i tacchi a spillo. No, qui si parla di un’altra arena: la responsabilità fiduciaria verso gli azionisti.

Certe notizie non arrivano dai comunicati stampa. Le si intercetta nei corridoi, nei documenti “confidenziali”, negli sguardi dei dirigenti in trasferta in Corea. Ma quando Samsung e Perplexity AI iniziano a flirtare pubblicamente, con trattative così avanzate da sfiorare la firma, è chiaro che qualcosa di grosso sta accadendo. Altro che “Bixby 2.0”. Qui si parla di una guerra fredda tra giganti della tecnologia, e Google sta per ricevere il colpo più sottile, ma più letale degli ultimi dieci anni.

Benvenuti nell’era in cui anche i dinosauri digitali iniziano a sudare freddo. No, non è un altro aggiornamento dell’algoritmo di ranking. È un giudice federale americano che, finalmente, sembra aver capito che Google non è solo un motore di ricerca. È il motore. Il telaio. Il carburante. E l’autista dell’intero veicolo informativo globale. Ma ora, proprio quel veicolo rischia di finire smontato pezzo per pezzo.

La keyword di oggi è: monopolio. Le secondarie? Google Chrome, AI generativa, distribuzione della ricerca. Il palcoscenico è quello della “remedies phase” del processo che vede Google accusata di aver mantenuto illegalmente il suo dominio nella ricerca online. Il giudice Amit Mehta, apparentemente afflitto da un raro rigurgito di pragmatismo, ha cominciato a mettere in discussione le proposte sul tavolo. E quando un giudice federale definisce la cessione di Chrome “più pulita ed elegante”, attenzione: il colosso sente davvero il terreno tremare sotto i piedi.

Google ha deciso che no, non ti meriti l’intelligenza artificiale offline.

Non più, almeno.

Il toolkit che permetteva di eseguire modelli open-source localmente, in edge, senza cloud, è stato abbandonato. Smantellato. Eliminato con la nonchalance tipica delle Big Tech quando qualcosa diventa troppo utile per essere libero.

C’è un silenzioso ma potentissimo colpo di stato in atto nei corridoi digitali di Google Workspace. Lo chiamano Gemini in Drive, e la sua missione è semplice quanto devastante per l’antico rituale del “guardarsi il video della riunione persa”. Ora lo fa lui. Lo guarda lui. E ti dice anche quello che ti serve sapere, senza che tu debba perdere mezz’ora della tua vita a fissare slide mosce e volti smarriti in videocall.

La novità è semplice nella sua superficie ma profonda nel suo impatto: Gemini ora riassume anche i video archiviati su Google Drive, dopo aver già colonizzato documenti e PDF con le sue sintesi algoritmiche. C’è un chatbot, ovviamente, con quella faccia finta-amichevole da assistente che “ti aiuta”, ma dietro c’è il motore semantico di Google che comincia a comprendere i contenuti visivi e trasformarli in azione testuale.

Non mi hanno invitato al party privato di Dior Cruise a Villa Albani. Né me, né mia sorella. Una mancanza imperdonabile, lei mi ha detto questione di gerarchia, Bho..sarà il mio outfit inadeguato… cosi’ che ho deciso di sublimare dedicando la mia serata, con gli avanzi della festa di ieri sera, alla versione beta di Gemini in Chrome, l’ultima trovata di Google per convincerci che l’AI non è solo un hype, ma una presenza “agente”, onnisciente e pronta a servire. Spoiler: no, non lo è. Ma ci stanno lavorando, e molto seriamente.

L’integrazione di Gemini dentro Chrome attualmente disponibile solo per gli utenti AI Pro o Ultra e solo sulle versioni Beta, Dev o Canary del browser è presentata come il primo passo verso un’esperienza “agentica”, ovvero un’intelligenza artificiale che non si limita a rispondere, ma che agisce. L’illusione della proattività. L’assistente che “vede” ciò che c’è sullo schermo, e lo commenta. Tipo il tuo collega passivo-aggressivo che legge ad alta voce ogni riga di codice che sbagli.

Lanciato da Google durante l’I/O con la solita retorica transumanista da Silicon Valley “Stiamo entrando in una nuova era della creazione” ha detto il VP di Gemini, Josh Woodward, col tono di chi presenta una nuova bibbia Veo 3 è stato mostrato come il Santo Graal della video-AI. Ma dietro gli slogan, il reale potere di questo strumento sta nella capacità di generare… spazzatura ipnotica. E lo fa benissimo.

La schizofrenia narrativa di Google ha raggiunto vette degne di un thriller legale. In aula, davanti al Dipartimento di Giustizia degli Stati Uniti, il colosso di Mountain View piange miseria, sostenendo di essere assediato da concorrenti agguerriti come OpenAI e da una nuova generazione di motori di ricerca spinti dall’intelligenza artificiale. Ma, quando si tratta di vendere pubblicità – cioè fare veri soldi – la melodia cambia: improvvisamente Google diventa una potenza inarrestabile, un canale obbligato per chiunque voglia raggiungere un consumatore connesso.

Il problema è che entrambi i racconti non possono essere veri contemporaneamente, a meno che non si accetti l’idea che Big Tech viva in una realtà quantistica, dove può essere monopolista e vittima nello stesso istante, a seconda dell’osservatore.

Nel teatrino digitale chiamato Google I/O, dove ogni anno si spaccia il futuro come progresso inevitabile, è andato in scena l’ennesimo colpo di mano ai danni dei produttori di contenuti: l’introduzione su larga scala della famigerata AI Mode la nuova interfaccia chatbot-style che sostituisce la ricerca classica con un blob generativo infarcito di “risposte intelligenti”. La parola chiave è: risposte, non link. Tradotto: meno click ai siti, più tempo dentro Google.

Così il motore di ricerca più potente del mondo si trasforma definitivamente in un recinto. Non ti porta più da nessuna parte, ti tiene dentro, ti mastica e poi ti sputa addosso una sintesi addestrata sui contenuti di altri. Magari i tuoi.

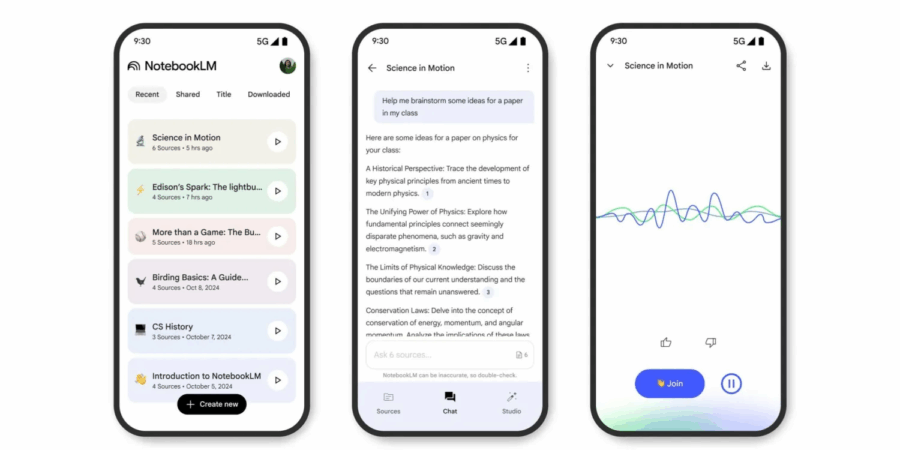

NotebookLM mobile: la voce dell’AI che ti racconta i tuoi appunti (e ti ascolta meglio di HR)

Google ha deciso di infilarsi anche nelle tue tasche, letteralmente. Dopo aver dato vita a NotebookLM come strumento AI “studioso” da scrivania, adesso lo piazza nel tuo Android e dal 20 maggio anche su iPhone e iPad con un’app che trasforma i tuoi documenti in voci sintetiche da podcast. Sì, hai letto bene: il tuo report trimestrale letto da un’intelligenza artificiale mentre sei in palestra. O mentre fingi interesse durante una riunione su Zoom.

Google ha recentemente svelato AlphaEvolve, un agente AI destinato a rivoluzionare il mondo dell’informatica e della matematica, promettendo di ottimizzare algoritmi e scoprire soluzioni innovative. Alimentato dalla potente piattaforma Gemini, AlphaEvolve non si limita a essere un semplice strumento di calcolo, ma è progettato per identificare e migliorare le idee più promettenti nel campo della ricerca algoritmica. Non si tratta solo di un’altra IA “intelligente”, ma di un agente che potrebbe essere un vero e proprio spartiacque nelle tecnologie moderne, spaziando dalla progettazione di chip e data center all’ottimizzazione di processi complessi come l’addestramento delle intelligenze artificiali.

Senza nemmeno suonare il gong, Google entra nella gabbia dell’intelligenza artificiale con l’ennesima trovata, mascherata da filantropia tecnologica: l’AI Futures Fund. Un nome da romanzo cyberpunk di serie B, ma con dentro il solito schema di colonizzazione strategica: capitali, risorse, controllo. Questa volta però non si parla di acquisizioni muscolari alla “dammi la tua startup e ti compro pure il cane”, ma di una seduzione più sottile. Il fondo non ha scadenze, non segue coorti, non chiede pitch al minuto. È sempre aperto, sempre pronto. Tipo l’occhio di Sauron, ma con badge di Google Cloud.

Google ha appena piazzato un colpo da maestro (o da illusionista, dipende da quanto sei cinico): i modelli Gemma, la loro linea di AI open-source “lightweight”, hanno superato i 150 milioni di download. Un numero che fa scena, attira le luci dei riflettori e fa impazzire le dashboard degli sviluppatori su Hugging Face, Kaggle, Colab e compagnia cantante. Ma prima di far partire la ola, respiriamo un attimo. Perché dietro il marketing ben oleato, c’è ben altro da dire.

Quando si parla di privacy, Google non è certo estraneo a sollevare polveroni, ma stavolta il gigante della Silicon Valley ha dovuto fare i conti con la giustizia texana. Il procuratore generale del Texas, Ken Paxton, ha annunciato che Google ha accettato di sborsare ben 1,375 miliardi di dollari per risolvere una causa che l’accusava di violare la privacy dei dati dei propri utenti. Una somma che fa sembrare “piccolo” l’importo che ha dovuto pagare Meta lo scorso luglio, in un caso simile riguardante il riconoscimento facciale.

Il mondo digitale, come ogni bar malfamato di Caracas, ha i suoi borseggiatori. Solo che qui non usano le mani, ma le notifiche. Quelle stesse notifiche che ti compaiono sullo smartphone alle tre di notte con promesse oscene di guadagni facili, antivirus miracolosi e principi nigeriani in cerca d’amore. Google ha deciso di affrontare questa fiera del click truffaldino con una mossa che sa di rivoluzione (ma con il solito retrogusto di controllo totale): Chrome su Android ora usa intelligenza artificiale on-device per analizzare le notifiche e sputtanare in tempo reale quelle truffaldine. Tutto questo, ovviamente, senza mandare nulla ai server centrali. Giurano.

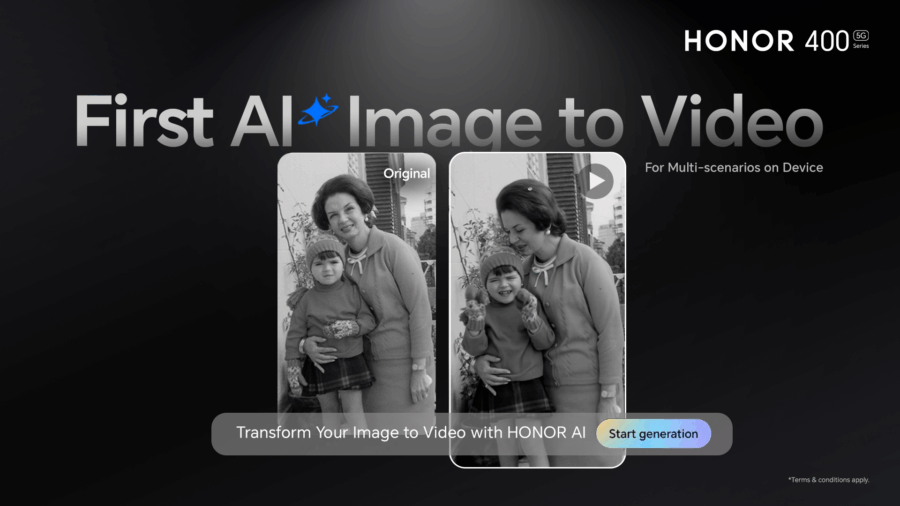

Hai presente quando pensavi che l’AI mobile fosse solo una scusa per filtri da influencer? E invece Google piazza un colpo da ko con il suo generatore di video da immagini, integrato direttamente nei nuovi smartphone Honor. Un lancio che sa di bivio tra “wow” e “mah, serviva proprio?” e che promette di trasformare ogni foto in un mini‐film da festival.