Il lancio di GPT-5 aveva il sapore della promessa di un’era più semplice, quasi da Apple anni ’90: un’unica intelligenza artificiale capace di capire l’utente, scegliere la modalità migliore e restituire la risposta ottimale senza che il povero umano dovesse navigare in un menu da stazione spaziale sovietica. L’idea del “one size fits all” era una dichiarazione di guerra alle complicazioni, con un router interno che avrebbe selezionato in tempo reale se usare un modello veloce, riflessivo o equilibrato. Peccato che, a quanto pare, la realtà si sia rivelata più simile a un volo low cost con tre scali e cambio di gate all’ultimo minuto.

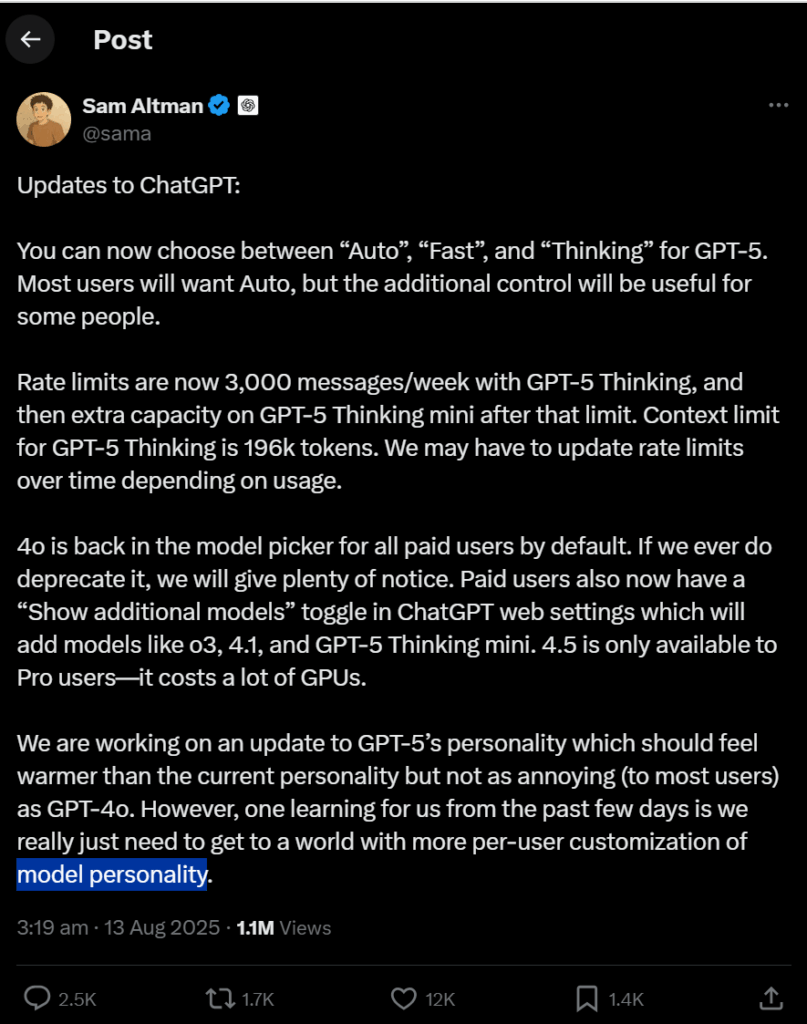

A pochi giorni dal debutto, Sam Altman ha annunciato tre nuove modalità: “Auto”, “Fast” e “Thinking”. La prima è il router originario, le altre due sono il pulsante di emergenza per chi non si fida dell’autopilota. È il riconoscimento implicito che GPT-5 non è ancora il coltellino svizzero dell’AI che OpenAI aveva sbandierato. Come se non bastasse, i modelli “defunti” GPT-4o, GPT-4.1 e o3 sono stati riesumati e reinseriti nella selezione. Il risultato? Il model picker è tornato a essere un bazar caotico, un paradosso per un prodotto che voleva abolirlo. Altman ha ammesso che serve più personalizzazione, promettendo un carattere di GPT-5 “più caldo ma non fastidioso” rispetto a GPT-4o, quasi fosse una questione di servizio clienti in un ristorante stellato.

Il problema non è solo tecnico ma psicologico. Gli utenti sviluppano legami affettivi con i modelli, un fenomeno che le aziende non avevano previsto. Alcuni preferiscono la prolissità, altri l’ironia tagliente o la contrarianità. La rimozione di GPT-4o ha scatenato una mini-rivolta digitale, confermando che l’intelligenza artificiale, per chi la usa intensamente, non è intercambiabile come un widget. L’esempio più teatrale resta il funerale pubblico organizzato a San Francisco per la “morte” di Claude 3.5 Sonnet di Anthropic. Un evento surreale ma perfettamente in linea con un’epoca in cui gli algoritmi diventano compagni di pensiero e specchi emotivi.

Sul piano ingegneristico, il router di GPT-5 ha avuto un debutto traballante. L’assegnazione automatica delle richieste al modello più adatto è un problema di ottimizzazione brutale: deve capire l’intento, la complessità e lo stile preferito dall’utente in millisecondi, senza sacrificare velocità o qualità. Il giorno del lancio, molti hanno percepito risposte più lente o meno incisive rispetto a GPT-4, costringendo Altman a un AMA su Reddit per rassicurare la folla digitale. Nick Turley, VP di ChatGPT, ha difeso il ritmo di iterazione del team, ma il sottotesto è chiaro: la promessa di un’intelligenza unica e universale si scontra con la realtà della diversità delle aspettative umane.

Questo scontro ha un risvolto strategico che va oltre la UX. La personalizzazione del “carattere” di un’AI non è solo un vezzo estetico, ma un fattore competitivo cruciale in un mercato dove le differenze tra modelli di punta si assottigliano. In pratica, OpenAI sta imparando che la battaglia non si vince solo con parametri e training set, ma con la capacità di modellare esperienze su misura, persino a costo di mantenere in vita modelli precedenti per soddisfare nicchie affezionate. È un paradosso che ricorda la gestione di brand di lusso: si lancia il nuovo, ma non si toglie mai del tutto il vecchio, perché il vintage genera fidelizzazione.

L’ironia della vicenda è che GPT-5 doveva semplificare tutto, ma ha resuscitato la complessità che voleva cancellare. Un po’ come quando un’azienda introduce un ERP “unificato” e dopo sei mesi riporta in vita i vecchi fogli Excel perché “funzionavano meglio per certi casi”. L’evidenza è che l’AI, come ogni tecnologia con impatto cognitivo diretto, non è una commodity uniforme ma un ecosistema di preferenze, abitudini e idiosincrasie personali. Chi progetta modelli dovrà accettare che il vero router non sta nel codice ma nell’utente, e che il futuro dell’AI sarà meno una questione di parametri e più una guerra di personalità.