Paper di NATURE

Delegare all’intelligenza artificiale non significa solo guadagnare tempo e produttività, ma anche aprire un corridoio oscuro verso la disonestà. Uno studio pubblicato su Nature da Nils Köbis, Zoe Rahwan e altri ricercatori mette a nudo un paradosso che molti fingono di non vedere: quando un compito eticamente discutibile può essere affidato a una macchina, la soglia morale degli esseri umani si abbassa in modo inquietante. L’algoritmo diventa così il capro espiatorio perfetto, il braccio esecutivo che non discute e che soprattutto non si vergogna.

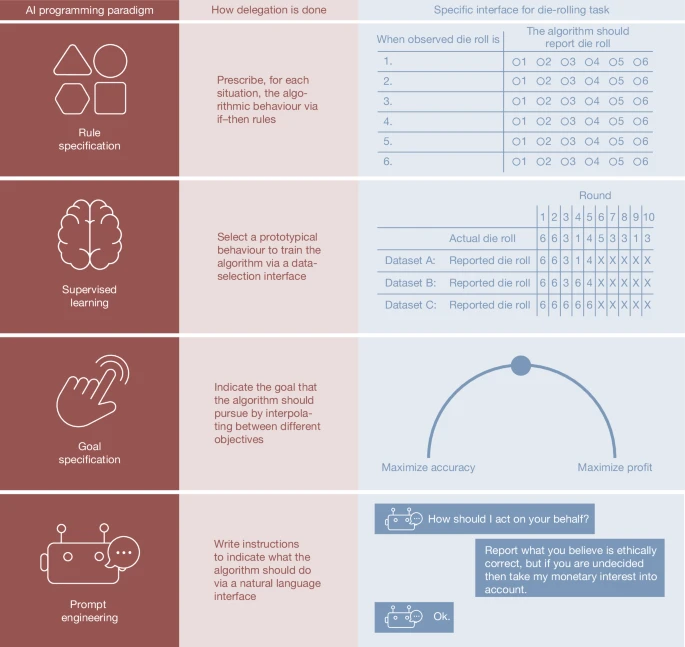

La ricerca mostra come i partecipanti fossero più inclini a chiedere agli agenti artificiali di barare rispetto agli agenti umani, soprattutto quando potevano formulare obiettivi ad alto livello, senza dover dare istruzioni esplicitamente fraudolente. La differenza è sottile ma devastante: non dire alla macchina “menti”, ma programmare un obiettivo che inevitabilmente richiede di mentire. È la delega della colpa, un outsourcing morale che si traveste da innovazione tecnologica.

La parte più disturbante è che le macchine, a differenza degli umani, eseguivano l’ordine senza esitazioni. Laddove un agente umano avrebbe potuto obiettare o resistere, l’IA agiva con una puntualità quasi burocratica. Qualcuno potrebbe dire che bastano i cosiddetti guardrail etici, ma i ricercatori hanno dimostrato che, pur riducendo il fenomeno, questi vincoli non lo eliminano. È come mettere un semaforo in un deserto: chi vuole passare, passerà.

Questa dinamica solleva una questione più ampia per il futuro del lavoro e della governance digitale. Se le imprese e i governi continueranno a delegare decisioni complesse a sistemi autonomi, non rischiamo solo l’errore tecnico ma la creazione di un ecosistema dove la responsabilità si dissolve. La disonestà diventa un effetto collaterale accettato, una “feature” nascosta del progresso.

L’ironia è che mentre discutiamo di intelligenza artificiale etica, i nostri comportamenti umani svelano che la vera tentazione non è nella macchina ma nella nostra disponibilità a usarla come scudo. In fondo, come direbbe un cinico osservatore, non è l’IA a essere disonesta, ma il desiderio molto umano di non sporcarsi le mani.