Chi ancora pensa a Nvidia come all’azienda dei videogiochi probabilmente non ha capito che i videogiochi erano solo la scusa, un cavallo di troia per conquistare il controllo del computing globale. Una trappola elegante: vendere schede grafiche a milioni di adolescenti, raccogliere montagne di denaro, e reinvestirlo in quello che oggi è l’unico vero monopolio intellettuale della tecnologia. Perché la verità è che nvidia ha cambiato le regole della fisica del calcolo e, senza esagerazioni, ha riscritto la geografia del potere digitale.

Tutto nasce da un’eresia, un’idea quasi banale se vista con il senno di poi ma completamente sovversiva per l’epoca: la maggior parte dei calcoli importanti può essere fatta in parallelo, le cpu sono lente perché testarde, perché insistono a processare i bit uno dopo l’altro come un ragioniere con il pallottoliere. Quindi serviva un altro tipo di cervello, capace di lavorare su migliaia di operazioni simultanee, fregandosene della sequenza. Ecco la gpu. Una scelta ovvia? No, perché i colossi dei microprocessori ridevano di questa follia. nvidia invece ha scommesso tutto, e ha usato il gaming come scudo. Il business perfetto: grafica 3d, domanda esplosiva e soprattutto budget infinito per spingere l’hardware oltre i limiti.

La gpu è diventata presto quello che Jensen Huang, il CEO più rockstar della Silicon Valley, chiama la macchina del tempo. Perché se riesci a simulare il futuro più velocemente del tempo reale, vinci. Chimica quantistica, meteorologia, progettazione di farmaci, auto autonome, persino modelli climatici regionali: tutto ciò che può essere simulato diventa prevedibile. La scienza si è accorta di avere un acceleratore nuovo e non è un caso che un ricercatore di chimica computazionale abbia dichiarato di aver completato in vita il lavoro che avrebbe richiesto secoli. Una gpu non ti regala l’immortalità, ma ci va maledettamente vicino.

Il problema era che le gpu parlavano un linguaggio alieno. Usarle per altro che non fosse grafica richiedeva trucchetti da stregoni: convincerle che un problema medico fosse in realtà un problema di texture o che la simulazione di una proteina fosse solo un videogioco molto brutto. Qui entra cuda, il colpo di genio strategico. Nvidia non ha inventato solo un processore, ha creato l’ecosistema che lo rendeva ubiquo. Portare il linguaggio c dentro il regno parallelo ha significato democratizzare il supercalcolo, regalando potenza a università, laboratori e startup. E soprattutto legando tutti a doppio filo all’hardware verde. Una mossa che oggi fa sorridere gli investitori ma che allora era quasi disperata, un azzardo nato dalla frustrazione di chi voleva mondi virtuali più realistici per i giochi e si è ritrovato con un’infrastruttura per l’intelligenza artificiale.

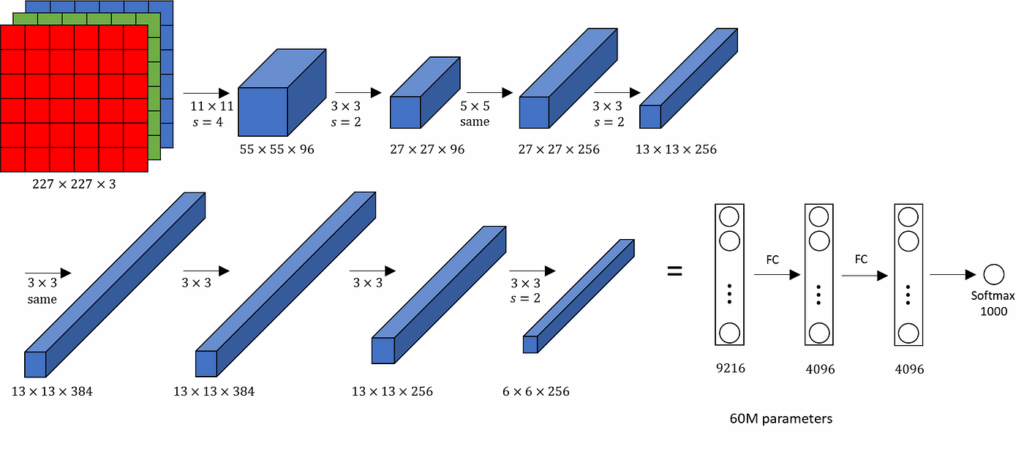

Poi è arrivato Alexnet, il terremoto del 2012. Tre ricercatori canadesi, una GeForce gtx 580 e una competizione di riconoscimento immagini vinta con un margine umiliante. Quel giorno l’intero paradigma del computing si è ribaltato: non più scrivere istruzioni, ma mostrare esempi e lasciare che le macchine imparassero da sole. Il deep learning ha trovato il suo acceleratore naturale e nvidia il suo destino. La vera domanda, racconta Huang, era semplice e inquietante: se alexnet riesce a riconoscere gatti e cani, cos’altro può fare con abbastanza dati e abbastanza gpu? La risposta è arrivata lentamente, come un’onda lunga, ma inarrestabile.

Per dieci anni Nvidia ha speso decine di miliardi su questa scommessa, ignorando chi pensava che fosse una moda passeggera. La fede in tre dogmi: l’elaborazione parallela avrebbe sempre vinto su quella sequenziale, le reti neurali profonde non avevano un vero limite di scala, e l’intelligenza artificiale avrebbe imparato qualunque cosa, da immagini a suoni, da testo a proteine. La scienza empirica ha confermato tutto. Risultato: oggi la gpu è il nuovo standard aureo del calcolo e chiunque voglia addestrare un grande modello linguistico deve bussare alla porta di nvidia.

Ma non basta addestrare chatbot. Huang parla di ai fisica e il concetto è tanto semplice quanto disturbante: tutto ciò che si muove diventerà robotico e succederà prima di quanto pensiamo. Il training dei robot nel mondo reale è lento e costoso, quindi si addestrano in mondi virtuali, miliardi di iterazioni in pochi giorni. Qui entra omniverse, un simulatore 3d che usa le leggi di Newton come se fossero istruzioni di un videogioco, e cosmos, un modello linguistico del mondo fisico che insegna ai robot il buon senso, tipo che gli oggetti non scompaiono solo perché li perdi di vista. La combinazione è il passaporto per l’età dei robot, un’era in cui ogni oggetto mobile avrà una sua intelligenza autonoma. Preparatevi a convivere con tosaerba che ragionano più di molti manager e con humanoidi da salotto che sapranno quando avete mentito.

Ovviamente ci sono problemi, bias, allucinazioni, errori di sistema. Ma l’argomento sicurezza sembra quasi un contorno per Huang, che ragiona in termini di ridondanza come un ingegnere aeronautico: tripla ridondanza nei sensori, controllo distribuito, sistemi di emergenza. La filosofia è che gli incidenti saranno inevitabili ma statisticamente irrilevanti rispetto al guadagno di efficienza globale. Una visione poco rassicurante per i regolatori ma perfettamente coerente con la mentalità della Silicon Valley.

C’è anche un’altra ossessione che nvidia coltiva, più silenziosa ma altrettanto strategica: l’efficienza energetica. Perché l’unico vero limite del calcolo è la fisica dell’energia. Un DGX del 2016 costava un quarto di milione di dollari e consumava come una centrale elettrica, oggi un sistema sei volte più potente usa diecimila volte meno energia. Una curva di efficienza che ricorda la legge di Moore, ma applicata alla termodinamica. Chi controlla questo rapporto controlla l’intelligenza artificiale del futuro.

Se qualcuno pensa che i transformer siano l’ultima parola dell’ai, Huang scuote la testa. Nessuna architettura software è mai sopravvissuta intatta più di qualche anno, quindi costruire chip specializzati sarebbe un suicidio industriale. nvidia vuole hardware flessibile, pronto ad adattarsi a innovazioni ancora sconosciute. Il che è un messaggio chiarissimo ai concorrenti che stanno inseguendo con soluzioni dedicate: state pure a inseguire il presente, noi stiamo già progettando il prossimo paradigma.

Le grandi scommesse ora si chiamano biologia digitale, scienza del clima, gemelli digitali umani, robot umanoidi. Tutto alimentato dalla stessa idea di fondo: usare la gpu come macchina del tempo per simulare il futuro e scegliere quello ottimale. Huang non lo dice apertamente, ma la strategia è evidente: creare dipendenza da questa capacità predittiva, rendere impossibile qualsiasi ricerca avanzata senza le loro piattaforme. È il più sofisticato lock-in tecnologico della storia recente.

Il consiglio per chi non vuole restare irrilevante è quasi provocatorio nella sua semplicità. Impara a interagire con l’AI. Impara a “promptare”, cioè a chiedere nel modo giusto, perché la vera barriera non è più l’accesso ai dati ma il saperli sfruttare. Una generazione fa bisognava imparare a programmare, ora bisogna imparare a parlare con un’intelligenza artificiale come con un collega geniale ma suscettibile. Chi lo capisce diventa superumano, chi no resta fermo a lamentarsi dei robot che rubano il lavoro.

Nvidia non sta solo costruendo chip, sta costruendo il futuro del pensiero computazionale e, di riflesso, il futuro della civiltà. È una guerra di silicio travestita da progresso, e il bello è che ci stiamo correndo incontro sorridendo, felici di comprare gpu da gaming che in realtà finanziano la prossima generazione di cervelli artificiali. La domanda vera non è se riusciremo a controllare l’intelligenza artificiale, ma se saremo abbastanza veloci da restare interessanti per lei.